一箭N雕:多任务深度学习实战

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了一箭N雕:多任务深度学习实战相关的知识,希望对你有一定的参考价值。

1、多任务学习导引

多任务学习是机器学习中的一个分支,按1997年综述论文Multi-task Learning一文的定义:Multitask Learning (MTL) is an inductive transfer mechanism whose principle goal is to improve generalization performance. MTL improves generalization by leveraging the domain-specific information contained in the training signals of related tasks. It does this by training tasks in parallel while using a shared representation。翻译成中文:多任务学习是一种归纳迁移机制,基本目标是提高泛化性能。多任务学习通过相关任务训练信号中的领域特定信息来提高泛化能力,利用共享表示采用并行训练的方法学习多个任务。

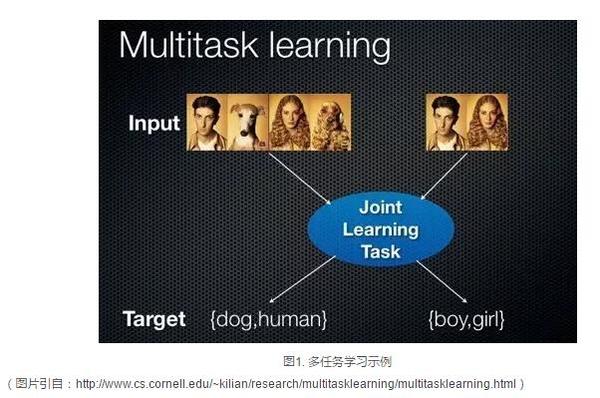

顾名思义,多任务学习是一种同时学习多个任务的机器学习方法,如图1所示,多任务学习同时学习了人类和狗的分类器以及男性和女性的性别分类器。

进一步的,图2所示为单任务学习和多任务学习的对比。在单任务学习中,每个任务采用单独的数据源,分别学习每个任务单独的模型。而多任务学习中,多个数据源采用共享表示同时学习多个子任务模型。

进一步的,图2所示为单任务学习和多任务学习的对比。在单任务学习中,每个任务采用单独的数据源,分别学习每个任务单独的模型。而多任务学习中,多个数据源采用共享表示同时学习多个子任务模型。

多任务学习的基本假设是多个任务之间具有相关性,因此能够利用任务之间的相关性互相促进。例如,属性分类中,抹口红和戴耳环有一定的相关性,单独训练的时候是无法利用这些信息,多任务学习则可以利用任务相关性联合提高多个属性分类的精度,详情可参考文章Maryland大学Hand等人的论文Attributes for Improved Attributes: A Multi-Task Network for Attribute Classification。

多任务学习的基本假设是多个任务之间具有相关性,因此能够利用任务之间的相关性互相促进。例如,属性分类中,抹口红和戴耳环有一定的相关性,单独训练的时候是无法利用这些信息,多任务学习则可以利用任务相关性联合提高多个属性分类的精度,详情可参考文章Maryland大学Hand等人的论文Attributes for Improved Attributes: A Multi-Task Network for Attribute Classification。

2、多任务深度学习

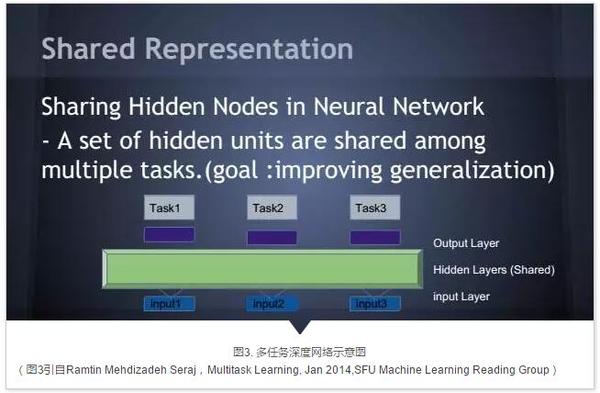

近年来,在深度学习技术的推动下计算机视觉领域取得了突飞猛进的进展。本质上说,深度学习是多层的神经网络,对输入进行了层级的非线性表示,来自网络可视化的证据表明,深度网络的层级表示从语义上从底层到高层不断递进。深度网络强大的表示能力,使得多任务深度学习有了施展的空间。图3所示为多任务深度网络结构示意图。Input x表示不同任务的输入数据,绿色部分表示不同任务之间共享的层,紫色表示每个任务特定的层,Task x表示不同任务对应的损失函数层。在多任务深度网络中,低层次语义信息的共享有助于减少计算量,同时共享表示层可以使得几个有共性的任务更好的结合相关性信息,任务特定层则可以单独建模任务特定的信息,实现共享信息和任务特定信息的统一。

在深度网络中,多任务的语义信息还可以从不同的层次输出,例如GoogLeNet中的两个辅助损失层。另外一个例子比如衣服图像检索系统,颜色这类的信息可以从较浅层的时候就进行输出判断,而衣服的样式风格这类的信息,更接近高层语义,需要从更高的层次进行输出,这里的输出指的是每个任务对应的损失层的前一层。

在深度网络中,多任务的语义信息还可以从不同的层次输出,例如GoogLeNet中的两个辅助损失层。另外一个例子比如衣服图像检索系统,颜色这类的信息可以从较浅层的时候就进行输出判断,而衣服的样式风格这类的信息,更接近高层语义,需要从更高的层次进行输出,这里的输出指的是每个任务对应的损失层的前一层。

3、多任务深度学习应用案例

目前,多任务深度学习已经广泛应用于人脸识别、细粒度车辆分类、面部关键点定位与属性分类等多个领域,以下讲介绍其中的代表性论文。

3.1人脸识别网络 DeepID2

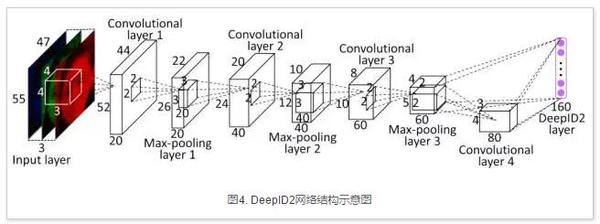

香港中文大学汤晓鸥组发表在NIPS14的论文Deep Learning Face Representation by Joint Identification-Verification,提出了一种联合训练人脸确认损失和人脸分类损失的多任务人脸识别网络DeepID2,网络结构如下图所示:

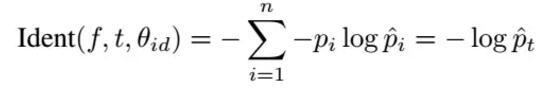

DeepID2中共有两个损失函数,分别为人脸分类损失函数,对应于Caffe中的SoftmaxLoss:

DeepID2中共有两个损失函数,分别为人脸分类损失函数,对应于Caffe中的SoftmaxLoss:

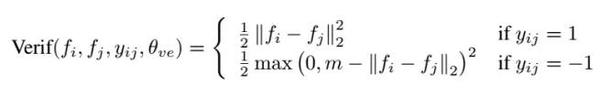

另外一个是人脸确认损失函数,对应于Caffe中的Contrastive Loss:

另外一个是人脸确认损失函数,对应于Caffe中的Contrastive Loss:

3.2细粒度车辆分类网络

3.2细粒度车辆分类网络

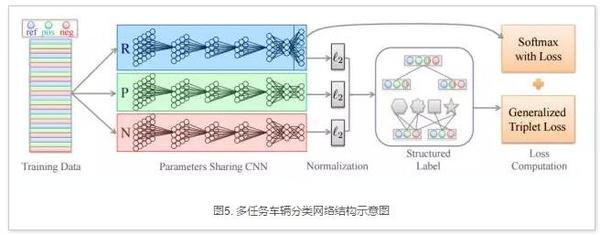

这里介绍一个比较有趣的将SoftmaxLoss和TripletLoss结合在一个网络中进行多任务训练的方法Embedding Label Structures for Fine-Grained Feature Representation,目前文章发表于arXiv。作者将这个网络用于细粒度车辆分类上,提醒注意的是为了计算Tiplet Loss,特征进行了L2范数归一操作,网络结构如下图所示:

3.3物体检测网络Faster R-CNN

3.3物体检测网络Faster R-CNN

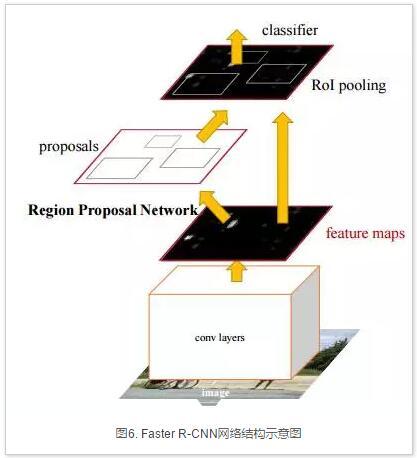

在物体检测网络Faster R-CNN中也有多任务学习的应用。Faster R-CNN的网络结构如下图6所示,包含两个任务,分别为窗口回归和窗口分类,其中RPN模块的卷积层在两个任务之间共享。Faster R-CNN的最新版本支持整体端到端训练,可以同时检测多类物体,是目前最具代表性的目标检测框架,同时也是多任务深度学习的一个典型应用。

3.4面部关键点定位与属性分类网络TCDCN

3.4面部关键点定位与属性分类网络TCDCN

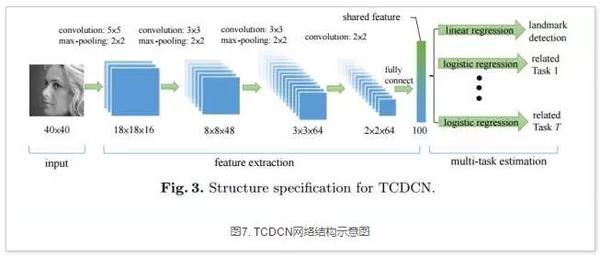

面部关键点估计和头部姿态以及人脸属性(是否戴眼镜、是否微笑和性别)之间有着紧密的联系,香港中文大学汤晓鸥组发表于ECCV14的工作Facial Landmark Detection by Deep Multi-task Learning利用多任务学习方法联合进行人脸面部关键点定位和属性预测,网络结构如下图7所示。

4、基于Caffe实现多任务学习的小样例

4、基于Caffe实现多任务学习的小样例

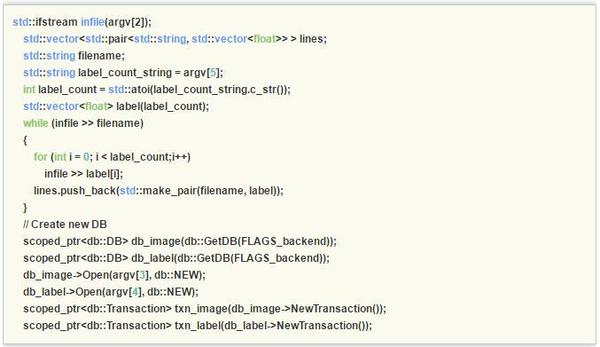

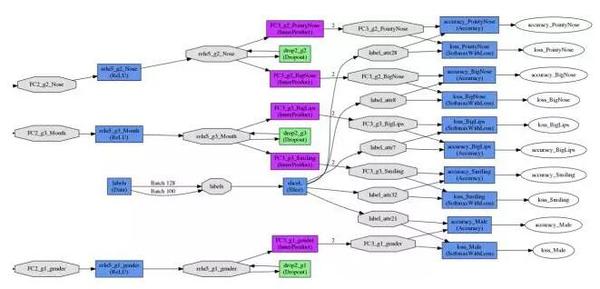

本节在目前广泛使用的深度学习开源框架Caffe的基础上实现多任务深度学习算法所需的多维标签输入。默认的,Caffe中的Data层只支持单维标签,为了支持多维标签,首先修改Caffe中的convert_imageset.cpp以支持多标签:

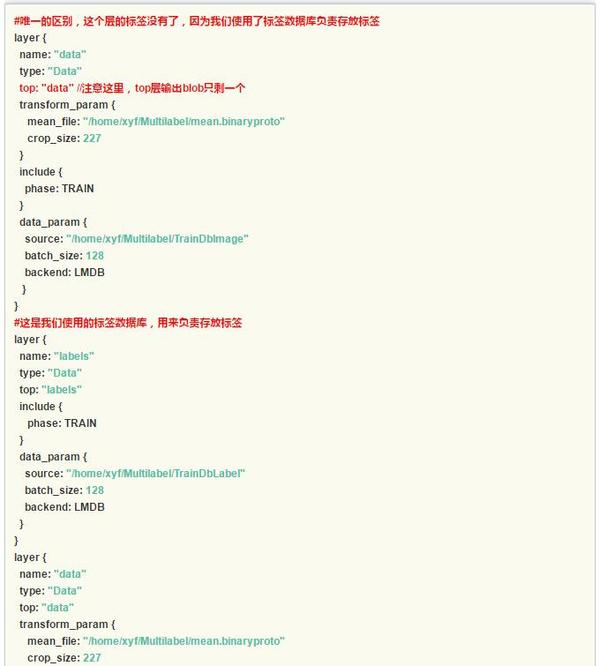

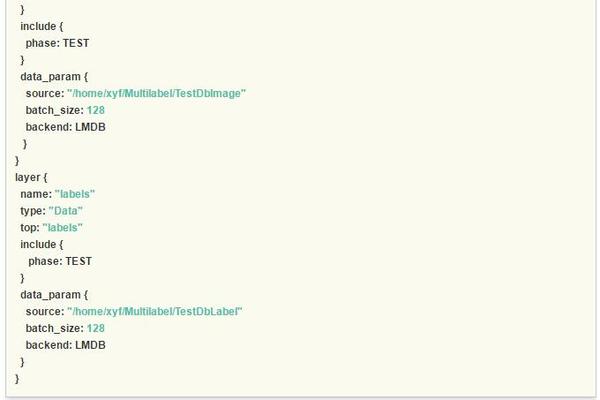

这样我们就有了多任务的深度学习的基础部分数据输入。为了向上兼容Caffe框架,本文摒弃了部分开源实现增加Data层标签维度选项并修改Data层代码的做法,直接使用两个Data层将数据读入,即分别读入数据和多维标签,接下来介绍对应的网络结构文件prototxt的修改,注意红色的注释部分。

这样我们就有了多任务的深度学习的基础部分数据输入。为了向上兼容Caffe框架,本文摒弃了部分开源实现增加Data层标签维度选项并修改Data层代码的做法,直接使用两个Data层将数据读入,即分别读入数据和多维标签,接下来介绍对应的网络结构文件prototxt的修改,注意红色的注释部分。

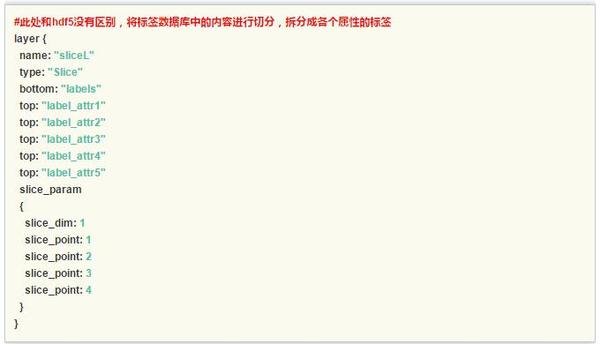

特别的,slice层对多维的标签进行了切分,为每个任务输出了单独的标签。

特别的,slice层对多维的标签进行了切分,为每个任务输出了单独的标签。

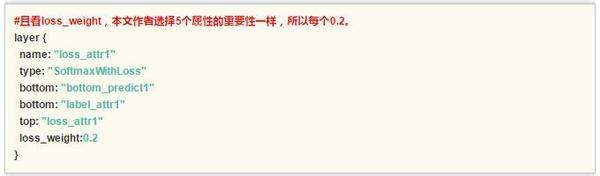

另外一个值得讨论的是每个任务的权重设置,在本文实践中五个任务设置为等权重loss_weight:0.2。一般的,建议所有任务的权重值相加为1,如果这个数值不设置,可能会导致网络收敛不稳定,这是因为多任务学习中对不同任务的梯度进行累加,导致梯度过大,甚至可能引发参数溢出错误导致网络训练失败。

另外一个值得讨论的是每个任务的权重设置,在本文实践中五个任务设置为等权重loss_weight:0.2。一般的,建议所有任务的权重值相加为1,如果这个数值不设置,可能会导致网络收敛不稳定,这是因为多任务学习中对不同任务的梯度进行累加,导致梯度过大,甚至可能引发参数溢出错误导致网络训练失败。

本文的完整代码可在作者个人的github主页下载:

本文的完整代码可在作者个人的github主页下载:

CodeSnap/convert_multilabel.cpp at master · HolidayXue/CodeSnap · GitHub

多任务损失函数层的网络结构示意图如下图所示:

5. 总结

5. 总结

本文回顾了多任务学习的基本概念,并讨论了多任务深度学习的基本思想和应用案例。最后以开源深度学习平台Caffe为例讨论了多任务深度学习的实现,并给出了开源代码。

致谢

本文在投稿之后经历了三轮修改,其中一轮公众号编辑部初审,一轮双盲评审大改和一轮单盲评审小修,两名审稿专家对原文进行了全面仔细的阅读,帮助作者修正了文章的若干理论表述,给出了建设性的提高可读性的修改意见。在此本文作者对全体审稿人表示感谢,并对深度学习大讲堂公众号编辑部耐心细致的审稿服务表示感谢。

作者:薛云峰,(https://github.com/HolidayXue),主要从事视频图像算法的研究,就职于浙江捷尚视觉科技股份有限公司担任深度学习算法研究员。捷尚致力于视频大数据和视频监控智能化,现诚招业内算法和工程技术人才,招聘主页http://www.icarevision.cn/job.php,联系邮箱:[email protected]

以上是关于一箭N雕:多任务深度学习实战的主要内容,如果未能解决你的问题,请参考以下文章

PyTorch深度学习项目实战100例—— 基于LeNet5实现交通标志分类任务 | 第50例

PyTorch深度学习项目实战100例—— 基于AlexNet实现宠物小精灵(宝可梦)分类任务 | 第49例

海云译见 | 深度学习最新进展:“IMPALA”深度强化多任务学习架构

《自然语言处理实战入门》深度学习 ---- 预训练模型的使用(ALBERT 进行多标签文本分类与微调 fine tune)