重磅︱文本挖掘深度学习之word2vec的R语言实现

Posted 悟乙己

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了重磅︱文本挖掘深度学习之word2vec的R语言实现相关的知识,希望对你有一定的参考价值。

笔者寄语:2013年末,Google发布的 word2vec工具引起了一帮人的热捧,大家几乎都认为它是深度学习在自然语言领域的一项了不起的应用,各种欢呼“深度学习在自然语言领域开始发力 了”。

基于word2vec现在还出现了doc2vec,word2vec相比传统,考虑单词上下文的语义;但是doc2vec不仅考虑了单词上下文的语义,还考虑了单词在段落中的顺序。

如果想要了解word2vec的实现原理,应该读一读官网后面的三篇参考文献。显然,最主要的应该是这篇: Distributed Representations of Words and Phrases and their Compositionality

这篇文章的基础是 Natural Language Processing (almost) from Scratch 其中第四部分提到了把deep learning用在NLP上。

强力推荐:一个在线测试的网站,貌似是一位清华教授做的:http://cikuapi.com/index.php[2]

笔者又写了一篇相关内容,推荐:

重磅︱R+NLP:text2vec包简介(GloVe词向量、LDA主题模型、各类距离计算等)

———————————————————————————————————————————————

一、word2vec词向量由来

在word2vec产生前,还有一些语言模型,在自然语言处理 NLP模型中,到达word2vec历经了一些步骤。但是对于NLP模型中,起到确定性作用的是词向量(Distributed Representation/word Embedding)的提出,在这之前有一些基础性的模型如统计语言模型、神经网络概率语言模型。

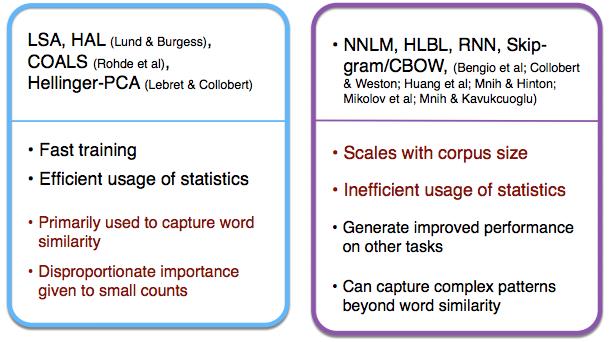

几个基于统计的传统语言模型与word2vec这种直接预测的方法的比较(图片摘自Stanford CS244)【5】:

1、统计语言模型

以上是关于重磅︱文本挖掘深度学习之word2vec的R语言实现的主要内容,如果未能解决你的问题,请参考以下文章