Scrapy-Redis分布式组件

Posted lcy0302

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Scrapy-Redis分布式组件相关的知识,希望对你有一定的参考价值。

第一节:redis数据库介绍

概述

redis是一种支持分布式的nosql数据库,他的数据是保存在内存中,同时redis可以定时把内存数据同步到磁盘,即可以将数据持久化,并且他比memcached支持更多的数据结构(string,list列表[队列和栈],set[集合],sorted set[有序集合],hash(hash表))。相关参考文档:http://redisdoc.com/index.html

redis使用场景:

- 登录会话存储:存储在

redis中,与memcached相比,数据不会丢失。 - 排行版/计数器:比如一些秀场类的项目,经常会有一些前多少名的主播排名。还有一些文章阅读量的技术,或者新浪微博的点赞数等。

- 作为消息队列:比如

celery就是使用redis作为中间人。 - 当前在线人数:还是之前的秀场例子,会显示当前系统有多少在线人数。

- 一些常用的数据缓存:比如我们的

BBS论坛,板块不会经常变化的,但是每次访问首页都要从mysql中获取,可以在redis中缓存起来,不用每次请求数据库。 - 把前200篇文章缓存或者评论缓存:一般用户浏览网站,只会浏览前面一部分文章或者评论,那么可以把前面200篇文章和对应的评论缓存起来。用户访问超过的,就访问数据库,并且以后文章超过200篇,则把之前的文章删除。

- 好友关系:微博的好友关系使用

redis实现。 - 发布和订阅功能:可以用来做聊天软件。

redis和memcached的比较:

| memcached | redis | |

|---|---|---|

| 类型 | 纯内存数据库 | 内存磁盘同步数据库 |

| 数据类型 | 在定义value时就要固定数据类型 | 不需要 |

| 虚拟内存 | 不支持 | 支持 |

| 过期策略 | 支持 | 支持 |

| 存储数据安全 | 不支持 | 可以将数据同步到dump.db中 |

| 灾难恢复 | 不支持 | 可以将磁盘中的数据恢复到内存中 |

| 分布式 | 支持 | 主从同步 |

| 订阅与发布 | 不支持 | 支持 |

redis在ubuntu系统中的安装与启动

- 安装:

sudo apt-get install redis-server - 卸载:

sudo apt-get purge --auto-remove redis-server -

启动:

redis安装后,默认会自动启动,可以通过以下命令查看:ps aux|grep redis如果想自己手动启动,可以通过以下命令进行启动:

sudo service redis-server start -

停止:

sudo service redis-server stop

redis在windows系统中的安装与启动:

- 下载:redis官方是不支持windows操作系统的。但是微软的开源部门将redis移植到了windows上。因此下载地址不是在redis官网上。而是在github上:https://github.com/MicrosoftArchive/redis/releases。

- 安装:点击一顿下一步安装就可以了。

- 运行:进入到

redis安装所在的路径然后执行redis-server.exe redis.windows.conf就可以运行了。 - 连接:

redis和mysql以及mongo是一样的,都提供了一个客户端进行连接。输入命令redis-cli(前提是redis安装路径已经加入到环境变量中了)就可以连接到redis服务器了。

其他机器访问本机redis服务器:

想要让其他机器访问本机的redis服务器。那么要修改redis.conf的配置文件,将bind改成bind [自己的ip地址或者0.0.0.0],其他机器才能访问。

注意:bind绑定的是本机网卡的ip地址,而不是想让其他机器连接的ip地址。如果有多块网卡,那么可以绑定多个网卡的ip地址。如果绑定到额是0.0.0.0,那么意味着其他机器可以通过本机所有的ip地址进行访问。

对redis的操作

对redis的操作可以用两种方式,第一种方式采用redis-cli,第二种方式采用编程语言,比如Python、php和JAVA等。

-

使用

redis-cli对redis进行字符串操作: -

启动

redis:sudo service redis-server start - 连接上

redis-server:redis-cli -h [ip] -p [端口] -

添加:

set key value 如: set username xiaotuo将字符串值

value关联到key。如果key已经持有其他值,set命令就覆写旧值,无视其类型。并且默认的过期时间是永久,即永远不会过期。 -

删除:

del key 如: del username -

设置过期时间:

expire key timeout(单位为秒)也可以在设置值的时候,一同指定过期时间:

set key value EX timeout 或: setex key timeout value -

查看过期时间:

ttl key 如: ttl username -

查看当前

redis中的所有key:keys * -

列表操作:

-

在列表左边添加元素:

lpush key value将值

value插入到列表key的表头。如果key不存在,一个空列表会被创建并执行lpush操作。当key存在但不是列表类型时,将返回一个错误。 -

在列表右边添加元素:

rpush key value将值value插入到列表key的表尾。如果key不存在,一个空列表会被创建并执行RPUSH操作。当key存在但不是列表类型时,返回一个错误。

-

查看列表中的元素:

lrange key start stop返回列表

key中指定区间内的元素,区间以偏移量start和stop指定,如果要左边的第一个到最后的一个lrange key 0 -1。 -

移除列表中的元素:

- 移除并返回列表

key的头元素:lpop key - 移除并返回列表的尾元素:

rpop key -

移除并返回列表

key的中间元素:lrem key count value将删除

key这个列表中,count个值为value的元素。

- 移除并返回列表

-

指定返回第几个元素:

lindex key index将返回

key这个列表中,索引为index的这个元素。 -

获取列表中的元素个数:

llen key 如: llen languages -

删除指定的元素:

lrem key count value 如: lrem languages 0 php根据参数 count 的值,移除列表中与参数 value 相等的元素。

count的值可以是以下几种:- count > 0:从表头开始向表尾搜索,移除与

value相等的元素,数量为count。 - count < 0:从表尾开始向表头搜索,移除与

value相等的元素,数量为count的绝对值。 - count = 0:移除表中所有与

value相等的值。

- count > 0:从表头开始向表尾搜索,移除与

-

-

set集合的操作:- 添加元素:

sadd set value1 value2.... 如: sadd team xiaotuo datuo - 查看元素:

smembers set 如: smembers team - 移除元素:

srem set member... 如: srem team xiaotuo datuo - 查看集合中的元素个数:

scard set 如: scard team1 - 获取多个集合的交集:

sinter set1 set2 如: sinter team1 team2 - 获取多个集合的并集:

sunion set1 set2 如: sunion team1 team2 - 获取多个集合的差集:

sdiff set1 set2 如: sdiff team1 team2

- 添加元素:

-

hash哈希操作:-

添加一个新值:

hset key field value 如: hset website baidu baidu.com将哈希表

key中的域field的值设为value。

如果key不存在,一个新的哈希表被创建并进行HSET操作。如果域field已经存在于哈希表中,旧值将被覆盖。 -

获取哈希中的

field对应的值:hget key field 如: hget website baidu -

删除

field中的某个field:hdel key field 如: hdel website baidu -

获取某个哈希中所有的

field和value:hgetall key 如: hgetall website -

获取某个哈希中所有的

field:hkeys key 如: hkeys website -

获取某个哈希中所有的值:

hvals key 如: hvals website -

判断哈希中是否存在某个

field:hexists key field 如: hexists website baidu -

获取哈希中总共的键值对:

hlen field 如: hlen website

-

-

事务操作:Redis事务可以一次执行多个命令,事务具有以下特征:

- 隔离操作:事务中的所有命令都会序列化、按顺序地执行,不会被其他命令打扰。

- 原子操作:事务中的命令要么全部被执行,要么全部都不执行。

-

开启一个事务:

multi以后执行的所有命令,都在这个事务中执行的。

-

执行事务:

exec会将在

multi和exec中的操作一并提交。 -

取消事务:

discard会将

multi后的所有命令取消。 -

监视一个或者多个

key:watch key...监视一个(或多个)key,如果在事务执行之前这个(或这些) key被其他命令所改动,那么事务将被打断。

-

取消所有

key的监视:unwatch

-

发布/订阅操作:

- 给某个频道发布消息:

publish channel message - 订阅某个频道的消息:

subscribe channel

- 给某个频道发布消息:

第二节:Scrapy-Redis分布式爬虫组件

Scrapy是一个框架,他本身是不支持分布式的。如果我们想要做分布式的爬虫,就需要借助一个组件叫做Scrapy-Redis,这个组件正是利用了Redis可以分布式的功能,集成到Scrapy框架中,使得爬虫可以进行分布式。可以充分的利用资源(多个ip、更多带宽、同步爬取)来提高爬虫的爬行效率。

分布式爬虫的优点:

- 可以充分利用多台机器的带宽。

- 可以充分利用多台机器的ip地址。

- 多台机器做,爬取效率更高。

分布式爬虫必须要解决的问题:

- 分布式爬虫是好几台机器在同时运行,如何保证不同的机器爬取页面的时候不会出现重复爬取的问题。

- 同样,分布式爬虫在不同的机器上运行,在把数据爬完后如何保证保存在同一个地方。

安装:

通过pip install scrapy-redis即可安装。

Scrapy-Redis架构:

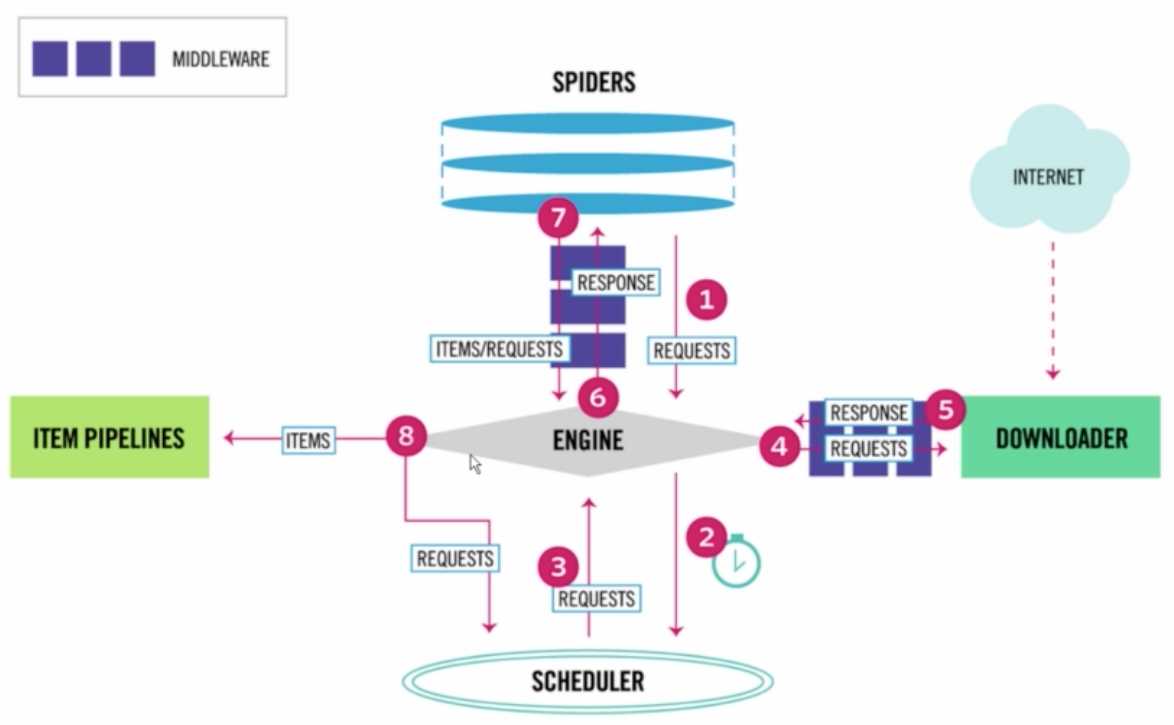

Scrapy架构图:

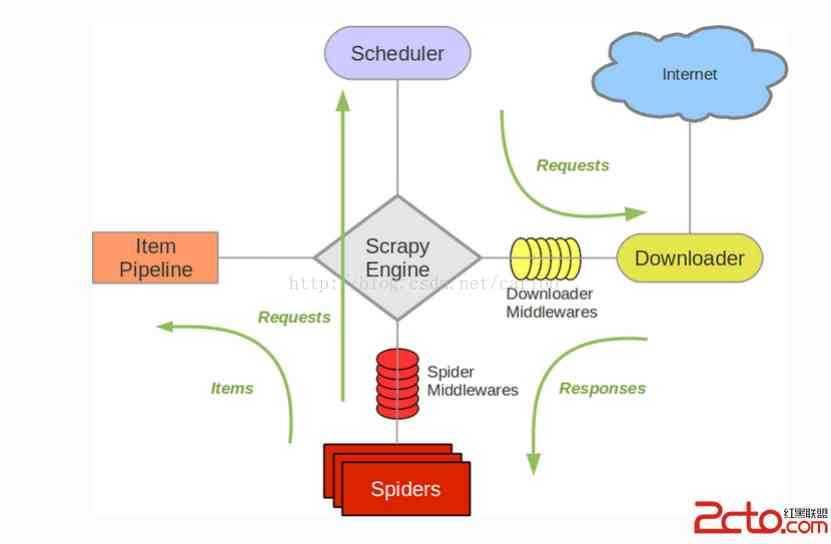

Scrapy-Redis架构图:

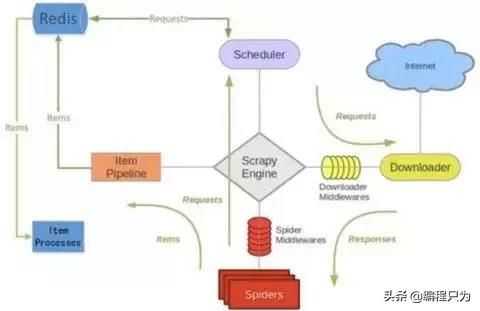

分布式爬虫架构图:

以上两个图片对比我们可以发现。Item Pipeline在接收到数据后发送给了Redis、Scheduler调度器调度数据也是从Redis中来的、并且其实数据去重也是在Redis中做的。

编写Scrapy-Redis分布式爬虫:

要将一个Scrapy项目变成一个Scrapy-redis项目只需修改以下三点就可以了:

- 将爬虫的类从

scrapy.Spider变成scrapy_redis.spiders.RedisSpider;或者是从scrapy.CrawlSpider变成scrapy_redis.spiders.RedisCrawlSpider。 - 将爬虫中的

start_urls删掉。增加一个redis_key="xxx"。这个redis_key是为了以后在redis中控制爬虫启动的。爬虫的第一个url,就是在redis中通过这个发送出去的。 - 在配置文件中增加如下配置:

# Scrapy-Redis相关配置

# 确保request存储到redis中

SCHEDULER = "scrapy_redis.scheduler.Scheduler"

# 确保所有爬虫共享相同的去重指纹

DUPEFILTER_CLASS = "scrapy_redis.dupefilter.RFPDupeFilter"

# 设置redis为item pipeline

ITEM_PIPELINES =

‘scrapy_redis.pipelines.RedisPipeline‘: 300

# 在redis中保持scrapy-redis用到的队列,不会清理redis中的队列,从而可以实现暂停和恢复的功能。

SCHEDULER_PERSIST = True

# 设置连接redis信息

REDIS_HOST = ‘127.0.0.1‘

REDIS_PORT = 6379

- 运行爬虫:

- 在爬虫服务器上。进入爬虫文件所在的路径,然后输入命令:

scrapy runspider [爬虫名字]。 - 在

Redis服务器上,推入一个开始的url链接:redis-cli> lpush [redis_key] start_url开始爬取。

- 在爬虫服务器上。进入爬虫文件所在的路径,然后输入命令:

以上是关于Scrapy-Redis分布式组件的主要内容,如果未能解决你的问题,请参考以下文章