线性回归和梯度下降

Posted matrixmlpforever

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了线性回归和梯度下降相关的知识,希望对你有一定的参考价值。

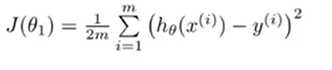

在许多线性回归问题中都可以选择最小二乘法作为代价函数,在之前的文章线性代数——最小二乘法和投影矩阵中讲到过,系数项是可以通过公式 x=(ATA)^-1*ATb 一次性求到的,然而大量的训练数据可能使得ATA没有逆,即便是利用伪逆,其计算量也会很大,所以才有了梯度下降来迭代系数的方法。

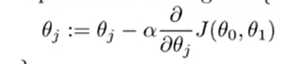

梯度下降法分许多种,这里分析以负梯度为方向更新的方法

、

、

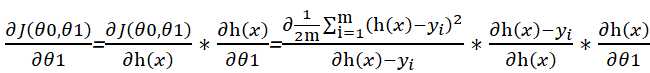

设Θ1为待更新的系数,根据链式法则有

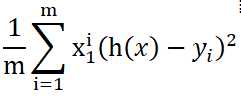

以双系数Θ1,Θ0 为例,h(x)=Θ1x1+Θ0x2+b,对Θ1求偏导后所得值就是x1,最终结果为

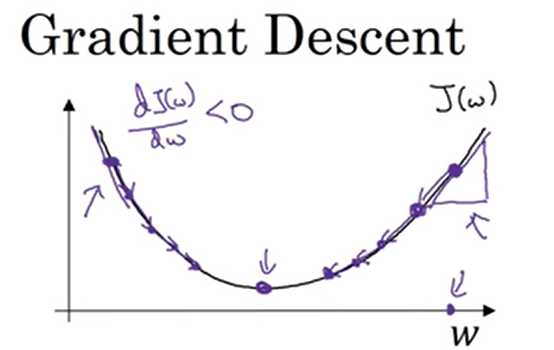

偏导的反方向往往指向局部最低点,所以每次往这个方向更新

其中σ是学习率,学习率的选取很重要,可以将它理解为更新的步幅,如果幅度过大就有可能一步跨过最低点,导致最后没法收敛

以上是关于线性回归和梯度下降的主要内容,如果未能解决你的问题,请参考以下文章