信息量信息熵交叉熵相对熵

Posted gaona666

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了信息量信息熵交叉熵相对熵相关的知识,希望对你有一定的参考价值。

1、信息量

“陈羽凡吸毒?!工作室不是刚辟谣了吗?哇!信息量好大!”

在生活中,极少发生的事情最容易引起吃瓜群众的关注。而经常发生的事情则不会引起注意,比如吃瓜群众从来不会去关系明天太阳会不会东边升起。

信息量的多少与事件发生概率的大小成反比。

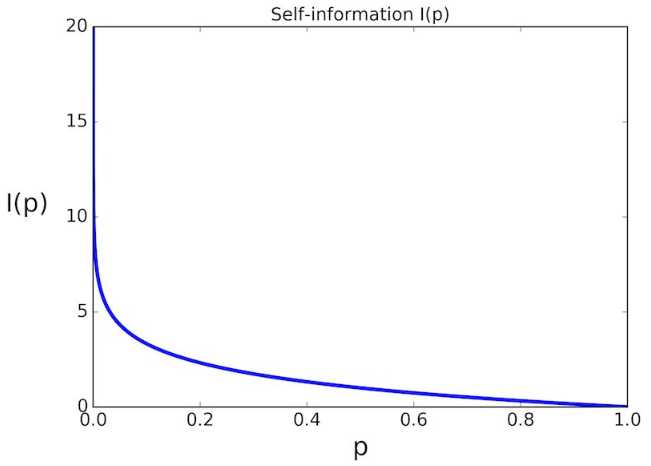

对于已发生的事件i,其所提供的信息量为:![]() 其中底数通常为2,负号的目的是为了保证信息量不为负。

其中底数通常为2,负号的目的是为了保证信息量不为负。

事件i发生的概率与对应信息量的关系如下所示:

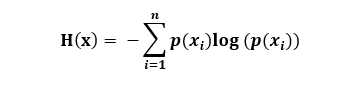

2、信息熵(香农熵)

所有可能发生事件所带来的信息量的期望

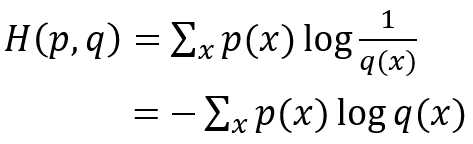

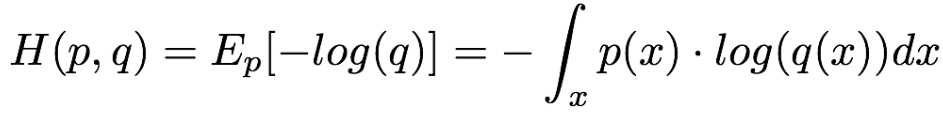

3、交叉熵

如果假设分布概率与真实分布概率一致,那么交叉熵 = 信息熵。

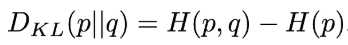

4、相对熵(KL散度)

就是用后验分布 q 来近似先验分布 p 的时候造成的信息损失。再直白一点,就是衡量不同策略之间的差异性

相对熵用来衡量q拟合p的过程中产生的信息损耗,损耗越少,q拟合p也就越好。

转载 https://www.cnblogs.com/wkang/p/10068475.html

以上是关于信息量信息熵交叉熵相对熵的主要内容,如果未能解决你的问题,请参考以下文章