吴恩达《机器学习》课程总结单变量线性回归

Posted ys99

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了吴恩达《机器学习》课程总结单变量线性回归相关的知识,希望对你有一定的参考价值。

2.1模型表示

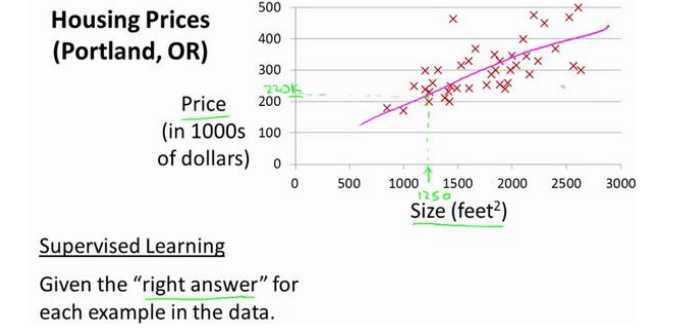

(1)监督学习中的回归问题案例房价预测

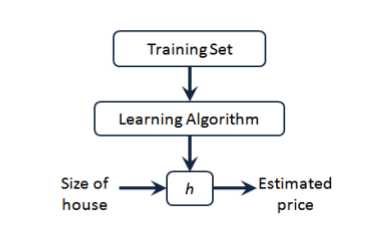

(2)监督算法的工作方式

案例中:m表示训练集的数量,x代表特征/输入变量,y代表目标变量/输出变量,(x,y)代表实例,(x(i),y(i))代表第i个观察实例,h代表假设/函数/输入到输出的映射。

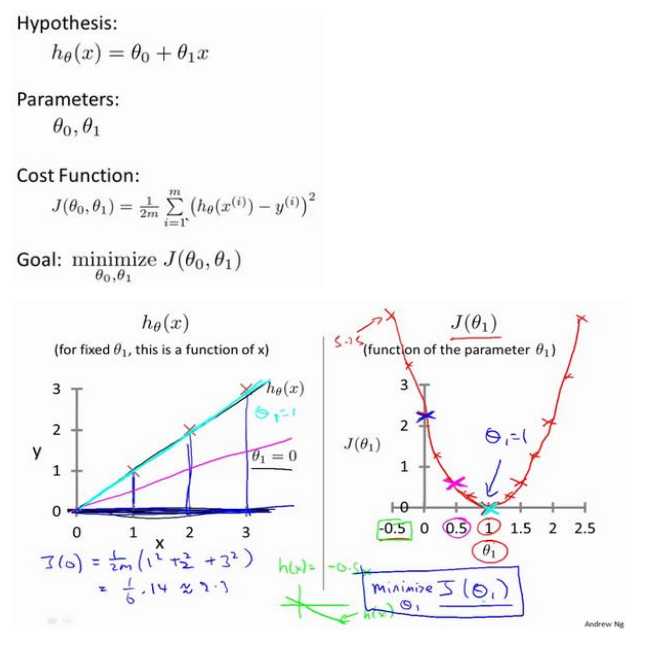

(3)房价预测的一种表达方式:h(Θ)=Θ0+Θ1x,只有一个变量,所以成为当变量线性回归问题。

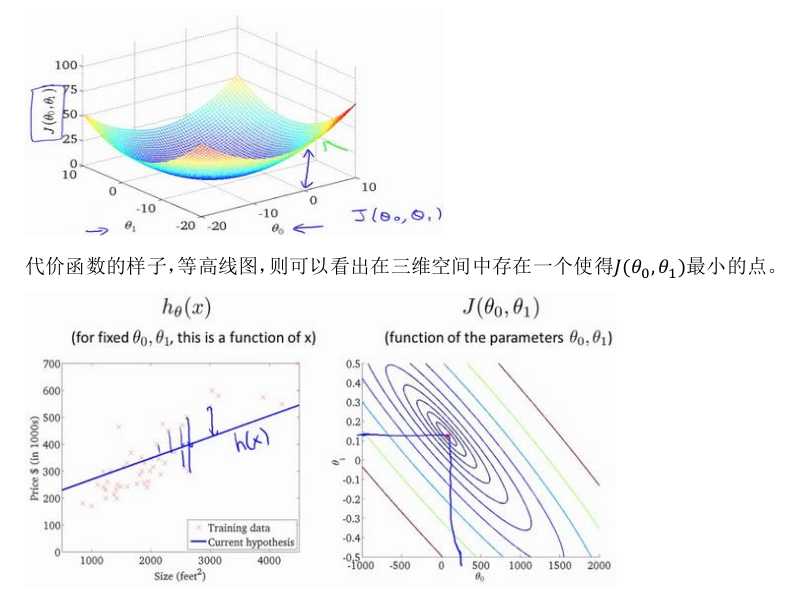

2.2代价函数

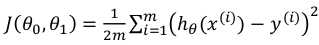

(1)对于回归问题常用的代价函数是平方误差代价函数:

我们的目标选取合适的参数Θ使得误差函数最小,即直线最逼近真实情况。

2.3代价函数的直观理解I

2.4代价函数的直观理解II

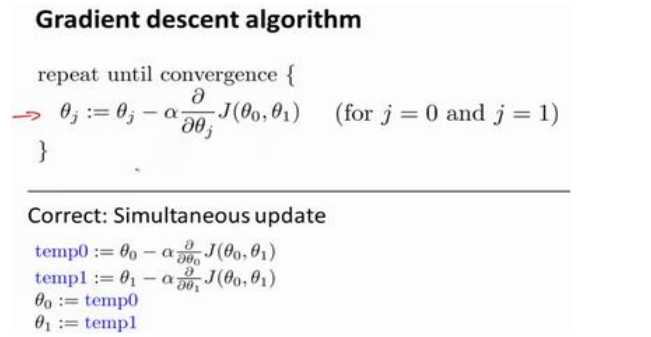

2.5梯度下降

需要注意:参数是要同时更新的;不要算出一个倒数更新一个倒数,再用更新后的式子去计算其他倒数,这样是不对的。

其中α叫学习率,表示沿着下降程度最大的方向迈出的步子大小。

2.6梯度下降的直观理解

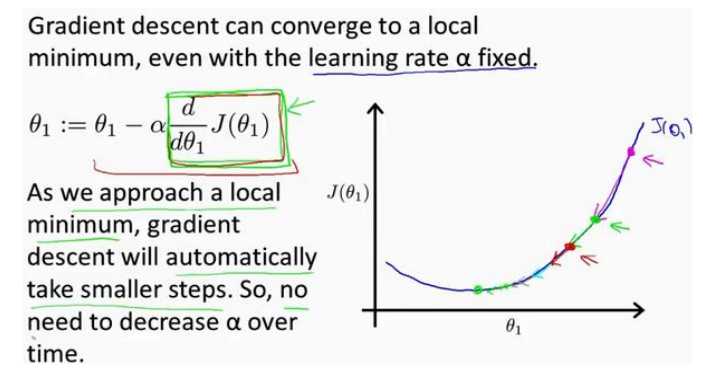

(1)梯度下降法可以最小化任何代价函数,而不仅仅局限于线性回归中的代价函数。

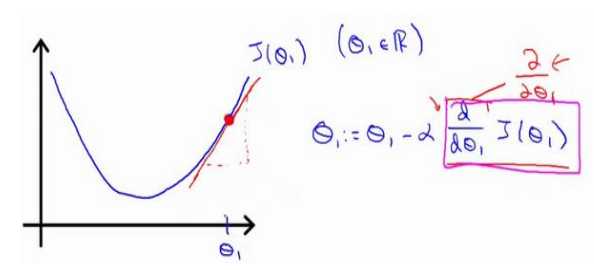

(2)当越来越靠近局部最小值时,梯度值会变小,所以即使学习率不变,参数变化的幅度也会随之减小。

(3)学习率过小时参数变化慢,到达最优点的时间长,学习率大时,可能导致代价函数无法收敛,甚至发散。

(4)梯度就是某一点的斜率。

2.7梯度下降的线性回归

以上是关于吴恩达《机器学习》课程总结单变量线性回归的主要内容,如果未能解决你的问题,请参考以下文章