教你使用Sqoop一次性将mysql中的十张表导入到hive中

Posted it春和

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了教你使用Sqoop一次性将mysql中的十张表导入到hive中相关的知识,希望对你有一定的参考价值。

🏠 个人主页:csdn春和

🛰 推荐专栏:更多专栏尽在主页!

JavaWeb专栏(从入门到实战超详细!!!)

SSM专栏 (更新中)

📖 本期文章:Sqoop一次性将mysql中的十张表同步到hive中

如果对您有帮助还请三连支持,定会一 一回访!

本文目录

前言:这是一篇实验随记文章,记录笔者学习过程中做的一些实验。第八次作业:将mysql中的十张表导入到大数据平台hive中

1、实验需求

一次性将mysql中的十张表导入到hive中

2、实验步骤

0、实验前提

启动hadoop集群并且开启hive服务 hive2后面需要使用到

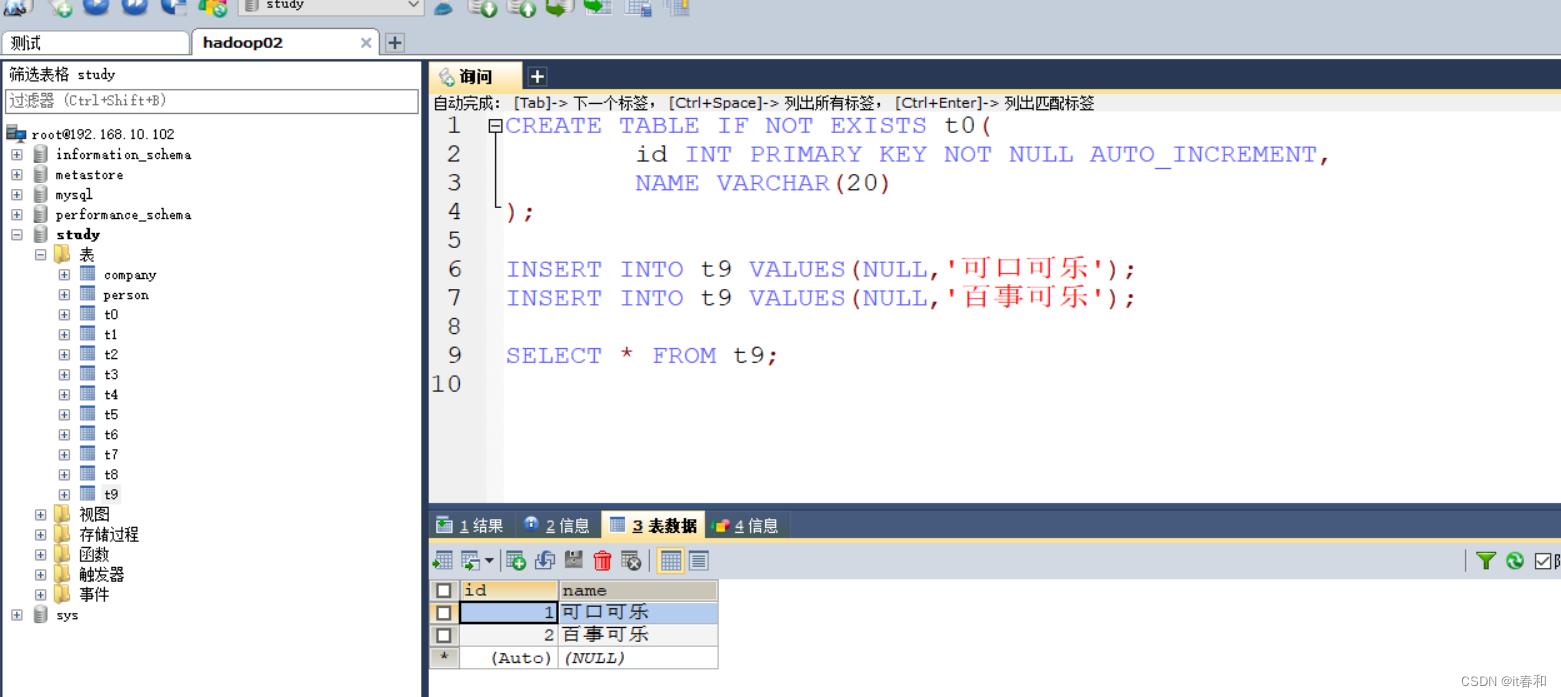

1、在mysql中准备十张表

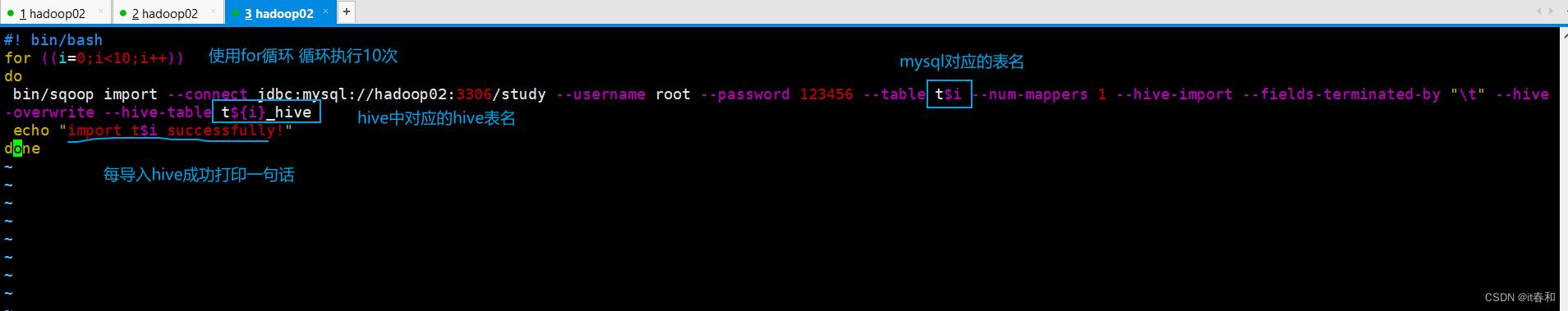

2、编写shell脚本一次性导入十张表

#! bin/bash

for ((i=0;i<10;i++))

do

bin/sqoop import --connect jdbc:mysql://hadoop02:3306/study --username root --password 123456 --table t$i --num-mappers 1 --hive-import --fields-terminated-by "\\t" --hive-overwrite --hive-table t$i_hive

echo "import t$i successfully!"

done

就这样简单的shell脚本编写完成,笔者shell脚本的知识遗忘的厉害,如果您有更好的做法强烈建议您私信我!!!

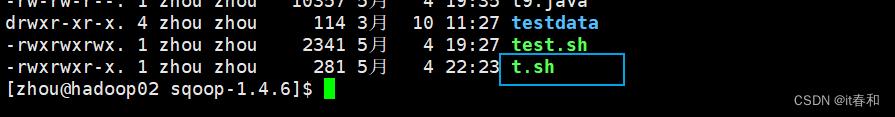

3、修改脚本执行权限

chmod +x t.sh

4、执行脚本

执行t.sh脚本,等待执行完成

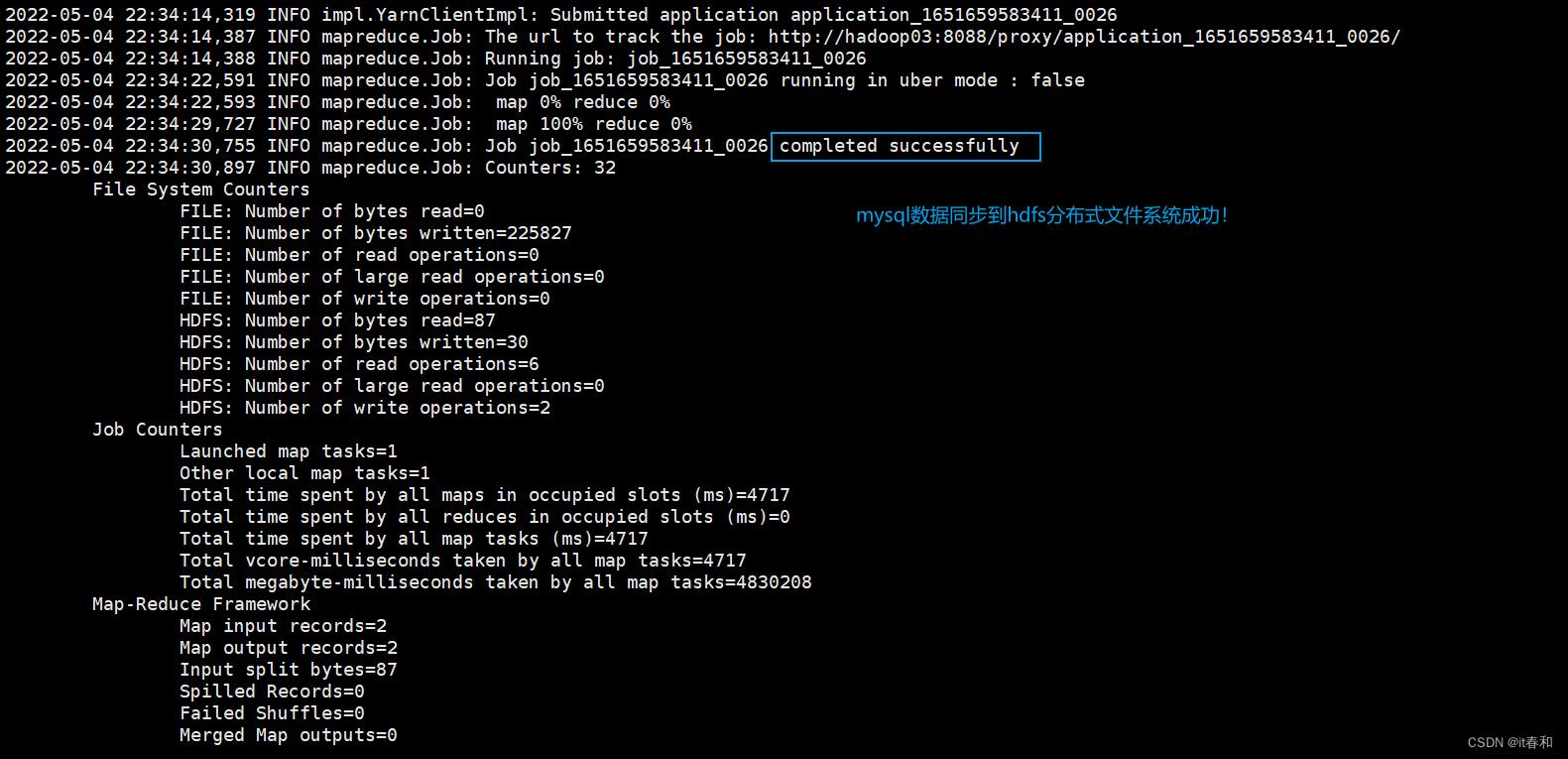

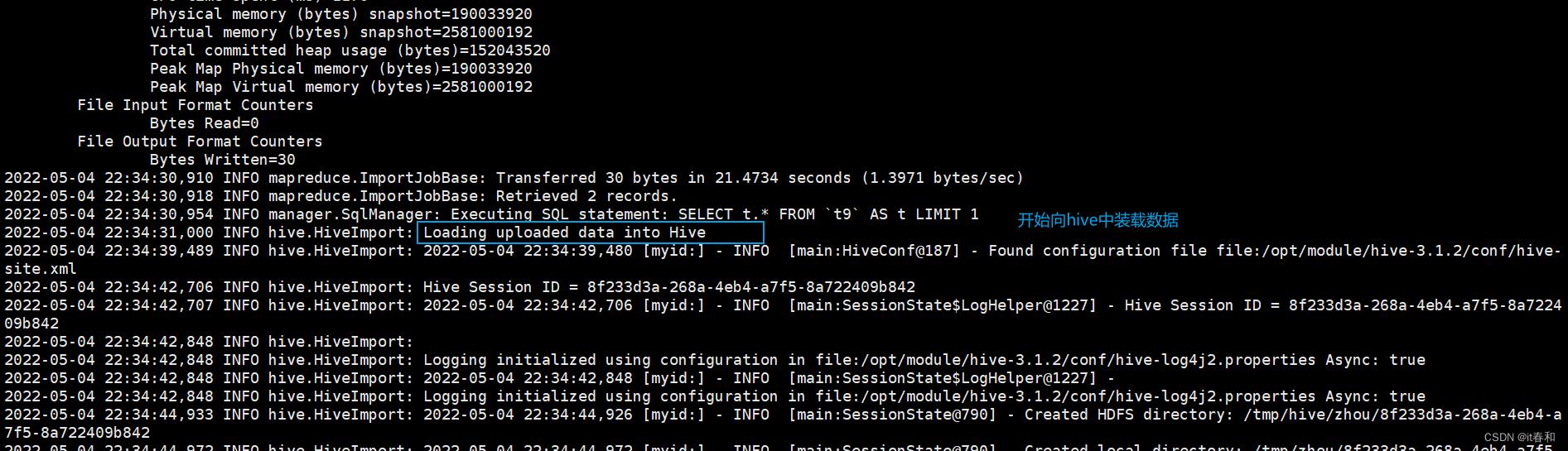

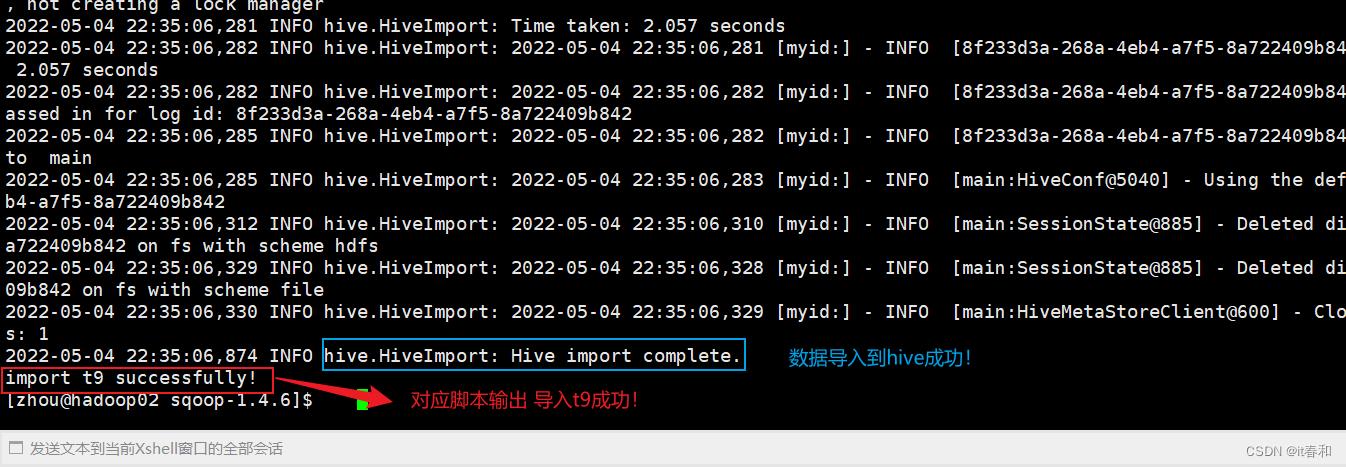

在此之间会有很多日志打印我们挑选一些来看

5、查看实验结果

查看hdfs

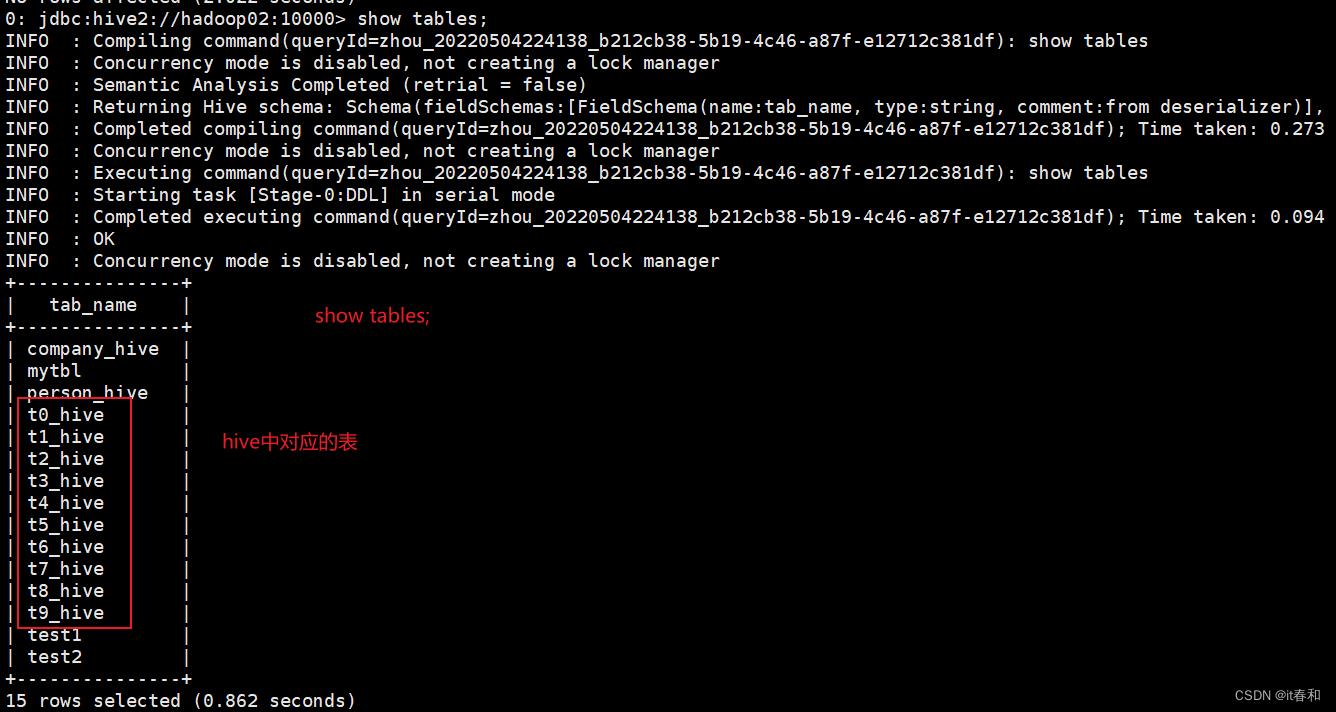

查看hive shell

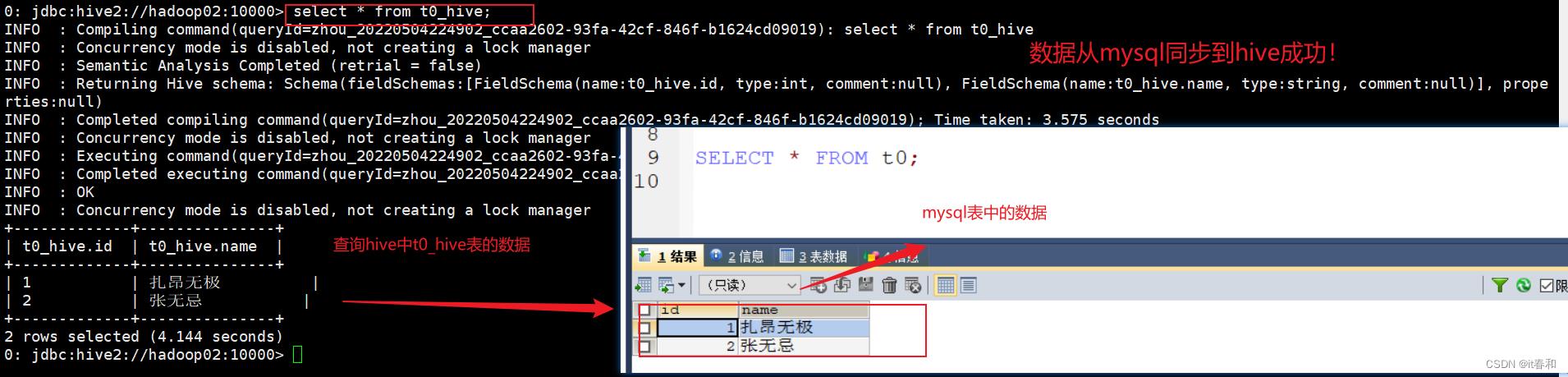

查询数据试试

到此数据从mysql表中导入到hive完成,在这里面也有许多可以优化的地方,比如循环执行怎样提高执行的效率等!这里我们先不做深究…

以上是关于教你使用Sqoop一次性将mysql中的十张表导入到hive中的主要内容,如果未能解决你的问题,请参考以下文章