Pandas 多进程处理数据,速度的确快了很多

Posted Python学习与数据挖掘

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Pandas 多进程处理数据,速度的确快了很多相关的知识,希望对你有一定的参考价值。

python 有自己的多进包 multiprocessing 去实现并行计算,但在Pandas处理数据中,使用 multiprocessing 并不好使,只听见风扇转啊转,就不见运行完毕。

为了提高一点数据清洗的速度,找到一个Pandas多进程的方法,pandarallel 库,做了一下测试。喜欢本文记得收藏、关注、点赞。

【注】文末提供技术交流方式

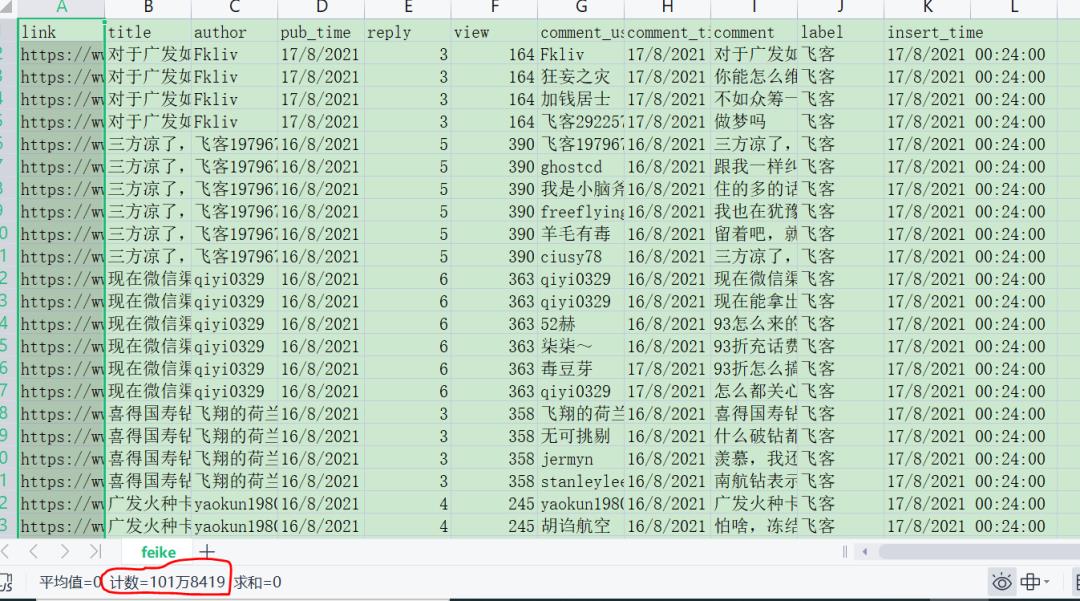

小数据集(先试过了1w)可能多进程还没单进程快,因为进程开启关闭也要一点时间。于是我弄了 100w 数据来测试:

利用以上数据做以下处理:

-

剔除 titile,comment 两列文本中的表情符号

-

title,comment 两列做一个分词处理,覆盖原来的列

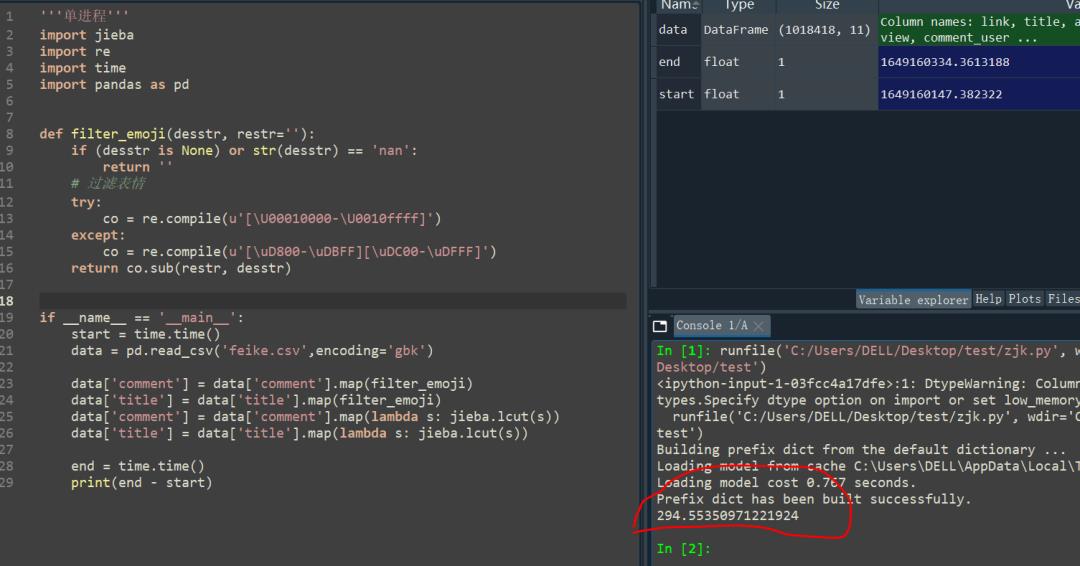

单进程

在交互式环境中输入如下命令:

'''单进程'''

import jieba

import re

import time

import pandas as pd

def filter_emoji(desstr, restr=''):

if (desstr is None) or str(desstr) == 'nan':

return ''

# 过滤表情

try:

co = re.compile(u'[\\U00010000-\\U0010ffff]')

except:

co = re.compile(u'[\\uD800-\\uDBFF][\\uDC00-\\uDFFF]')

return co.sub(restr, desstr)

if __name__ == '__main__':

start = time.time()

data = pd.read_csv('feike.csv',encoding='gbk')

data['comment'] = data['comment'].map(filter_emoji)

data['title'] = data['title'].map(filter_emoji)

data['comment'] = data['comment'].map(lambda s: jieba.lcut(s))

data['title'] = data['title'].map(lambda s: jieba.lcut(s))

end = time.time()

print(end - start)

输出:

在单进程的情况下,可以看到用时 294s,接近 5min 了。

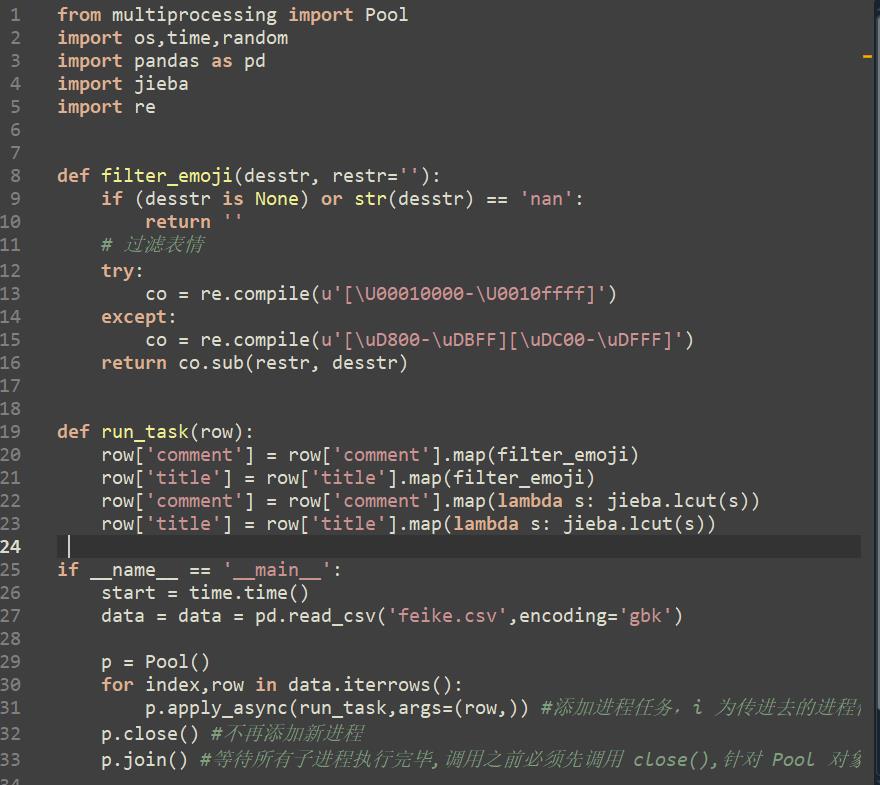

多进程

multiprocessing多进程写法,这种写法网上一搜一大把,代码没有错,多进程任务可以执行。

例如 run_task 函数中的任务是爬虫代码时,没有什么问题,但如果是数据清洗的代码,我测试就很久都跑不出来:

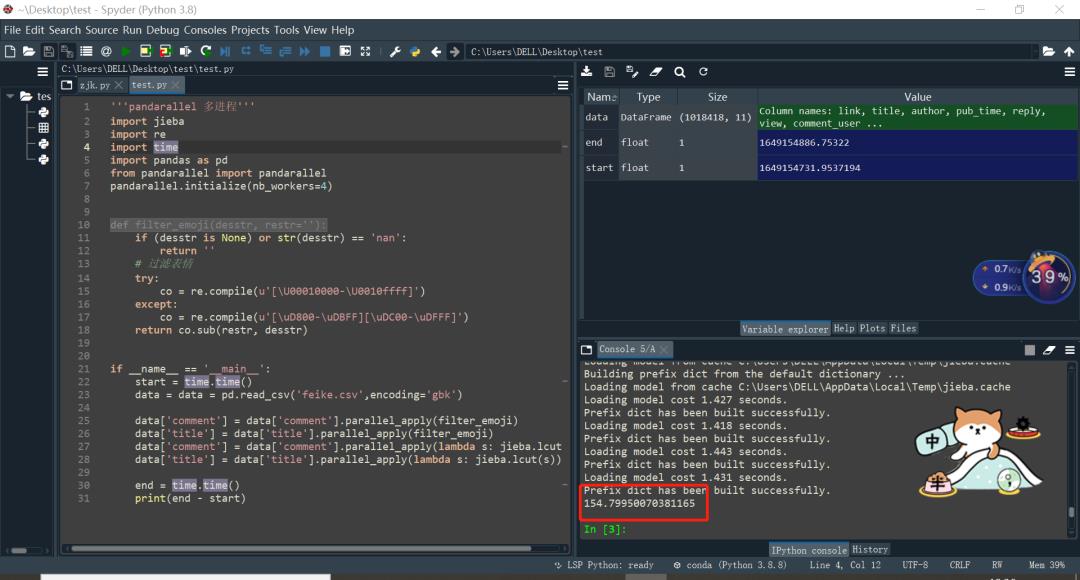

接下来换成Pandas多进程 pandarallel 的写法就可以:

'''pandarallel 多进程'''

import jieba

import re

import time

import pandas as pd

from pandarallel import pandarallel

pandarallel.initialize(nb_workers=4)

def filter_emoji(desstr, restr=''):

if (desstr is None) or str(desstr) == 'nan':

return ''

# 过滤表情

try:

co = re.compile(u'[\\U00010000-\\U0010ffff]')

except:

co = re.compile(u'[\\uD800-\\uDBFF][\\uDC00-\\uDFFF]')

return co.sub(restr, desstr)

if __name__ == '__main__':

start = time.time()

data = data = pd.read_csv('feike.csv',encoding='gbk')

data['comment'] = data['comment'].parallel_apply(filter_emoji)

data['title'] = data['title'].parallel_apply(filter_emoji)

data['comment'] = data['comment'].parallel_apply(lambda s: jieba.lcut(s))

data['title'] = data['title'].parallel_apply(lambda s: jieba.lcut(s))

end = time.time()

print(end - start)

输出:

可以看到改写后时间用时 154s(2min30s),比单进程快了一倍。关于 pandarallel 可以查看文档:https://github.com/nalepae/pandarallel/tree/v1.5.2

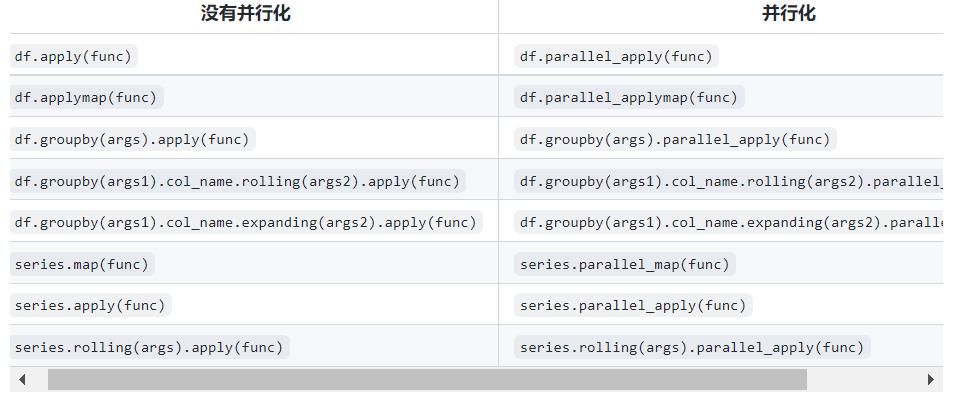

对应的多进程写法函数对照表,Pandas中的 apply,applymap,map 三个函数的区别,写对应的代码:

推荐文章

技术交流

欢迎转载、收藏、有所收获点赞支持一下!

目前开通了技术交流群,群友已超过2000人,添加时最好的备注方式为:来源+兴趣方向,方便找到志同道合的朋友

- 方式①、发送如下图片至微信,长按识别,后台回复:加群;

- 方式②、添加微信号:dkl88191,备注:来自CSDN

- 方式③、微信搜索公众号:Python学习与数据挖掘,后台回复:加群

以上是关于Pandas 多进程处理数据,速度的确快了很多的主要内容,如果未能解决你的问题,请参考以下文章

python中的多处理-在多个进程之间共享大对象(例如pandas数据框)