cdh完美集成kafka

Posted lenmom

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了cdh完美集成kafka相关的知识,希望对你有一定的参考价值。

前言

其实cloudera已经做了这个事了,只是把kafka的包和cdh的parcel包分离了,只要我们把分离开的kafka的服务描述jar包和服务parcel包下载了,就可以实现完美集成了。

具体实现的简要步骤可参照cloudera官网提供的文档:http://www.cloudera.com/content/www/en-us/documentation/kafka/latest/topics/kafka_installing.html,

下面就是我根据这个文档的集成过程。

kafka相关包准备

csd包:http://archive.cloudera.com/csds/kafka/

parcel包: http://archive.cloudera.com/kafka/parcels/latest/ ( 根据自己的集群的系统版本下载 )

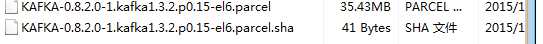

我用的是centos6.5 x64的系统,所以我下载的parcel包为KAFKA-0.8.2.0-1.kafka1.3.2.p0.56-el6.parcel与KAFKA-0.8.2.0-1.kafka1.3.2.p0.56-el6.parcel.sha1

集成实现

-

关闭集群,关闭cm服务( 假如不关闭cm服务,会出现在添加kafka服务时找不到相关的服务描述 )

-

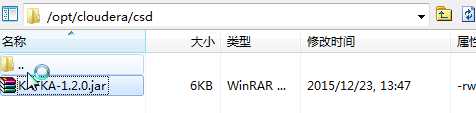

将csd包放到cm安装节点下的 /opt/cloudera/csd目录下,如图 :

- 将parcel包放到cm安装节点下的 /opt/cloudera/parcel-repo目录下,如图:

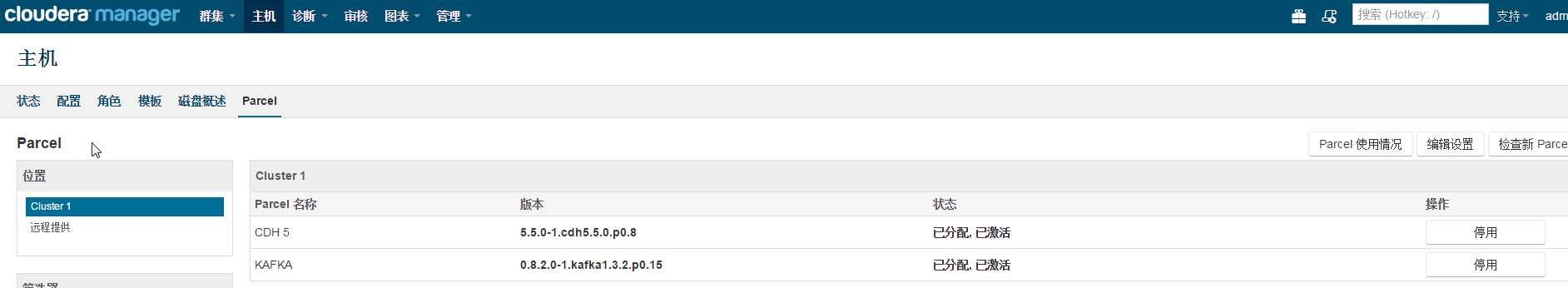

- 启动cm服务,分配并激活percel包

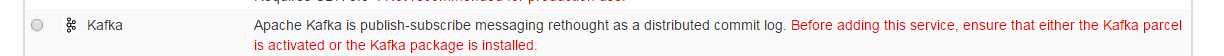

- 添加kafka服务:

- 启动服务

以上是关于cdh完美集成kafka的主要内容,如果未能解决你的问题,请参考以下文章

CDH-Kerberos环境下使用flume消费带Sentry认证的kafka数据保存到hdfs中