LARGE SCALE GAN TRAINING FOR HIGH FIDELITY NATURAL IMAGE SYNTHESIS

Posted 2008nmj

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了LARGE SCALE GAN TRAINING FOR HIGH FIDELITY NATURAL IMAGE SYNTHESIS相关的知识,希望对你有一定的参考价值。

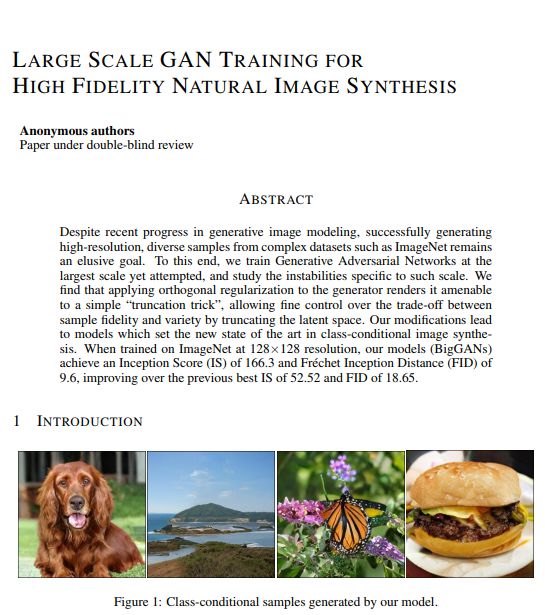

最强GAN图像生成器,真假难辨

论文地址:

https://openreview.net/pdf?id=B1xsqj09Fm

更多样本地址:

https://drive.google.com/drive/folders/1lWC6XEPD0LT5KUnPXeve_kWeY-FxH002

第一篇就是这篇最佳BigGAN,DeepMind负责星际项目的Oriol Vinyals,说这篇论文带来了史上最佳的GAN生成图片,提升Inception Score 100分以上。

论文摘要:

尽管近期由于生成图像建模的研究进展,从复杂数据集例如 ImageNet 中生成高分辨率、多样性的样本仍然是很大的挑战。为此,研究者尝试在最大规模的数据集中训练生成对抗网络,并研究在这种规模的训练下的不稳定性。研究者发现应用垂直正则化(orthogonal regularization)到生成器可以使其服从简单的「截断技巧」(truncation trick),从而允许通过截断隐空间来精调样本保真度和多样性的权衡。这种修改方法可以让模型在类条件的图像合成中达到当前最佳性能。当在 128x128 分辨率的 ImageNet 上训练时,本文提出的模型—BigGAN—可以达到 166.3 的 Inception 分数(IS),以及 9.6 的 Frechet Inception 距离(FID),而之前的最佳 IS 和 FID 仅为 52.52 和 18.65。

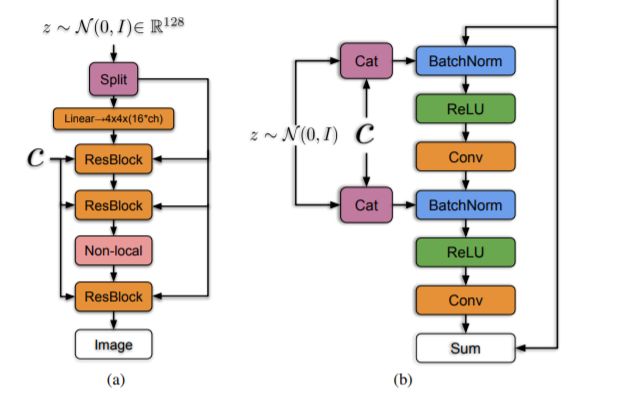

BigGAN的生成器架构

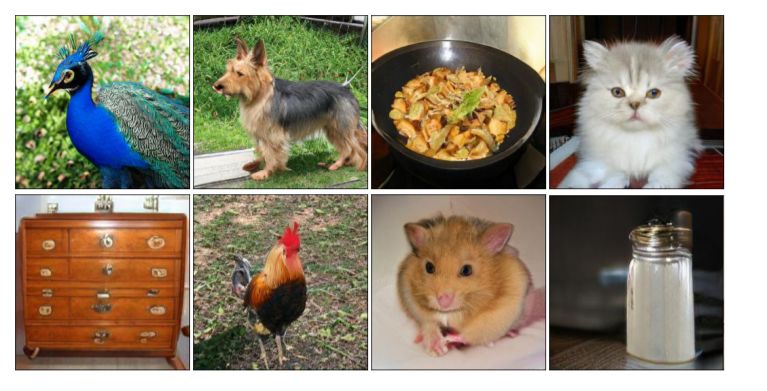

生成样例,真是惟妙惟肖

以上是关于LARGE SCALE GAN TRAINING FOR HIGH FIDELITY NATURAL IMAGE SYNTHESIS的主要内容,如果未能解决你的问题,请参考以下文章

什么情况下使用large training data会非常有效

ON LARGE BATCH TRAINING FOR DEEP LEARNING: GENERALIZATION GAP AND SHARP MINIMA

ON LARGE BATCH TRAINING FOR DEEP LEARNING: GENERALIZATION GAP AND SHARP MINIMA

GPT-2隐私泄露论文阅读:Extracting Training Data from Large Language Models

Cite 1.7KAccurate, Large Minibatch SGD: Training ImageNet in 1 Hour

16 On Large-Batch Training for Deep Learning: Generalization Gap and Sharp Minima 1609.04836v1(示例代码