elk之logstash学习

Posted fenggeblog

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了elk之logstash学习相关的知识,希望对你有一定的参考价值。

Logstash最强大的功能在于丰富的过滤器插件。此过滤器提供的并不单单是过滤的功能,还可以对进入过滤器的原始数据进行复杂的逻辑处理。甚至添加独特的事件到后续流程中。

1、logstash基本语法组成

logstash主要由三部分组成:input、filter、output。而filter就是过滤器插件,这个组件可以不要,但是这样子就不能体现出logtash的强大过滤功能了。

input{

输入插件

}

filter{

过滤器插件

}

outer{

输出插件

}

下面我们依次对各个插件进行介绍

1.1、logstash输入插件(input)

Logstash的输入插件主要用来接收数据,Logstash支持多种数据源,常见的有读取文件、标准输入、读取syslog日志、读取网络数据等,这里分别介绍下每种接收数据源的配置方法

我们先来看个例子:

input{

file{

path => ["/var/log/messages"]

type => "system"

start_position => "timestamp"

}

}

output{

stdout{

codec => rubydebug

}

}

这时我们有几个小疑问:

1、logstash的input是怎么样接收日志的呢?

logstash使用一个名为filewatch的ruby gem库来监听文件变化,并通过一个叫.sincedb的数据库文件来记录被监听的日志文件的读取进度(时间戳)。这个sincedb数据文件的默认路径在 <path.data>/plugins/inputs/file下面,文件名类似于.sincedb_452905a167cf4509fd08acb964fdb20c。而<path.data>表示logstash插件存储目录,默认是LOGSTASH_HOME/data。(rpm包安装则是在/usr/share/logstash目录下)。

2、logstash的input技术跟Linux的那个比较像呢?

input就跟Linux的管道右侧内容一样,在Linux管道中,左侧的输出传给管道的右侧接收机制。而input就是如此,当他监听一个文件时,会以tail -f命令的形式逐行获取数据。不过input可以指定从哪个地方(某一时间戳)开始读取,而start_position就是指定时间戳。如果不指定则从头开始读取。type则是用来标记时间类型。

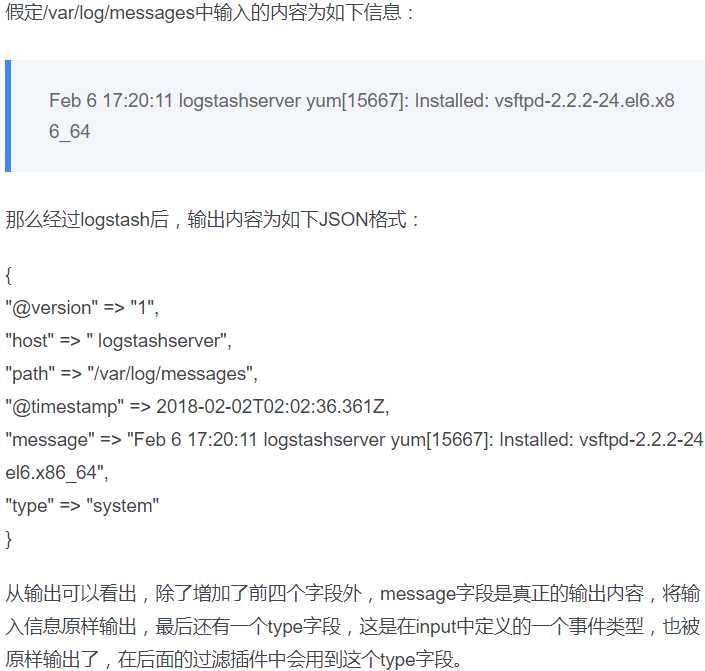

下面举个例子来看:

1.2、标准输入

stdin是从标准输入获取信息的。这里我们看一个稍微复杂一点的例子:

input { stdin { add_field => {"key"=>"apple"} tags => ["add1"] type => "test1" } } output { stdout { codec => rubydebug } }

然后我们启动一下终端,大家要注意,我这里没有指定输入文件,而指定的是stdin,表示标准输入,意思就是交互式输入数据。

[[email protected]::172.31.22.29 /etc/logstash/conf.d]#/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/l1.conf Sending Logstash logs to /var/log/logstash which is now configured via log4j2.properties hello word #手动输入此信息 { "type" => "test1", "@version" => "1", "message" => "hello word", "@timestamp" => 2019-01-22T05:42:08.340Z, "tags" => [ [0] "add1" ], "host" => "ip-172-31-22-29.ec2.internal", "key" => "apple" }

type和tags是logstash的两个特殊字段, type一般会放在input中标记事件类型, tags主要用于在事件中增加标签,以便在后续的处理流程中使用,主要用于filter或output阶段。

2、logstash编码插件(Codec)

前面的例子中,其实我们就已经用过编码插件codec了,就是这个rubydebug,它就是一种codec。

编码插件(codec)可以在logstash输入或输出时处理不同类型的数据,同时,还可以更好更方便的与其他自定义格式的数据产品共存,比如:fluent、netflow、collectd等通用数据格式的其他产品。因此,logstash不只是一个input-->filter-->output的数据流,而且是一个input-->decode-->filter-->encode-->output的数据流。

codec支持的编码格式常见有plain、json、json_lines等,下面依次介绍:

1、codec插件之plain

plain是最简单的编码插件,你输入什么信息,就返回什么信息,诸如上面的例子中的timestamp、type等都不会带有:

修改一下配置文件:

input { stdin { } } output { stdout { codec => plain } }

现在我们启动一下:

[[email protected]::172.31.22.29 /etc/logstash/conf.d]#/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/l1.conf Sending Logstash logs to /var/log/logstash which is now configured via log4j2.properties2019-01-22T06:10:14.161Z ip-172-31-22-29.ec2.internal hello word #在此输入信息 2019-01-22T06:10:19.382Z ip-172-31-22-29.ec2.internal hello word

2、codec插件之json、json_lines

有时候logstash采集的日志是JSON格式,那我们可以在input字段加入codec => json来进行解析,这样就可以根据具体内容生成字段,方便分析和储存。如果想让logstash输出为json格式,可以在output字段加入codec=>json。下面是一个包含json编码的时间配置文件:

input { stdin { } } output { stdout { codec => json } }

启动一下:

[[email protected]:172.31.22.29 /etc/logstash/conf.d]#/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/l1.conf Sending Logstash logs to /var/log/logstash which is now configured via log4j2.properties hello word #输入此行信息 {"host":"ip-172-31-22-29.ec2.internal","@version":"1","message":"hello word","@timestamp":"2019-01-22T06:27:27.191Z"}

你会发现插件是json的时候,。他会自带一些信息,诸如host、@version、@timestamp。json的每个字段都是key:value格式,多个字段之间通过逗号分隔。这种输出比较长,因此我们采用json_lines编码格式稍微好一点。

以上是关于elk之logstash学习的主要内容,如果未能解决你的问题,请参考以下文章