基于RK3399+YOLO目标检测人工智能图像系统设计

Posted 深圳信迈科技DSP+ARM+FPGA

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了基于RK3399+YOLO目标检测人工智能图像系统设计相关的知识,希望对你有一定的参考价值。

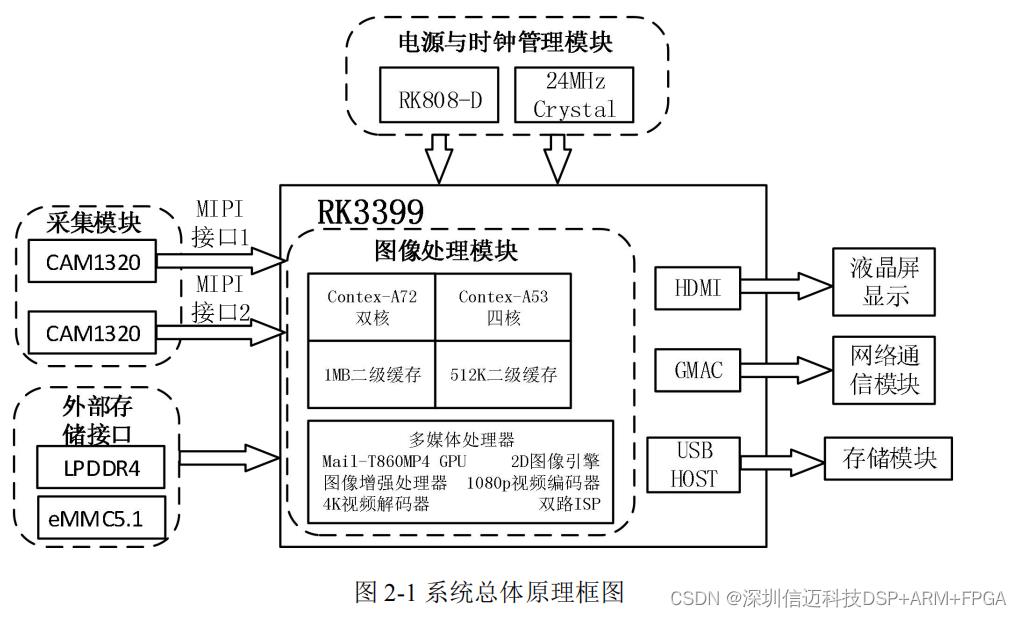

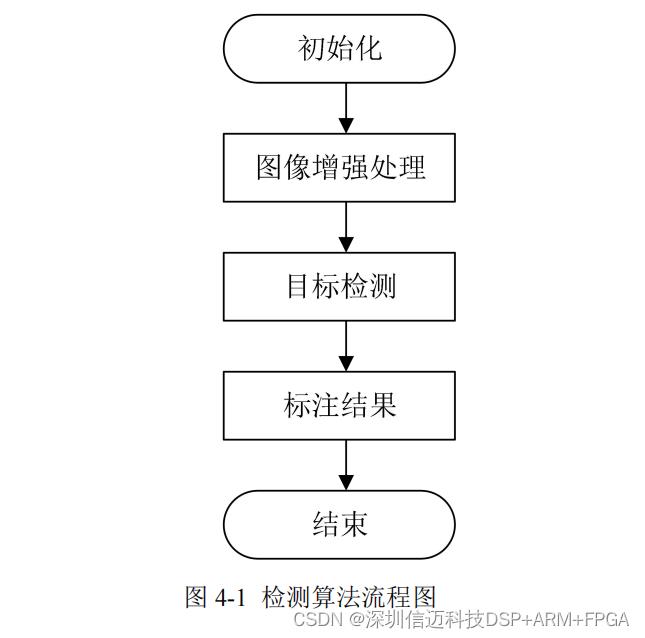

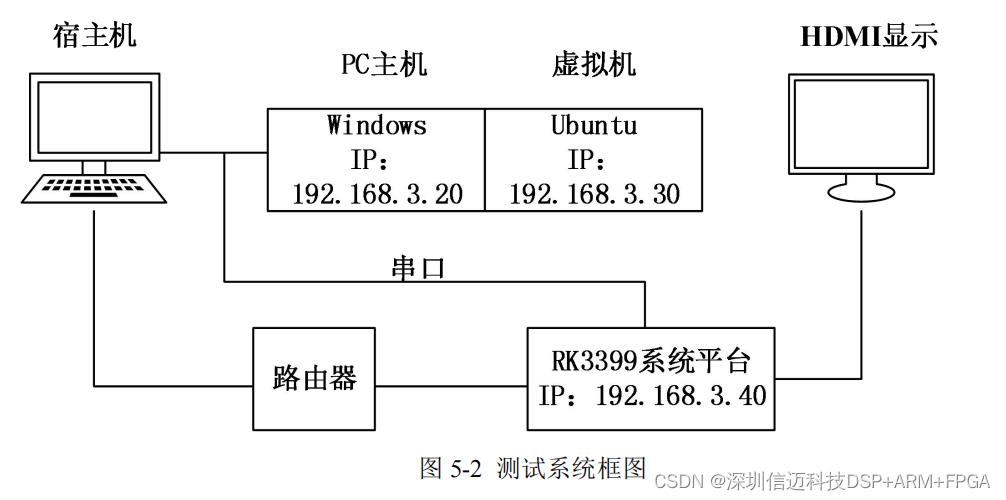

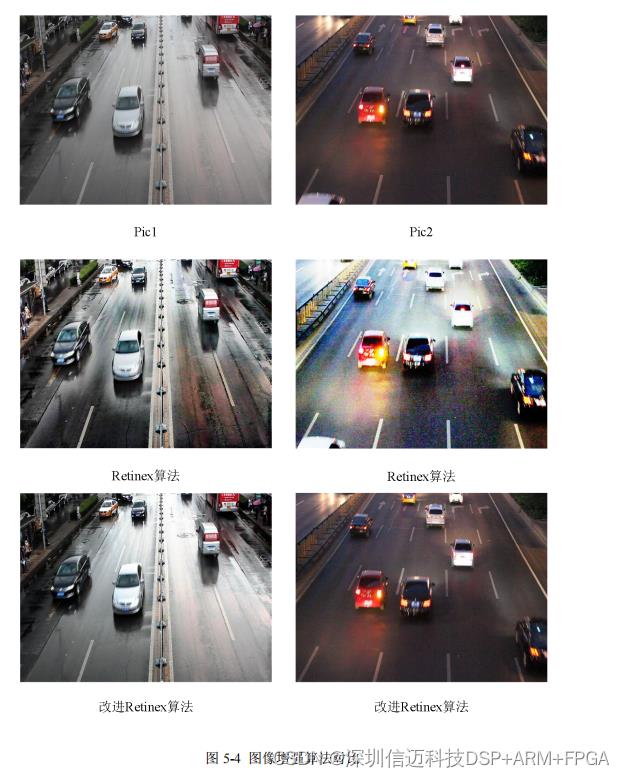

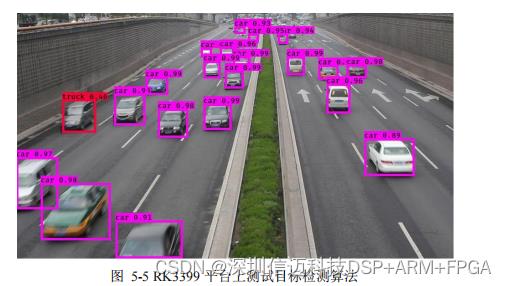

随着 5G 通信技术的大范围普及,传统的目标检测系统已经不再能满足如今步入智 能化的各行各业的需求。消费者对以往依靠机器学习的传统目标检测系统提出了更高的 要求,相关的生产企业也开始向智能化和低功耗化过渡。其中如何将图像增强技术、目 标检测技术与神经网络相结合,移植到便携的嵌入式平台已经成为了如今开发人员研究 的热点。本课题设计了一种基于异构处理器的目标检测系统,可以针对一些目标物体密 集的特定环境下可以对目标物体进行高效准确地识别。 本文首先对目标检测系统的总体进行了设计,在硬件设计方面选用多核异构的 ARM 处理器 RK3399 作为核心处理器,图像采集模块选用了 CAM1320 模组,并且搭建外围 附属电路,完成硬件设计;软件部分对卷积神经网络进行了介绍。如今主流的目标检测 算法将图像的像素矩阵通过卷积和池化处理提取出特征信息,在全连接层对图像进行类 别预测。并对其中的典型代表算法 YOLOv3 中的网络结构、边界框和损失函数进行了分 析。通过对比 YOLOv3 和其他目标检测算法的性能指标,最终选择了 YOLOv3 作为本 文算法改进的基础。 之后对系统的目标检测的软件部分整体进行了阐述。首先介绍了基于 HSI 的图像增 强算法,对图像的特征信息和色彩信息分别做多尺度 Retinex 增强和色彩拉伸处理,将 增强后的图像作为目标检测算法的输入。然后针对 YOLOv3 在检测特定环境下所表现出 的目标漏检和检测分类集中现象,对 YOLOv3 算法做出了优化,一方面引入了 SE 单元 加强特征,另一方面将原先的三个尺度输出优化为针对密集环境的四尺度输出。 最后在目标检测系统平台的交叉编译调试环境进行搭建后,将优化后的神经网络模 型移植到嵌入式平台上,对目标检测系统平台进行测试,通过对图像的各项参数和目标 检测的准确率等指标分析,并得出实验结论,证明该目标检测系统可以有效增强图像, 其识别有效率达到 92.56% ,系统满足实际场景的高准确性需求。 针对系统目标检测硬件处理的需求,本论文设计了一种基于多核异构架构 ARM 的 嵌入式目标检测系统平台。系统原理框图如下:

信迈RK3399开发板

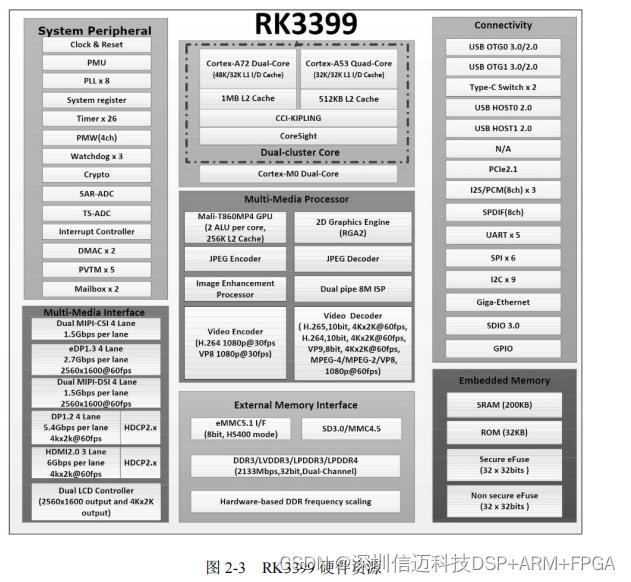

在图 2-2 所示的 信迈RK3399 硬件图中, RJ45 接口在本文设计的系统中用于连接网线进行图像传输、HDMI 接口用于连接屏幕进行显示、USB 插槽用于插入 U 盘保存文件、 其他空余 IO 口可以对系统功能进行扩展、MIPI 接口用于连接图像传感器进行视频采 集,通过串口和网口对系统进行实时调试。图 2-3 为 RK3399 的硬件资源图。

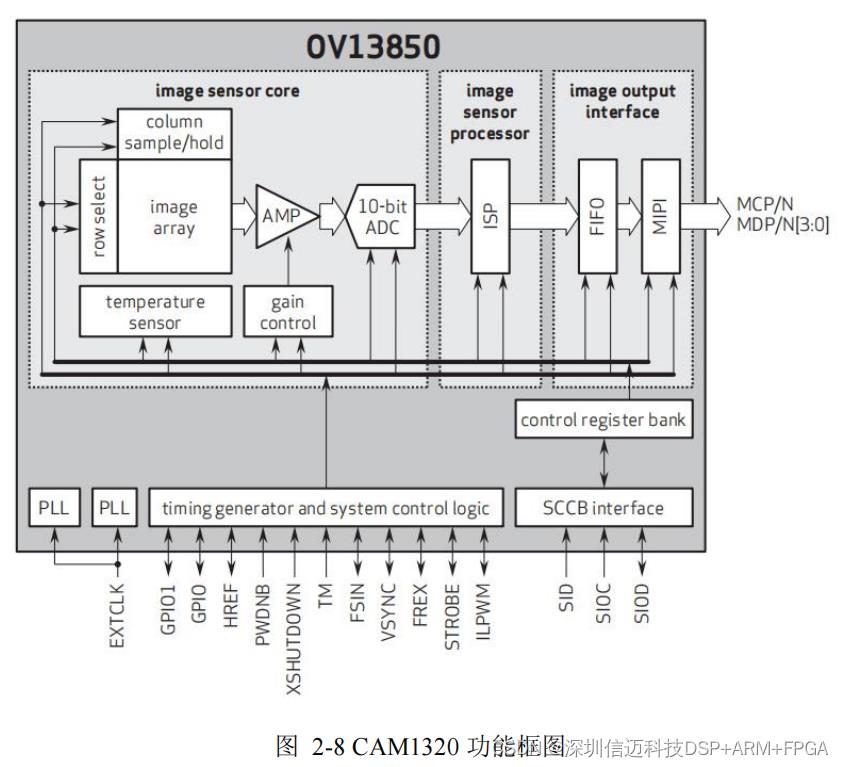

当

CPU

发出采集命。令时,图像采集模块开始采集视频图像。采集过程中,传感器

会将采集到的模拟信号经过自带的处理模块进行自动增益等处理,之后模拟信号会由

A/D

转换模块转换为数字信号,便于嵌入式平台进行处理,并由传感器自带的

FIFO

对

高速数据进行缓存,之后由处理器将

FIFO

中的数据读取到

DDR

中进行后续的图像算法

处理。

OV13850

图像传感器采用标准的

Serial Camera Control Bus

(

SCCB

)协议,

SCCB

协 议与 I2C

协议极其相似,由时钟信号线

SIOC

和传输信号线

SIOD

组成,与

I2C

总线 不同的是 SCCB

一次传输

9

位数据,前

8

位为有用数据,第

9

位为无效位。其

OV13850 传感器的 RGB

输出时序如图

2-9

所示:

当

CPU

发出采集命。令时,图像采集模块开始采集视频图像。采集过程中,传感器

会将采集到的模拟信号经过自带的处理模块进行自动增益等处理,之后模拟信号会由

A/D

转换模块转换为数字信号,便于嵌入式平台进行处理,并由传感器自带的

FIFO

对

高速数据进行缓存,之后由处理器将

FIFO

中的数据读取到

DDR

中进行后续的图像算法

处理。

OV13850

图像传感器采用标准的

Serial Camera Control Bus

(

SCCB

)协议,

SCCB

协 议与 I2C

协议极其相似,由时钟信号线

SIOC

和传输信号线

SIOD

组成,与

I2C

总线 不同的是 SCCB

一次传输

9

位数据,前

8

位为有用数据,第

9

位为无效位。其

OV13850 传感器的 RGB

输出时序如图

2-9

所示:

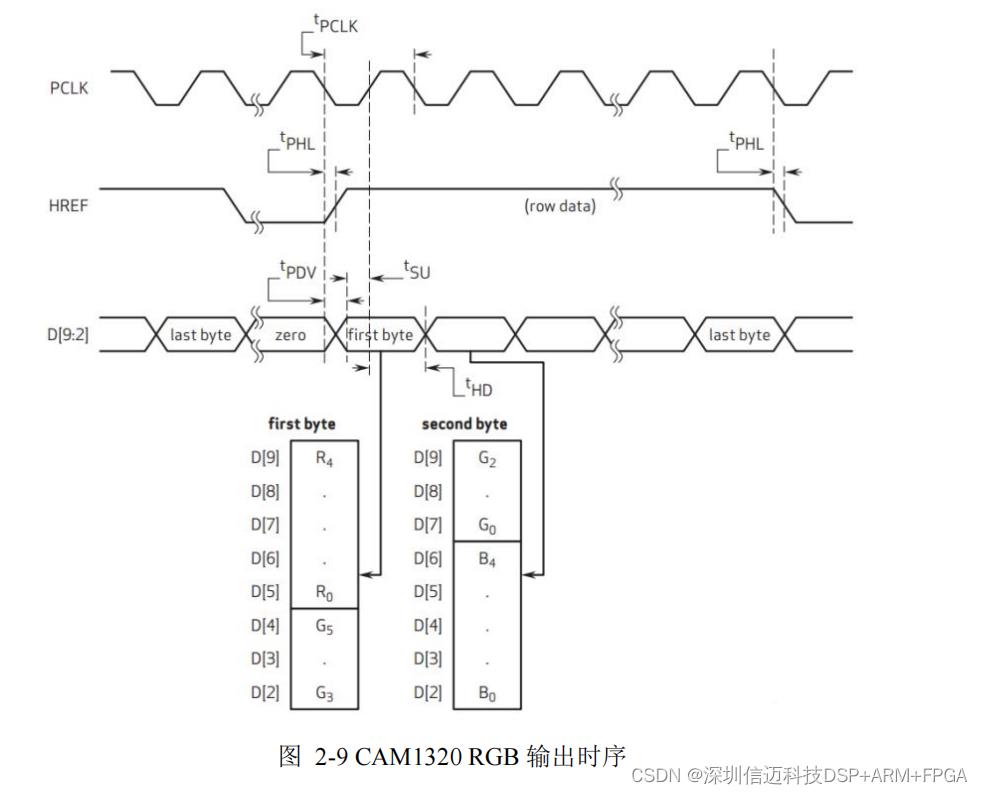

从图

2-9

中,可以看到

CAM1320

图像数据通过

D [9

:

2]

输出一个字节,前两个字节

形成

16

位

RGB565

数据。在时序图中,当

HREF

为高电平时,数据传输开始,一个

PCLK

传输一个字节,而当最后一个字节传输完成时,

HREF

变为低电平。

HREF

周期由

640 tp

和

144 tp

组成。

1

个

t

PCLK

发送

1

个字节。

480

个

HREF

周期组成一个帧,在

8t

LINE

时

间后,

VSYNC

将形成一个上升沿以表示图像传输帧的结束。

3

目标检测算法研究

本章的主要对基于卷积神经网络的典型检测算法代表

YOLOv3

进行了详细分析。与

传统目标检测算法相比,引入卷积神经网络可以使目标检测算法受环境因素的影响较

小,更适用于外界环境。同时将几种基于神经网络的目标检测算法进行性能对比,选择

最符合本课题需求的

YOLOv3

作为本课题系统改进优化的算法基础。

3.1

卷积神经网络相关知识简介

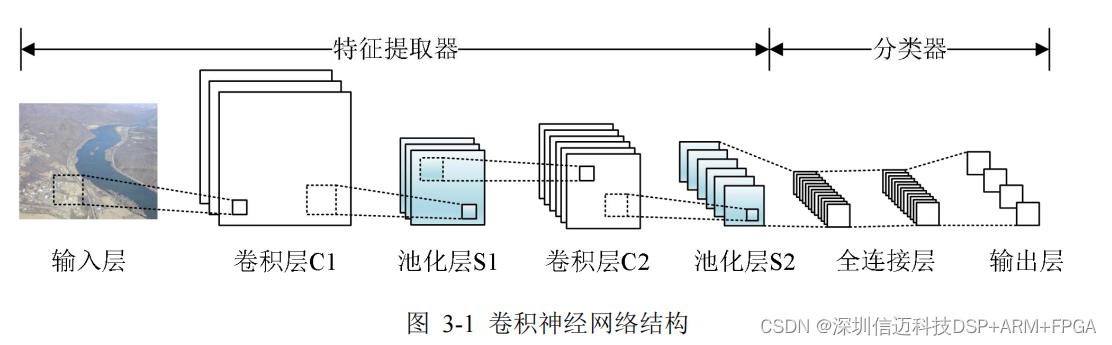

卷积神经网络(

Convolutional Neural Network

)在多层感知器的基础上增加了卷积

和池化对图像进行处理

[25]

,属于一种前馈神经网络。常见的卷积神经网络结构如图

3-1

,

卷积神经网络通常包括特征提取器和分类器,其中特征提取器由三个部分组成:输入层

(即待检测图像对应像素矩阵)、卷积层和池化层;分类器包括全连接层和输出层。在

训练学习时,像素矩阵经过卷积和池化处理后提取出图像中物体的特征信息,全连接层

负责把各个物体的特征信息如颜色、轮廓等转化为一维特征向量。网络的最后一层即输

出层通过目标物体的预测值及损失函数计算出物体所属类别的概率,通过进行比较,将

概率最高的结果输出

[26]

。

从图

2-9

中,可以看到

CAM1320

图像数据通过

D [9

:

2]

输出一个字节,前两个字节

形成

16

位

RGB565

数据。在时序图中,当

HREF

为高电平时,数据传输开始,一个

PCLK

传输一个字节,而当最后一个字节传输完成时,

HREF

变为低电平。

HREF

周期由

640 tp

和

144 tp

组成。

1

个

t

PCLK

发送

1

个字节。

480

个

HREF

周期组成一个帧,在

8t

LINE

时

间后,

VSYNC

将形成一个上升沿以表示图像传输帧的结束。

3

目标检测算法研究

本章的主要对基于卷积神经网络的典型检测算法代表

YOLOv3

进行了详细分析。与

传统目标检测算法相比,引入卷积神经网络可以使目标检测算法受环境因素的影响较

小,更适用于外界环境。同时将几种基于神经网络的目标检测算法进行性能对比,选择

最符合本课题需求的

YOLOv3

作为本课题系统改进优化的算法基础。

3.1

卷积神经网络相关知识简介

卷积神经网络(

Convolutional Neural Network

)在多层感知器的基础上增加了卷积

和池化对图像进行处理

[25]

,属于一种前馈神经网络。常见的卷积神经网络结构如图

3-1

,

卷积神经网络通常包括特征提取器和分类器,其中特征提取器由三个部分组成:输入层

(即待检测图像对应像素矩阵)、卷积层和池化层;分类器包括全连接层和输出层。在

训练学习时,像素矩阵经过卷积和池化处理后提取出图像中物体的特征信息,全连接层

负责把各个物体的特征信息如颜色、轮廓等转化为一维特征向量。网络的最后一层即输

出层通过目标物体的预测值及损失函数计算出物体所属类别的概率,通过进行比较,将

概率最高的结果输出

[26]

。

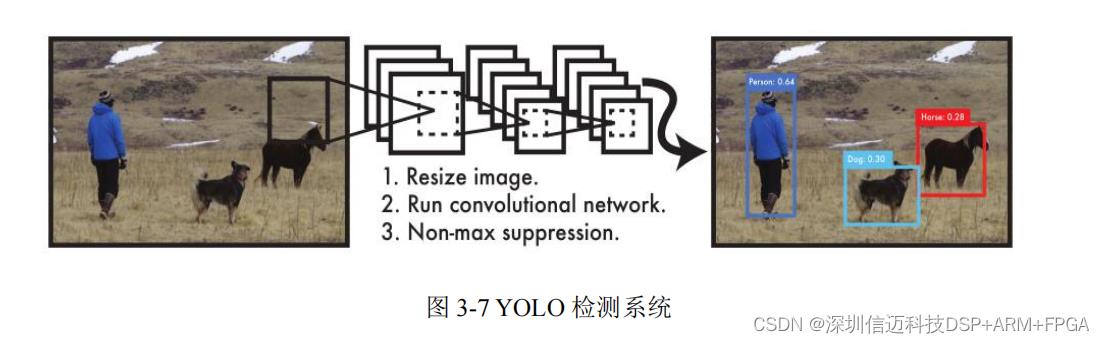

3.2 YOLO

目标检测算法

YOLO

是由

Joseph Redmon

在

Faster R-CNN

的基础上提出

[38]

,其创新点是在保持

较高检测精度的前提下实现了对整幅图片的实时检测。

YOLO

将目标检测问题转化为回

归问题

[39]

,通过使用神经网络对图像进行遍历,对图像中的目标物体进行预测并分类。

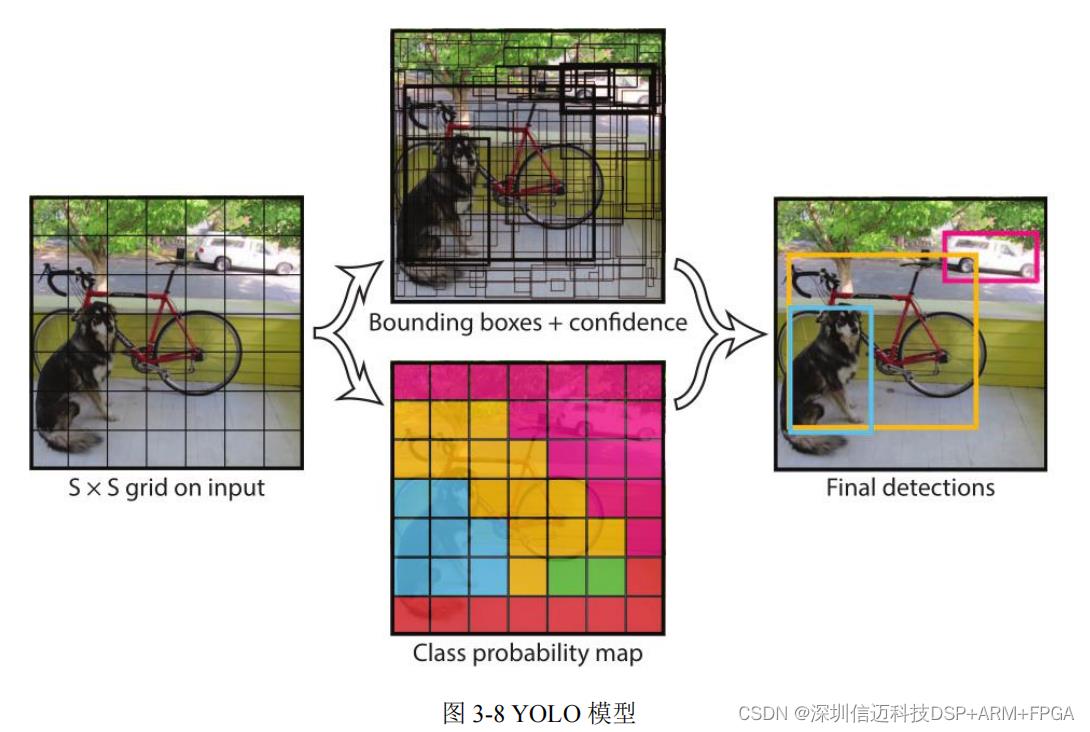

YOLO

算法首先将输入的图片重新调整为适合检测的尺寸,之后使用神经网络对图像进

行处理,将输入图片平均分为若干个网格,待识别物体的中心处于的网格负责对该物体

进行预测识别。

3.2 YOLO

目标检测算法

YOLO

是由

Joseph Redmon

在

Faster R-CNN

的基础上提出

[38]

,其创新点是在保持

较高检测精度的前提下实现了对整幅图片的实时检测。

YOLO

将目标检测问题转化为回

归问题

[39]

,通过使用神经网络对图像进行遍历,对图像中的目标物体进行预测并分类。

YOLO

算法首先将输入的图片重新调整为适合检测的尺寸,之后使用神经网络对图像进

行处理,将输入图片平均分为若干个网格,待识别物体的中心处于的网格负责对该物体

进行预测识别。

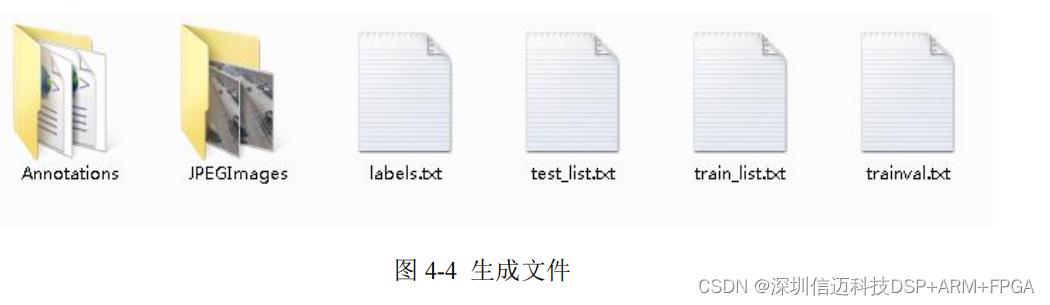

最终得到的数据集文件如下所示。

以上是关于基于RK3399+YOLO目标检测人工智能图像系统设计的主要内容,如果未能解决你的问题,请参考以下文章

RK3399pro + K7/A7 FPGA+ AI国产人工智能图像处理平台