框架---scrapy(基本用法)

Posted tingshu

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了框架---scrapy(基本用法)相关的知识,希望对你有一定的参考价值。

https://docs.scrapy.org/en/latest/topics/commands.html (官方文档)

1.scrapy startproject hello

此时会生成一个hello工程,同时生成一个srapy.cfg配置文件和一个同名文件夹

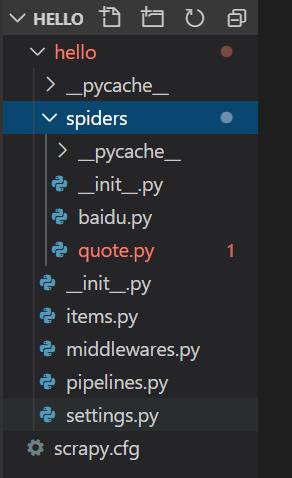

2.srapy genspider quote quotes.toscrape.com

items.py,定义了保存数据时的数据结构

middlewares.py,处理中间件,可以处理request,response等

pipelines.py,可以

settings.py,配置信息

quote.py,主要代码实现在该spider中

3.spider crawl quote (quote为创建的spider,注意不要带.py后缀)

爬取网页并解析,输出结果到屏幕

spider crawl quote -o quotes.json

将结果输出到json文件中

同时还支持其他文件方式的保存,如:quotes.csv,quotes.marshal,quotes.xml

spider crawl quote -o ftp://username:pass@ftp.example.com/path/quotes.csv

4.spider介绍

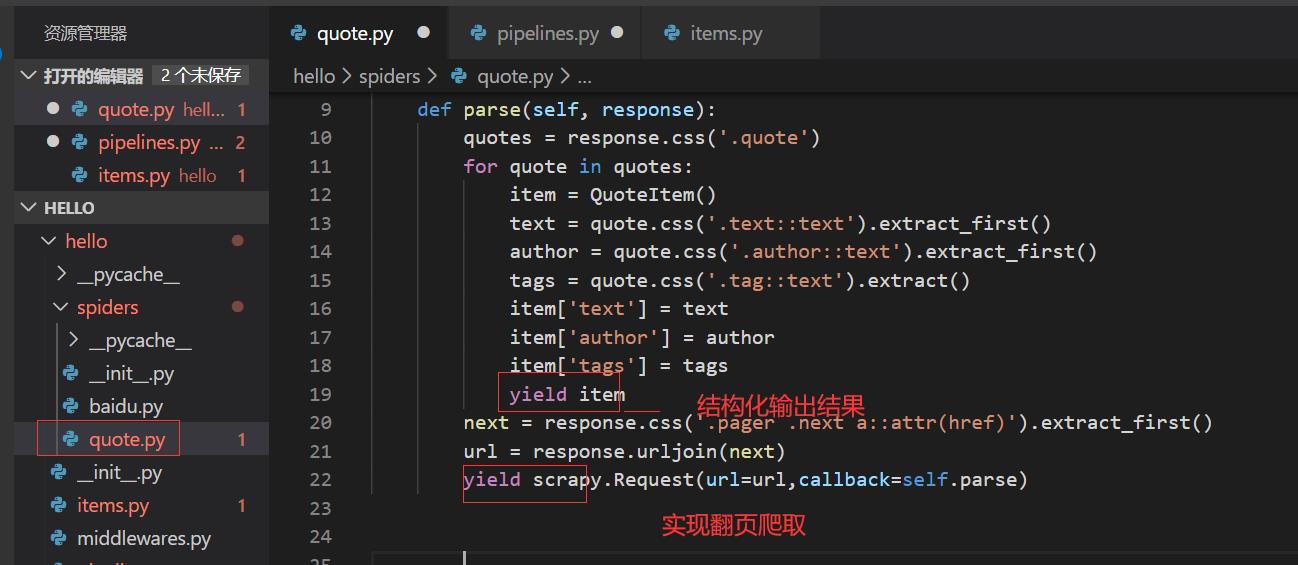

- parse方法为请求链接之后默认执行的方法,其中的参数response为请求链接成功之后得到的response

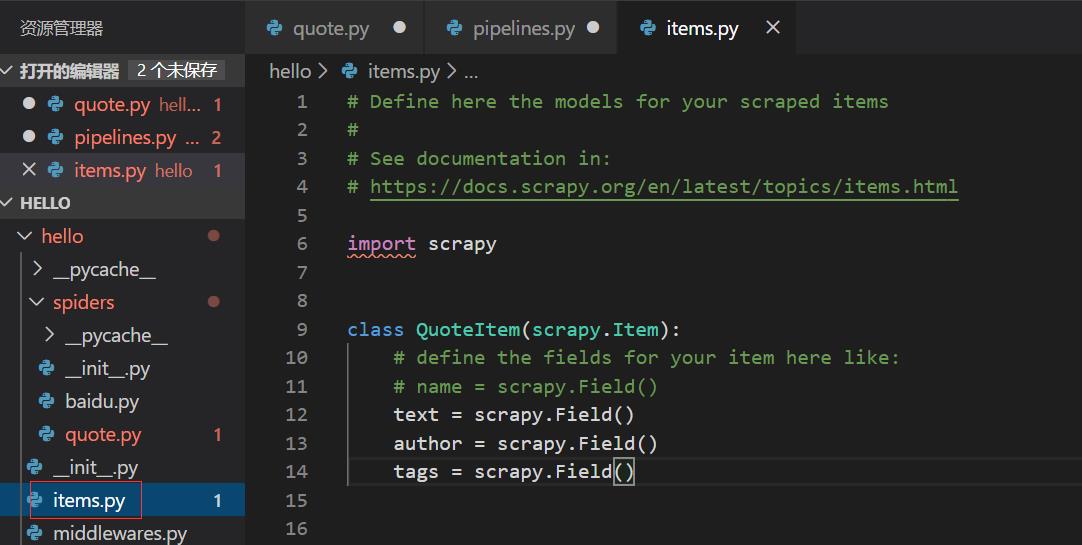

) - items.py

将parse()方法解析后的结果处理,将结果结构化输出

如相对item做进一步处理,如剔除某些item或将item保存到数据库,可借助pipelines.py操作

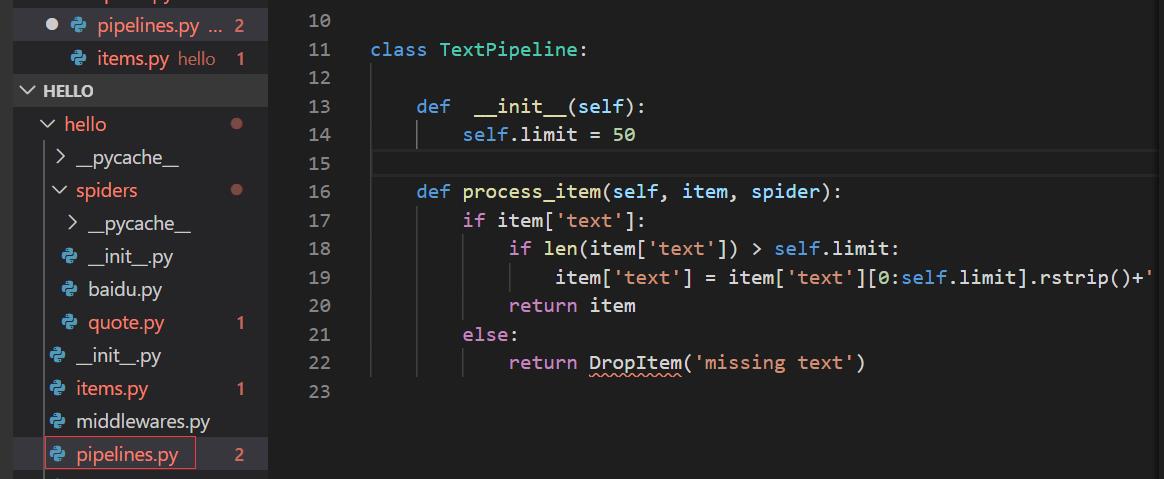

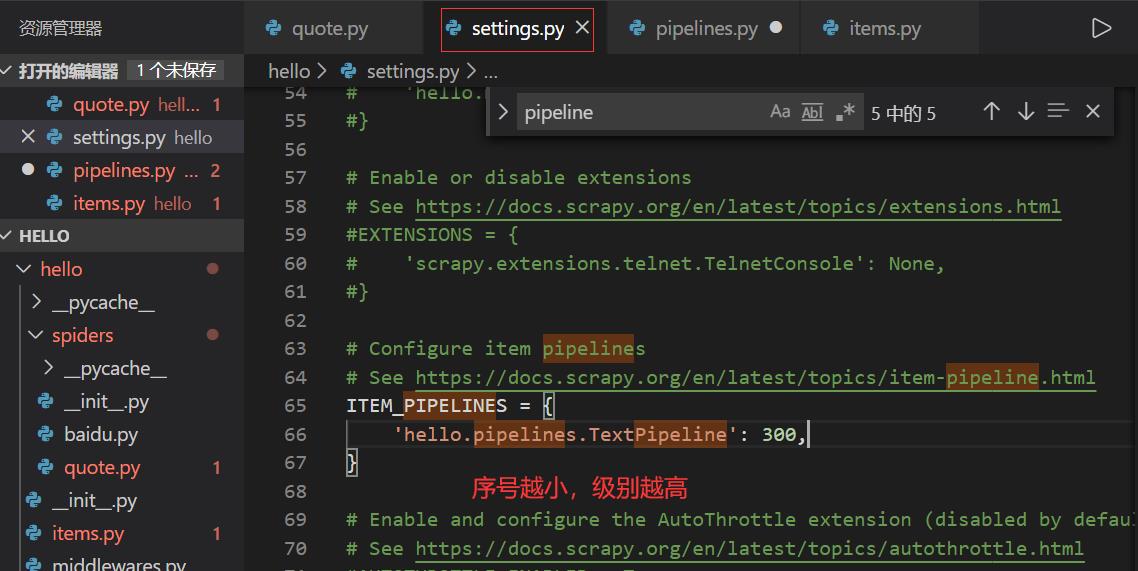

- pipelines.py

需在setting.py中指定后才能生效

以上是关于框架---scrapy(基本用法)的主要内容,如果未能解决你的问题,请参考以下文章