学会运用爬虫框架 Scrapy

Posted 极客猴

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了学会运用爬虫框架 Scrapy 相关的知识,希望对你有一定的参考价值。

上篇文章介绍 Scrapy 框架爬取网站的基本用法。但是爬虫程序比较粗糙,很多细节还需打磨。本文主要是讲解 Scrapy 一些小技巧,能让爬虫程序更加完善。

1 设置 User-agent

Scrapy 官方建议使用 User-Agent 池, 轮流选择其中一个常用浏览器的 User-Agent来作为 User-Agent。scrapy 发起的 http 请求中 headers 部分中 User-Agent 字段的默认值是Scrapy/VERSION (+http://scrapy.org),我们需要修改该字段伪装成浏览器访问网站。

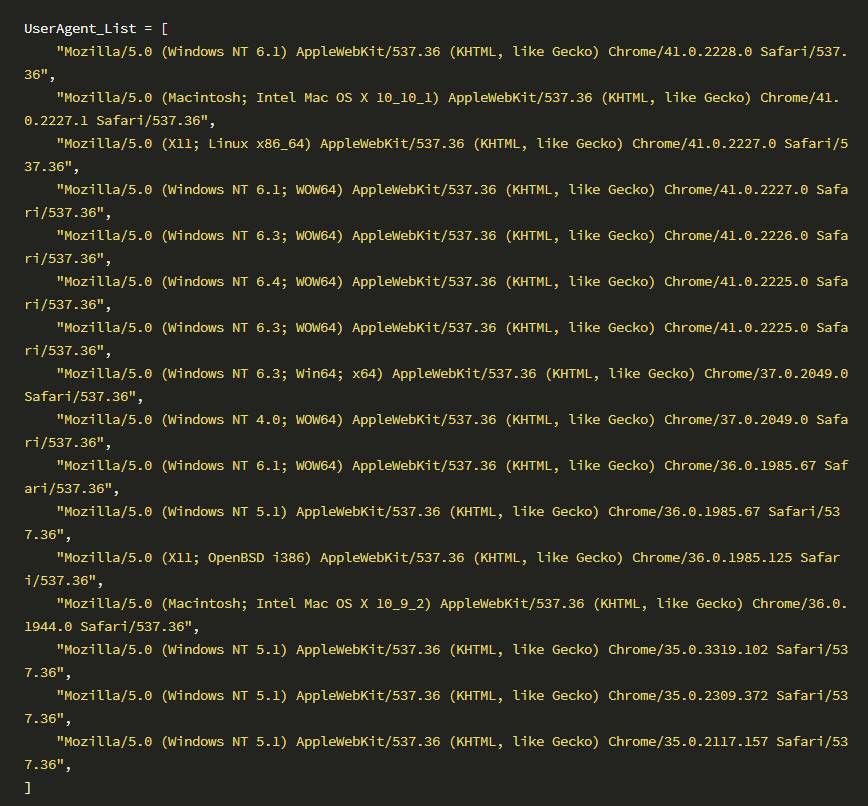

1) 同样在 setting.py 中新建存储 User-Agent 列表,

2) 在 middlewares.py 文件中新建一个名为RandomUserAgentMiddleware的代理中间层类

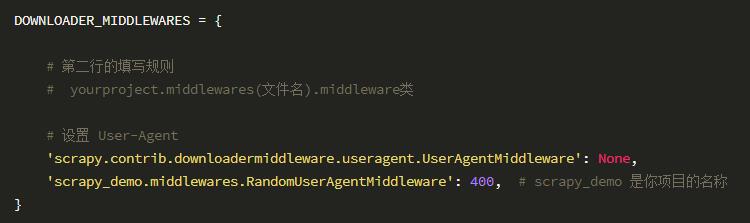

3) 在 settings.py 中配置 RandomUserAgentMiddleware , 激活中间件

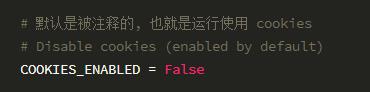

2 禁用cookies

有些站点会使用 cookies 来发现爬虫的轨迹。因此,我们最好禁用 cookies

在 settings.py 文件中新增以下配置。

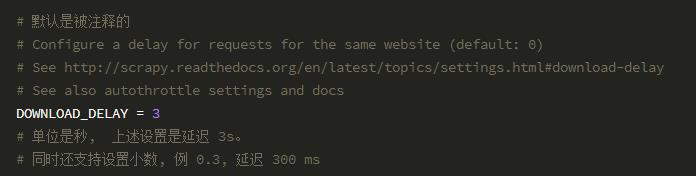

3 设置下载延迟

在 settings.py 文件中新增以下配置。

4 设置代理

有些网站设置反爬虫机制,这使得我们的爬虫程序可能爬到一定数量网页就爬取不下去了。我们需要装饰下爬虫,让它访问网站行为更像类人行为。使用 IP 代理池能突破大部分网站的限制。

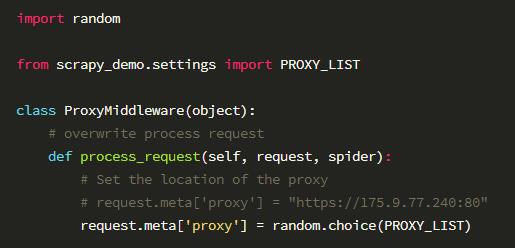

2) 在 middlewares.py 文件中新建一个名为ProxyMiddleware的代理中间层类

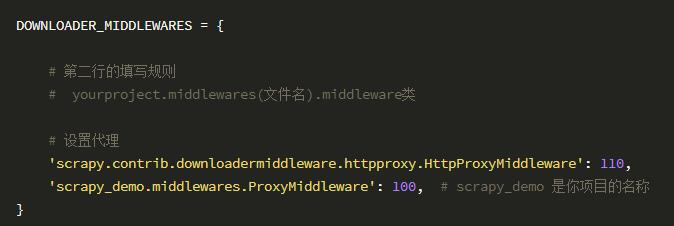

3) 在 settings.py 文件中增加代理配置:

除此之外,如果你比较狠的话,可以采用 VPN + Tor 方式来突破反爬虫机制。

5 减小下载超时

如果您对一个非常慢的连接进行爬取(一般对通用爬虫来说并不重要), 减小下载超时能让卡住的连接能被快速的放弃并解放处理其他站点的能力。

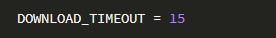

在 settings.py 文件中增加配置:

6 页面跟随规则

在爬取网站时,可能一些页面是我们不想爬取的。如果使用 最基本的 Spider,它还是会将这些页面爬取下来。因此,我们需要使用更加强大的爬取类CrawlSpider。

我们的爬取类继承 CrawlSpider,必须新增定义一个 rules 属性。rules 是一个包含至少一个 Rule(爬取规则)对象的 list。 每个 Rule 对爬取网站的动作定义了特定表现。CrawlSpider 也是继承 Spider 类,所以具有Spider的所有函数。

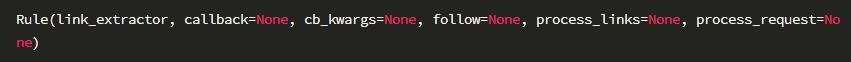

Rule 对象的构造方法如下:

我们在使用 Rule 一般只会用到前面几个参数,它们作用如下:

link_extractor: 它是一个 Link Extractor 对象。 其定义了如何从爬取到的页面提取链接。

link_extractor既可以自己定义,也可以使用已有LinkExtractor类,主要参数为:allow:满足括号中“正则表达式”的值会被提取,如果为空,则全部匹配。deny:与这个正则表达式(或正则表达式列表)不匹配的 Url 一定不提取。allow_domains:会被提取的链接的domains。deny_domains:一定不会被提取链接的domains。restrict_xpaths:使用xpath表达式,和allow共同作用过滤链接。还有一个类似的restrict_css

callback:从 link_extractor 中每获取到链接时将会调用该函数。它指定一个回调方法。会返回一个包含 Item 对象的列表。follow:它 是一个布尔(boolean)值,指定了根据该规则从 response 提取的链接是否需要跟进。 如果 callback 为None, follow 默认设置为 True ,否则默认为 False 。process_links:从link_extractor中获取到链接列表时将会调用该函数。它同样需要指定一个方法,该方法主要用来过滤 Url。

我以爬取豆瓣电影 Top 250 页面为例子进行讲解如何利用 rules 进行翻页爬取。

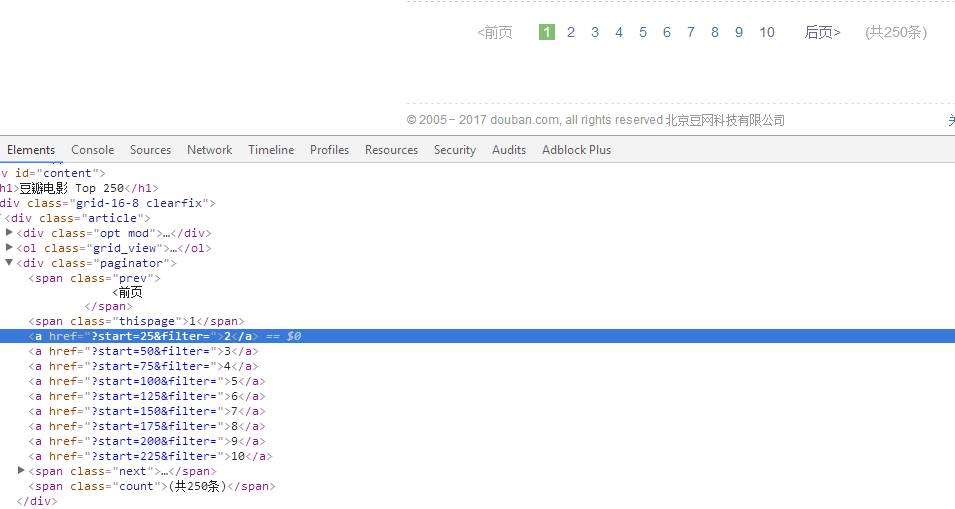

在页面的底部,有这样的分页。我们想通过抓取翻页 url 进行下一个页面爬取。

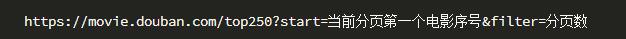

通过分析页面可知,链接的规则是

我使用 xpath 来匹配,当然你也可以使用正则表达式或者 CSS 选择器。rules 可以这样定义:

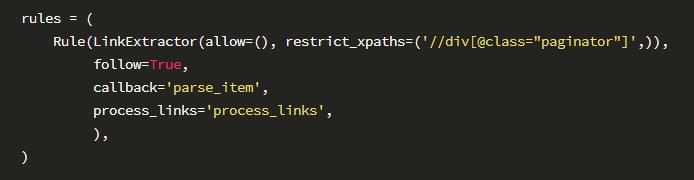

完整的 spider 代码如下:

另外,LinkExtractor 参数中的 allow() 和 deny() ,我们也是经常使用到。规定爬取哪些页面是否要进行爬取。

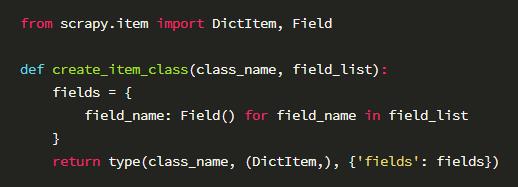

7 动态创建Item类

对于有些应用,item的结构由用户输入或者其他变化的情况所控制。我们可以动态创建class。

推荐:

上文:

- END -

以上是关于学会运用爬虫框架 Scrapy 的主要内容,如果未能解决你的问题,请参考以下文章

教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神