bert 压缩优化方向的论文

Posted tfknight

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了bert 压缩优化方向的论文相关的知识,希望对你有一定的参考价值。

bert 瘦身版本,基于知识蒸馏:

https://arxiv.org/abs/1909.10351

蒸馏的其他用法

因为蒸馏只是一种将知识提取注入的技巧,所以它不光可以用来给模型减肥。也可以让模型大小保持不变,但通过从集成模型蒸馏,或者其他一些蒸馏技巧加强单一模型的表现。可以参考下面两个论文:

论文:BAM! Born-Again Multi-Task Networks for Natural Language Understanding

用动态轻量卷积替代self-attention的工作

在NMT达到同样质量的前提下 提升了训练速度,长句子下 由原来的长度平方复杂度,降低到了长度线性复杂度,应该是ICLR 2019上的

https://openreview.net/pdf?id=SkVhlh09tX

用超低精度压缩 BERT,量化

提出 group-wise quantization 加上基于二次阶Hessian信息的混合方法:

论文:Q-BERT: Hessian Based Ultra Low Precision Quantization of BERT

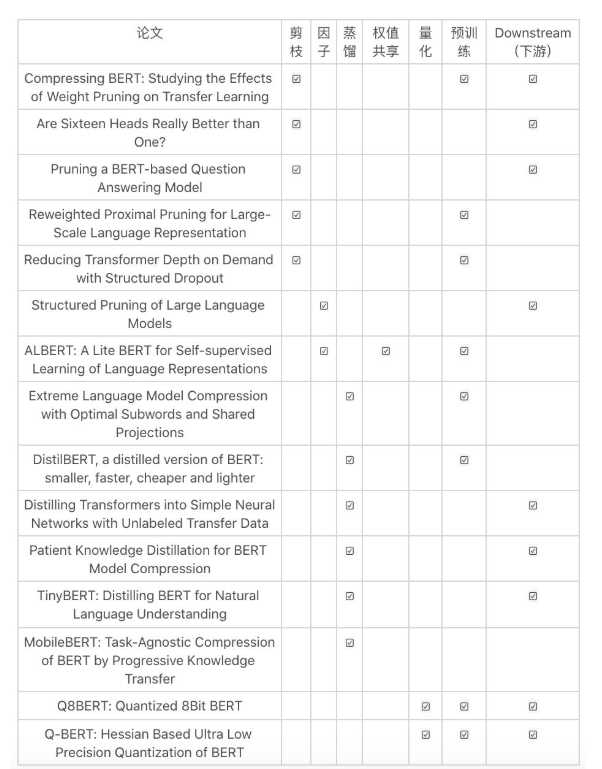

优化方式汇总论文:

以上是关于bert 压缩优化方向的论文的主要内容,如果未能解决你的问题,请参考以下文章