Science:AI领域那么多引人注目的「进展」,竟是无用功

Posted jinsexiaomifeng

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Science:AI领域那么多引人注目的「进展」,竟是无用功相关的知识,希望对你有一定的参考价值。

Science:AI领域那么多引人注目的「进展」,竟是无用功

近日,一篇 Science 社论文章梳理了近年来 AI 各子领域的进展,发现看似红红火火的领域实际上毫无进展。在人工智能技术风起云涌的今天,这篇文章的观点或许值得我们思考。

人工智能看似越来越聪明:芯片越来越快,数据越来越多,算法性能也比之前更好。但是一些改进来自于微调,而不是其创造者所说的核心创新,甚至有些改进根本不存在,MIT 计算科学与人工智能实验室博士 Davis Blalock 如是说。

Blalock 及其同事对比了数十种神经网络改进方法,发现「看完五十篇论文,愈发不明白当前最优性能是什么样了」。

他们一共评估了 81 种剪枝算法,即通过修剪不必要的连接提高神经网络效率的方法。所有这些算法都声称自己具备更优秀的表现,但是它们甚至很少得到恰当的对比。这项研究将它们进行对比评估后,发现在过去十年中没有明确证据可以表明算法性能出现提升。

相关研究《What is the State of Neural Network Pruning?》令 Blalock 的导师、MIT 计算机科学家 John Guttag 感到震惊,他表示,不公平的对比或许可以解释这一停滞现象。「老话说得好,如果你无法衡量一件事,就很难让它变得更好。」

近年来,研究人员发现多个 AI 子领域的进展实则「摇摇欲坠」。

2019 年,一项针对搜索引擎所用信息检索算法的元分析发现,「高水位线早在 2009 年就已确立」。

2019 年的另一项研究在 18 种推荐算法中仅成功复现了 7 种,而且其中 6 个在性能上无法超越多年前开发的更简单的非神经算法。

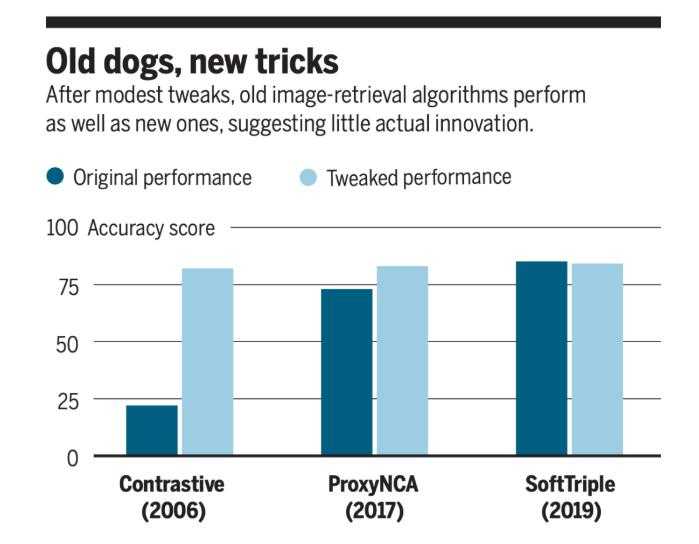

而在今年三月的一篇 arXiv 论文《A Metric Learning Reality Check》中,康奈尔大学计算机科学家 Kevin Musgrave 对损失函数进行了评估。他以公平的方式在图像检索任务中对十几种损失函数进行对比,发现与损失函数发明者所声称的相反,自 2006 年以来模型准确率并未因此得到提升。Musgrave 表示:「总是会有这样的炒作。」

CMU 计算机科学家 Zico Kolter 表示,机器学习算法的性能提升来自于架构、损失函数或优化策略的基础改变,而对它们进行微调也能带来性能提升。Kolter 致力于研究免受「对抗攻击」影响的图像识别模型。早期的对抗训练方法叫做投影梯度下降(PGD),即在真实和欺骗性样本上训练模型,该方法后来似乎被一些更复杂的方法超越。

但在今年 2 月的一篇 arXiv 论文《Overfitting in adversarially robust deep learning》中,Kolter 及其同事发现,在使用简单的 trick 对这些方法进行增强后,所有方法的性能几乎相同。

「这个结果令人吃惊,我们之前从未发现过这一点。」Kolter 的博士生 Leslie Rice 表示。Kolter 称该研究表明 PGD 这类创新很难实现,也很难出现实质性的改进。「很显然,PGD 就是正确的算法,这是显而易见的,但人们想要找到更复杂的解决方案。」

另外一些重要的算法改进似乎经受住了时间的考验。1997 年长短期记忆(LSTM)的诞生带来了极大突破。在经过恰当训练后,LSTM 与其诞生二十年后看似更先进的架构性能相当。

另一个机器学习突破出现在 2014 年,它就是生成对抗网络(GAN)。2018 年的一篇论文《Are GANs Created Equal? A Large-Scale Study》称,只要有充足的计算量,原版 GAN 方法的能力可与近年来的新方法媲美。

Kolter 表示,研究人员更愿意开发新算法并进行微调,使之超越原有的 SOTA 结果。原有的方法看起来没那么新颖,因此「更难据此写出论文」。

Guttag 认为,即使算法的发明者也很难全面地对比自己的工作与其他方法,因为万一其突破并不像他们以为的那样呢。「太认真地对比会有风险」,而且实现难度颇大:AI 研究者使用不同的数据集、调试方法、性能度量指标和基线。「要做到一一对应的比较很不现实。」

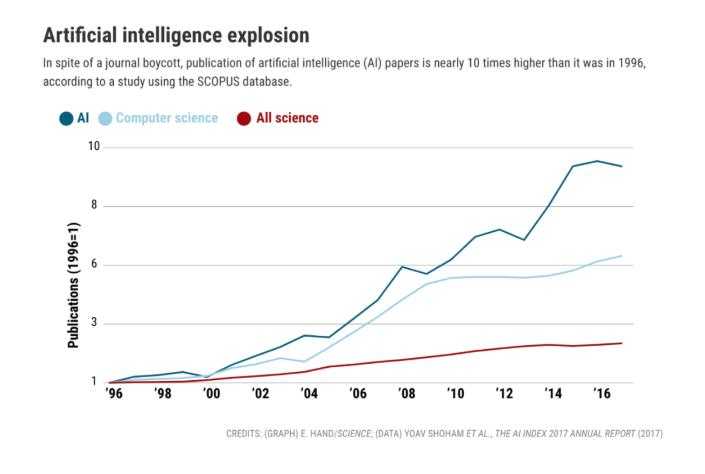

一些夸大的性能表述可能要归因于该领域的爆炸式发展,论文数量比有经验的评审还要多。「其中大量论文读起来是种煎熬,」Blalock 说道。他敦促审稿人使用更多的对比方法来进行评判,并表示更好的工具或许能起到一定的帮助。今年初,Blalock 的共同作者、MIT 研究人员 Jose Gonzalez Ortiz 推出了一款名为 ShrinkBench 的软件,可以更便捷地比较剪枝算法。

研究人员指出,即使新方法本质上不如旧方法好,但它们实现的调整说不定也可以用到之前的方法上。偶尔也会出现真正突破性的新算法。「这很像是一个风险投资组合,」Blalock 说道。「即使一些投资不赚钱,但总有能够获得回报的。」

以上是关于Science:AI领域那么多引人注目的「进展」,竟是无用功的主要内容,如果未能解决你的问题,请参考以下文章

AI预测RNA结构登上Science封面,论文一作已成立药物公司开始招人

降低AI for Science门槛,实现生命科学领域新突破

Computer Science - Computer Vision - Intro