Python3实战Spark大数据分析及调度 (网盘分享)

Posted nobug123

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Python3实战Spark大数据分析及调度 (网盘分享)相关的知识,希望对你有一定的参考价值。

Python3实战Spark大数据分析及调度

搜索QQ号直接加群获取其它学习资料:517432778

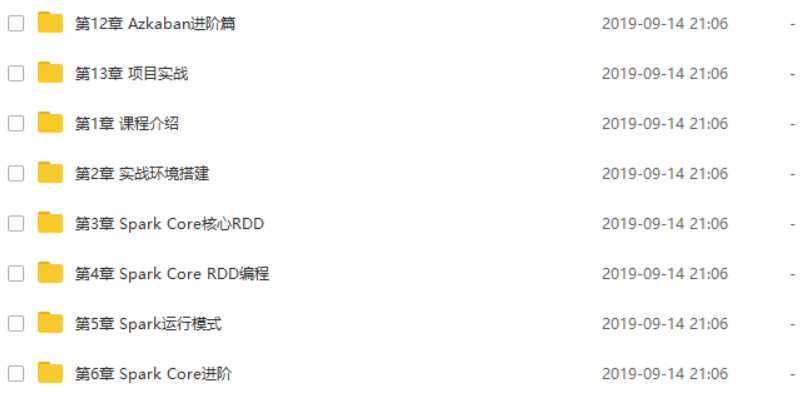

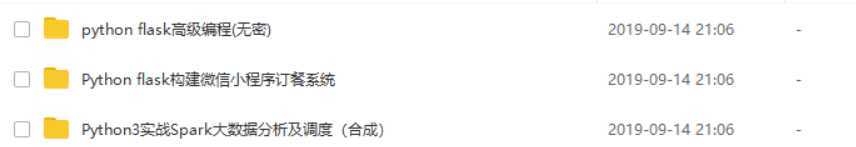

部分课程截图:

链接:https://pan.baidu.com/s/1YMmswv47fOUlt-z2A6691A

提取码:z5xv

PS:免费分享,若点击链接无法获取到资料,若如若链接失效请加群

其它资源在群里,私聊管理员即可免费领取;群——517432778,点击加群,或扫描二维码

-

第1章 课程介绍

课程介绍

- 1-1 PySpark导学试看

- 1-2 OOTB环境演示

-

第2章 实战环境搭建

工欲善其事必先利其器,本章讲述JDK、Scala、Hadoop、Maven、Python3以及Spark源码编译及部署

- 2-1 -课程目录

- 2-2 -Java环境搭建

- 2-3 -Scala环境搭建

- 2-4 -Hadoop环境搭建

- 2-5 -Maven环境搭建

- 2-6 -Python3环境部署

- 2-7 -Spark源码编译及部署

-

第3章 Spark Core核心RDD

本章详细讲解RDD是什么以及特性(面试常考)、Spark中两个核心类SparkContext和SparkConf、pyspark启动脚本分析、RDD的创建方式以及如何使用IDE开发Python Spark应用程序并提交到服务器上运行

- 3-1 -课程目录

- 3-2 -RDD是什么

- 3-3 -通过电影描述集群的强大之处

- 3-4 -RDD的五大特性

- 3-5 -RDD特性在源码中的体现试看

- 3-6 -图解RDD

- 3-7 -SparkContext&SparkConf详解

- 3-8 -pyspark

- 3-9 -RDD创建方式一

- 3-10 -RDD创建方式二

- 3-11 -使用IDE开发pyspark应用程序

- 3-12 -提交pyspark作业到服务器上运行

-

第4章 Spark Core RDD编程

本章将针对RDD中常用的算子进行详细案例讲解,并进行综合案例实战

- 4-1 -课程目录

- 4-2 -RDD常用操作

- 4-3 -map算子使用详解

- 4-4 -filter算子详解

- 4-5 -flatMap算子详解

- 4-6 -groupByKey算子详解

- 4-7 -reduceByKey算子详解

- 4-8 -sortByKey算子详解

- 4-9 -union算子使用详解

- 4-10 -distinct算子使用详解

- 4-11 -join算子详解

- 4-12 -action常用算子详解

- 4-13 -算子综合案例实战一词频统计

- 4-14 -算子综合案例实战之词频统计重构

- 4-15 -算子综合案例实战之TopN统计

- 4-16 -算子综合案例实战之平均数统计

-

第5章 Spark运行模式

本章将介绍Spark的几种运行模式,需要重点掌握on YARN模式

- 5-1 -课程目录

- 5-2 -local模式运行

- 5-3 -standalone模式环境搭建及pyspark运行

- 5-4 -standalone模式spark-submit运行

- 5-5 -yarn运行模式详解

-

第6章 Spark Core进阶

本章将介绍Spark中的核心术语、运行架构、并对比Spark和MapReduce的概念区分、存储策略及选择方式、宽窄依赖及Shuffle

- 6-1 -课程目录

- 6-2 -Spark核心概念详解

- 6-3 -结合Spark UI详解Spark核心概念试看

- 6-4 -Spark运行架构及注意事项

- 6-5 -Spark和Hadoop重要概念区分

- 6-6 -Spark缓存的作用

- 6-7 -Spark缓存概述

- 6-8 -Spark缓存策略详解

- 6-9 -Spark缓存策略选择依据

- 6-10 -Spark Lineage机制

- 6-11 -Spark窄依赖和宽依赖

- 6-12 -Spark Shuffle概述

- 6-13 -图解RDD的shuffle以及依赖关系

-

第7章 Spark Core调优

本章将从Spark作业性能指标、序列化、内存管理、广播变量及数据本地化这几个方面来介绍Spark作业的调优

- 7-1 -课程目录

- 7-2 -优化之HistoryServer配置及使用

- 7-3 -优化之序列化

- 7-4 -优化之内存管理

- 7-5 -优化之广播变量

- 7-6 -优化之数据本地性

-

第8章 Spark SQL

本章将讲解Spark SQL的架构、DataFrame&Dataset、以及如何使用Python API来对DataFrame进行编程

- 8-1 -课程目录

- 8-2 -Spark SQL前世今生

- 8-3 -Spark SQL概述&错误认识纠正

- 8-4 -Spark SQL架构

- 8-5 -DataFrame&Dataset详解

- 8-6 -DataFrame API编程

- 8-7 -RDD与DataFrame互操作方法一

- 8-8 -RDD与DataFrame互操作方法二

- 8-9 -Spark SQL其他

-

第9章 Spark Streaming

本章将讲解Spark Streaming的核心概念、执行原理、以及如何Python API来对Spark Streaming进行编程

- 9-1 -课程目录

- 9-2 -Spark Streaming概述

- 9-3 -实时流处理框架对比

- 9-4 -Spark Streaming执行原理

- 9-5 -从词频统计案例来了解SparkStreaming

- 9-6 -核心概念之StreamingContext

- 9-7 -核心概念之DStream及常用操作

- 9-8 -SparkStreaming操作文件系统数据实战

-

第10章 Azkaban基础篇

本章将讲解Azkaban的特性、架构、运行模式、源码编译及部署、快速入门

- 10-1 Azkaban基础篇课程目录

- 10-2 -工作流概述

- 10-3 -工作流在大数据处理中的重要性

- 10-4 -常用调度框架介绍

- 10-5 -Azkaban概述及特性

- 10-6 -Azkaban架构

- 10-7 -Azkaban运行模式详解

- 10-8 -Azkaban源码编译

- 10-9 -Azkaban solo server环境部署

- 10-10 -Azkaban快速入门案例

-

第11章 Azkaban实战篇

本章将讲解如何使用Azkaban来完成HDFS、MapReduce、Hive作业的调度、定时作业调度以及邮件告警

- 11-1 -Azkaban实战篇课程目录

- 11-2 -依赖作业在Azkaban中的使用

- 11-3 -HDFS作业在Azkaban中的使用

- 11-4 -MapReduce作业在Azkaban中的使用

- 11-5 -Hive作业在Azkaban中的使用

- 11-6 -定时调度作业在Azkaban中的使用

- 11-7 -邮件告警及SLA在Azkaban中的使用

-

第12章 Azkaban进阶篇

本章将讲解Azkaban在生产上的部署、权限管理、Ajax API、Plugin、以及短信和调度框架的二次开发

- 12-1 -Azkaban进阶篇课程目录

- 12-2 -Two Server Mode之数据库准备工作

- 12-3 -Two Server Mode之AzkabanWebServer搭建

- 12-4 -Two Server Mode之AzkabanExecServer搭建

- 12-5 -Two Server Mode之使用实战

- 12-6 -Azkaban权限管理

- 12-7 -Azkaban中AJAX API使用

- 12-8 -Azkaban Plugin的使用

- 12-9 -Azkaban中短信告警改造思路

- 12-10 Azbakan在生产上使用的改造思路

-

第13章 项目实战

本章将讲解在构建大数据平台的技术选型、集群升级资源评估,并使用Spark对气象数据进行分析,讲分析结果写入ES,并通过Kibana进行统计结果的可视化展示

- 13-1 -课程目录

- 13-2 -大数据项目开发流程

- 13-3 -大数据企业级应用

- 13-4 -企业级大数据分析平台

- 13-5 -集群数据量预估

- 13-6 -集群机器规模&资源&作业规划

- 13-7 -项目需求

- 13-8 -数据加载成DataFrame并选出需要的列

- 13-9 -SparkSQL UDF函数开发

- 13-10 -每年Grade出现的次数统计

- 13-11 -Grade在每年中的占比统计

- 13-12 -ES部署及使用

- 13-13 -Kibana部署及使用

- 13-14 -将作业运行到YARN上

- 13-15 -统计分析结果写入ES测试

- 13-16 -统计分析结果入ES并通过Kibana图形化展示

- 13-17 -作业

- 13-18 -通过Azkaban调度整个流程

- 13-19 -课程总结及展望(重点关注)

以上是关于Python3实战Spark大数据分析及调度 (网盘分享)的主要内容,如果未能解决你的问题,请参考以下文章

第2天Python实战Spark大数据分析及调度-RDD编程

第2天Python实战Spark大数据分析及调度-RDD编程

Spark进阶 大数据离线与实时项目实战 Spark-Hbase-Redis-Hadoop 大技术栈的企业级应用 网盘云分享