第三百五十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy的暂停与重启

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了第三百五十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy的暂停与重启相关的知识,希望对你有一定的参考价值。

第三百五十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy的暂停与重启

scrapy的每一个爬虫,暂停时可以记录暂停状态以及爬取了哪些url,重启时可以从暂停状态开始爬取过的URL不在爬取

实现暂停与重启记录状态

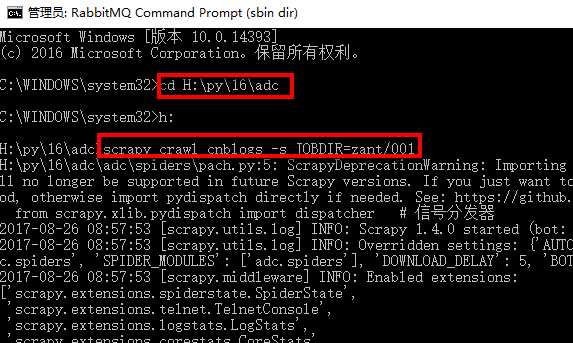

1、首先cd进入到scrapy项目里

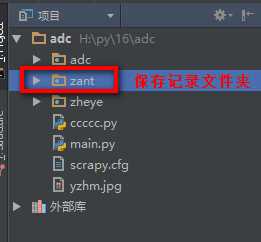

2、在scrapy项目里创建保存记录信息的文件夹

3、执行命令:

scrapy crawl 爬虫名称 -s JOBDIR=保存记录信息的路径

如:scrapy crawl cnblogs -s JOBDIR=zant/001

执行命令会启动指定爬虫,并且记录状态到指定目录

爬虫已经启动,我们可以按键盘上的ctrl+c停止爬虫

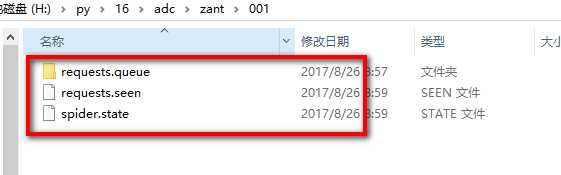

停止后我们看一下记录文件夹,会多出3个文件

其中的requests.queue文件夹里的p0文件就是URL记录文件,这个文件存在就说明还有未完成的URL,当所有URL完成后会自动删除此文件

当我们重新执行命令:scrapy crawl cnblogs -s JOBDIR=zant/001 时爬虫会根据p0文件从停止的地方开始继续爬取,

以上是关于第三百五十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy的暂停与重启的主要内容,如果未能解决你的问题,请参考以下文章

第三百五十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—数据收集(Stats Collection)

第三百五十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy信号详解

第三百五十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—将bloomfilter(布隆过滤器)集成到scrapy-redis中

一起Talk Android吧(第三百五十三回:Gson库解析JSON数组一)