最小二乘法(Least Squares)简介

Posted ygl_9913

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了最小二乘法(Least Squares)简介相关的知识,希望对你有一定的参考价值。

原文链接:

最小二乘法(Least Squares)详细介绍 | 数据学习者官方网站(Datalearner)

最小二乘法(Least Squares)是回归分析中的一种标准方法,它是用来近似超定系统(Overdetermined System)答案的一种方法。超定系统是指数学中的一种概念,一组包含未知数的方程组中,如果方程的数量大于未知数的数量,那么这个系统就是一个超定系统(超定方程组)。超定系统(超定方程组)一般是无解的,只能求近似解。而最小二乘法就是求超定方程组近似解的一种方法。

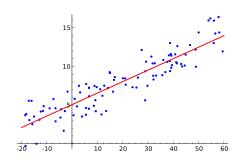

举个通俗的例子,如下二维平面图中有很多个点,假设我们想用一条直线来拟合数据,即期望能找到一条直线能最好地穿过这些数据点。

那么图中,一个点就可以构造一个方程,而未知数显然只有两个(直线的斜率和截距),因此这就是一个超定系统,我们是没有办法找到一条完美的直线,使得上述的点都在直线上。因此,我们只能期望找到一条最好的“适配(best fitting line)”直线来拟合这些数据。那么,什么样的直线才是我们需要的呢?在定义这样的直线之前,我们先定义一些变量:

首先,使用

表示数据

的观测结果,即真实值,或者是观测的响应变量(observed response)。其次,

表示第

个数据,即第

个预测变量(predictor value) 最后,

表示第

个数据的实验结果,即预测的响应变量(predicted response)。

注意,上述表述中没有严格区分变量和数值的含义。那么,我们假设最佳的直线表示如下:

有了这条直线之后,我们就可以使用已知的  来预测其对应的标签

来预测其对应的标签  。例如,假设

。例如,假设  是某个学生的体重,

是某个学生的体重, 是某个学生的身高,建立了学生的体重和身高之间的回归方程之后我们就可以在已知学生的体重的情况下来预测学生的身高了。但是实际上,我们的预测未必是准确的,例如体重为32公斤的学生,实际身高是1.27米,但是我们预测的结果可能是1.17米,那么我们预测的结果和真实的结果之间就有了一个预测误差prediction error(残差,residual error)。这个之间的差值是0.1米。某个我们最终确定的直线在训练集中会产生

是某个学生的身高,建立了学生的体重和身高之间的回归方程之后我们就可以在已知学生的体重的情况下来预测学生的身高了。但是实际上,我们的预测未必是准确的,例如体重为32公斤的学生,实际身高是1.27米,但是我们预测的结果可能是1.17米,那么我们预测的结果和真实的结果之间就有了一个预测误差prediction error(残差,residual error)。这个之间的差值是0.1米。某个我们最终确定的直线在训练集中会产生  个这样的误差。我们希望这

个这样的误差。我们希望这  个误差的平均值越小越好。最小误差的那个直线就是我们期望找到的直线。

个误差的平均值越小越好。最小误差的那个直线就是我们期望找到的直线。

因此,找一条直线能使得所有点离这个直线的距离平均值最小的这种近似的结果就是回归分析的目标。

最小二乘(Least squares)的含义就是在整体的优化方案中,最小化每个方程结果的残差平方和。

最小二乘法主要包含了两大类方法,一种是线性最小二乘法(Linear Least Squares),一种是非线性最小二乘法(Nonlinear Least Squares)。

线性最小二乘法主要包括如下三种类型:

-

普通最小二乘法(Ordinary Least Squares, OLS)

-

加权最小二乘法(Weighted Least Squares, WLS)

-

广义最小二乘法(Generalized Least Squares, GLS )

以上是关于最小二乘法(Least Squares)简介的主要内容,如果未能解决你的问题,请参考以下文章

Linear least squares,Lasso,ridge regression有何本质区别

自动驾驶 8-4: 最小二乘法和最大似然法 Least Squares and the Method of Maximum Likelihood

自动驾驶 8-4: 最小二乘法和最大似然法 Least Squares and the Method of Maximum Likelihood

Regularized least-squares classification(正则化最小二乘法分类器)取代SVM

自动驾驶 8-2: 平方误差准则和最小二乘法 (下) Squared Error Criterion and the Method of Least Squares (Part 2)