每日一读InfiniteWalk: Deep Network Embeddings as Laplacian Embeddings with a Nonlinearity

Posted 海轰Pro

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了每日一读InfiniteWalk: Deep Network Embeddings as Laplacian Embeddings with a Nonlinearity相关的知识,希望对你有一定的参考价值。

目录

- 简介

- 论文简介

- ABSTRACT

- 1 INTRODUCTION

- 2 BACKGROUND AND RELATED WORK

- 3 METHODOLOGY

- 4 EXPERIMENTAL SETUP

- 6 DISCUSSION AND CONCLUSIONS

- 结语

简介

Hello!

非常感谢您阅读海轰的文章,倘若文中有错误的地方,欢迎您指出~

ଘ(੭ˊᵕˋ)੭

昵称:海轰

标签:程序猿|C++选手|学生

简介:因C语言结识编程,随后转入计算机专业,获得过国家奖学金,有幸在竞赛中拿过一些国奖、省奖…已保研

学习经验:扎实基础 + 多做笔记 + 多敲代码 + 多思考 + 学好英语!

唯有努力💪

【每日一读】每天浅读一篇论文,了解专业前沿知识,培养阅读习惯(阅读记录 仅供参考)

论文简介

原文链接:https://dl.acm.org/doi/10.1145/3394486.3403185

会议:KDD '20: Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining (CCF A类)

年度:20 August 2020(发表日期)

ABSTRACT

用于学习单词嵌入的跳过克模型[21]已经广泛流行,

- DeepWalk[25]在其他方法中扩展了该模型,以便从网络中学习节点表示

- Qiu等人最近的工作[26]为DeepWalk目标提供了一个封闭形式的表达式,消除了对小数据集采样的需要,提高了精度

在这些方法中,“窗口大小”𝑇是一个关键的超参数,其中单词或节点被认为是同时出现的

我们研究了𝑇→∞极限中的目标,这允许我们从[26]简化表达式

我们证明了这个极限目标对应于分解拉普拉斯图伪逆的一个简单变换,将DeepWalk与光谱图嵌入的大量先前工作联系起来。

进一步,我们证明,通过对这个伪逆应用一个简单的非线性入口转换,我们恢复了有限-𝑇目标的良好近似,并在多标签分类中与DeepWalk和其他跳过图方法的嵌入相竞争

令人惊讶的是,我们发现即使是简单的拉普拉斯伪逆的二元阈值化也常常具有竞争性,这表明最近方法的核心进步是在经典光谱嵌入方法之上的非线性。

1 INTRODUCTION

顶点嵌入是在连续向量空间中学习图形顶点表示的任务,以用于下游任务,例如链接预测和顶点分类 [34]。此任务的主要经典方法是谱嵌入:顶点由图拉普拉斯算子的最小特征向量中的相应值表示。谱嵌入方法包括 Shi-Malik 归一化切割算法 [28]、拉普拉斯特征图 [5] 和随机块模型的谱划分方法 [19]。它们还包括许多谱聚类方法,这些方法通过首先将谱嵌入基于数据点相似性将它们转换为图来将谱嵌入应用于一般数据集[22]。

最近,受 Word2vec [21] 启发的方法在许多任务上的预测性能超过了谱嵌入方法,该方法执行相关的词嵌入任务。 Word2vec 根据它们在固定距离内与其他词(称为上下文词)同时出现的频率形成词的表示?在自然文本中。 DeepWalk [25]、LINE [31] 和 node2vec [10] 算法等将这一想法应用于网络数据。特别是,DeepWalk 在网络上进行多次随机游走,将顶点视为单词,并将游走视为文本中的单词序列。在[17]中已经表明,通过这种方法学习的表示隐含地形成了已知矩阵的低维分解,该矩阵包含随机游走中节点之间共现的逐点互信息(PMI)。邱等人的工作。 [26] 给出了该矩阵的封闭形式表达式,并显示了与归一化图拉普拉斯算子的连接。这激发了他们的 NetMF 算法,该算法执行直接分解,提高了 DeepWalk 在许多任务上的性能。

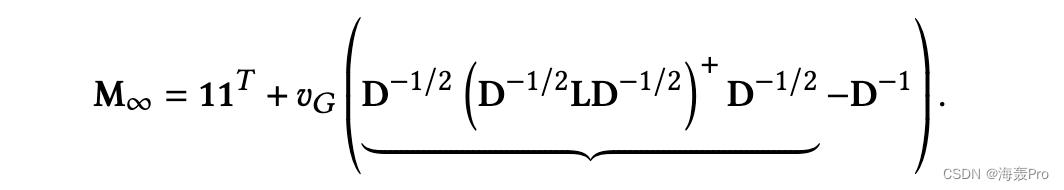

在这项工作中,我们将极限中的 DeepWalk 视为窗口大小?走向无穷大。我们在这个极限中推导出一个简单的 PMI 矩阵表达式:

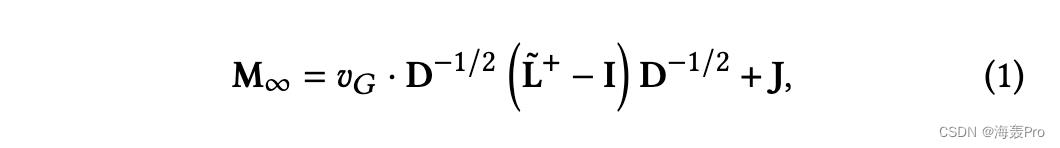

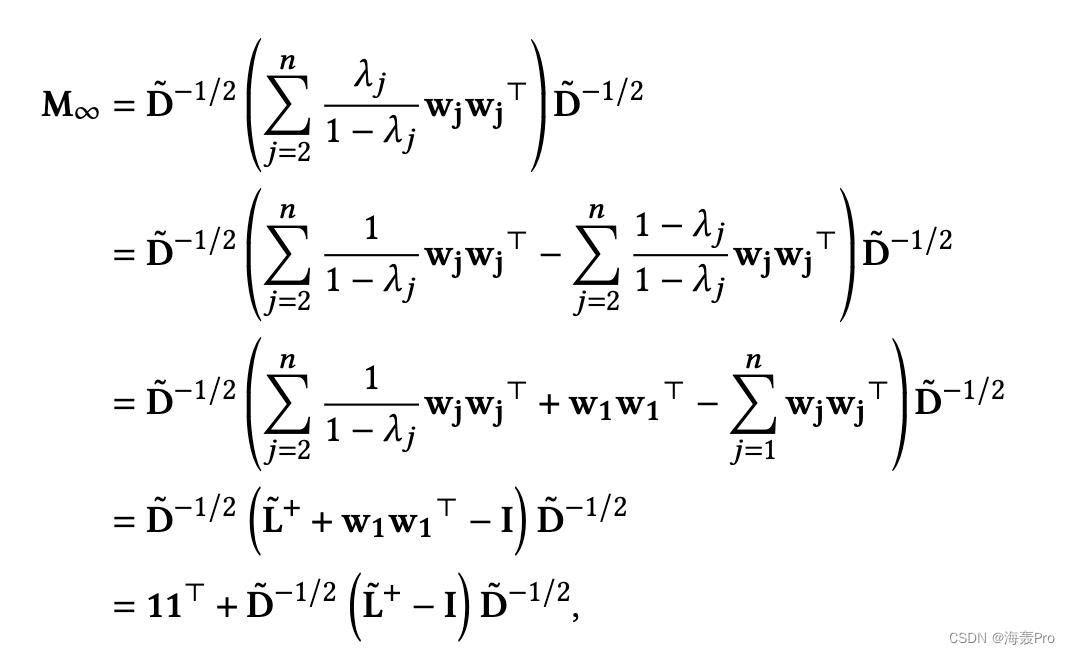

其中D为度矩阵,𝑣𝐺为D的迹(𝐺中边数的两倍),L为归一化拉普拉斯矩阵(即I−D−1/2AD−1/2),J为全一矩阵。′L+是′L的伪逆。可以证明D−1/2′L+D−1/2等于非归一化拉普拉斯伪逆L+,经典光谱嵌入的中心对象,直到第2级分量(见3.3节(6))。因此,M∞等于L+加上最多一个3阶分量和一个对角矩阵。

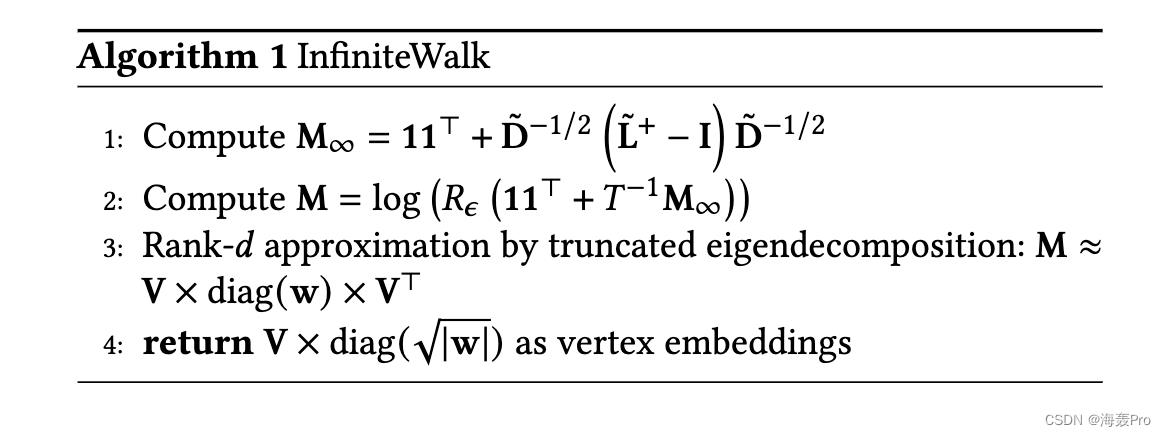

与DeepWalk和其他跳过克方法相比,直接使用M∞本身的低维分解形成的嵌入在下游任务中表现较差,这并不奇怪。然而,我们证明了在一个线性函数的元素应用后,加上一个对数,特别是𝑥→log(1 +𝑥/𝑇),M∞近似于有限-𝑇PMI矩阵。将变换后的矩阵因式分解形成的嵌入与DeepWalk具有竞争力,与Qiu等人[26]的NetMF方法几乎具有竞争力,在对多标签节点分类任务进行评估时。我们称我们的方法为 InfiniteWalk。

注意,窗口超参数𝑇只出现在InfiniteWalk中的入口非线性中,而不在公式forM∞中。这可能令人惊讶,因为𝑇是现有方法中的一个关键超参数。我们的结果表明𝑇的重要性很大程度上取决于所应用的非线性的形状。由于M∞与拉普拉斯伪逆密切相关,DeepWalk与经典光谱嵌入的关键区别似乎在于对这种非线性的应用。

更详细地说,请注意我们的结果表明,InfiniteWalk 通过形成 M∞ 的非线性 entrywise 变换的低秩分解,很好地逼近了 DeepWalk。经典的谱嵌入和聚类方法 [5, 19, 28] 使用对应于拉普拉斯 L 的最小特征值(或该矩阵的变体)的特征向量嵌入节点,这些特征向量是 L+ 的最大特征值。因此,这些方法可以被视为使用 L+ 的最佳低维分解(位于 L+ 的顶部特征向量的跨度内)的嵌入节点,而不应用入口非线性。

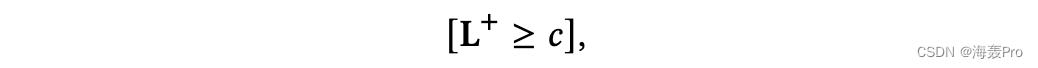

受此观察的启发,我们进一步简化了拉普拉斯伪逆的非线性变换的想法:将其阈值化为二进制矩阵。特别是,我们形成二进制矩阵

其中𝑐是L+本身的一个超参数分位数元素(例如中位数或第95百分位元素)。令人惊讶的是,通过分解这个二进制矩阵得到的嵌入在许多任务上也可以与DeepWalk和Qiu等人的方法竞争。

从广义上讲,我们的结果加强了基于分解图拉普拉斯算子的经典方法与最近的“深度”顶点嵌入方法之间的理论联系。他们认为,这些方法在概念上并不像乍一看那样不同。

2 BACKGROUND AND RELATED WORK

我们首先调查现有的基于 skip-gram 的网络嵌入的工作及其与矩阵分解的联系,我们的工作就是以此为基础的。

2.1 Skip-Gram

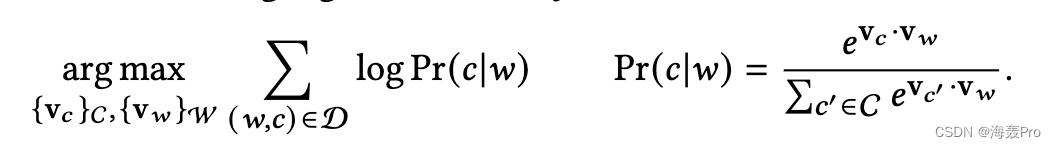

在单词嵌入模型中,单词通常被视为单词和上下文。上下文只是出现在另一个单词的长度为𝑇的窗口中的一个单词。正如[9]中形式化的那样,给定一个由单词𝑤∈W、上下文𝑐∈C(典型的W = C)和(𝑤,𝑐)单词-上下文共现对(𝑤,𝑐)∈D组成的数据集,用于训练单词和上下文嵌入的“skipgram”模型v𝑤,v𝑐[21]具有以下对数似然目标:

我们可以看到,目标鼓励共现对(𝑤,𝑐)∈D具有大点积v𝑐·v𝑤的相似嵌入。这个精确的目标没有被使用,因为重复计算配分函数的计算量太大;[21]提出了一种替代方法:负采样的跳过图(SGNS)。这里,使用了一个辅助的“负”数据集D”,由不出现在D中的随机(𝑤,𝑐)对组成。鼓励这个负集合中的对具有小v𝑐·v𝑤的不同嵌入。

2.2 Implicit PMI Matrix

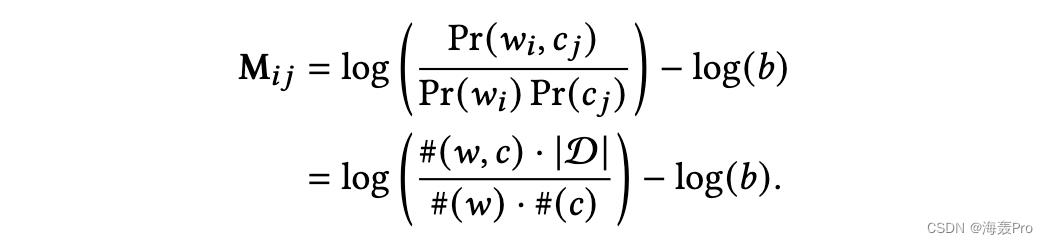

Levy和Goldberg[17]证明SGNS隐式分解了一个矩阵,该矩阵的条目给出了单词𝑤𝑖和上下文𝑐𝑗出现的点互信息(PMI)。给定这些共现的数据集,矩阵M中的一个元素由

其中𝑏= |D ’ |/|D|为负样本与正样本之比。

他们的证明假设嵌入的维度至少是单词/上下文集的基数;Li等人[18]的分析放宽了该等价成立的假设。包括[4]和[8]在内的几项研究提出了单词上下文共现的生成模型,以解释基于pmi的方法在线性化单词语义属性方面的有效性。最近,Allen等人在[2]和[3]中的分析基于PMI矩阵的几何特性对这一现象进行了解释,而不需要生成模型所要求的强大假设。对跳跃式PMI矩阵的广泛研究和结果使它成为表征学习中一个内在有趣的对象。

2.3 Networks

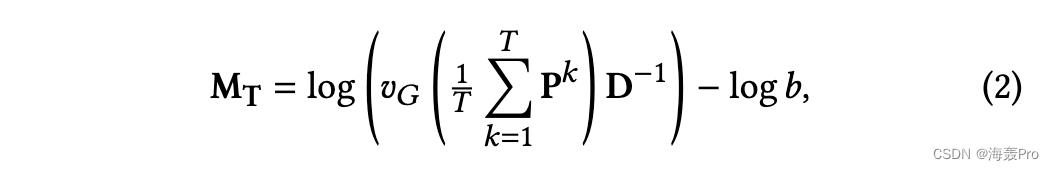

DeepWalk方法[25]将SGNS模型应用到网络中,其中单词和上下文集是网络中的节点,共现对D是出现在长度为𝑇hops的窗口内的节点对,该窗口位于图上运行的长度为𝐿的随机漫步的集合中。Qiu等人[26]在DeepWalk的无向、连通和非二部图上随机行走的情况下,导出了PMI矩阵的以下表达式:在每个节点出发的行走次数𝛾→∞和行走长度𝐿→∞的极限下,其趋近于

其中log是一个元素的自然对数,𝑣𝐺(图的“体积”)是所有顶点的度的和,p = D−1A是随机游走过渡矩阵。

与DeepWalk中从随机行走中采样不同,Qiu等人的NetMF算法显式计算并分解这个矩阵来生成嵌入,在多标签顶点分类任务中显著优于DeepWalk。对于较低的𝑇,NetMF手动计算精确的和,而对于较高的𝑇,它通过对称转移矩阵的SVD计算低秩近似,′P = D−1/2AD−1/2。虽然Qiu等人分析了增加𝑇对得到的矩阵频谱的影响,但他们没有追求𝑇→∞的极限,而是像最初的DeepWalk论文中那样停留在𝑇= 10。我们证明了这个极限矩阵既有意义又易于表示。

2.4 Other Approaches

其他一些节点嵌入算法与DeepWalk有很大的相似之处。Qiu等人[26]表明LINE方法也是隐式矩阵分解,尽管其算法基于边缘采样而不是随机漫步采样。特别地,它的分解矩阵是DeepWalk矩阵的特例,𝑇= 1。我们将LINE的性能包括在我们的实证结果中。node2vec[10]是对DeepWalk的推广,它使用了二阶随机漫步:node2vec漫步中下面节点的分布依赖于当前和前面的节点,而不是像DeepWalk中只依赖于当前节点。超参数允许行走按照需要接近bfs或dfs之类的行为,作者断言它们提取了关于节点相似度的定性不同的信息。

在过去几年中,已经开发了几种以端到端方式将卷积神经网络应用于网络数据的架构,包括 [13] 和 [6] 的图卷积网络 (GCN),并且一些方法利用了这些架构生成节点嵌入:例如,Deep Graph Infomax [32] 使用 GCN 来最大化涉及节点周围补丁的互信息目标。 Wu 等人最近的工作。 [33] 表明,GCN 的大部分复杂性来自受其他形式的深度学习启发的组件,这些形式对网络数据的效用有限。同样,我们寻求进一步研究“深度”网络嵌入的核心原理,除了它们在词嵌入和神经网络中的启发。我们注意到,与 DeepWalk 和相关方法一样,我们专注于无监督嵌入,仅源自图的结构,无需训练,例如顶点标签。

3 METHODOLOGY

我们现在介绍我们的主要贡献,将DeepWalk在无限窗口限制下与经典的非线性光谱嵌入联系起来。

我们讨论了这个观点如何阐明了窗口大小参数𝑇在DeepWalk中的作用,并激发了一种基于拉普拉斯伪逆图的二元阈值的非常简单的嵌入技术

3.1 Derivation of Limiting PMI Matrix

我们首先展示如何简化(2)中DeepWalk PMI的表达式,该表达式由极限𝑇→∞中的[26]给出。我们首先建立了图上关于随机游走的一些众所周知的事实。

首先,在我们假设图是无向的、连通的和非二部的情况下,P∞是有定义的。它的秩为-1,等于1′𝒅⊤,其中1是1的列向量,而′𝒅是随机游走平稳分布中每个顶点的概率质量作为列向量。注意𝒅𝑖= D𝑖𝑖/𝑣𝐺。也就是说,在平稳分布中一个顶点的概率质量与它的度数成正比。我们让′D = D/𝑣𝐺表示包含条目′D𝑖𝑖=′𝒅𝑖的对角矩阵。

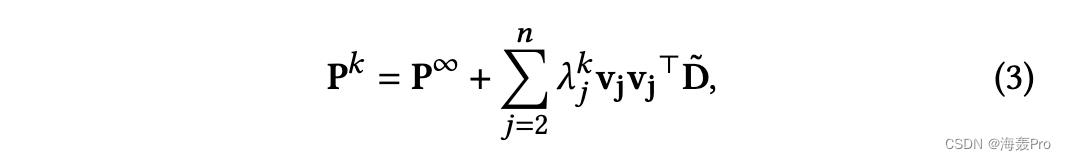

设𝜆𝑖和wi为对称跃迁矩阵的𝑖th特征值和特征向量= D−1/2AD−1/2。我们有𝜆1 = 1和w1 =(√×𝒅1,…,√̃𝒅⊤𝑛)。从[16],对于任何正整数𝑘,

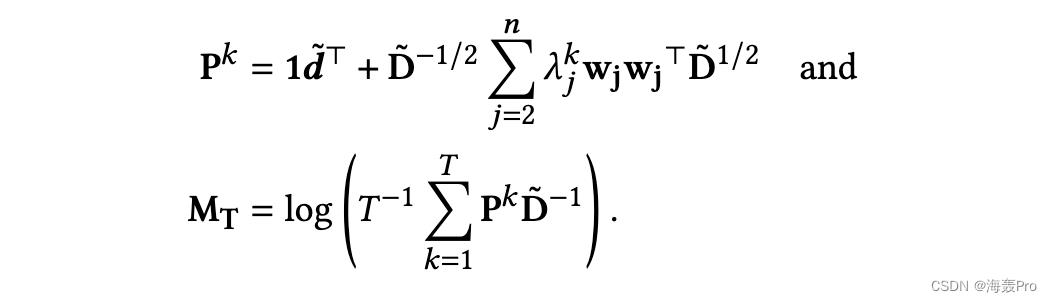

其中vi = ’ D '−1/2wi。对于P𝑘,我们重写(3)中的表达式,对于PMI矩阵,我们重写Qiu等人的表达式(2),将后者的负抽样比𝑏设为1(即,每个正样本对应一个负样本):

将前者代入后者,然后重新排列求和的顺序并应用几何级数公式得到

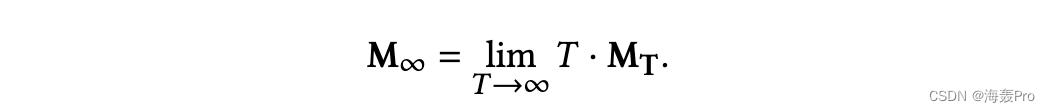

现在我们考虑极限为𝑇→∞。定义

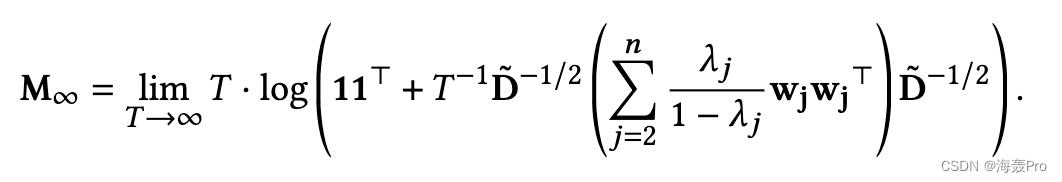

由于𝑗≠1[16]时|𝜆𝑗| < 1,当𝑇→∞时(1−𝜆𝑇𝑗)项趋于1,我们有:

因为日志(1 +𝜖)→𝜖作为𝜖→0,对于任意常数实数𝑐,𝑇日志(1 +𝑇−1𝑐)→𝑐作为𝑇→∞。我们应用这个单位元素,然后简化:

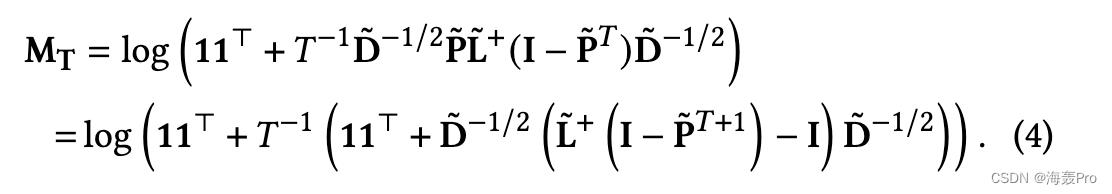

其中,最后一步是从w1开始的,它是元素的平方根。注意,上面的方程给出了(1)中M∞的表达式,since, D = D/𝑣𝐺。类似的分析还得到有限-𝑇PMI矩阵的一般表达式:

3.2 Approximation of Finite-𝑇 PMI Matrix via Limiting PMI Matrix

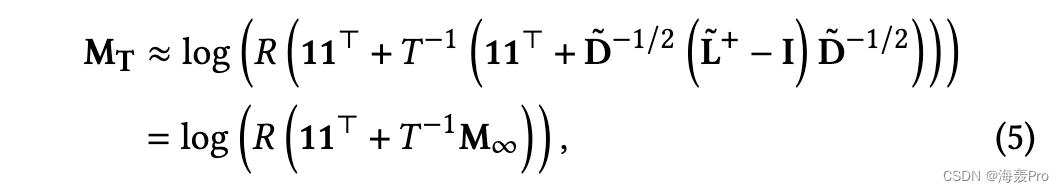

注意,对于有限矩阵-𝑇的表达式(4),当乘以𝑇−1时,与极限矩阵的区别仅在于项(D−1/2)× L+ × P(𝑇+1)× D−1/2,当𝑇→∞时,该项消失。因此,我们可以将有限的-𝑇矩阵近似化,只需将这一项去掉如下:

其中𝑅(𝑥)是任意斜坡函数,以确保对数的参数为正。在我们的实现中,我们使用函数𝑅𝜖(𝑥)= max(𝜖,𝑥)。对于𝜖,我们使用64位浮点机精度限制(∼𝑒−36)。注意,[26]的NetMF方法使用𝑅1(𝑥);我们发现,小的正数值始终表现得更好。两个斜坡函数都可以解释为产生Levy和Goldberg介绍的正移位PMI矩阵(移位PPMI)矩阵[17]。其他避免对数无效参数的方法是未来工作的一个有趣途径。

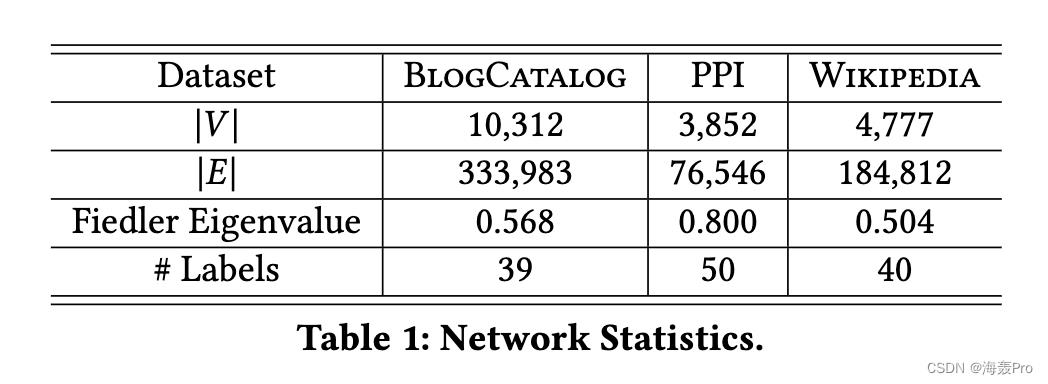

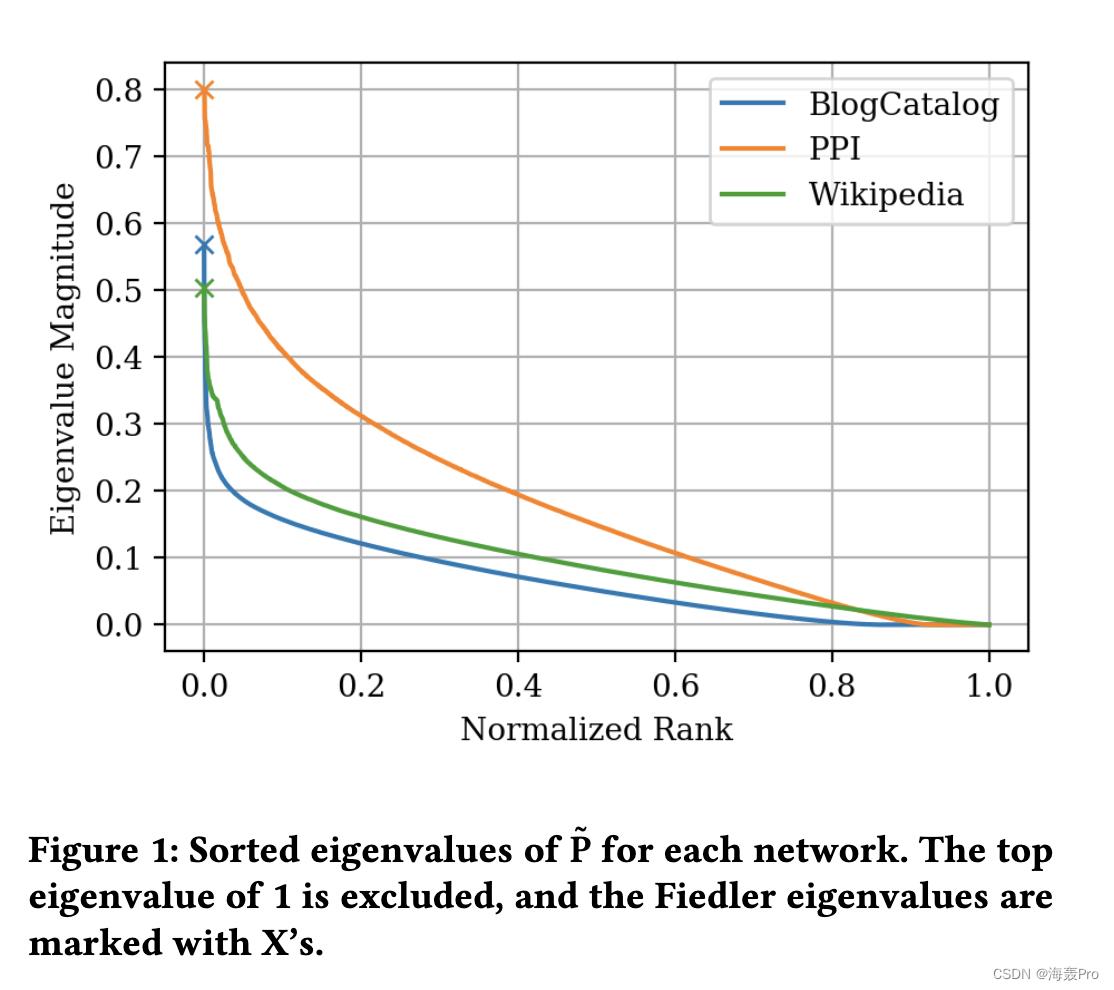

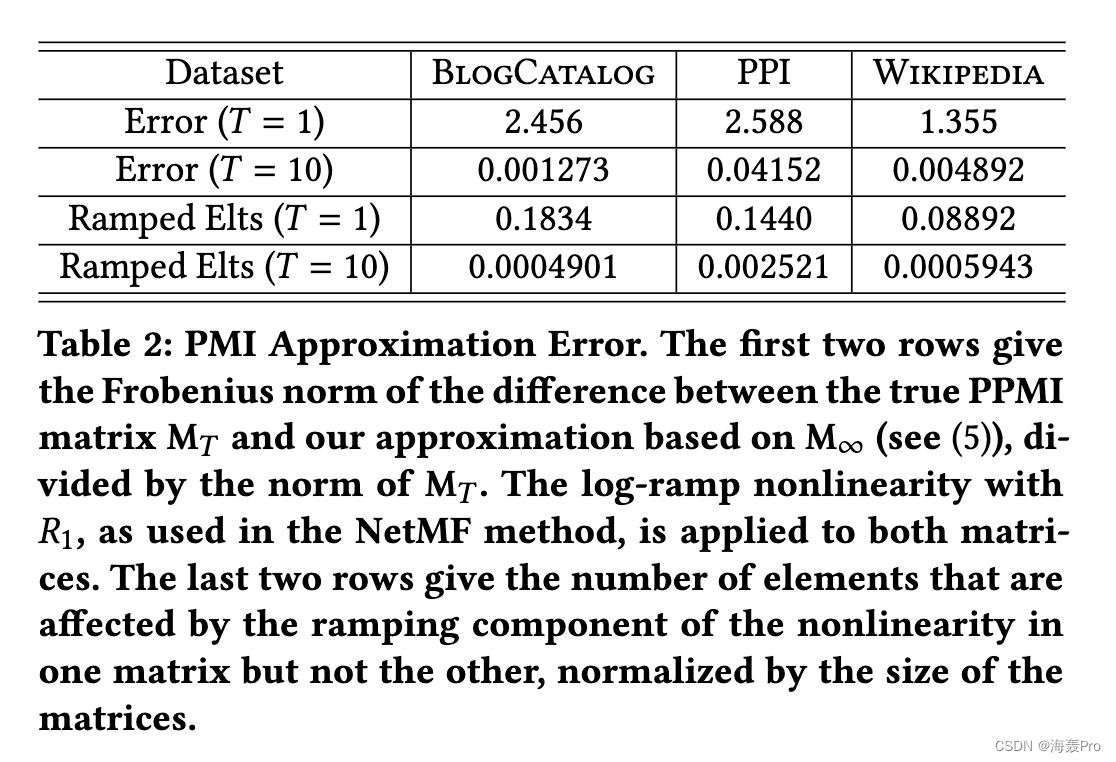

注意(5)的准确性受到了第二大特征值(即费德勒特征值)的限制。该特征值的大小越小,混合速率越快,即随着𝑘的增加,P𝑘→P∞的速率越高。在第4.2节中,我们展示了对于典型的图,费德勒特征值相对较小,因此对于较大的𝑇,近似非常准确,例如𝑇= 10,这是DeepWalk的典型设置。对于小的𝑇,近似就不那么准确了,例如𝑇= 1(见表2)。

窗口大小的影响𝑇。直观地说,(5)中𝑇的作用是控制对数非线性的“强度”,因为,如前所述,对于任何实常数𝑐,log(1+𝑇−1𝑐)→𝑇−1𝑐作为𝑇→∞。也就是说,在这个极限下,对数变成了一个简单的线性缩放。正如我们将看到的,即使(5)的近似值不准确(当𝑇非常低时),这个近似值矩阵在定性上与实际的𝑇-window PMI矩阵具有类似的属性,并产生类似的质量嵌入(通过下游分类任务中的性能来衡量)。这一发现表明,对数非线性的强度可以影响嵌入的局部性(在DeepWalk中通过窗口大小𝑇调制),独立于修改非线性参数,其中包含了通过长度-𝑇窗口过滤的网络的实际信息。

3.3 Binarized Laplacian Pseudoinverse

DeepWalk是具有入口非线性的经典拉普拉斯因式分解的变体,受此观点的激励,我们研究了InfiniteWalk的高度简化版本。我们通过以下方法构造一个二元矩阵:1)计算非归一化拉普拉斯L+的伪逆;2)选取一个分位数超参数𝑞∈(0,1);3)确定分位数𝑞元素的值;4)将所有小于该值的元素设为0,其余设为1。换句话说,矩阵B中的一个元素由B𝑖𝑗= [(L+)𝑖𝑗≥𝑐]给出,其中𝑐是L+的𝑞quantile元素。然后,我们通过将这个矩阵B部分因式分解成PMI矩阵来生成嵌入。有趣的是,这可以解释为对隐式派生网络的邻接矩阵进行因式分解,其稀疏性由𝑞决定。更好地理解这个网络的结构和解释是未来工作的一个有趣的方向。

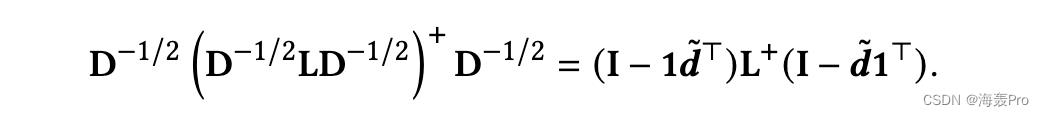

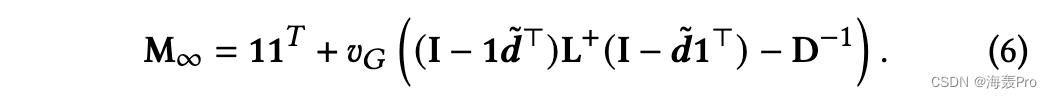

注意,在此方法中,我们使用非归一化拉普拉斯算子,而不是出现在M∞表达式(1)中的归一化拉普拉斯算子(LaplacianL) = D−1/ 2ld−1/2。这是因为,正如我们将展示的,极限PMI矩阵等于非归一化拉普拉斯矩阵的伪逆,直到第3个秩项和对角线调整。我们可以重写极限矩阵的表达式,通过将归一化拉普拉斯展开为归一化拉普拉斯,如下所示:

考虑上面包含 L 的下括号项。如果该项具有真逆而不是伪逆,则涉及度矩阵的四个因子将简单地取消。相反,对伪逆 [20] 应用 Sherman-Morrison 公式的变体会导致该术语的以下表达式:

这为限制 PMI 矩阵生成以下替代表达式:

在我们用一个分位数将L+二值化的环境中,注意用全1矩阵进行加法和用𝑣𝐺进行乘法不会影响矩阵中元素的秩,用对角矩阵D−1进行减法影响的元素相对较少。因此,我们可能期望通过分位数上的阈值对L+进行二值化,其效果与对PMI极限矩阵本身进行二值化类似。

二值化可以说是用非线性增强拉普拉斯算子的最简单的方法之一。正如我们将看到的,与 DeepWalk 和相关方法相比,该方法具有良好的下游性能。我们认为,这表明深度顶点嵌入相对于基于拉普拉斯因式分解的经典谱嵌入方法的核心进步是非线性的应用。

4 EXPERIMENTAL SETUP

6 DISCUSSION AND CONCLUSIONS

在这项工作中,我们简化了有限-𝑇network PMI矩阵的已知表达式,并导出了𝑇→∞矩阵在拉普拉斯图伪逆方面的表达式。该表达式加强了基于sgns和类谱嵌入方法之间的联系。

我们证明,在一个简单的缩放对数非线性下,这个极限矩阵可以用来近似有限-𝑇矩阵,在下游顶点分类任务中产生竞争结果。这一发现表明,SGNS方法应用于网络的核心机制是经典拉普拉斯嵌入方法的简单非线性变换。我们甚至发现,仅仅通过阈值化拉普拉斯伪逆就可以从经典方法中获得大部分的性能增益,这再次表明了非线性的重要性。

未来的工作。我们将我们的工作视为理解基于 SGNS 的嵌入方法的核心机制的一步。然而,许多悬而未决的问题仍然存在。

例如,有人可能会问为什么标度对数非线性是一个不错的选择。相关地,性能对非线性变化的鲁棒性如何?我们对拉普拉斯伪逆的二值化结果表明它可能非常稳健,但这值得进一步探索。最后,正如所讨论的,我们的二值化方法可以看作是基于拉普拉斯伪逆生成图的邻接矩阵,然后直接分解该矩阵。了解该派生图如何与输入图相关联将是了解该方法令人惊讶的竞争性能的一个非常有趣的下一步。

此外,如前所述,node2vec[10]是DeepWalk的泛化,它添加了额外的超参数来创建二阶随机漫步。Qiu等人[26]还提供了由node2vec隐式分解的矩阵的表达式,因此求该矩阵的𝑇→∞极限可以深入了解node2vec,并对DeepWalk的极限PMI矩阵进行有趣的推广。

结语

文章仅作为个人学习笔记记录,记录从0到1的一个过程

希望对您有一点点帮助,如有错误欢迎小伙伴指正

以上是关于每日一读InfiniteWalk: Deep Network Embeddings as Laplacian Embeddings with a Nonlinearity的主要内容,如果未能解决你的问题,请参考以下文章

每日一读Deep Variational Network Embedding in Wasserstein Space

每日一读Deep Variational Network Embedding in Wasserstein Space

每日一读Large-Scale Nodes Classification With Deep Aggregation Network

每日一读Joint Unsupervised Learning of Deep Representations and Image Clusters

每日一读Joint Unsupervised Learning of Deep Representations and Image Clusters