基于TOF数据库和RGB-D的HOG特征提取和GRNN网络人体姿态识别方法研究

Posted fpga和matlab

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了基于TOF数据库和RGB-D的HOG特征提取和GRNN网络人体姿态识别方法研究相关的知识,希望对你有一定的参考价值。

目录

一、理论基础

预处理:

第一步:由于采集到的深度图有的地方的深度值为零,首先用最邻近差值算法将为零的深度值用其周围的点代替;

第二步:用中值滤波算法对上一步骤获得的图像进行处理,去噪声;

头模型匹配:

第三步:首先对图像进行边缘检测,采用canny算法,对采集后的图像进行距离转换,然后用头模型(图片集中的头模型)进行头部匹配,最终定位人的位置;

提取人形:

第四步:由于人脚与地面处于同一深度,所以先用F响应滤波器对图像进行处理,提取人脚与地面的边缘;

第五步:采用区域增长算法,对定位的人进行提取,最终提取整个人形,方法参考文献1;

特征提取:

第六步:用HOG方法对上一步获得的图像进行特征提取;

第七步:用深度差分算法对第五步获得的图像进行特征提取,特征函数为:

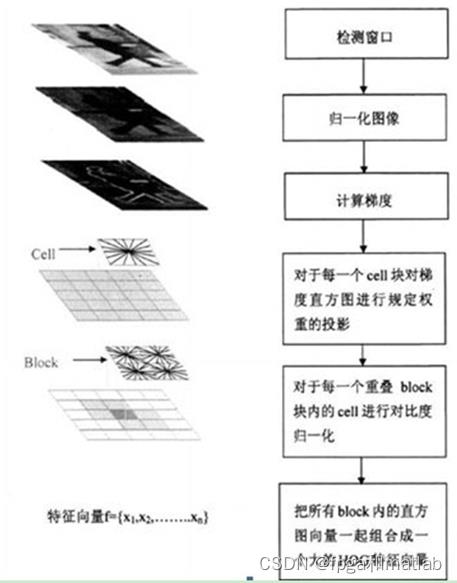

HOG特征提取方法就是将一个image(你要检测的目标或者扫描窗口):

1)灰度化(将图像看做一个x,y,z(灰度)的三维图像);

2)采用Gamma校正法对输入图像进行颜色空间的标准化(归一化);目的是调节图像的对比度,降低图像局部的阴影和光照变化所造成的影响,同时可以抑制噪音的干扰;

3)计算图像每个像素的梯度(包括大小和方向);主要是为了捕获轮廓信息,同时进一步弱化光照的干扰。

4)将图像划分成小cells(例如6*6像素/cell);

5)统计每个cell的梯度直方图(不同梯度的个数),即可形成每个cell的descriptor;

6)将每几个cell组成一个block(例如3*3个cell/block),一个block内所有cell的特征descriptor串联起来便得到该block的HOG特征descriptor。

7)将图像image内的所有block的HOG特征descriptor串联起来就可以得到该image(你要检测的目标)的HOG特征descriptor了。这个就是最终的可供分类使用的特征向量了。

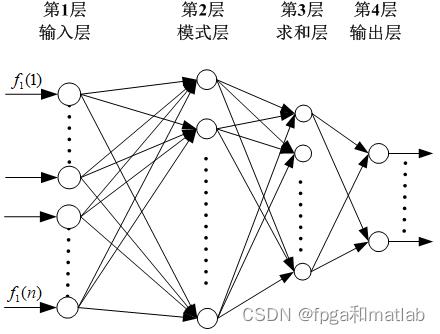

GRNN通常被用来进行函数逼近。它具有一个径向基隐含层和一个特殊的线性层。第一层和第二层的神经元数目都与输入的样本向量对的数目相等。GRNN结构如图2所示,整个网络包括四层神经元:输入层、模式层、求和层与输出层。

二、核心程序

clc;

clear;

close all;

warning off;

addpath 'func\\'

load grnn.mat

NAME = 'cam1';

p0 = ['Imges\\',NAME];

dt = dir(p0);

p = [dt.name];

correct = 0;

for k = 1:length(dt)-3

path = dt(k+3,1).name;

path = dt(k+3,1).name

%这个部分,我们基于cam0这个图像集合,进行库的建立和训练

%这个部分,我们基于cam0这个图像集合,进行库的建立和训练

Ks = 1/2;

I0 = imread([ 'Imges\\',NAME,'\\',path]);

[R,C,K] = size(I0);

if K == 1

I1 = I0;

else

I1 = rgb2gray(I0);

end

I1 = imresize(I1,Ks);

[R1,C1,K] = size(I1);

figure(1);

subplot(221);

imshow(I1);

title('原始图像');

%% 预处理:

%第一步由于采集到的深度图有的地方的深度值为零,首先用最邻近差值算法将为零的深度值用其周围的点代替

I2 = func_nearest_Interpolation(I1);

subplot(222);

imshow(uint8(I2));

title('最邻近差值图像');

%第二步:用中值滤波算法对上一步骤获得的图像进行处理,去噪声;

L = 5;

I3 = uint8(medfilt2(I2,[L,L]));

subplot(223);

imshow(I3);

title('中值滤波');

%第三步:获得二值图

I4(1:floor(5*R1/7),:) = im2bw(I3(1:floor(5*R1/7),:) , 0.9*graythresh(I3(1:floor(5*R1/7),:)));

I4(1+floor(5*R1/7):R1,:) = im2bw(I3(1+floor(5*R1/7):R1,:),1.25*graythresh(I3(1+floor(5*R1/7):R1,:)));

subplot(224);

imshow(I4);

title('二值图');

%第四步:边缘图

I5 = edge(I4,'canny');

%第五步:distance map

I6 = func_distancemap(I5);

I6 = 255-uint8(255*I6);

figure(2);

subplot(221);

imshow(I6);

title('distance图');

%第六步:提取上半身

[Is,Is_edge,indy] = func_bodycatch(I4,I6);

Is2 = bwareaopen(Is,4000);

subplot(222);

imshow(Is);

title('提取上半身');

subplot(223);

imshow(Is2);

title('提取上半身边缘');

%人体的提取

ff = uint8(255*Is2);

[rows,cols] = size(ff);

[Ls,n] = bwlabel(ff);

X1 = [];

X2 = [];

Y1 = [];

Y2 = [];

flag = 0;

L1 = zeros(R,C,3);

S = [];

for i=1:n

[r,c] = find(Ls==i);

a1(i) = max(r);

a2(i) = min(r);

b1(i) = max(c);

b2(i) = min(c);

w(i) = b1(i)-b2(i);

h(i) = a1(i)-a2(i);

S(i) = w(i)*h(i);

X1 = [X1,a2(i)];

X2 = [X2,a1(i)];

Y1 = [Y1,b2(i)];

Y2 = [Y2,b1(i)];

L1(a2(i):a2(i)+2,b2(i):b1(i),1) = 0;

L1(a2(i):a2(i)+2,b2(i):b1(i),2) = 0;

L1(a2(i):a2(i)+2,b2(i):b1(i),3) = 255;

L1(1.2*a1(i)-2:1.2*a1(i),b2(i):b1(i),1) = 0;

L1(1.2*a1(i)-2:1.2*a1(i),b2(i):b1(i),2) = 0;

L1(1.2*a1(i)-2:1.2*a1(i),b2(i):b1(i),3) = 255;

L1(a2(i):1.2*a1(i),b1(i)-2:b1(i),1) = 0;

L1(a2(i):1.2*a1(i),b1(i)-2:b1(i),2) = 0;

L1(a2(i):1.2*a1(i),b1(i)-2:b1(i),3) = 255;

L1(a2(i):1.2*a1(i),b2(i):b2(i)+2,1) = 0;

L1(a2(i):1.2*a1(i),b2(i):b2(i)+2,2) = 0;

L1(a2(i):1.2*a1(i),b2(i):b2(i)+2,3) = 255;

end

if length(S) > 1

LL = L1;

[V,I] = sort(S);

inds = I(end-1:end);

[RR,CC] = size(Is2);

IF = zeros(RR,CC);

for i = 1:RR

for j = 1:CC

if Is2(i,j) == 1

IF(i,j) = I1(i,j);

else

IF(i,j) = 0;

end

end

end

if X1(inds(1)) < X1(inds(2))

IF1 = IF(X1(inds(1)):X2(inds(1)),Y1(inds(1)):Y2(inds(1)));

XC1 = Y2(inds(1));

YC1 = X1(inds(1));

IF2 = IF(X1(inds(2)):X2(inds(2)),Y1(inds(2)):Y2(inds(2)));

XC2 = Y2(inds(2));

YC2 = X1(inds(2));

else

IF2 = IF(X1(inds(1)):X2(inds(1)),Y1(inds(1)):Y2(inds(1)));

XC2 = Y2(inds(1));

YC2 = X1(inds(1));

IF1 = IF(X1(inds(2)):X2(inds(2)),Y1(inds(2)):Y2(inds(2)));

XC1 = Y2(inds(2));

YC1 = X1(inds(2));

end

end

if length(S) == 1

[IF1,IF2,CUT,IFS,L1] = func_body_fenge(Is2,X1,X2,Y1,Y2);

LL = L1;

XC1 = Y2-30;

YC1 = X1;

XC2 = CUT-30;

YC2 = X1;

end

figure(3);

subplot(131);

imshow(IF,[]);

title('提取上半身边缘');

subplot(132);

imshow(IF1,[]);

title('提取上半身边缘1');

subplot(133);

imshow(IF2,[]);

title('提取上半身边缘2');

%特征提取

Hog_Dat1 = func_feature(IF1);

Hog_Dat2 = func_feature(IF2);

FF1 = sim(net,Hog_Dat1);

FF2 = sim(net,Hog_Dat2);

I0 = imresize(I0,Ks);

I_final = I0;

for i = 1:R1

for j = 1:C1

if LL(i,j,3) == 255

I_final(i,j,1) = 0;

I_final(i,j,2) = 0;

I_final(i,j,3) = 255;

end

end

end

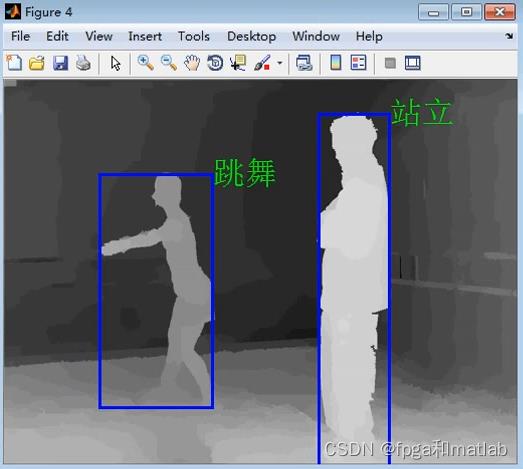

figure(4);

imshow(I_final);

title('姿态识别效果');

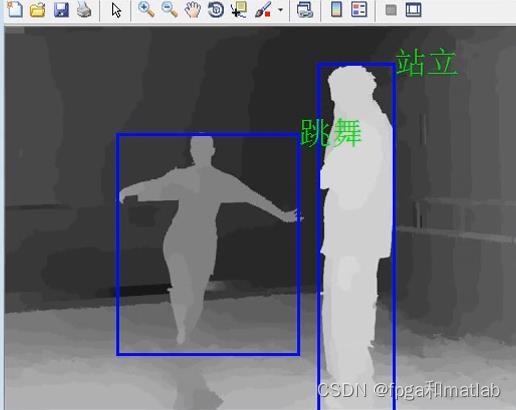

if round(FF1) == 1

correct = correct+1;

text(XC2,YC2,'跳舞','color',[0,1,0],'fontsize',24);

else

text(XC2,YC2,'站立','color',[0,1,0],'fontsize',24);

end

if round(FF2) == 2

correct = correct+1;

text(XC1,YC1,'站立','color',[0,1,0],'fontsize',24);

else

text(XC1,YC1,'跳舞','color',[0,1,0],'fontsize',24);

end

pause(0.01);

end

%计算正确率

corrects = correct/2/(length(dt)-3);

disp('正确率:');

100*corrects

三、仿真测试结果

TOF数据库如下:

A09-43

以上是关于基于TOF数据库和RGB-D的HOG特征提取和GRNN网络人体姿态识别方法研究的主要内容,如果未能解决你的问题,请参考以下文章

车牌识别基于HOG特征提取和GRNN网络的车牌识别算法matlab仿真

基于BP神经网络+HOG特征提取的视频中车辆车牌识别算法仿真