Spark 安装与启动

Posted @SmartSi

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark 安装与启动相关的知识,希望对你有一定的参考价值。

版本:

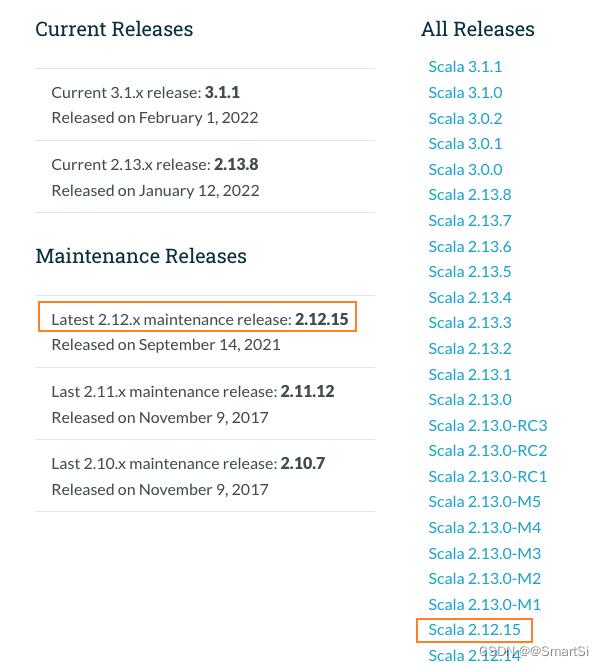

- Scala 版本:2.12.15

- Spark 版本:3.1.3

- Hadoop 版本:2.7.7

1. Scala 安装

我们从官网 https://www.scala-lang.org/download/all.html 下载 2.12.15 版本:

解压到 /opt 目录:

tar -zxvf scala-2.12.15.tgz -C /opt

创建软连接便于升级:

ln -s scala-2.12.15/ scala

修改 /etc/profile 文件设置环境变量,便于后续操作:

# scala

export SCALA_HOME=/opt/scala

export PATH=$SCALA_HOME/bin:$PATH

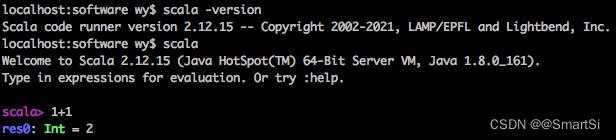

可以与 scala 进行交互来验证安装是否成功:

2. Hadoop 安装

如果没有安装 Hadoop,可以参考:Hadoop 安装与

以上是关于Spark 安装与启动的主要内容,如果未能解决你的问题,请参考以下文章