像素时代的黄昏和“淘宝叛军”

Posted 阿里巴巴淘系技术团队官网博客

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了像素时代的黄昏和“淘宝叛军”相关的知识,希望对你有一定的参考价值。

去年,大淘宝技术相继发布了3D建模工具Obeject Drawer、3D直播间、国内首款AR试表(淘宝拍照),在商家、消费者、学术圈层和外部市场都引起了一定的影响力,媒体和大众对3D XR技术领域的兴趣逐步被点燃。

科技媒体评论员史中,专访了阿里巴巴大淘宝技术的五位专家承越、友闻、长孙泰、豪赞、吕行,共同探讨在“3D&XR”新技术下构建的特色商业应用,给我们的消费生活带来的变革和影响。

以下是采访原文——

文:史中

来源:浅黑科技

如果我们的后代站在未来回望,很可能会把60后、70后、80后、90后、00后、10后,都归为“同一代人”,这个时代就叫“像素时代”。

而从“20后”开始,新一代人出现了,他们的时代叫作“体素时代”。

此时此刻,我们也许正站在历史的转折点上,少数人欢欣鼓舞,而多数人懵然无知。

我厚颜无耻地希望,这篇文章也许能成为大家理解未来的一个小小扳手。

(一)像素时代的“黄昏”

用轻松的方式开场吧,来回顾一下俺们的共同回忆。

比如,我们一起经历过战争与和平。

体验过爱与死。

见证了荣耀与梦想。

也品尝过柴米油盐、江湖恩怨。

但是,你有没有发现一个问题——无论如何努力回想,这些经典的画面都只能以“平面”的方式在我们脑海里放映:

魂斗罗、坦克大战当然本身就是平面游戏;《大话西游》、“奥运开幕”也是同样,我们只能站在摄影师的角度去还原当时的场景,至于镜头里恰好背对我们的人,当时他们有怎样的表情、状态,将成为一个谜,重温者永远不得而知。

网页就更是平面的了,一般人根本不会提出“网页的背面长什么样”这种蛇精病问题——它就没有背面。

平面信息是如此深刻地渗入我们的生活,以至于万物都离不开一个关键词:“像素”。

屏幕要看像素,摄像头要看像素,照片、视频都要看像素。仔细想想,世界上没有任何一个专业技术词汇能像“像素”这样被普通大众所理解,普及到一个农村大妈也能脱口而出。

看到这儿,你也许有点摸不着头脑——像素有啥不好?我从小喝到大,生活中一切需求都能满足啊。。。

你看,有人把电影的演职员表展开,就是一大张图像。

这里按下暂停键,我必须强行问你一句:真的是这样么?

如果把“像素”换成“体素”呢?

1、防止有浅友不知道,我先解释一下什么是“体素”。

其实很容易理解:在平面空间组成信息的元素叫像素,在立体空间里组成信息的元素就叫体素。(一个像素包含xy两个参数,而一个体素包含xyz三个参数。)

比如:《仙剑奇侠传》里李逍遥就是用“像素”拼成的,而在《我的世界》里,主角史蒂夫就是由体素组成的。

2、再解释一下什么是“体素时代”。

当日常生活中的大多数信息都以体素来“标记”和“传递”的时候,我们就四舍五入迈进了体素时代。

举个简单的例子:

你拼了一个很好看的汽车模型,想跟朋友显摆一下。

今天的操作是,你选一个(或几个)角度拍“照片”发到朋友圈,大家点赞;

但未来很可能是,你用手机环绕模型拍一圈,它就会在三维世界自动生成一个立体的模型,你把这个“影像”发到朋友圈,大家就可以随意转动,相当于从无数个角度无死角欣赏你的作品。

当然,你有没有勇气让别人无死角欣赏自己的作品是另一个问题,但这里我想说明的是:

“体素时代”能够传递的信息,比“像素时代”要完整和丰富得多。

你还记得《三体》的结尾有一个经典情节不?

太阳系被未知文明的二向箔从3D状态“拍”成2D状态。“程心旅行团”一行在冥王星上目睹了地球“躺平”的全过程。

文中描述,三维世界的地球内部有丰富的结构,在不损失信息的情况下变成二维的,面积就会变得巨大,像一张宇宙烙饼。

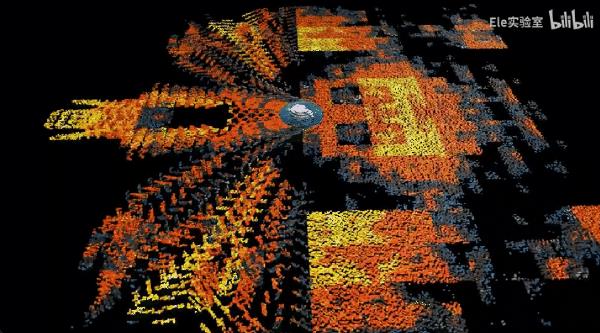

难以想象么?没关系,在B站上有同学(@Ele实验室)用数学方法模拟了这个过程,就如下图:

(链接附后,感兴趣浅友可以移步看完整版)

地球的故事告诉我们,如果“体素时代”的信息量是“弱水三千”,像素时代就只是“取了一瓢饮”。那,有没有一种可能:踏进体素时代,就像一个人住过别墅花园,再也回不去鸽笼蜗居?

体素时代早有征兆:

比如,《黑客帝国》开创的“子弹时间”和《阿凡达》开创的“3D 电影”;比如,以《绝地求生》、《堡垒之夜》为代表的第一人称游戏;比如,Oculus VR 眼镜、正在赶来的苹果 AR 眼镜和各路牛鬼蛇神的元宇宙雏形。

Meta 的“VR 社交平台”Horizon Worlds

这些尝试的意义在于,它们为世界积累了“3D建模系统”、“虚拟渲染引擎”、“头显硬件”等诸多技术。这些技术,可以看做是涓滴细水,而它们终究会汇在一起,成为“时代的泥石流”。

现在,泥石流近在眼前。

最先进入体素时代的将会是我们生活的哪个部分呢?

我盲猜有三个:电商、社交、搜索。

这三个领域,熟不熟悉?梦回2000年,互联网的流金岁月,我们的生活不恰恰也是从这三个领域开始变革的吗?

如果,我们20年前经历的那一波以“像素”为代表的的科技浪潮,在今天以同样摧枯拉朽的姿势重新席卷一遍——我们也许将看到体素时代的淘宝、微信和百度。

这不是在凭空想象,端倪已经出现。

就在前两天,我和淘宝的几个前沿技术团队聊了聊。在他们眼里,体素时代正如黎明一般迫近。而这群技术理想主义者,趁其他人还没睡醒,就已经背上行囊向星辰大海进发了。

(二)前辈们留下的“两把钥匙”

说实话,现在为“体素时代”擂鼓助威,我心里也有点发虚。

为啥呢?因为历史上,这个时代四舍五入已经“来”过一次,而且又走了。。。

那是遥远的2016年,还没有国际形势的剑拔弩张,只有人们对爱与科技的幻想。

那一年,谷歌地球的创始人,整天幻想怪物出没的老男孩汉克搞出了《PokémonGo》(宝可梦Go),人们拿着手机对准无趣的草丛和平常巷陌,就能发现宠物小精灵隐藏其中,一个精灵球甩过去,捕获神兽,爽点爆棚。

《PokémonGo》和汉克

VR/AR 的热潮就这么出现了。

彼时尚未嗅到命运血腥的暴风影音信心满怀推出 VR 眼镜;光线传媒、爱奇艺这样的顶级内容制作商也开始重金制作 VR 影片;明星初创公司 MagicLeap 在网上强推了一个短片——篮球场的木地板上,一只鲸鱼腾空跃起,收获四座尖叫。

当时的淘宝也深受鼓舞,在2016年的“淘宝造物节”上推出了VR购物模块——“Buy+”。人们不用买VR眼镜,也能在手机屏幕上体验到“3D购物”的乐趣。

现在说起“Buy+”,其实很多人都不太记得。

这是因为,Buy+本身就是实验性的。虽然大家第一感觉很惊艳,但在那个技术尚不成熟的世界里,要把“脑袋”转到对准地上的箭头才能走路,可以说“举步维艰”;好不容易走到货架前,商品种类也是有限的,还不能享受和店家讲价的快感。体验并不完善。

所以,尝鲜之后,大多数人也就淡忘了。

但从历史的角度看,Buy+ 意义重大,因为它证明了“体素时代”虽好,但没办法跑步进入。而且,它还用自己的经验教训给后人留下了进入体素时代的“两把钥匙”:

第一把钥匙:人人都得用得起;

这里的人人包括两个,卖家和买家。

当时为一套洗发水3D建模所花的钱,恨不得能买半车洗发水,除了大厂,又有几家公司用得起呢?而且,如果模型稍微精细一点,一般的手机就跑不起来,得用上专业的“头显设备”,这又有几个用户愿意用呢?

所以,大幅降低“建模建设”和“模型渲染”的成本,就是必要条件。

第二把钥匙:体验不能凹造型。

还拿洗发水举例,这类生活用品人人都熟悉,连质感气味形状都知道,好像不必通过3D模型了解。。。这样的场景就很难给人提供新的刺激。

所以,找到能发挥3D模型功能的独特场景,也是必要条件。

2016年的那波 AR/VR 热潮很快就过去了。但“降低成本”和“寻找场景”这两把钥匙却传给了后来人。(这两把钥匙我用绿色字体表示,后面说到钥匙的时候,我还会用绿色标注。)

灰烬之下,开始有了新芽。

(三)体素时代的“商品详情页”

不妨把进度条拉到2021年,也就是我们今天故事的前夜。

你会发现,那时的“淘宝App”就像一个大逃杀战场:很多当年大开大合的 VR/AR 功能都已残血进入了蛰伏期,而一些实用的小功能,反而因为用户的支持“苟”住了。

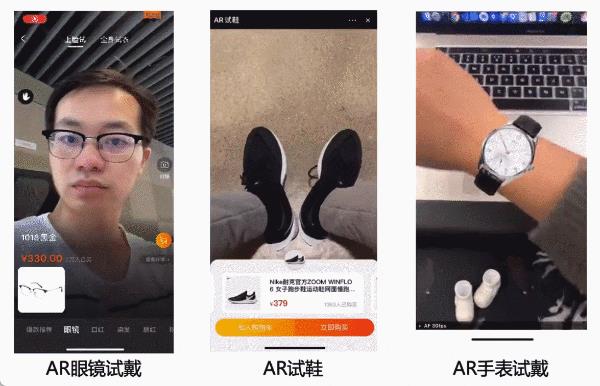

比如,“AR试”。

也就是通过摄像头来试鞋、试妆、试表和试眼镜。

“AR试”之所以能通过大逃杀活下来,恰恰是因为手握那两把钥匙:1)一目了然就能看到商品上身的效果,给用户提供了很实在的参考,这是场景合适;2)运用了一种名叫 WebXR 的轻量化技术,几乎所有手机都能无压力地运行3D计算,这是成本低廉。

注意,刚才我提到一个生词,WebXR。

多介绍几句,WebXR 最早是2016年由 Mozilla(就是做火狐浏览器那个)的几位技术宅提出的框架,它的理想就是:手机上不用下载任何软件,仅仅打开浏览器就能进入3D世界。(XR的意思就是AR、VR、MR,什么R都行)

那几年,虽然 XR 产业遭遇了血雨腥风,但 WebXR 技术本身却在社区的贡献之下日益精进,越来越轻量化,越来越亲民。

好了,有了这些铺垫,现在请上我们今天第一位主角,承越。

承越是个资深 XR 爱好者,2016年的时候就吃了螃蟹——当时他看完 HTC Vive 头显的发布会,直接上头,下单剁手。

(和我打视频电话中的)承越

2021年时,他在淘宝的技术团队负责会场、频道的开发,一方面看到“AR试”很受欢迎,一方面看到 WebXR 在互动技术上有了新进步,他又有点上头:

既然手表、鞋,这种东西能在线试,那么更复杂的东西,例如小家电的拆装和使用,能不能在线试呢?

想到这,他坐不住了,带着几位同学成立了一个“f(x)团队”,尝试把 WebXR 这几年的最新技术推进实战。

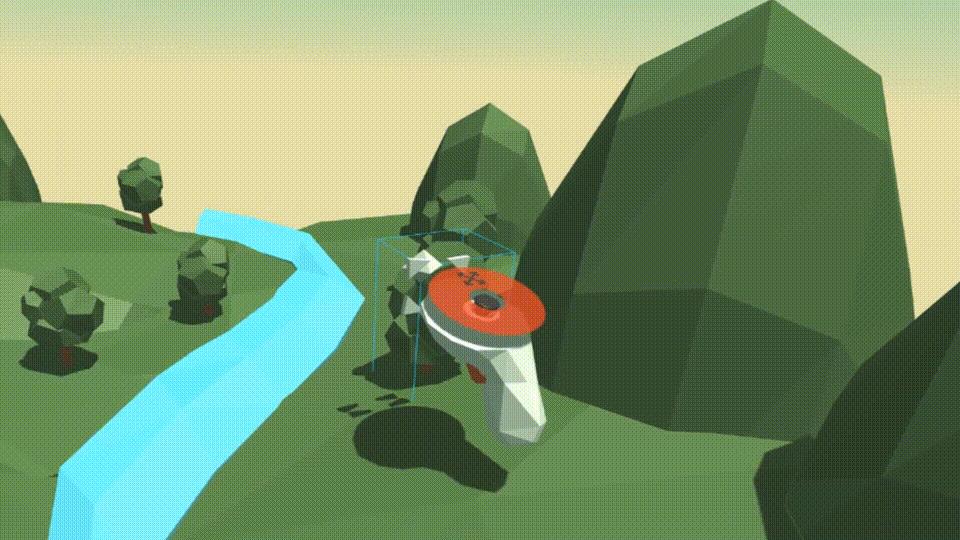

调研了半天,他们决定先做一个“商品说明书”。

啥是说明书?

我们分析发现了一个有趣的现象:人们浏览淘宝商品的时候,通常会在“物品+场景”那张图上停留很长时间,这说明人们不止关心商品本身,更关心商品和环境在一起的信息。也就是,“商品应该用在哪里”。

比如一个吸尘器,有很多组件、吸头,它们怎么装配才能吸地毯,怎么装配才能吸瓷砖呢?

这些信息虽然在家电说明书里都有记载,但人们看上去不直观,我们就把这些组件都做成3D模型,用户在3D空间里拆装、使用,很快就能明白它的用法,这就是“商品说明书”啦。

承越说。

我仔细体会了一下,这么说来,要想做出一个好的“商品说明书”,承越他们不仅需要把“商品本身”变成“可拆装的3D模型”,还得把“商品使用的场景”变成“3D空间”。

但这件事儿没有说起来那么容易——在商品过剩的时代,用户是很挑剔的,你这说明书但凡“不流畅”或者“不真实”,大家就会觉得没必要在这浪费时间,转头就走。。。

于是,第一个坑来了。

悖论摆在面前:要保证流畅,3D模型就要精简;可模型一精简,就会失真,变成五毛特效。

思来想去,承越他们只好对模型分情况“雕刻”——用户可以互动的地方,模型就尽量做得精细,用户不互动的地方,就尽量把模型做小。

说到互动,第二个坑来了。

如果想实现“互动”功能,就必须往这些模型里注入“灵魂”,也就是“功能代码”。但这些代码也会占很大一部分空间。。。

承越告诉我,标准的 WebXR 框架包括很细致的交互动作。比如,你的手放到一个物体上,可以触发一个命令;手指移动,也会触发命令;移动停止也能触发命令,抬起手指还会触发一个命令。

作为一个框架,设计的时候当然要考虑所有情况,无可厚非。但如果直接拿来就用,就会让最终的成品充满无用代码,变得很臃肿。直接表现就是——用户点开之后,要看着进度条加载半天。

所以,要想做出好东西,精简“WebXR”的框架是不可省略的动作。

承越说,为了搞清楚一堆代码之间的调用关系,他们把所有功能都画在墙上,然后用“连连看”把不同模块的关系搞清楚,最后,再一根根剪断。

有点像拆弹部队,面对一堆杂乱无章的线,却不能犯错误。一旦把有用的功能给剪掉,就会“爆炸”。

他笑。

从2022年春节开始,雕刻了两个月,成果斐然,f(x)团队总算把这套 Demo 从最初的几百M精简到了10M以内。这就已经相当于一个短视频的大小了,普通手机、普通网速下载起来也没压力。

至此,不妨再跟着我想象一下这个说明书的样子:

1)一个3D小房间,里面有一个(或多个)商品。

2)你可以进入这个房间,仔细研究商品的功能,而商品各个部位的属性、参数,也都用悬浮泡泡的方式展示在旁边。

3)赛博空间里,这样的3D小房间还可以有很多,无穷无尽,他们之间相互连通,你可以走来走去。

你有没有发现:这个商品的3D小房间,有点像我们熟悉的“商品详情页”。而如果布置妥当,小房间能给你传达的信息,其实比详情页更多、更直接。

也就是说,“3D商品说明书”只是这个设想的初级阶段,未来它很有可能成为新一代的“3D商品详情页”。

说到这,你可能就明白了, 承越他们正是在为“体素时代”的到来寻找那把钥匙——合适的场景。(注意,是绿色字体)

承越帮我设想了一个标准场景:

未来朋友分享给我一个商品,很可能不是商品详情页,而是一个“3D房间”的链接,我只要点击,一秒就能进入这个3D房间,在里面体验过商品的详细功能,如果觉得好,就能直接下单购买!

这听上去还挺酷的。

好,我们继续。如果你接受了“体素时代会有很多3D房间”这个设定,就一定会想到:未来这些房间里恐怕需要大量的“3D商品”来填充。

于是,这些3D商品怎么才能“低成本”、“大量地”建模制作出来,就成了迫切需要解决的问题。

巧了,在淘宝技术团队,恰好有一群大牛在研究这个问题。

(四)“侵略者”和“造物者”

2021年春天,友闻开心地一蹦三尺。

缠绕在他心头的一团乱麻,被一把利剑劈开。

这团“乱麻”是啥呢?

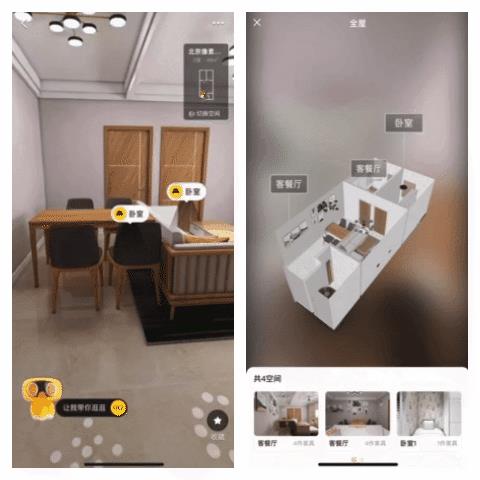

多介绍一句背景:友闻带领一群技术宅,服务于“每平每屋”。应该有不少人用过“每平每屋”,就是阿里巴巴旗下的家居平台,可以在上面买家具,也可以请设计师帮你搞家居设计和装修。

然鹅卖家居是个很费劲的事儿,因为家具款式和装修风格各有不同,顾客很难想象出一个沙发放到一种装修风格里的样子。。。想象不出来,就不敢买嘛。

所以,最好的办法就是“先尝后买”——下单之前,让设计师先帮你做出一套“3D设计图”瞧瞧。

就像这样⇓⇓⇓

但设计师干活儿是要钱的。一个装修方案的3D设计最少也得1000块,一个沙发的手绘3D模型最便宜也要200块。一般人看到这么贵,就打退堂鼓了,我还不如去线下家具店看看实物呢。。。

所以,友闻和团队的任务就是:找到一种方法,用计算机来代替人类进行“建模”和“设计”,大大降低“尝”的成本。

但是这件事儿谈何容易。2020年,友闻和团队研究了一年,尝试了三种不同的技术路线,全都没能成功。。。

友闻

就在这时,那支“利剑”横空出世。

这就是谷歌发表在机器视觉顶级会议 ECCV 上的一种算法:NeRF。

看到这,可能有的浅友心中一惊:顶级会议的学术研究,估计完全看不懂吧。。。放心,后面我会用特别简单的例子来给你说明白。

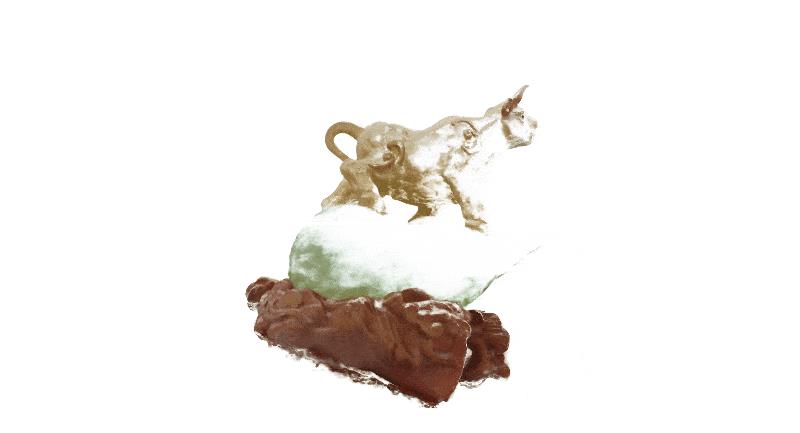

NeRF 的核心奥义就是一句话:原本需要“手绘”的3D建模,用“拍照”的方式来实现。

NeRF 建模就像这样⇓⇓⇓

当然,建模的话,用一张照片肯定不够,得从不同角度多拍几张(或是绕着主体拍一段视频)——只要角度足够丰富,就能靠“想象力”把平面上的“像素”还原成空间里的“体素”。

这个想象的过程,靠的当然不是人脑,而是人工智能。

NeRF 有牛呢?它被技术宅们形容为:人工智能对图形渲染的一次“侵略”。

还是用实力说话吧。你看,给我几张谷歌街景的照片,就能还你一个3D世界的旧金山。。。

连一座城市都能还原出来,还原一个椅子和柜子,还不是小菜一碟么?淘宝商家自己绕着椅子拍一段视频,就能还原出椅子的3D模型,这简直是生产力的史诗级飞跃啊。。。

想到这里,友闻激动万分。

但很快,问题出现了:

NeRF的论文只是理论上可行,但真按照论文的方法做出来一个模型,要消耗大量计算力,渲染一帧就要20多秒;

有一种叫做 FastNeRF 的改良技术可以解决这个问题,但做出来的模型大小超过1G,完全没办法大规模实战。。。

但作为算法界的老炮,他是不会轻易认输的。

一个三维模型,只有表面这一层体素是最有意义的,至于物体的内部和外部的体素,其实并不包含重要信息。

举个例子:西瓜之所以看上去是西瓜,不是因为“西瓜瓤”,而是因为“西瓜皮”。你看不到西瓜内部,并不影响你判断它是个西瓜。

所以,在3D建模过程中,内部体素就可以大幅删减。

当然,举西瓜的例子只是为了说明模型精简的思路。整个2021年春天,团队都在研究一件事情,怎么像修剪树木一样,既不影响模型表达效果,又能把 NeRF 算法的计算量简化到最小。

两个月后,他们成功地把模型的大小从1G压缩到了70M,计算效率也比论文中提升了10000倍。

技术宅们赶紧找来一堆桌椅板凳,实操起来。

新问题很快出现了:这套系统要求拍摄者必须是人肉三脚架、人肉稳定仪。稍微手抖一下,人工智能就会“想象不出来”,换句话说,就是建模失败。。。

即便建模成功,也有可能出现一个诡异的情况,那就是:从某个刁钻的角度看,3D物体会出现缺损。。。

这是为啥呢?

说到这,看来我还得科普一下 NeRF 进行“想象”时候的基本原理。

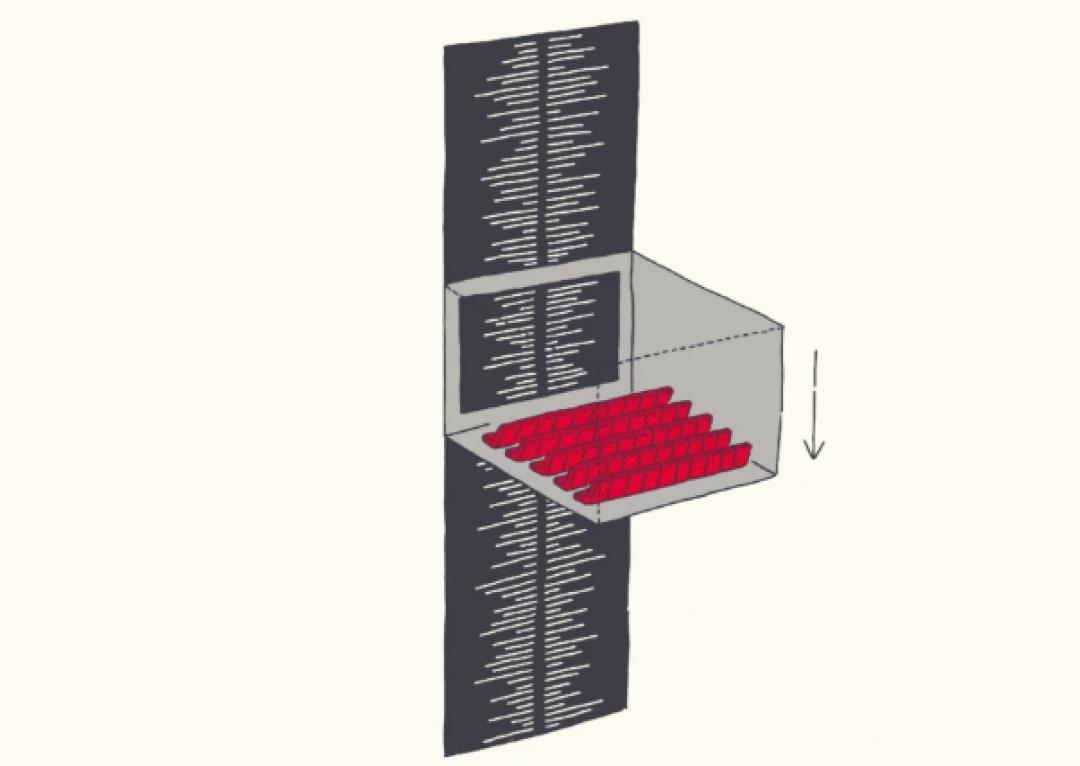

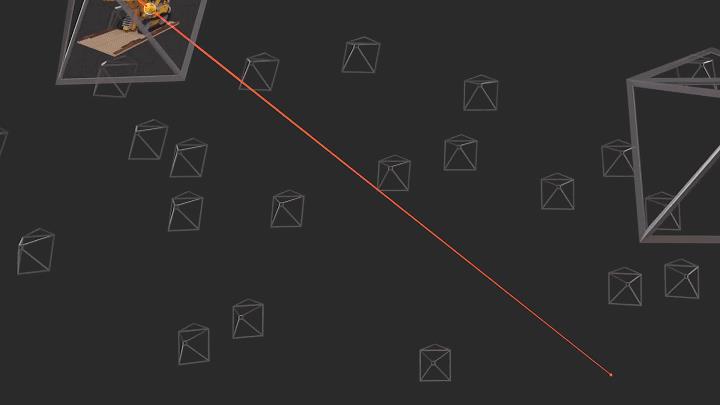

首先,系统会射出无数根“光线”穿过物体;

然后,通过不同光线上同一个点的坐标,反推计算,就能还原出3D模型中体素的准确位置。

在 NeRF 原版的设计中,从一个点射出的光线都是平行的,就像电影《英雄》里,秦国士兵射出的箭那样。结果,就会造成前文所说的“刁钻角度”下模型缺损的问题。

就像这样⇓⇓⇓

友闻他们眉头一皱,计上心来,做了一个小改动,把平行的箭改成了“乱箭”——让每一条光线随机选择角度。这样,在完全没有增加计算量的前提下,却一下子解决了建模质量的问题。

就像这样⇓⇓⇓

当然,类似这样的改进,他们还做了好多,就不一一详解了。这些改进综合起来,就大大提高了建模的成功率。

到了2021年10月,他们已经能做到:一个普通人,用普通手机,学习拍摄10次就能学会建模。

这时,友闻他们才觉得时机成熟了。

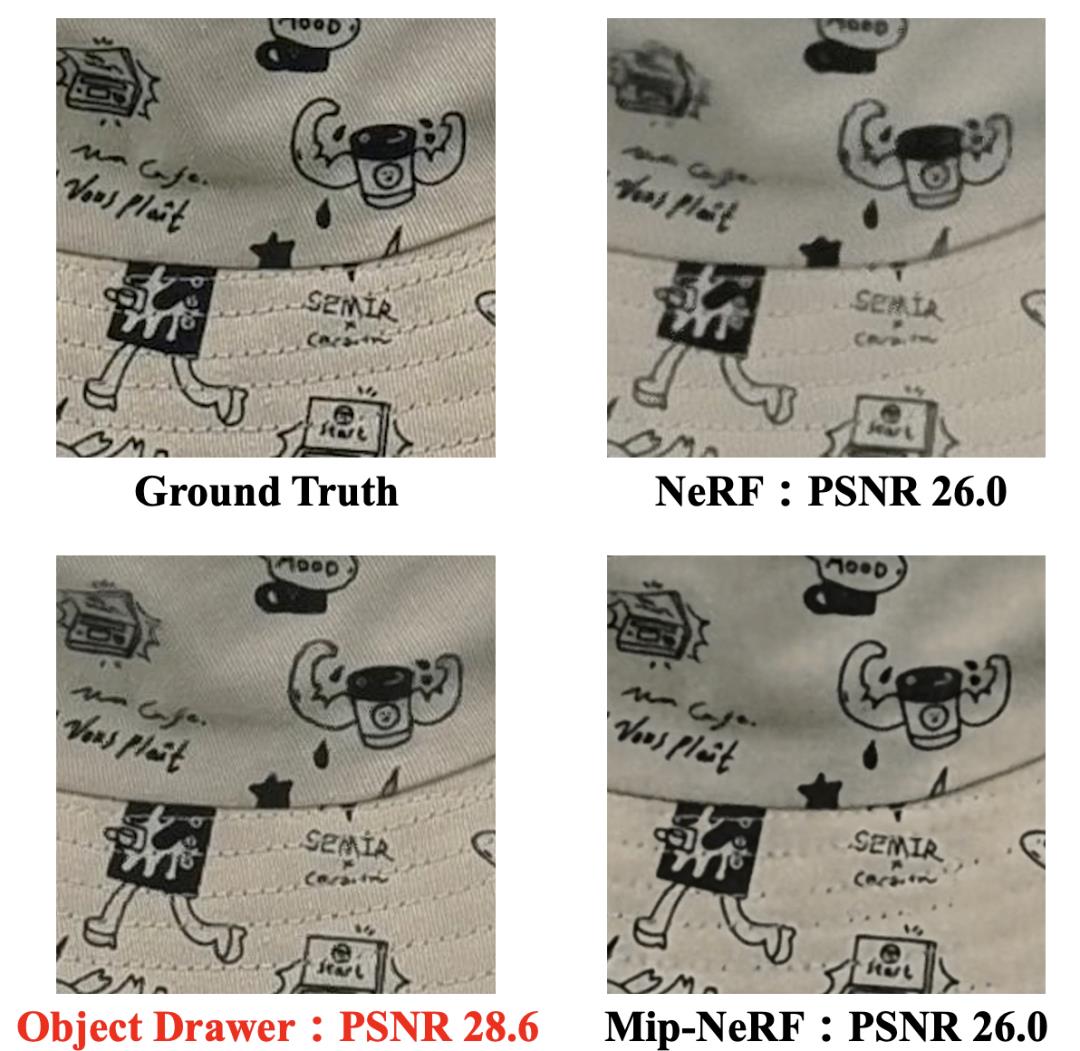

他们给这套系统起名叫做“Object Drawer”,在淘宝内部正式发布。

说到这,这个故事就和我们今天的主题联系起来了:因为友闻他们做的,恰恰就是寻找“体素时代”的那一把钥匙——“降低成本”。

说到这我还得提醒你注意:要想真正进入“体素时代”,降低成本绝不能靠粗制滥造的“五毛特效”,华丽逼真的模型是首要前提。

这不,“Object Drawer” 刚刚发布,就有一些商家申请内测,但是他们用过之后,给出了“吐槽”:

“形状嘛倒是还原得还可以,但是表面纹理为啥有点模糊啊。。。”

友闻有点挠头:“纹理”二字,可击中了人工智能的软肋。

因为人工智能的运算过程的本质是概率推理,这必然会造成相邻体素的参数有一定的相似性。换句话说,模糊就是人工智能甩不掉的内在缺陷。。。

但眼看万里长征已经走了一大半,不能功败垂成。友闻他们只好研究了另一种方案,把传统算法生成的纹理叠加在 NeRF 的模型之上。这样一来,在计算成本不提升的前提下,一下子就让表面纹理从“模棱两可”变成了“高清画质”。

至此,“Object Drawer” 被封装成了一个非常好用的“摄像头建模工具”。

虽然在友闻他们看来,Object Drawer 还有很大的进步空间,但不可否认,一个虚拟世界的“模型生产线”已经雏形初现!

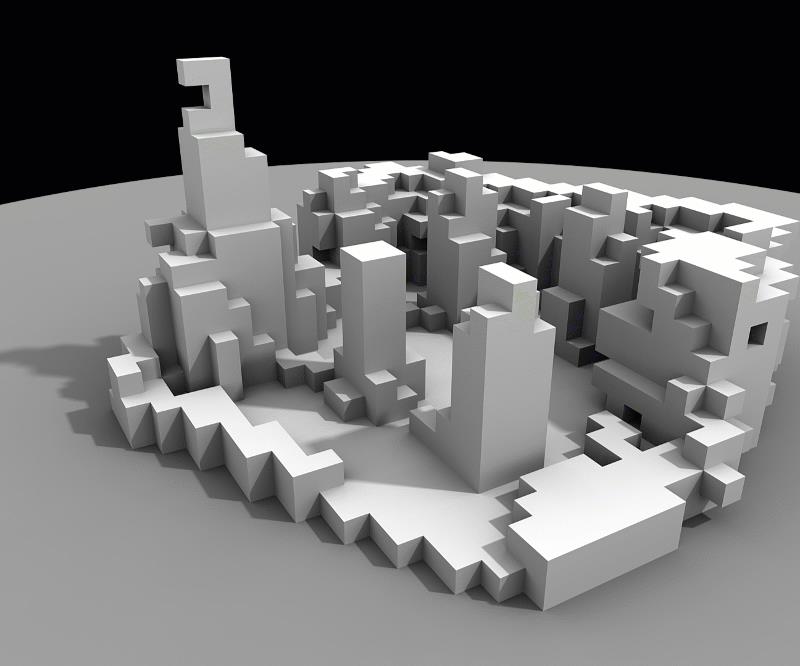

注意,3D模型生产线和实物生产线有所不同:

一个以原子为基础的“物理商品”会随着时间损坏、变质;但以代码为基础的“3D模型”一旦被制作出来,就永远光鲜如初。

这些模型会成为赛博世界里的“基石”,永远坚硬,而且不断堆垒。

你有没有发现,这个过程很像淘宝过去的发展历程。无数商家们不断把自己的商品拍照上传,这些数以亿计的照片积累起来,就成为蕴含数据价值的金矿——可以通过人工智能学习服务商家,也可以用于未来虚拟空间的设计和搭建。

从这个角度理解,3D模型的价值,比图片的价值只多不少。

当然,这些设想都是后话。眼下,在这些模型积累的过程中,它们能发挥什么价值呢?

起码有一条路,已经能走通了:一群技术大牛,正在把这些3D模型塞进主播们的带货直播间,把“普通直播间”升级成“3D直播间”。

(五)3D直播间

经常看直播购物的浅友可能知道,现在的直播已经非常“卷”了,主播们光是在镜头前耍嘴皮子已经远远不够了。

他们得搞些大场面。

比如李佳琦,他的直播间就会在大促的时候,租下一个巨大的演播室,然后聘请晚会级的灯光、舞美团队。几百号人共同协作,才能完成一场直播狂欢。

这是李佳琦日常直播,也需要40-60人的团队。

但讲真,这样的阵势确实费钱,没个几百万是搞不下来的,不是头部主播根本不敢这样玩。

在长孙泰眼里,这样的实景直播好是好。。。但也。。。不是很有必要。。。

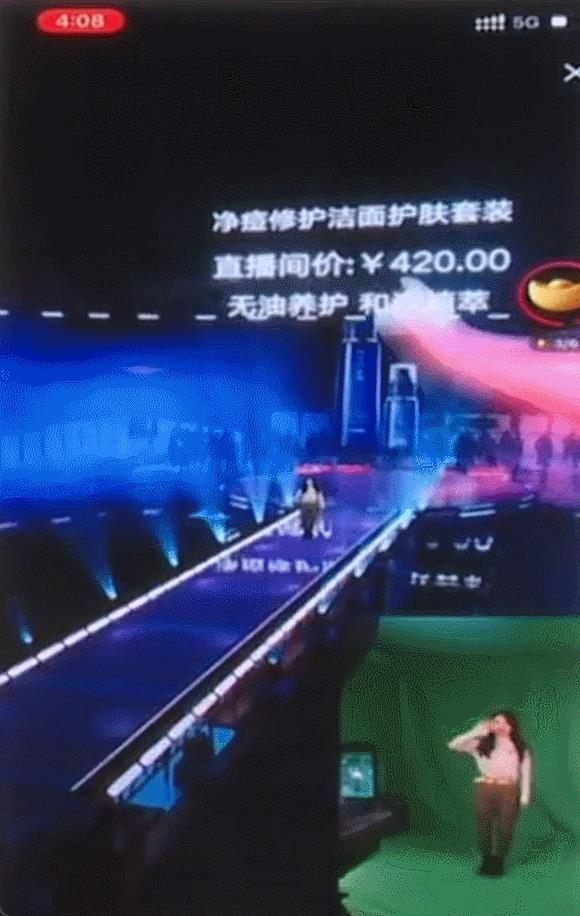

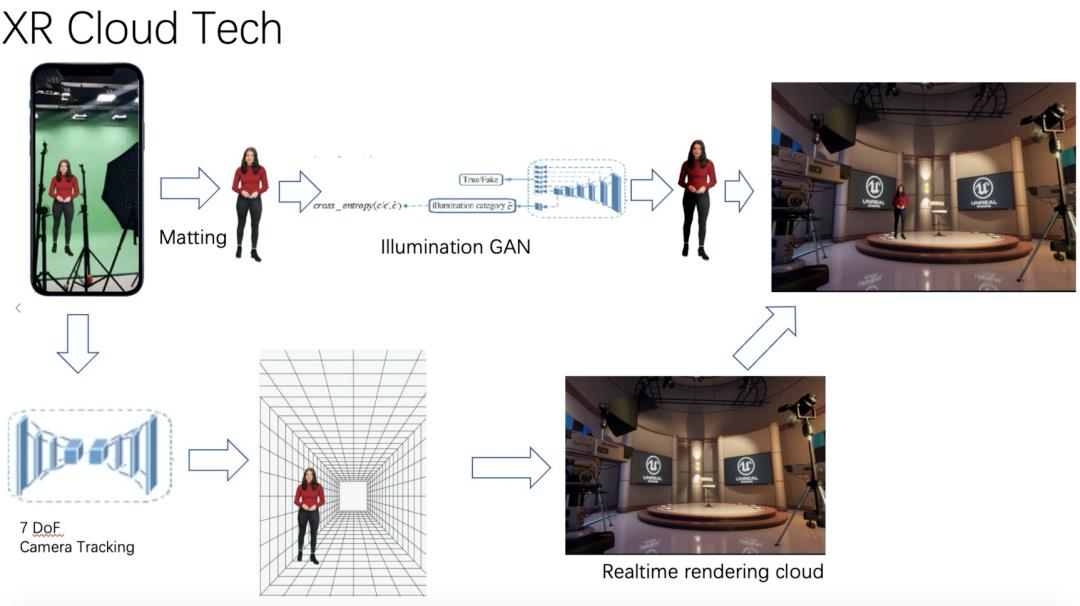

因为他和团队可以用一整套3D技术,实现虚拟场景直播——人只要站在绿幕前,就可以被传送到一个盛大的舞台中央。

这个舞台可以在深山老林,也可以在古堡花园,可以漫天飞着鲸鱼,也可以建在月球的环形山里,总之,压根不用受物理定律的限制。。。

这不,2021年的“618 大促”,小米在天猫进行了一场盛大的带货直播。

他们使用的技术就是“3D直播间”。

注意,这些舞台元素不是随便“Ctrl+V”过来的妖艳贱货,而是专门为这场直播从头设计的。但即便是专门团队制作了整套舞台3D形象,成本也只是几万元量级,比搭建实景舞台便宜得多。

这是小米的直播间

长孙泰伸出三个指头,给我科普:“凡是卖货的场景,都分为三个要素:人、货、场。”

所谓人,就是主播,用绿幕抠图的方法来捕捉影像。(当然也可以是数字人,这里篇幅有限不讨论了。)

所谓货,就是要卖的东西,它可以是主播手上拿着实物,也可以以“3D模型”的方式出现在主播身边的“虚空”中。

所谓场,就是舞台。

对于“3D直播间”来说,场,也就是舞台是最复杂的。

之所以复杂,还是因为要求高。由于直播效果是要和专业的舞台相对标的,所以这些背景模型没办法做到像友闻他们用 Object Drawer 扫描出来的模型那么小。

这就造成两个结果:

1、舞台目前还需要专业团队来制作;

2、要想把这个舞台运行起来,需要一个配置非常好的电脑。(手机暂时不行)

退回到2021年夏天,如果你想搞一个3D直播,需要有一个小团队去到你家辅助你:一部分人负责支绿幕、打光;一部分人操作电脑,在旁边把人物影像和虚拟背景合成起来。

估计你也感受到了,这样的操作临时搞一两次还可以,但好像不能作为标准方法大量推广。

原因就是——这样的成本太高。

这么高昂的成本,是无法带领广大主播进入“体素时代”的。

于是,整个2021年下半年,长孙泰和团队就在尝试把这一整套系统搬到云端。

他们要达到的目标就是:

1、主播只需要像平常一样直播,可以有绿幕也可以没有绿幕,打光更好不打光也行,系统都能自动把他们的人像抠出来。

2、3D舞台和3D商品的计算全部在云端运行。主播的人像传到云端,和背景叠加之后,直接传输到千万剁手党的手机上。

这样一来,不用专人去现场辅助直播,成本直接大幅降低——无论是大主播还是小主播,就都能方便地搞出自己的“3D直播间”。

这是云上XR直播的全流程

长孙泰提醒我:“虚拟商品”这样的资产可以积累,“虚拟舞台”这样的资产也是可以积累的。

不妨拿乐高积木打比方:

乐高积木生产的过程固然比较复杂,需要在工厂里实现;

但是一旦生产出来,再用这些积木拼插出无数有趣的场景,就变得简单了,普通人也能玩得转。

主播可以买来“积木”自己拼搭,这就是它私有的直播间(不与别人分享);主播也可以选择在淘宝上直接使用公共3D直播间,在上面做个性化微调。

这样,使用“公共3D直播间”的主播越多,平摊下来,制作成本就越低。

假如制作一个精美的舞台用了5万块,结果有5万个主播都选择共用,那就相当于每人众筹1块钱。

我和长孙泰聊天的时候,3D直播间的技术尚在打磨中,目前还没有开放给普通主播使用。但他很有信心:“用不了多久,普通的主播,甚至夫妻店,就能拥有自己的3D直播间了。”

长孙泰

说到这儿,我们不妨回到历史的上空,俯视现在这个时间点已有的一切:

我们正在拥有价格低廉的“3D模型”,也有了价格低廉的“3D房间”和“3D直播间”,它们共同构成了“体素世界”的雏形。

接下来,终于到了灵魂拷问:

普通人(也就是你和我)目前只能隔着手机屏幕*观察*和*控制*这个世界,但不能方便地“置身其中”。

之所以这样,是因为我们还缺乏一个成本低廉,表现稳定的“任意门”,这个任意门,就是“XR 眼镜”。

当然,无数技术人曾经和正在尝试造出这扇门,比如“先烈” Google Glass, Meta 的 VR 眼镜 Oculus,微软的 VR眼镜 Hololens,国产 VR 眼镜 Pico,还有万众期待的“苹果眼镜”。(哦还有罗永浩老师即将推出的AR眼镜)

看架势,这将是一个史诗级的科技赛道。

从左至右:Hololens、Oculus、Google Glass

但问题在于:在杀手级的“XR 眼镜”普及之前,写软件代码的技术宅们不能闲着。他们必须提前“抢跑”,一旦硬件具备,软件要马上能安装进去。

豪赞,就是抢跑的大牛中的一位。

(六)两个世界间的“挂钩”

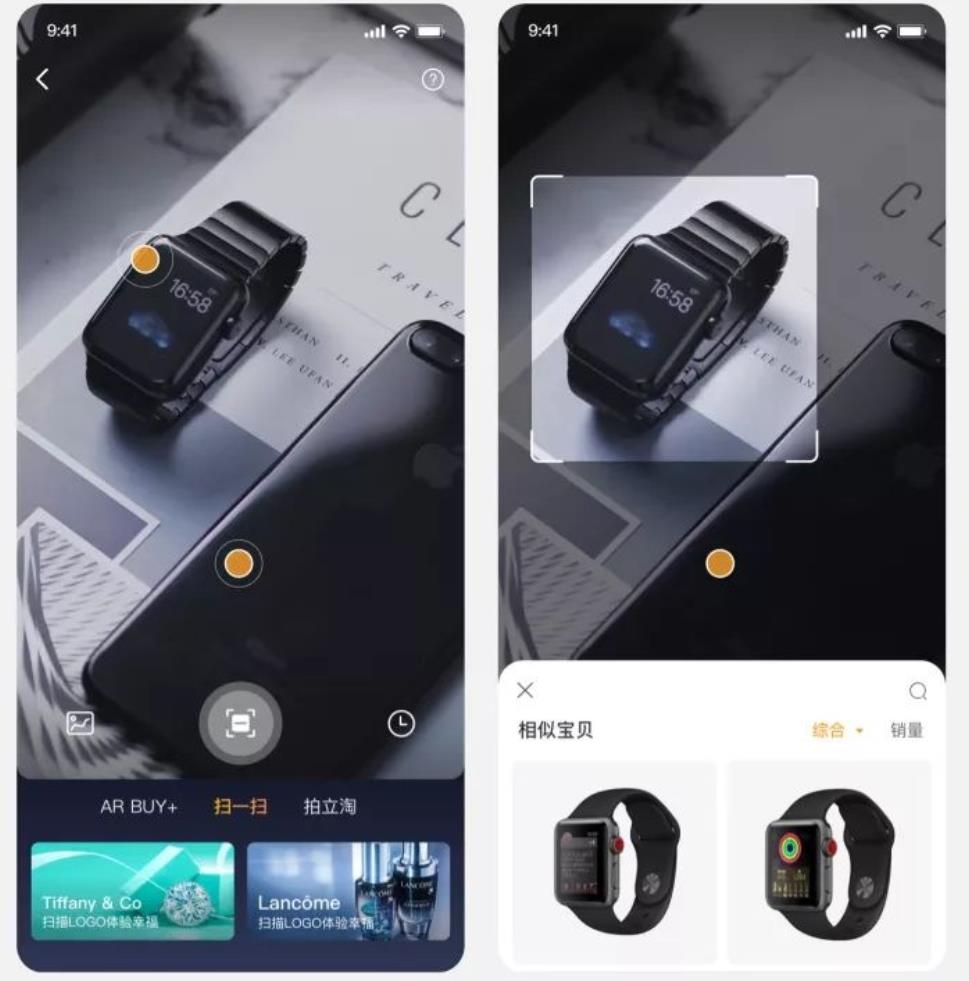

很多人应该都用过淘宝里的“拍立淘”功能。

你对着一个东西拍张照片,立刻就能搜索到相关商品。

2019年的拍立淘

在普通人眼里,这只是一个辅助购物的小特性,可是在豪赞眼里,这却是通往未来的绝佳入口。

因为“拍立淘”这个场景,把“现实世界”和“体素世界”联系起来了。(注意,我用了绿色字体,说明这是一个合适的场景。)

为什么这么说呢?最近,豪赞他们为拍立淘升级了一个“XR看世界”的新功能,从中可以看出端倪。

过去你需要拍一张照片上传,它才启动搜索;现在不用了,你只要拿摄像头对着世界,系统就实时工作,帮你识别视野里一切物品,然后跳转到商品详情。(这个光说你感受不强,你可以现在就打开拍立淘感受一下。)

“XR看世界”,从本质上来讲,就相当于做出了很多包含信息的“3D泡泡”,追踪在实体物品之上。

你想想看,如果这时把“手机”换成“XR 眼镜”,会发生什么呢?

没错,你眼前世界的一切物体,都可以被附加上“3D泡泡”:“

路边不认识的花,上面有泡泡会显示它的名称、习性。

路边不认识的车,上面有泡泡会显示它的品牌、价格。

路人穿的衣服很好看, 系统也能在淘宝商品库里给你找出来一模一样的。

怎么样,瞬间有了科幻电影里的感觉了吧?

这一整套技术,有一个名字——XR 互动技术。

豪赞就是这方面的专家。

人们通过拍立淘找到了想要的商品,就会购买。在我看来,这些购买就是对我们“XR 互动技术”的认可,是“点赞”。将来,大家不仅可以通过 AR 买东西,还可以通过 AR 看世界,我们就会得到更多的赞,所以我的花名就是“豪赞”!

豪赞老师有理有据给我解释。

豪赞

你有没有发现,XR互动技术就像“物理世界”和“体素世界”的挂钩,把两个原本没有关系的世界给联系起来了。

不过,要获得“豪赞”并不是那么容易的事情,因为这个“挂钩”背后的技术还是挺复杂的。

我们来拆解一下步骤:

1、要把摄像头采集的视频切分为一帧一帧的静态图片;

2、用人工智能找到静态图片里究竟包含哪些物体;

3、去云端的数据库里找到和这些物体相关的信息,然后显示在物体旁边的“泡泡”上;

4、运用影像追踪技术,识别出相邻两帧画面中“同一个物体”,就可以让“泡泡”在动态视频中跟随同一个主体移动了。

这一套流程跑下来,计算量可小不了。

实际上,这么大的计算量,靠手机或AR眼镜中的小芯片来搞定,确实是力不从心。。。

所以,豪赞他们处理这个问题的核心思路就是:在整个流程中适当的位置砍掉不必要的计算逻辑。

比如,我们发现人们经常会把A物体放在大腿上。画面实际上出现了两个东西:“A物体”和“大腿”。但人工智能会老老实实进行一系列的计算,然后给出答案:画面里有“A物体”和“大腿”。

但你有没有发现,整个流程里,识别大腿的计算完全是不需要的?

豪赞解释。

所以,更好的做法是,画面里对“桌面、大腿、手、墙壁”之类的识别动作根本不应该被拉起,这个计算流越早被“压制”掉,就能越省计算力。

但是,靠技术宅们手动定义哪些东西不应该被识别,这既不准确,效率也不高。

这里涉及到人工智能改进的一个通用方法,就是:通过用户对每次搜索的点击行为,来修正系统的行为。

比如,最开始系统经常都能搜出“大腿”,但绝大多数用户不会点击“大腿”,更不会购买“大腿”(也就是不给“大腿”点赞),这个动作就被称为“负样本”。

在人们使用“XR 看世界”的功能时,“负样本”会源源不断传送给人工智能用来学习,很快,系统就知道大腿是不用识别的,从而越来越精简,计算量不断变小。

这就是系统“剪枝”的过程。

不过,仅仅靠“剪枝”,剩下的“主干”还是太大,没办法把计算量控制在设备的能力范围。

于是,豪赞他们必须做得更多:能不能在不影响AI模型效果的前提下,把“模型的主干”变小呢?

目测,这种既让马儿跑又不让马吃草的操作还真能实现。这里给你隆重介绍一个逆天的“推理引擎”——MNN。

啥是“推理引擎”呢?

我们不妨拿汽车引擎来类比。

同样是98号汽油,用A引擎就能跑到200km每小时,且油耗很低;用B引擎只能跑到100km每小时,且油耗很高。

这里的汽油就是前文所说的“AI模型”,用同样的模型,却能跑得更快,更省计算力,就是“推理引擎”的职责了。

“用 MNN 引擎,不损失精度的情况下,至少可以把模型减小一半。如果把精度牺牲一点,还可以小得多。”豪赞说。

这么神奇的嘛?我赶紧给 MNN 的负责人吕行打电话,请他帮我科普其中的黑科技。

吕行

吕行骄傲地告诉我,MNN 的绝招简单来说可以分为三层:

1、向上看,市面上存在很多人工智能训练框架,他们训练出来的模型各不相同,但是 MNN 可以把这些模型都统一成 MNN 格式。

2、向下看,市面上存在很多手机芯片类型,MNN 为不同的芯片类型搞出了最适合的算子运行模式。提前预制好。

3、在中间,人工智能模型运行时,程序会自动探测自己跑在哪一类芯片上,然后就切换到最合适的预制模式来运行。

听完他的介绍,我感觉 MNN 有点像一个自动驾驶汽车:走平路就用高档位,遇到上坡就自动切换成低档位,路滑就不急踩刹车。

和发动机一样,推理引擎背后的系统依赖非常复杂,技术细节也是极其精细的,精细到 MNN 团队已经有很多世界级的论文产出,被顶级会议收录。限于篇幅,今天我们没办法展开了,后面我会找机会专门写文章讨论。

吕行自豪地告诉我,目前阿里巴巴已经有30多个 App 都内置了 MNN 的模块。

目前,MNN加持的轻量级人工智能可以进行语音识别、视频内容理解,当然也帮助把“XR 看世界”这把钩子做得更小巧坚固;未来,如果出现杀手级的“XR 眼镜”,MNN 肯定也会第一时间适配,把更多普通人拉进体素世界。

(七)数字资产和“淘宝叛军”

因为正处疫情期间,所以和这些淘宝技术大牛的聊天都是在线上进行的。

挂断和大牛们的视频电话,从“体素世界”的想象中抽离回来,我看看窗外熟悉到有些腻味的风景,总有一种肉身沉重的感觉。

估计很多浅友也开始质疑:你说得这么热闹,但我们现在不还活在无聊的现实中么?体素时代到底什么时候来呢?

我必须承认,客观上来说,没有人能精确预言一个时代的到来。

而且,对于一项技术的过度关注,反而会消磨大家对它的善意,2016年的”VR热潮”和如今如出一辙的“元宇宙骗局”已经证明了这一点。

所以,我只想小心翼翼地客观呈现这些大牛们的努力:

他们只是从自己熟悉的家园出发,用各自的方式开始了远征,为体素时代悄悄准备“砖石”——一旦未来降临,我们手中不至于赤手空拳。

承越告诉我,他们的“3D说明书”正在努力从“小家电”拓展出去,很快,大家就能看到冰箱、洗衣机这样大家电的3D说明书。他们也在尝试做出3D世界的“穿鞋带说明书”,甚至还有美妆产品的说明书——让大家在虚拟世界就能体会到各种化妆品的使用顺序和使用效果。

“这些尝试未必都能成功,但值得我们尝试。”他说。

长孙泰告诉我,他希望不就得将来,每个大小商家都有各自的“云上直播间”。

商家可以像装修房子那样,不断修改、丰富云上直播间的样子,还可以添加新的3D摆件。不仅如此,还能根据直播的主题在各个直播间之间切换,就像一个人在全国每个城市都有别墅,想住哪套住哪套,土豪得不要不要的。

友闻告诉我,他们还在奋力改进算法,让 Object Drawer 绘制出来的 3D模型平均大小从20m缩小到5m。

未来,商家上架一个商品,就像现在拍一张照片那么简单。每一个淘宝上的商品都可以有配套的3D模型。

他说。

这样一来,我们买一个椅子,就同时在虚拟世界得到一个“数字椅子”,买一个水壶,就在虚拟世界得到一个“数字水壶”。

于是,我们装点自己家的时候,也能装点自己数字世界的另一个家:

我们在真实的家里,得到的是真实生活品质的提升,而在虚拟房间里,得到的是突破物理定律的自由想象——我们可以让水杯悬在半空,我们可以让屋顶闪耀璀璨银河。

我们可以邀请朋友到真实的家,也可以邀请朋友的数字分身到我们的数字庄园。

数字艺术家 Krista Kim 做了一个 Mars House(火星屋)。他把一片豪宅建设在了荒凉的火星上,使之充满了对于物理定律的挑衅。

所以,我愿意把这些淘宝大牛称为“叛军”。他们反叛的不是任何人,而是像素时代的种种限制,种种无趣。他们相信,人们的3D数字世界里不应一片荒芜,而创造必须始于今天,始于脚下。

也许有朝一日,站在未来,我们回望那个像素时代的黄昏,也许会对当年的先行者们致以微笑。

因为他们坚信,对未来最大的慷慨,就是把一切献给现在。

参考文章:

《一种降维打击的可视化方案》

https://www.bilibili.com/video/BV1Sf4y147J9?share_source=copy_web

✿ 拓展阅读

以上是关于像素时代的黄昏和“淘宝叛军”的主要内容,如果未能解决你的问题,请参考以下文章