cross_val_score的用法

Posted 古月哥欠666

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了cross_val_score的用法相关的知识,希望对你有一定的参考价值。

cross_val_score

交叉验证既可以解决数据集的数据量不够大问题,也可以解决参数调优的问题。这块主要有三种方式:简单交叉验证(HoldOut检验)、cv(k-fold交叉验证)、自助法。

交叉验证优点:

1:交叉验证用于评估模型的预测性能,尤其是训练好的模型在新数据上的表现,可以在一定程度上减小过拟合。

2:还可以从有限的数据中获取尽可能多的有效信息。

常用的是k折交叉验证方法,其流程为:

1、首先,将全部样本划分成k个大小相等的样本子集;

2、依次遍历这k个子集,每次把当前子集作为验证集,其余所有样本作为训练集,进行模型的训练和评估;

3、最后把k次评估指标的平均值作为最终的评估指标。在实际实验中,k通常取3,5,10.

主要用来判断模型拟合的好坏,下面主要介绍下其函数内部各个参数含义:

from sklearn.model_selection import cross_val_score

cross_val_score(estimator, X, y=None, *, groups=None, scoring=None, cv=None, n_jobs=None, verbose=0, fit_params=None, pre_dispatch="2*n_jobs", error_score=np.nan)

estimator:估计器,也就是模型

X, y:数据,标签值

soring:调用的方法

cv:交叉验证生成器或可迭代的次数

n_jobs:同时工作的cpu个数(-1代表全部)

verbose:日志冗长度,int:冗长度,0:不输出训练过程,1:偶尔输出,>1:对每个子模型都输出

fit_params:传递给估计器的拟合方法的参数

pre_dispatch:控制并行执行期间调度的作业数量。减少这个数量对于避免在CPU发送更多作业时CPU内存消耗的扩大是有用的。

pre_dispatch该参数可以是:

none,在这种情况下,所有的工作立即创建并产生。将其用于轻量级和快速运行的作业,以避免由于按需产生作业而导致延迟

一个int,给出所产生的总工作的确切数量

一个字符串,给出一个表达式作为n_jobs的函数,如'2 * n_jobs'

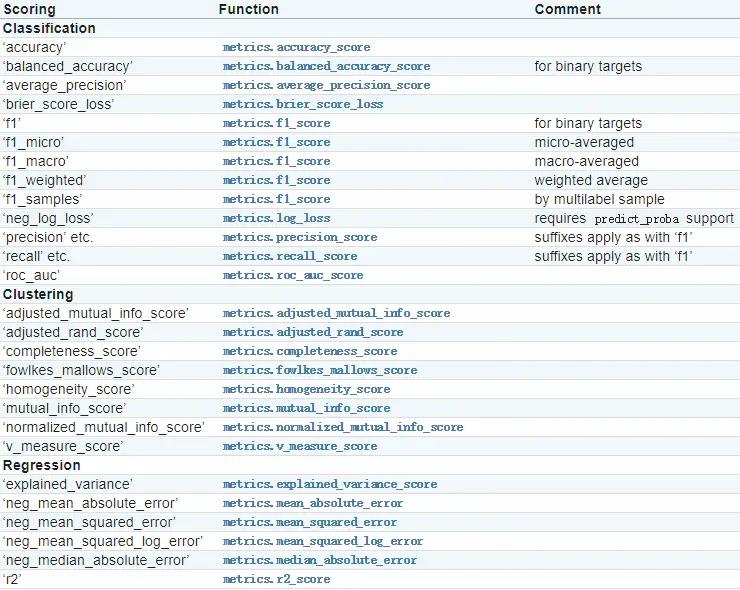

常见的soring方法有

例如

from sklearn import metrics

from sklearn.model_selection import cross_val_score

from sklearn import svm

from sklearn import datasets

clf = svm.SVC(kernel='linear', C=1)

iris = datasets.load_iris()

scores = cross_val_score(clf, iris.data, iris.target, cv=5, scoring='f1_macro')

print(scores)

cv参数

当CV是整数时,cross_val_score默认使用KFold或StratifiedKFold策略,后者会在估计器派生ClassifierMixin时使用。

也可以通过传入一个交叉验证迭代器来使用其他交叉验证策略,比如:

from sklearn.model_selection import ShuffleSplit

n_samples = iris.data.shape[0]

cv = ShuffleSplit(n_splits=5, test_size=0.3, random_state=0)

scores = cross_val_score(clf, iris.data, iris.target, cv=cv)

print(scores)

最后用一个例子调用交叉验证函数来进行模型的一个参数优化

from sklearn import datasets #自带数据集

from sklearn.model_selection import train_test_split,cross_val_score #划分数据 交叉验证

from sklearn.neighbors import KNeighborsClassifier #一个简单的模型,只有K一个参数,类似K-means

import matplotlib.pyplot as plt

iris = datasets.load_iris() #加载sklearn自带的数据集

X = iris.data #这是数据

y = iris.target #这是每个数据所对应的标签

train_X,test_X,train_y,test_y = train_test_split(X,y,test_size=1/3,random_state=3) #这里划分数据以1/3的来划分 训练集训练结果 测试集测试结果

k_range = range(1,31)

cv_scores = [] #用来放每个模型的结果值

for n in k_range:

knn = KNeighborsClassifier(n) #knn模型,这里一个超参数可以做预测,当多个超参数时需要使用另一种方法GridSearchCV

scores = cross_val_score(knn,train_X,train_y,cv=10,scoring='accuracy') #cv:选择每次测试折数 accuracy:评价指标是准确度,可以省略使用默认值,具体使用参考下面。

cv_scores.append(scores.mean())

plt.plot(k_range,cv_scores)

plt.xlabel('K')

plt.ylabel('Accuracy') #通过图像选择最好的参数

plt.show()

best_knn = KNeighborsClassifier(n_neighbors=3) # 选择最优的K=3传入模型

best_knn.fit(train_X,train_y) #训练模型

print(best_knn.score(test_X,test_y)) #看看评分

也可以根据时间的多少进行不同模型速度的检测:

from sklearn.linear_model import LogisticRegression

from sklearn.ensemble import RandomForestClassifier

from sklearn.ensemble import AdaBoostClassifier

from sklearn.ensemble import GradientBoostingClassifier

from xgboost import XGBClassifier

from lightgbm import LGBMClassifier

from sklearn.model_selection import cross_val_score

import time

clf1 = LogisticRegression()

clf2 = RandomForestClassifier()

clf3 = AdaBoostClassifier()

clf4 = GradientBoostingClassifier()

clf5 = XGBClassifier(eval_metric='mlogloss')#这里不添加里面的参数会产生警告,原因版本问题objective ‘binary:logistic’ was changed from ‘error’ to ‘logloss’.

clf6 = LGBMClassifier()

for clf, label in zip([clf1, clf2, clf3, clf4, clf5, clf6], [

'Logistic Regression', 'Random Forest', 'AdaBoost', 'GBDT', 'XGBoost',

'LightGBM'

]):

start = time.time()

scores = cross_val_score(clf, X_train, y_train, scoring='accuracy', cv=5)

end = time.time()

running_time = end - start

print("Accuracy: %0.8f (+/- %0.2f),耗时%0.2f秒。模型名称[%s]" %

(scores.mean(), scores.std(), running_time, label))

如果同时模型需要多个参数进行优化会用到网格搜索法,具体见链接

模型调参利器 gridSearchCV(网格搜索)

使用 cross_val_score 的系数

【中文标题】使用 cross_val_score 的系数【英文标题】:coefficients using cross_val_score 【发布时间】:2017-03-29 13:25:16 【问题描述】:我使用 cross_val_score 来训练模型。下面是代码。

model = RandomForestRegressor(n_estimators = 200)

meanscores = cross_val_score(model, X, r, cv = 10, scoring = 'neg_mean_absolute_error')

print('\nMean Absolute Error :', meanscores)

这将返回给我 MAE。但是如何通过上面的代码获取模型的feature_importances_。

【问题讨论】:

先看文档。很清楚。有一个函数叫做`feature_importances_` 【参考方案1】:我想this 是您正在寻找的。希望对您有所帮助。

【讨论】:

以上是关于cross_val_score的用法的主要内容,如果未能解决你的问题,请参考以下文章

Windows10 上的 cross_val_score,并行计算错误

使用joblib在sklearn中重用由cross_val_score拟合的模型

手动和 cross_val_score 预测的 Python 不同结果

在 sklearn cross_val_score 上评估多个分数