超详细的的PyTorch安装教程,成功率高,适合初学者,亲测可用。

Posted 微智启工作室

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了超详细的的PyTorch安装教程,成功率高,适合初学者,亲测可用。相关的知识,希望对你有一定的参考价值。

啰嗦几句:网上的教程很多,安装的方法多种多样,操作复杂,成功率还不高。小编在淘宝专门帮助不会安装的小伙伴远程配置环境,这方法都是测试过了,适用大部分人的,完全按照文章来操作,基本都是可以安装成功的。

如果你不想再折腾了,可能联系技术客服3447362049远程安装,打开Todesk(客服会发)远程软件即可,无需准备任何东西。

第一步:Anaconda下载安装

Anaconda,推荐使用和微智启工作室一致的版本,否则可能会出现无法使用下载源或者其他未知的问题。

下载地址:

阿里云盘下载地址(推荐):https://www.aliyundrive.com/s/MrrK3zZ3j2Z

百度网盘下载地址:链接:https://pan.baidu.com/s/1HF2DI0-PgYys1yvV8DfGVQ

提取码:8888

如果上面两个链接都失效了,可以在小强软件商城(zbsc.zjitgzs.cn)进行搜索下载。

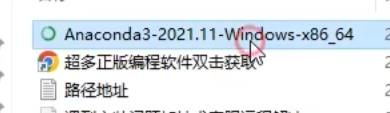

1、下载完后,双击运行解压。然后双击运行Anaconda3安装程序

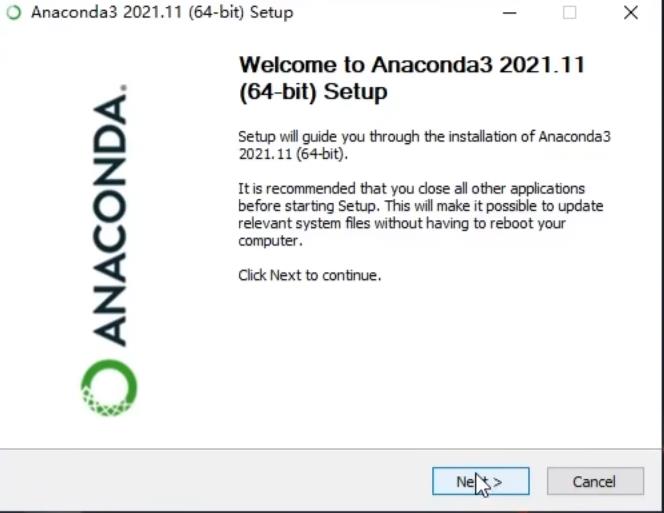

2、Next

3、I Agree

4、勾选Just Me,Next

5、可以修改为其他盘,例如D盘Anaconda文件夹(路径尽量不要含有中文)

6、一定要记得勾选这两个复选框,否则后续需要手动配置PATH环境变量

7、当Next按钮变亮,可点击的时候,说明Anaconda已经安装成功,关闭窗口。

第二步:修改Anaconda下载源

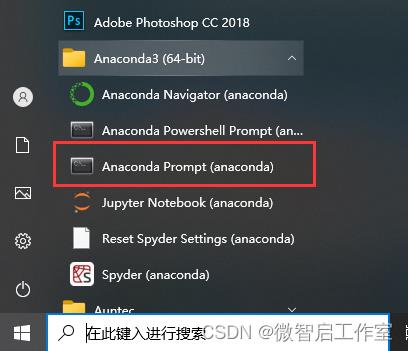

1、在电脑左下角开始菜单,打开Anaconda Prompt (anaconda)命令窗口,

2、输入下方命令,创建.condarc文件

conda config --set show_channel_urls yes

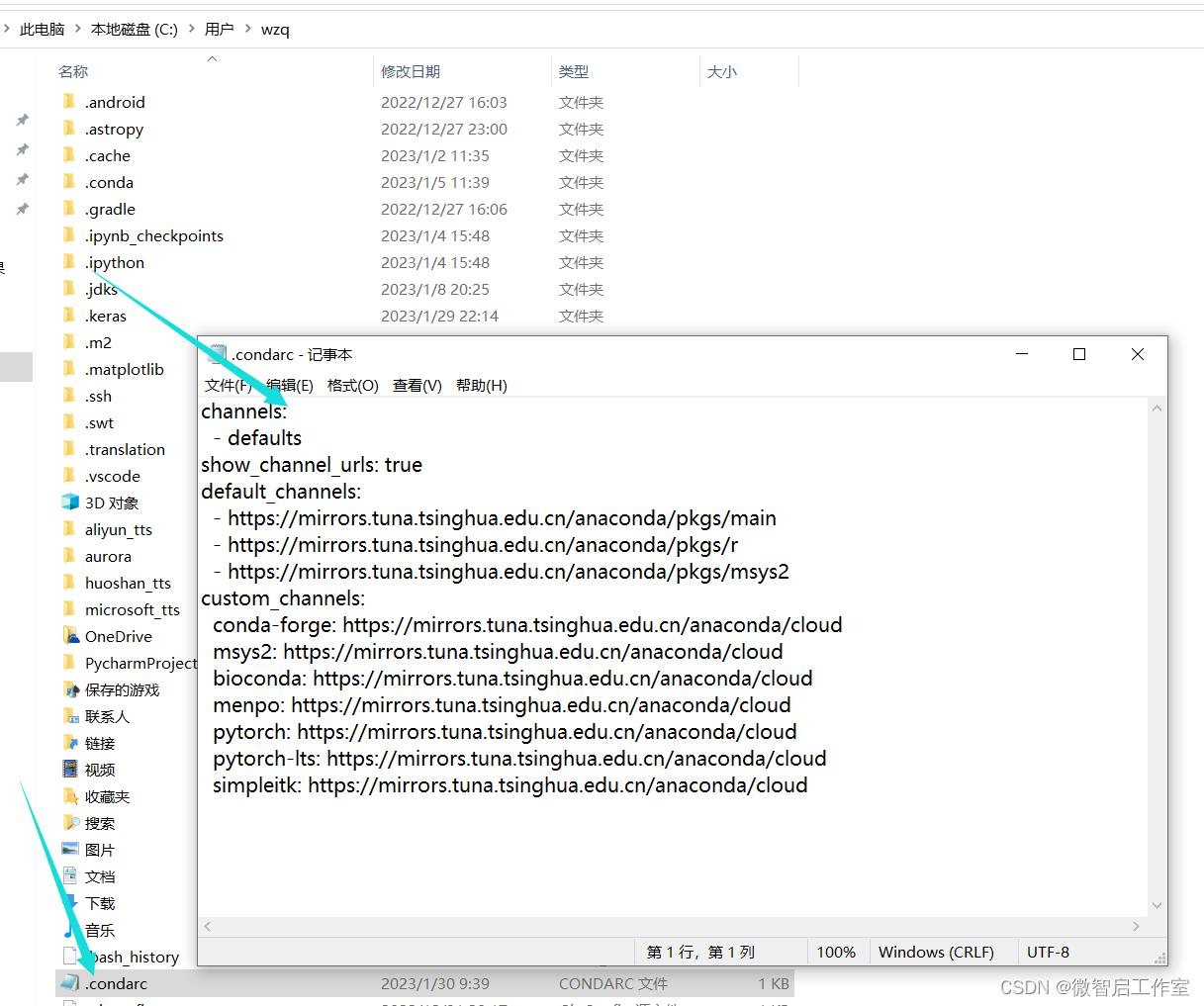

3、输入命令回车后,会在C:\\Users\\wzq(wzq是你的用户名,可以是administrators或者其他的)目录,生成一个.condarc文件

4、右键以记事本方式打开.condarc文件,把里面的内容,全部替换为下方的内容,保存退出。

channels:

- defaults

show_channel_urls: true

default_channels:

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/r

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/msys2

custom_channels:

conda-forge: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

msys2: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

bioconda: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

menpo: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

pytorch: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

pytorch-lts: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

simpleitk: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud此时,anaconda的下载源就已经修改为清华源了

第三步:查看CUDA版本

pytorch安装的CUDA版本,不能高于电脑的CUDA版本,所以在安装前,我们需要知道电脑的版本,有以下几种查看方式。

1.1:在电脑右下角,展开,右键选择控制面板

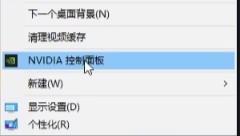

1.2:右键桌面空白处,选择显卡控制面板

1.3:如果以上2种方式,你都没有找到英伟达控制面板,就需要查看电脑是否有独立显卡了。

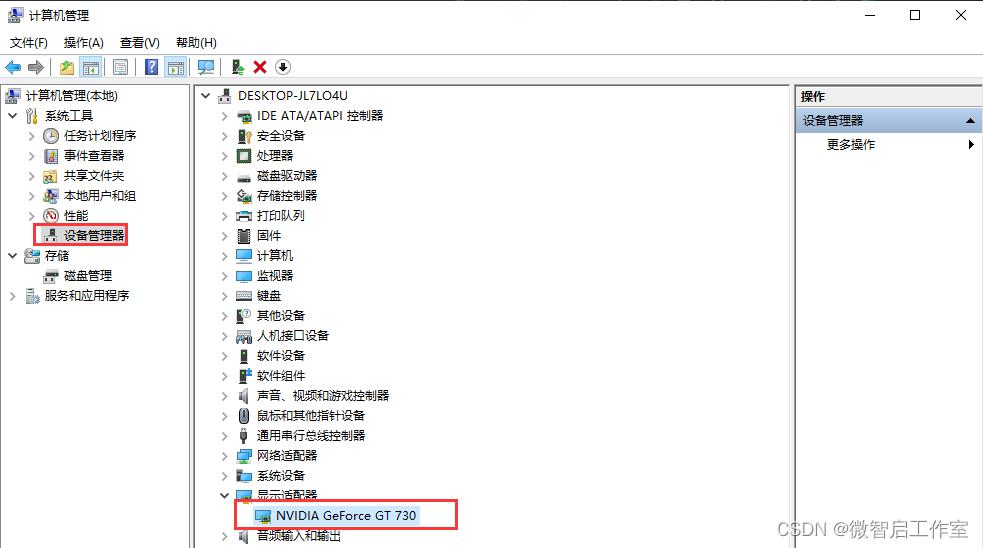

1.3.1右键此电脑图标,选择管理。

1.3.2 查看设备管理器,显示适配器,如果有NVIDIA 字样,则说明是有独立显卡的。

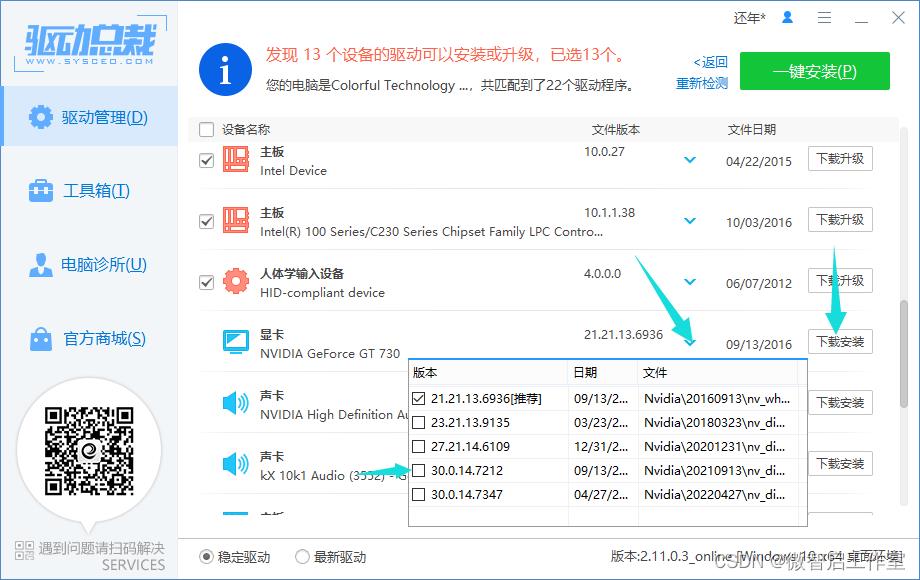

1.3.3此时只需更新显卡驱动即可,更新CUDA驱动,可以下载驱动总裁(驱动总裁在线版本_驱动总裁在线版本下载-系统总裁|系统封装首席执行官),进行驱动更新。

1.3.4下载安装完后,重启电脑,应该就可以显示显卡控制面板了。

打开显卡控制面板后→帮助→组件,就可以查看CUDA了

例如我的是11.4(记住这个版本号)

第四步:创建独立虚拟环境

conda create -n PyTorch python=3.8第五步:获取pytorch安装指令

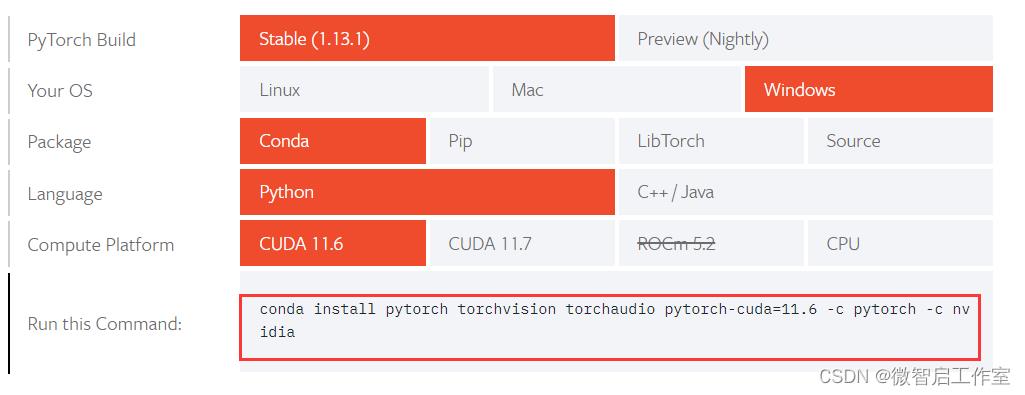

pytorch官网:Start Locally | PyTorch

复制下方红框部分的安装指令到Anaconda进行安装(后续还会继续更新)

我的CUDA版本是11.4,上方pytorch官网中最低是11.6,显然都不符合安装需求,那么我就需要在历史版本中选择比较低的安装指令。

历史版本:Previous PyTorch Versions | PyTorch

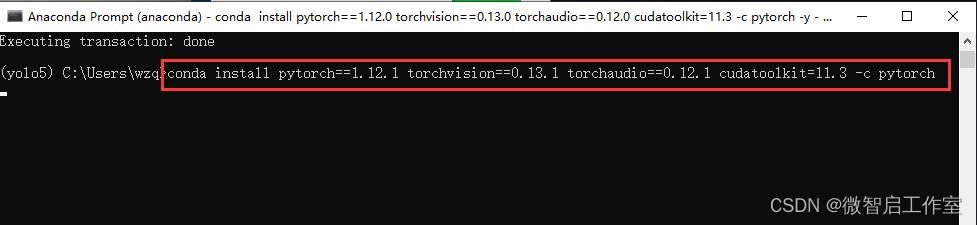

例如选择11.3版本(不高于我电脑的11.4,符合),复制指令到anaconda命令窗口进行安装

然后输入y,一直下一步(不用再单独下载cuda了)

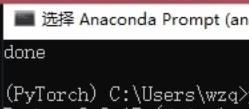

当出现这个界面(done字样)的时候,证明我们已经下载完了。

第六步:验证是否安装成功

依次输入

python

import torch

print(torch.cuda.is_available())

如果测试返回True,恭喜你,安装成功,给小编来个赞吧!

如果测试返回FALSE,非常遗憾,安装并不成功,原因可能是python版本问题、显卡驱动版本问题、pytorch不兼容等问题,需要逐一尝试排除的。

如果你不想再折腾了,可能联系技术客服3447362049远程安装,打开Todesk(客服会发)远程软件即可,无需准备任何东西。

超详细Pytorch 入门教程

1 认识Pytorch

什么是Pytorch?

- Pytorch是一个基于Numpy的科学计算包, 向它的使用者提供了两大功能.

- 作为Numpy的替代者, 向用户提供使用GPU强大功能的能力.

- 做为一款深度学习的平台, 向用户提供最大的灵活性和速度.

2 Pytorch的基本元素操作

- Tensors张量: 张量的概念类似于Numpy中的ndarray数据结构, 最大的区别在于Tensor可以利用GPU的加速功能.

- 我们使用Pytorch的时候, 常规步骤是先将torch引用进来, 如下所示:

from __future__ import print_function

import torch

-

创建矩阵的操作

-

创建一个没有初始化的矩阵:

x = torch.empty(5, 3)

print(x)

输出结果:

tensor([[2.4835e+27, 2.5428e+30, 1.0877e-19],

[1.5163e+23, 2.2012e+12, 3.7899e+22],

[5.2480e+05, 1.0175e+31, 9.7056e+24],

[1.6283e+32, 3.7913e+22, 3.9653e+28],

[1.0876e-19, 6.2027e+26, 2.3685e+21]])

- 创建一个有初始化的矩阵:

x = torch.rand(5, 3)

print(x)

输出结果:

tensor([[0.1368, 0.8070, 0.4567],

[0.4369, 0.8278, 0.5552],

[0.6848, 0.4473, 0.1031],

[0.5308, 0.9194, 0.2761],

[0.0484, 0.9941, 0.2227]])

对比有无初始化的矩阵: 当声明一个未初始化的矩阵时, 它本身不包含任何确切的值. 当创建一个未初始化的矩阵时, 分配给矩阵的内存中有什么数值就赋值给了这个矩阵, 本质上是毫无意义的数据.

- 创建一个全零矩阵并可指定数据元素的类型为long

x = torch.zeros(5, 3, dtype=torch.long)

print(x)

输出结果:

tensor([[0, 0, 0],

[0, 0, 0],

[0, 0, 0],

[0, 0, 0],

[0, 0, 0]])

- 直接通过数据创建张量

x = torch.tensor([2.5, 3.5])

print(x)

输出结果:

tensor([2.5000, 3.3000])

- 通过已有的一个张量创建相同尺寸的新张量

# 利用news_methods方法得到一个张量

x = x.new_ones(5, 3, dtype=torch.double)

print(x)

# 利用randn_like方法得到相同张量尺寸的一个新张量, 并且采用随机初始化来对其赋值

y = torch.randn_like(x, dtype=torch.float)

print(y)

输出结果:

tensor([[1., 1., 1.],

[1., 1., 1.],

[1., 1., 1.],

[1., 1., 1.],

[1., 1., 1.]], dtype=torch.float64)

tensor([[-0.1497, -0.5832, -0.3805],

[ 0.9001, 2.0637, 1.3299],

[-0.8813, -0.6579, -0.9135],

[-0.1374, 0.1000, -0.9343],

[-1.1278, -0.9140, -1.5910]])

- 得到张量的尺寸:

print(x.size())

输出结果:

torch.Size([5, 3])

注意: torch.Size函数本质上返回的是一个tuple, 因此它支持一切元组的操作.

3 Pytorch的基本运算操作

- 加法操作:

y = torch.rand(5, 3)

print(x + y)

输出结果:

tensor([[ 1.6978, -1.6979, 0.3093],

[ 0.4953, 0.3954, 0.0595],

[-0.9540, 0.3353, 0.1251],

[ 0.6883, 0.9775, 1.1764],

[ 2.6784, 0.1209, 1.5542]])

第二种加法方式:

print(torch.add(x, y))

输出结果:

tensor([[ 1.6978, -1.6979, 0.3093],

[ 0.4953, 0.3954, 0.0595],

[-0.9540, 0.3353, 0.1251],

[ 0.6883, 0.9775, 1.1764],

[ 2.6784, 0.1209, 1.5542]])

第三种加法方式:

# 提前设定一个空的张量

result = torch.empty(5, 3)

# 将空的张量作为加法的结果存储张量

torch.add(x, y, out=result)

print(result)

输出结果:

tensor([[ 1.6978, -1.6979, 0.3093],

[ 0.4953, 0.3954, 0.0595],

[-0.9540, 0.3353, 0.1251],

[ 0.6883, 0.9775, 1.1764],

[ 2.6784, 0.1209, 1.5542]])

第四种加法方式: in-place (原地置换)

y.add_(x)

print(y)

输出结果:

tensor([[ 1.6978, -1.6979, 0.3093],

[ 0.4953, 0.3954, 0.0595],

[-0.9540, 0.3353, 0.1251],

[ 0.6883, 0.9775, 1.1764],

[ 2.6784, 0.1209, 1.5542]])

注意:

- 所有in-place的操作函数都有一个下划线的后缀.

- 比如x.copy_(y), x.add_(y), 都会直接改变x的值.

用类似于Numpy的方式对张量进行操作:

print(x[:, 1])

输出结果:

tensor([-2.0902, -0.4489, -0.1441, 0.8035, -0.8341])

改变张量的形状: torch.view()

x = torch.randn(4, 4)

# tensor.view()操作需要保证数据元素的总数量不变

y = x.view(16)

# -1代表自动匹配个数

z = x.view(-1, 8)

print(x.size(), y.size(), z.size())

输出结果:

torch.Size([4, 4]) torch.Size([16]) torch.Size([2, 8])

如果张量中只有一个元素, 可以用.item()将值取出, 作为一个python number

x = torch.randn(1)

print(x)

print(x.item())

输出结果:

tensor([-0.3531])

-0.3530771732330322

4 关于Torch Tensor和Numpy array之间的相互转换

Torch Tensor和Numpy array共享底层的内存空间, 因此改变其中一个的值, 另一个也会随之被改变.

a = torch.ones(5)

print(a)

输出结果:

tensor([1., 1., 1., 1., 1.])

- 将Torch Tensor转换为Numpy array

b = a.numpy()

print(b)

输出结果:

[1. 1. 1. 1. 1.]

对其中一个进行加法操作, 另一个也随之被改变:

a.add_(1)

print(a)

print(b)

输出结果:

tensor([2., 2., 2., 2., 2.])

[2. 2. 2. 2. 2.]

- 将Numpy array转换为Torch Tensor:

import numpy as np

a = np.ones(5)

b = torch.from_numpy(a)

np.add(a, 1, out=a)

print(a)

print(b)

输出结果:

[2. 2. 2. 2. 2.]

tensor([2., 2., 2., 2., 2.], dtype=torch.float64)

- 注意:

所有在CPU上的Tensors, 除了CharTensor, 都可以转换为Numpy array并可以反向转换.

关于Cuda Tensor: Tensors可以用.to()方法来将其移动到任意设备上.

# 如果服务器上已经安装了GPU和CUDA

if torch.cuda.is_available():

# 定义一个设备对象, 这里指定成CUDA, 即使用GPU

device = torch.device("cuda")

# 直接在GPU上创建一个Tensor

y = torch.ones_like(x, device=device)

# 将在CPU上面的x张量移动到GPU上面

x = x.to(device)

# x和y都在GPU上面, 才能支持加法运算

z = x + y

# 此处的张量z在GPU上面

print(z)

# 也可以将z转移到CPU上面, 并同时指定张量元素的数据类型

print(z.to("cpu", torch.double))

输出结果:

tensor([0.6469], device='cuda:0')

tensor([0.6469], dtype=torch.float64)

5 总结

-

学习了什么是Pytorch.

- Pytorch是一个基于Numpy的科学计算包, 作为Numpy的替代者, 向用户提供使用GPU强大功能的能力.

- 做为一款深度学习的平台, 向用户提供最大的灵活性和速度.

-

学习了Pytorch的基本元素操作.

- 矩阵的初始化:

- torch.empty()

- torch.rand(n, m)

- torch.zeros(n, m, dtype=torch.long)

- 其他若干操作:

- x.new_ones(n, m, dtype=torch.double)

- torch.randn_like(x, dtype=torch.float)

- x.size()

- 矩阵的初始化:

-

学习了Pytorch的基本运算操作.

- 加法操作:

- x + y

- torch.add(x, y)

- torch.add(x, y, out=result)

- y.add_(x)

- 其他若干操作:

- x.view()

- x.item()

- 加法操作:

-

学习了Torch Tensor和Numpy Array之间的相互转换.

- 将Torch Tensor转换为Numpy Array:

- b = a.numpy()

- 将Numpy Array转换为Torch Tensor:

- b = torch.from_numpy(a)

- 注意: 所有才CPU上的Tensor, 除了CharTensor, 都可以转换为Numpy Array并可以反向转换.

- 将Torch Tensor转换为Numpy Array:

-

学习了任意的Tensors可以用.to()方法来将其移动到任意设备上.

- x = x.to(device)

加油!

感谢!

努力!

以上是关于超详细的的PyTorch安装教程,成功率高,适合初学者,亲测可用。的主要内容,如果未能解决你的问题,请参考以下文章