多分类逻辑回归(Multinomial Logistic Regression)

Posted 搜索与推荐Wiki

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了多分类逻辑回归(Multinomial Logistic Regression)相关的知识,希望对你有一定的参考价值。

前言

其中二分类是最常见且使用最多的分类场景,解决二分类的算法有很多,比如:

简介

在统计学里,多类别逻辑回归是一个将逻辑回归一般化成多类别问题得到的分类方法。用更加专业的话来说,它就是一个用来预测一个具有类别分布的因变量不同可能结果的概率的模型。

另外,多类别逻辑回归也有很多其它的名字,包括polytomous LR,multiclass LR,softmax regression,multinomial logit,maximum entropy classifier,conditional maximum entropy model。

在多类别逻辑回归中,因变量是根据一系列自变量(就是我们所说的特征、观测变量)来预测得到的。具体来说,就是通过将自变量和相应参数进行线性组合之后,使用某种概率模型来计算预测因变量中得到某个结果的概率,而自变量对应的参数是通过训练数据计算得到的,有时我们将这些参数成为回归系数。

模型分析

1、线性分类器

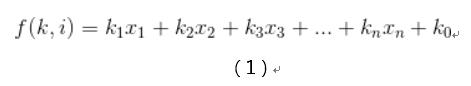

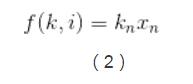

多分类逻辑回归使用的是跟线性回归一致的线性预测函数,其基本表达式如下:

其中i=[1,n]这里的k是一个回归系数,它表示的是第n个观测变量/特征对地n个结果的影响有多大。这里将1看做x0,我们可以得到上述公式的向量化形式:

这里kn是一个回归系数向量,表示的是观测向量xi表示的观测数据对结果k的影响度,或者叫重要性。

2、逻辑回归

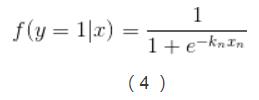

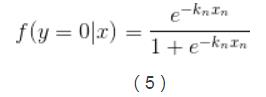

多分类逻辑回归是基于逻辑回归(Logistic Regression)来做的,逻辑回归的基本表示如下:

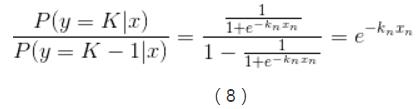

3、k-1个独立二元逻辑回归到多分类逻辑回归的扩展

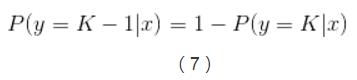

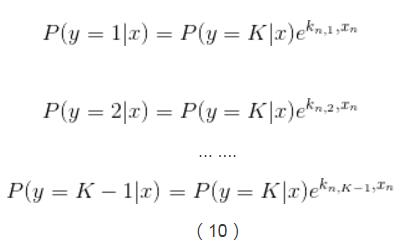

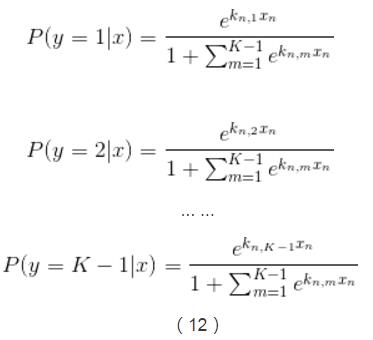

实现多类别逻辑回归模型最简单的方法是,对于所有K个可能的分类结果,我们运行K−1个独立二元逻辑回归模型,在运行过程中把其中一个类别看成是主类别,然后将其它K−1个类别和我们所选择的主类别分别进行回归。通过这样的方式,如果选择结果K作为主类别的话,我们可以得到以下公式。

在公式(6)中已经引入了所有可能的回归系数集合,对公式(6)两边进行指数化处理,能够得到以下公式:

这样我们就能计算出所有给定未预测样本情况下某个结果的概率,如下:

回归参数的估计

上面篇幅所涉及到的每一个权重向量kn中的未知系数我们可以通过最大后验估计(MAP)来计算,同时也可以使用其它方法来计算,例如一些基于梯度的算法。

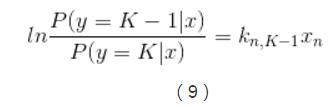

二元逻辑回归对数模型到多分类逻辑回归的扩展

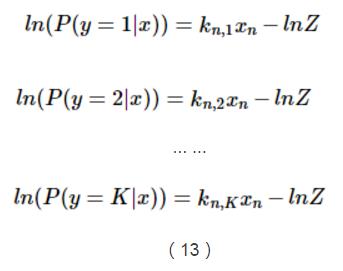

在上文中提到了由K-1个独立二元回归到多分类逻辑回归的扩展,这里介绍另外一种多分类逻辑回归的扩展——使用线性预测器和额外的归一化因子(一个配分函数的对数形式)来对某个结果的概率的对数进行建模。

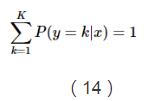

这里用一个额外项-ln(Z)来确保所有概率能够形成一个概率分布,从而使得这些概率的和等于1。

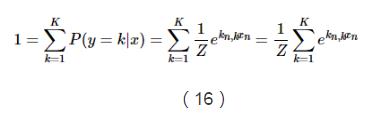

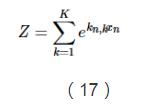

由于上面说到,所有概率之和等于1,因此我们可以得到Z的推导公式:

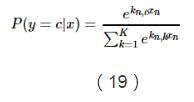

这个函数能够将x1,...,xn之间的差别放大,当存在一个xk比所有值中的最大值要小很多的话,那么它对应的softMax函数值就会区域0。相反,当xk是最大值的时候,除非第二大的值跟它很接近,否则的话softMax会趋于1。所以softmax函数可以构造出一个像是平滑函数一样的加权平均函数。

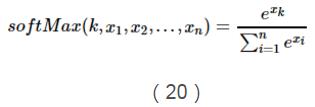

所以,我们可以把上面的概率公式写成如下softMax函数的形式:

至此,多分类的逻辑回归形式以及介绍完了,后续会进行最大似然函数的学习,敬请期待!

扫一扫 关注微信公众号!号主 专注于搜索和推荐系统,尝试使用算法去更好的服务于用户,包括但不局限于机器学习,深度学习,强化学习,自然语言理解,知识图谱,还不定时分享技术,资料,思考等文章!

【技术服务】,详情点击查看:https://mp.weixin.qq.com/s/PtX9ukKRBmazAWARprGIAg

以上是关于多分类逻辑回归(Multinomial Logistic Regression)的主要内容,如果未能解决你的问题,请参考以下文章