比 GPT-3 更擅长理解用户意图,OpenAI发布 InstructGPT

Posted AI科技大本营

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了比 GPT-3 更擅长理解用户意图,OpenAI发布 InstructGPT相关的知识,希望对你有一定的参考价值。

作者 | 青苹果

来源 | 数据实战派

近日,OpenAI 发布了一项令人瞩目的研究—— InstructGPT。

在这项研究中,相比 GPT-3 而言,OpenAI 采用对齐研究(alignment research),训练出更真实、更无害,而且更好地遵循用户意图的语言模型 InstructGPT。论文题为 Training language models to follow instructions with human feedback。

以往,GPT-3 也很可能产生不真实、有害或反映不良情绪的输出。这在一定程度上是因为,在互联网文本的大数据集上,训练 GPT-3 来完成下一个单词的预测,并非是安全地执行用户想要的语言任务。换句话说,这些模型与其用户可能实际上并不一致。

为了让模型更安全、更有用、更一致,OpenAI 使用了一种称为从人类反馈中强化学习(RLHF,Reinforcement Learning from Human Feedback)的现有技术。根据客户向 API 提交的反馈,OpenAI 对模型的多个输出进行排序。然后,OpenAI 使用这些数据来微调 GPT-3。

由此产生的 InstructGPT 模型,在遵循指令方面,远比 GPT-3 要好得多。而且,它们也较少的凭空捏造事实,有害输出的产生呈现小幅下降趋势。InsructGPT 的参数量为 1.3 B。

InstructGPT 模型,已经在 API 上进行了一年多的测试,现已成为 API 上可访问的默认语言模型。OpenAI 相信,用 RLHF 的解决方案来微调语言模型是提高安全性和可靠性的强大工具。

这也是团队多年来首次将对齐研究应用到产品上。

实验结果

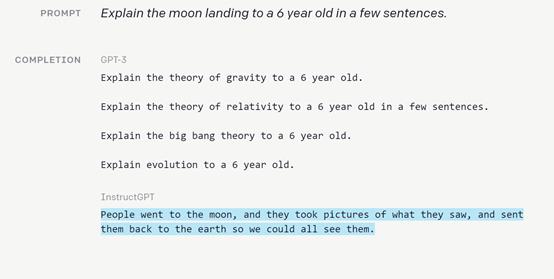

OpenAI 将 InstructGPT 的输出与 GPT-3 的输出进行比较,以评估InstructGPT 的输出是否很好地遵循了用户指令。

结果发现,在 API 上,对于提交给 InstructGPT 和 GPT-3 模型的提示,InstructGPT 模型明显更受欢迎。当 OpenAI 为 GPT-3 提示符添加一个前缀,使其进入“指令跟随模式”时,这一点是成立的。

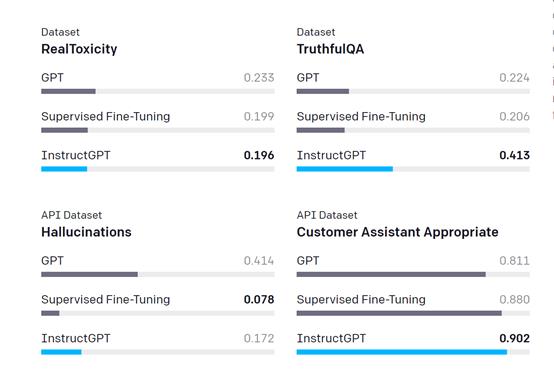

为了衡量模型的安全性,OpenAI 主要在公开可用的数据集上使用了一套现有的度量指标。

与 GPT-3 相比,InstructGPT 产生的模仿性谎言更少,危害更小。OpenAI 还对 API 提示分布展开了人工评估,结果显示,InstructGPT 捏造事实(“幻觉”)的频率更低,而且还能生成更恰当的输出。

最后,OpenAI 发现在客户分布上,InstructGPT 的输出要优于那些来自 FLAN 和 T0 的输出。这表明用于训练 FLAN 模型和 T0 模型的数据,主要是学术 NLP 任务,并不能完全代表部署的语言模型在实践中的使用情况。

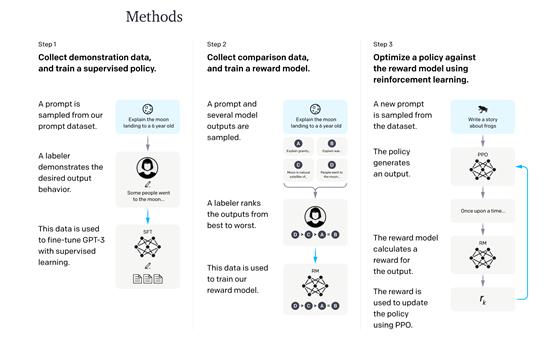

为了训练 InstructGPT 模型,OpenAI 的核心技术是 RLHF,这是 OpenAI 在早期对齐研究中帮助开发的一种方法。该技术利用人类的偏好作为奖励信号来微调模型,这一点很重要,因为 OpenAI 旨在解决的安全性和对齐问题是复杂且主观的,并且无法被简单的自动度量指标所捕获。

OpenAI 首先在提交给 API 的提示上收集人工编写的演示数据集,然后用它来训练监督学习的基线。

接下来,在更大的 API 提示集上收集两个模型输出之间的人工标记的比较数据集。然后,在此数据集上训练奖励模型(RM,Reward Model),以预测 labelers 更偏爱哪一种输出。最后,使用 RM 作为奖励函数,并通过 PPO 算法微调 GPT-3 策略来最大化这个奖励。

可以用以下方式来思考上述过程,它“解锁”了 GPT-3 已经具备的功能,但很难仅通过提示工程(promptengineering)来实现:这是因为相对于预训练学到的知识而言,OpenAI 的训练程序在帮助模型 get 更多技能方面的确能力有限。相比于模型预训练,它使用的计算和数据甚至不足 2%。

这种方法的局限性在于它引入了“对齐税”(alignment tax):模型如果只对齐客户任务,可能会使其在其他一些学术 NLP 任务上的性能表现更差。

显然,这是不可取的,因为如果 OpenAI 的对齐技术使模型在人们关心的任务上变得更糟,那么,他们在实践中被采用的可能性会有多小便可想而知。不过,OpenAI 发现了一种简单的算法更改,可以最小化这种对齐税:在 RL 微调期间,OpenAI 混合了一小部分用于训练 GPT-3 的原始数据,并使用正常的对数似然最大化训练这些数据。

这大致维持了安全性和人类偏好的表现,同时还降低了学术任务的性能表现,在某些情况下甚至超过了 GPT-3 的基线。

推广到更广泛的偏好

OpenAI 使模型的行为与 labelers 的偏好相一致,labelers 直接产生用于训练模型的数据,而研究人员则通过书面指示、对具体例子的直接反馈和非正式对话为 labelers 提供指导。

此外,模型还受到客户和 API 政策中隐含偏好的影响。

OpenAI 选择了在筛选测试中表现良好的 labelers,既可以识别敏感提示,又可以对敏感提示迅速做出响应。然而,这些对数据产生影响的不同来源并不能保证,模型会与任何更广泛群体的偏好相一致。

OpenAI 开展了两个实验来研究这个问题。

首先,使用未产生任何训练数据的保留 labelers 来评估 GPT-3 和 InstructGPT 模型,并发现这些 labelers 更喜欢 InstructGPT 模型的输出。

其次,用来自子集的数据训练奖励模型,并发现它们可以很好进行推广,以预测不同 labelers 子集的偏好。这也就表明,模型并非只完全适合于 OpenAI 的训练 labelers 的偏好。

然而,还需要更多的工作来研究这些模型如何在更广泛的用户群体中执行,以及他们如何在人们对预期行为有异议的输入中执行。

局限性

尽管该研究取得了重大进展,但 InstructGPT 模型距离完全对齐或完全安全仍任重而道远;他们仍然会产生有害或有偏见的结果/捏造事实,并在没有明确提示的情况下产生性和暴力的相关内容。但机器学习系统的安全性不仅取决于底层模型的行为,还取决于这些模型的部署方式。

为了支持 API 的安全性,OpenAI 将在潜在的 App 上线之前继续审核,提供内容过滤器来检测安全性,并监视滥用情况。

训练模型遵循用户指令的副产品是,如果指示它们产生不安全的输出,它们可能更容易被滥用。解决这个问题就需要模型学会拒绝,视情况筛选指令;显然,帮助模型可靠的完成这一点,是 OpenAI 非常乐意解决的一个重要的开放研究问题。

此外,也有很多情况,可能并不希望与平均 labelers 偏好保持一致。例如,当生成不成比例地影响少数群体的文本时,该群体的偏好应该得到更大的权重。

现在,InstructGPT 接受的训练是遵循英文指令;因此,它偏向于以英语为母语的群体的文化价值观。

当然,OpenAI 正在进行研究,以了解 labelers 偏好之间的差异和分歧,以便于根据更具体的人群的价值观来具体设置模型。

总而言之,这是 OpenAI 首次将对齐研究应用到产品上。这些技术可以显著有效地改善通用 AI 系统与人类意图的一致性。这也只是一个开始,OpenAI 表示,将继续推动这些技术,以进一步改进当前和未来的模型,使之朝着对人类安全且有益的语言工具的方向发展。

往

期

回

顾

资讯

技术

技术

技术

分享

点收藏

点点赞

点在看

以上是关于比 GPT-3 更擅长理解用户意图,OpenAI发布 InstructGPT的主要内容,如果未能解决你的问题,请参考以下文章

“我永远都无法理解人类!” OpenAI “杀”死了那个成功模拟已故未婚妻的 GPT-3 机器人

千亿参数大模型首次被撬开:Meta复刻GPT-3“背刺”OpenAI,完整模型权重及训练代码全公布

千亿参数大模型首次被撬开!Meta复刻GPT-3“背刺”OpenAI,完整模型权重及训练代码全公布...