实时视频动作检测(action detection)

Posted tf_q568897492

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了实时视频动作检测(action detection)相关的知识,希望对你有一定的参考价值。

行为检测( action detection) 旨在从长视频中定位出人们感兴趣行为在时间甚至是空间上的具体位置,是最为重要的视频理解任务之一。该技术可以广泛应用于视频监控、视频搜索与检索、自动驾驶、人机交互、视频内容推荐等。

行为检测任务可以分为时序行为检测( temporal action detection) 和时空行为检测( spatio-temporal action detection) 两类。前者只需要得到行为的类别以及在视频中发生的开始帧和结束帧,而后者还需要定位出与行为相关的目标( 人、物体等) 的空间坐标。

slowfast论文简介:本论文提出了用于视频识别的SlowFast网络。该模型包含:1)Slow路径,以低帧率运行,用于捕捉空间语义信息;2)Fast路径,以高帧率运行,以较好的时间分辨率捕捉运动。可以通过减少Fast路径的通道容量,使其变得非常轻,同时学习有用的时间信息用于视频识别。该模型在视频动作分类和检测方面性能强大,而且SlowFast概念带来的重大改进是本论文的重要贡献。在没有任何预训练的情况下,本论文在Kinetics数据集上的准确率达到了79.0%,远远超过之前的最佳水平。在AVA动作检测数据集上,我们也达到了28.3 Map,是当前最佳水平。

ava数据集简介:本文介绍了一种具有时空定位(Spatio-temporally Localized)的原子视觉动作(AVA)视频数据集。这里的原子视觉动作即为谷歌推出的一个新的视频数据库,名称为“原子视觉行为(AVA)。AVA数据集在430个15分钟的视频剪辑中密集地注释了80个动作,动作在空间和时间上进行了定位,标注了1.58万个动作标签,每个人都有多个动作标签出现。

数据集的关键特征是:

(1)定义原子视觉动作,而不是复合动作;

(2)精确的时空标注,每个人可能有多个标注;

(3)在15分钟的视频剪辑中对这些行为进行详尽的注释;

(4)跨连续段的时间连接人;

(5)利用电影收集各种动作表现形式

本程序可以在免费云gpu上直接调试运行注册地址:

https://gpushare.com/auth/register?user=18*****1785&fromId=c4100216220&source=link

复制链接进入网站注册,如果是手机浏览器要进入桌面网页,网页右下角有个注册礼包按钮点一下,第一项绑定微信,完成后领取20元卷。然后点建立实例,点按量付费,选择能使用代金券的主机,底下选择pytorch pytorch1.9 Python3.8 cud11.1,创建实例后 随便上传一个jupyter文件,运行后还有额外奖励。

本源码的具体注册运行及配置按照zip里面的install.doc的图文教程操作,也可以点这里下载install.doc

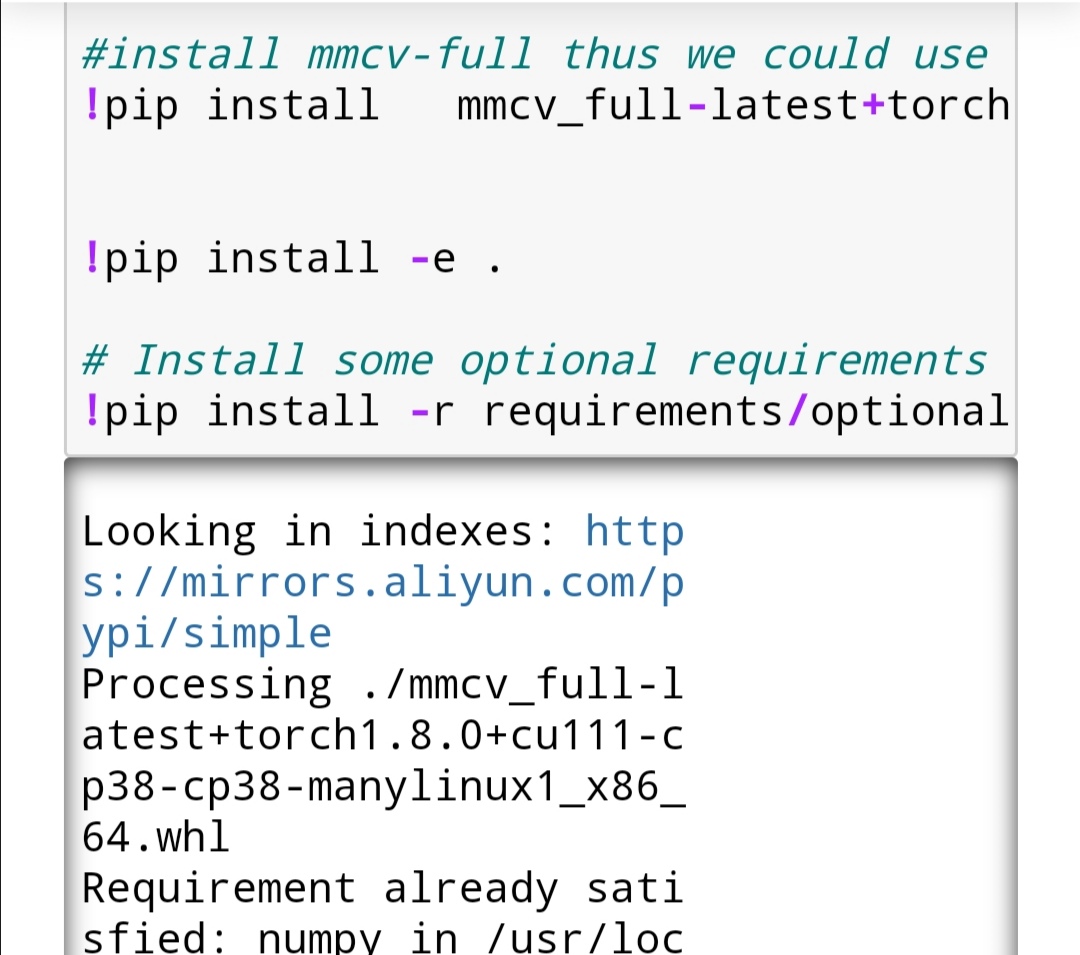

安装环境

具体按照ipynb,从上往下运行

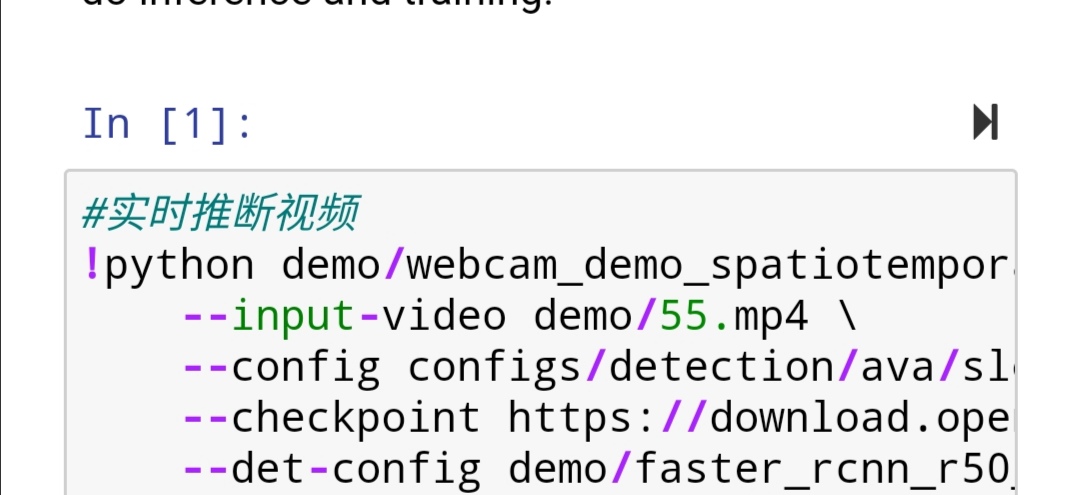

最后一格是视频的时空动作检测推断

下载后有问题可以加q 568897492

以上是关于实时视频动作检测(action detection)的主要内容,如果未能解决你的问题,请参考以下文章

论文阅读 End-to-End Semi-Supervised Learning for Video Action Detection

论文阅读 End-to-End Semi-Supervised Learning for Video Action Detection

论文阅读 End-to-End Semi-Supervised Learning for Video Action Detection