论文笔记UnifiedQA:新SOTA,生成模型一统问答任务

Posted iLuz

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文笔记UnifiedQA:新SOTA,生成模型一统问答任务相关的知识,希望对你有一定的参考价值。

引言

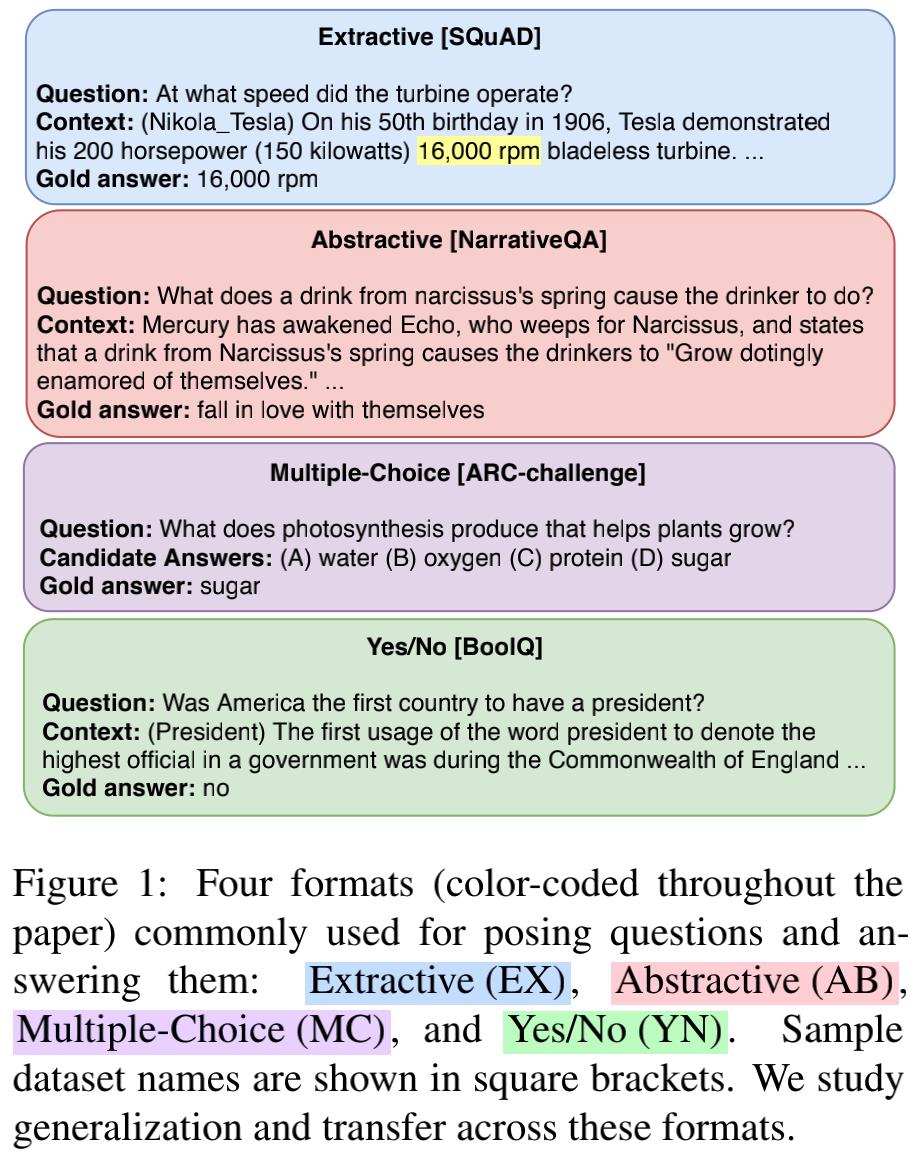

问答任务有多种形式,常见的有抽取式问答(EX)、摘要式问答(AB)、多选题式问答(MC)、判断式问答(YN)。

一般的解决方案是针对不同形式的问答任务设计不同的模型。例如,抽取式问答、多选题式问答、判断式问答可以转化为分类任务,摘要式问答可以转换为生成任务。

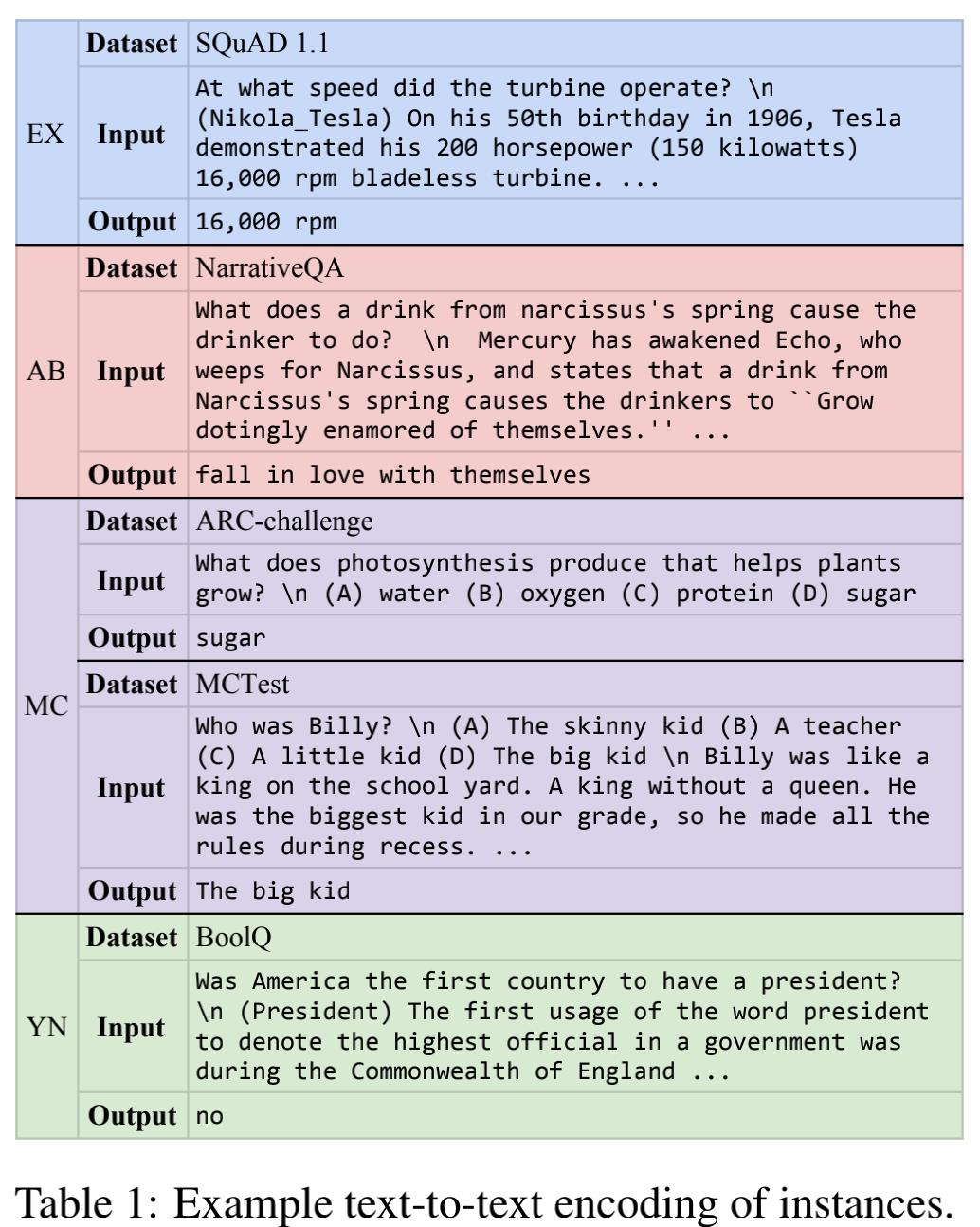

尽管任务形式不同,但模型所需的语义理解和推理能力是共通的,或许不需要 format-specialized models。基于这种直觉,Allen 研究所联合华盛顿大学于2020年11月在 EMNLP 上提出首个可以处理多种形式的预训练问答模型 UnifiedQA,成为多个问答任务的新 SOTA。所有 NLP 任务都能转换为 seq2seq 任务。基于同样的思想,UnifiedQA 是一个 text-to-text 的预训练问答模型,编码器接收用“\\n”拼接起来的问题,解码器生成回答。Table 1 展示了四个问答任务的样例。

论文名称:UNIFIEDQA: Crossing Format Boundaries with a Single QA System

论文链接:https://aclanthology.org/2020.findings-emnlp.171

论文代码:https://github.com/allenai/unifiedqa

主要贡献:

- 构建了与形式无关的预训练问答系统,效果可以媲美甚至超过 format-specialized models,证明模型的推理能力是共通的,不受形式限制;

- 对没见过的数据集(zero-shot)泛化能力强;

- 微调 UnifiedQA 在十个问答数据集上可以达到新 SOTA。

模型介绍

T5 是一个前缀prompt加持下的多任务 transfomer 预训练模型,对于不同的任务会在输入序列的最前面加上任务的描述;BART 是 BERT 和 GPT 的结合。两个模型都是 text-to-text 模型,非常适用于统一不同的形式。因此,UnifiedQA 用 11B 参数的 T5 和 BARTlarge 作为起始点进行预训练。

1. 输入格式

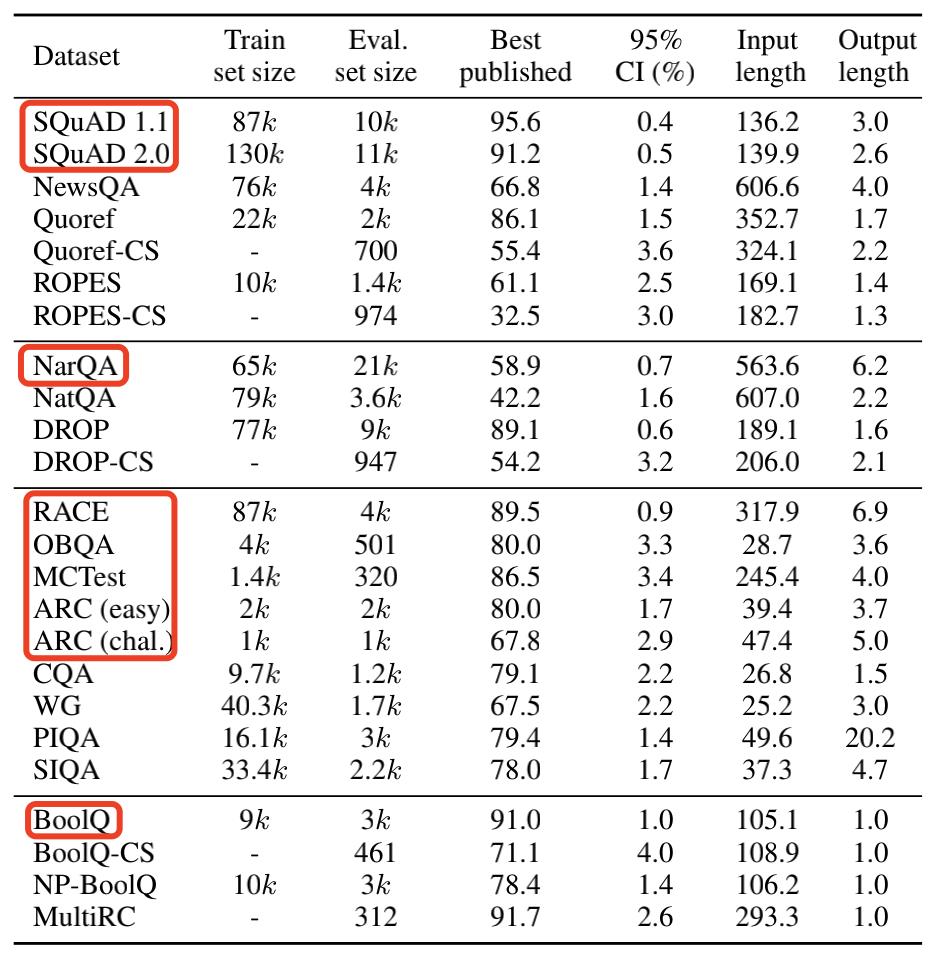

作者收集了四个类别的 20 个英文问答数据集,选取其中 8 个数据集作为训练集,编码过的输入在每个 batch 中均分分布。

训练集至少包括问题和回答,还有的包括回答问题所需的上下文 context 或选项。编码过的输入是问题放在最前面,其次是选项,最后放上下文,三个部分用 “\\n” 连接,如 Table 1 所示。

2. 实验结果

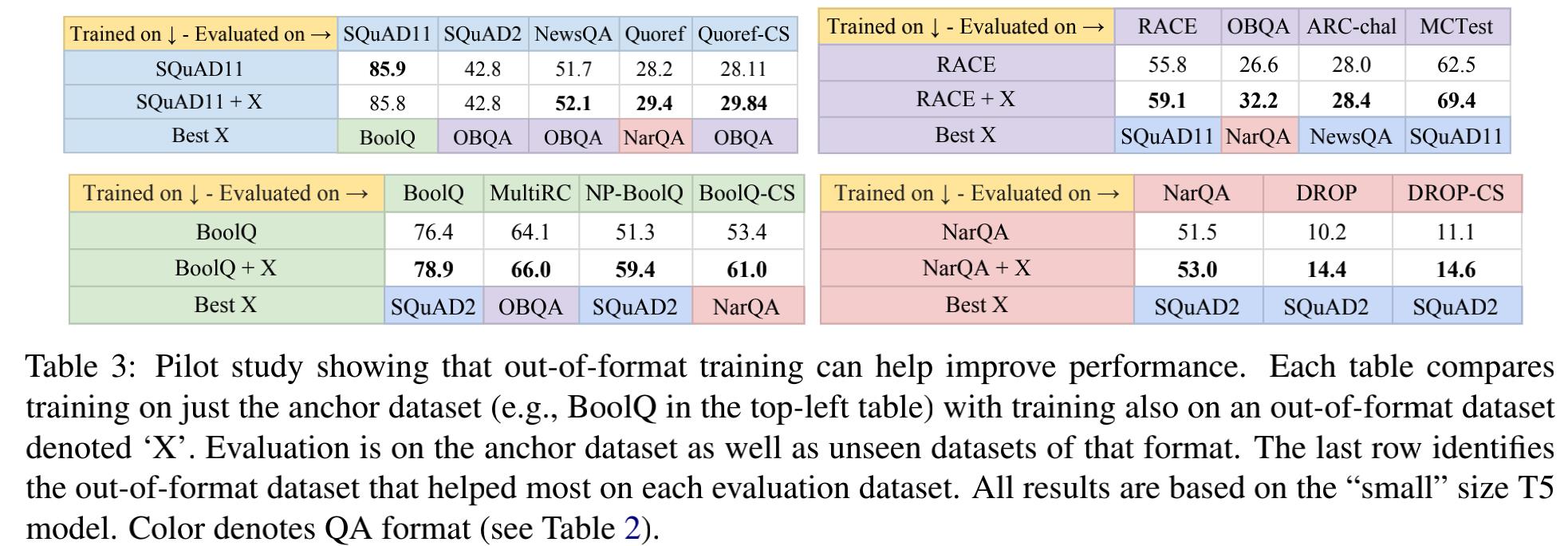

- 作者证明了多任务是有效的:对比单类型任务的性能和多类型任务的性能,发现抽取式问答和摘要式问答相辅相成,单类别任务在训练集上加上其他类别的数据集就能带来增益。

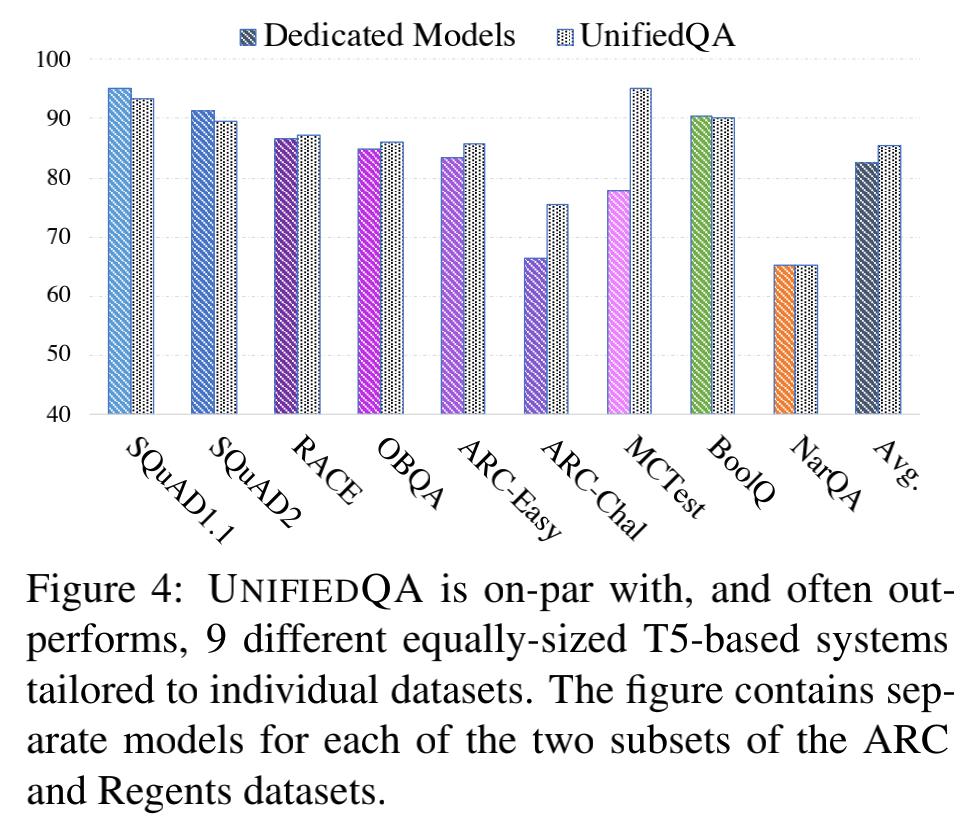

- UnifiedQA 可以媲美甚至超过单独训练的模型:在 8 个数据集上分别微调 T5 进行对比

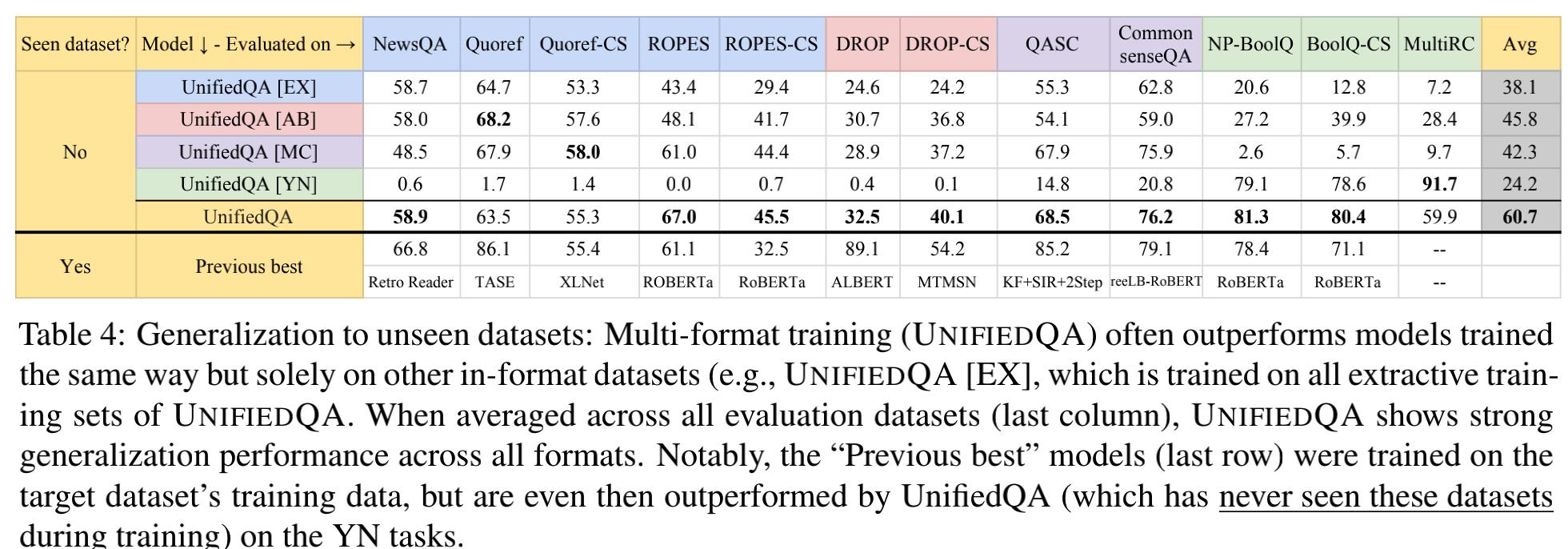

- UnifiedQA 对于没见过的数据集泛化性好:作者对比了在单类型任务上训练的模型和多类型任务模型的泛化性,发现还是多类型任务的泛化性好。笔者认为实验结论也证明了形式不一的任务提高了模型的推理能力,所谓“见多识广”,比专攻单类型的模型表现要好。

- UnifiedQA 微调后效果更上一层楼:作者对比了 UnifiedQA、T5、BART各自在没见过的数据集上微调,发现基于 T5 的 UnifiedQA 表现最好,同时也刷新了SOTA

- 最后作者证明了训练集的选取也很重要:缺少BoolQ, SQuAD 2.0, OBQA, NarQA任意一个都会对模型性能带来较大的损害

总结

UnifiedQA 和 T5 的区别:

- UnifiedQA 仅用于问答任务,而 T5 的适用范围更广;

- UnifiedQA 由于只用于问答任务,不需要显式地添加指示任务类型的前缀 prompt,需要模型在训练过程中自己学会“要干什么”,增大了训练难度。不需要指示任务类型的前缀 prompt 也是作者倡导的卖点。因此,作者并没有探究显式加上描述任务的 prompt 对训练有什么影响。

UnifiedQA 为什么有效:

UnifiedQA 的成功归功于多数据+多任务+生成模型,缺一不可。多任务还能成功的关键在于任务之间有本质的联系,都是问答任务,不是区别很大的任务(例如问答+翻译)。本质上 UnifiedQA 也用到了 prompt 的思想,对不同类型的问答任务设计了相同的模版。这篇论文也证明了不需要多么复杂的模型,只需要合理地组合更丰富的数据就能带来提升(数据依然是提点关键)。

以上是关于论文笔记UnifiedQA:新SOTA,生成模型一统问答任务的主要内容,如果未能解决你的问题,请参考以下文章

图像生成王者不是GAN?扩散模型最近有点火:靠加入类别条件,效果直达SOTA

图像生成王者不是GAN?扩散模型最近有点火:靠加入类别条件,效果直达SOTA

图像生成王者不是GAN?扩散模型最近有点火:靠加入类别条件,效果直达SOTA