去中心化的联邦图神经网络

Posted Xidian小韩同学

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了去中心化的联邦图神经网络相关的知识,希望对你有一定的参考价值。

《Decentralized Federated Graph Neural Networks》论文阅读笔记

发表在2021年的IJCAI

- 背景

GNN广泛用来分析图结构数据,然而,在用户端有隐私,规则限制,商业竞争等。因此,我们能看到的图结构数据是分布式的,这也就限制了GNN的应用。 - 已有方法

已有一些关于中心化联邦图神经网络的研究,中心服务器协调各个参与者从图结构数据中训练的GNN模型。 - 存在问题

中心服务器需要进行模型聚合操作,在很多跨领域场景下,这种中心服务器是不被接受的。因此,去中心化的学习模型在真实场景下还是很关键的。 - 本文

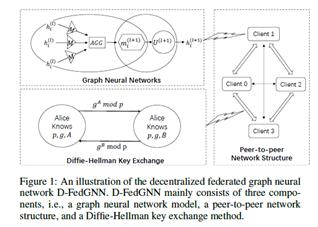

提出一种去中心化的联邦图神经网络D-FedGNN,允许多个参与者训练一个图神经网络模型,且不需要中心服务器。具体的,使用去中心化的并行梯度下降是算法DP-SGD,在点对点的网络结构中训练图神经网络模型。为了保护模型聚合过程中的隐私,D-FedGNN引入Diffie-Hellman key exchange方法在客户端进行安全模型聚合。

- 具体

5.1 初始化

每个客户端有自己的子图,G = (V,E),在初始阶段,客户端初始化训练模型参数,然后将训练好的模型参数发送给其他客户端,最终,调用Diffie-Hellman密钥交换协议,与j客户建立共享密钥。

5.2 本地模型更新:

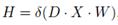

每个客户端利用自己的隐私数据训练图神经网络模型,在训练过程中,每个客户端首先生成节点的嵌入向量X,执行前向图卷积层的计算:

其中,D是邻接矩阵,编码图中的边信息,可以进行图变换,如拉普拉斯矩阵。δ是非线性激活函数ReLU。

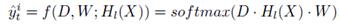

假设有l个图卷积层,则GCN的输出:

损失函数:

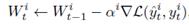

反向传播更新模型:

5.3 安全模型聚合:

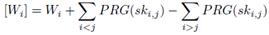

客户端首先将本地的模型参数安全掩码:

其中,PRG()是伪随机数生成器,sk是客户端i,j共享的密钥。

以上是关于去中心化的联邦图神经网络的主要内容,如果未能解决你的问题,请参考以下文章

论文导读- SpreadGNN: Serverless Multi-task Federated Learning for Graph Neural Networks(去服务器的多任务图联邦学习)