李宏毅机器学习 p3[学习笔记 ]

Posted bohu83

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了李宏毅机器学习 p3[学习笔记 ]相关的知识,希望对你有一定的参考价值。

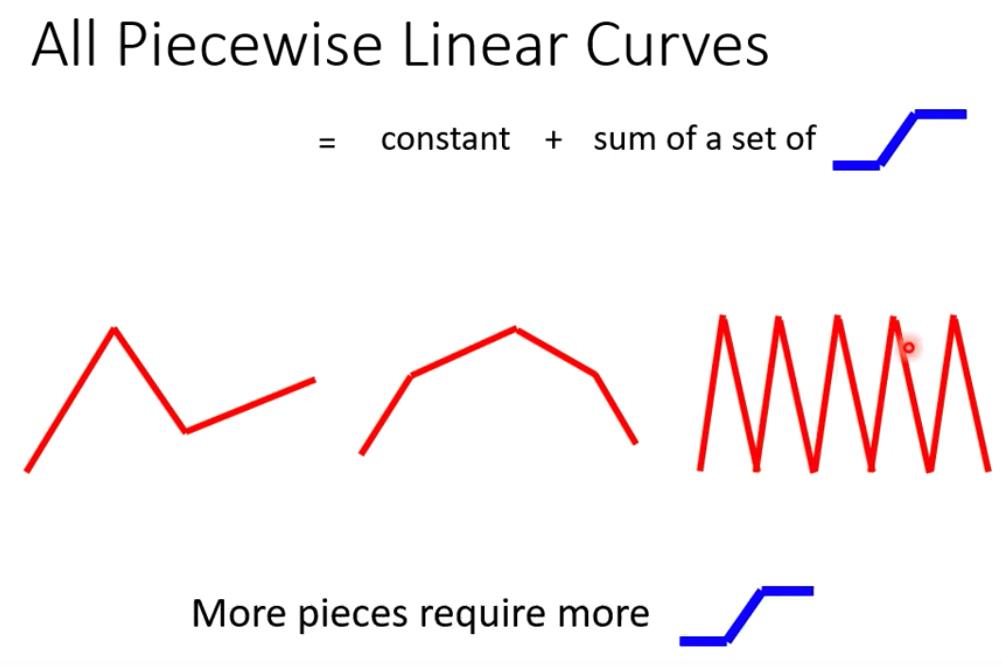

线性模型过于简单,蓝色线所示,如果更复杂的模型 ,如 红线所示。

可以使用一个常数项跟 一堆蓝色的折线的组合。

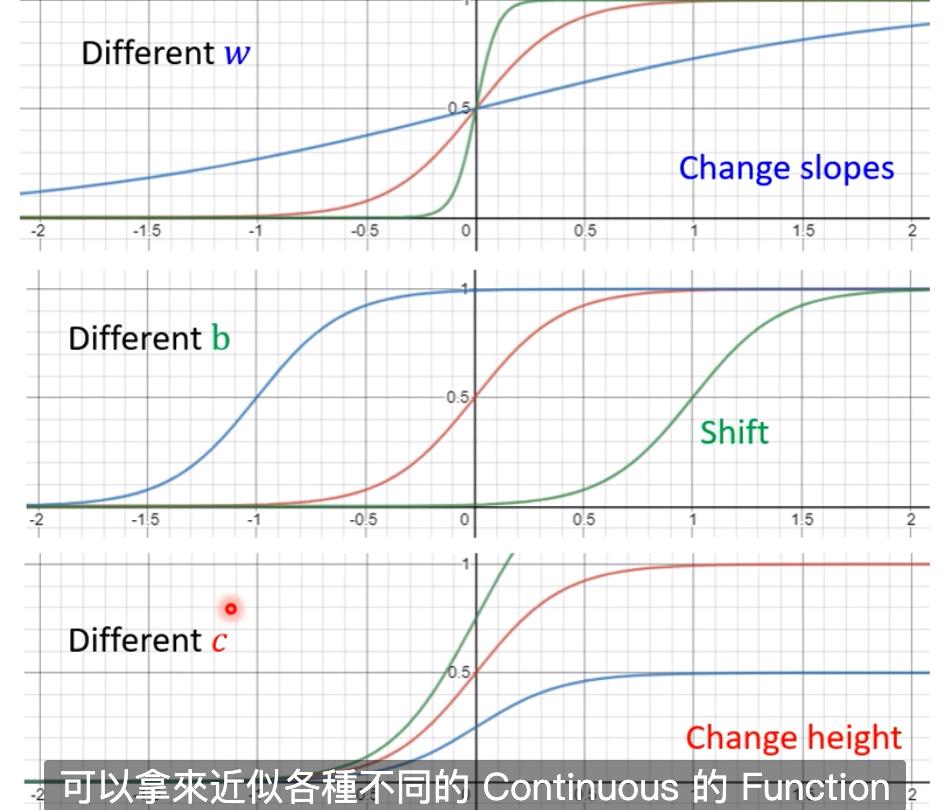

蓝色折线使用sigmod 函数表示,它的特点:随着  的增大,y趋向于c,随着

的增大,y趋向于c,随着  的减少,y趋向于0.

的减少,y趋向于0.

可以调整不同的w,b,c 来 调整不同的图像 。

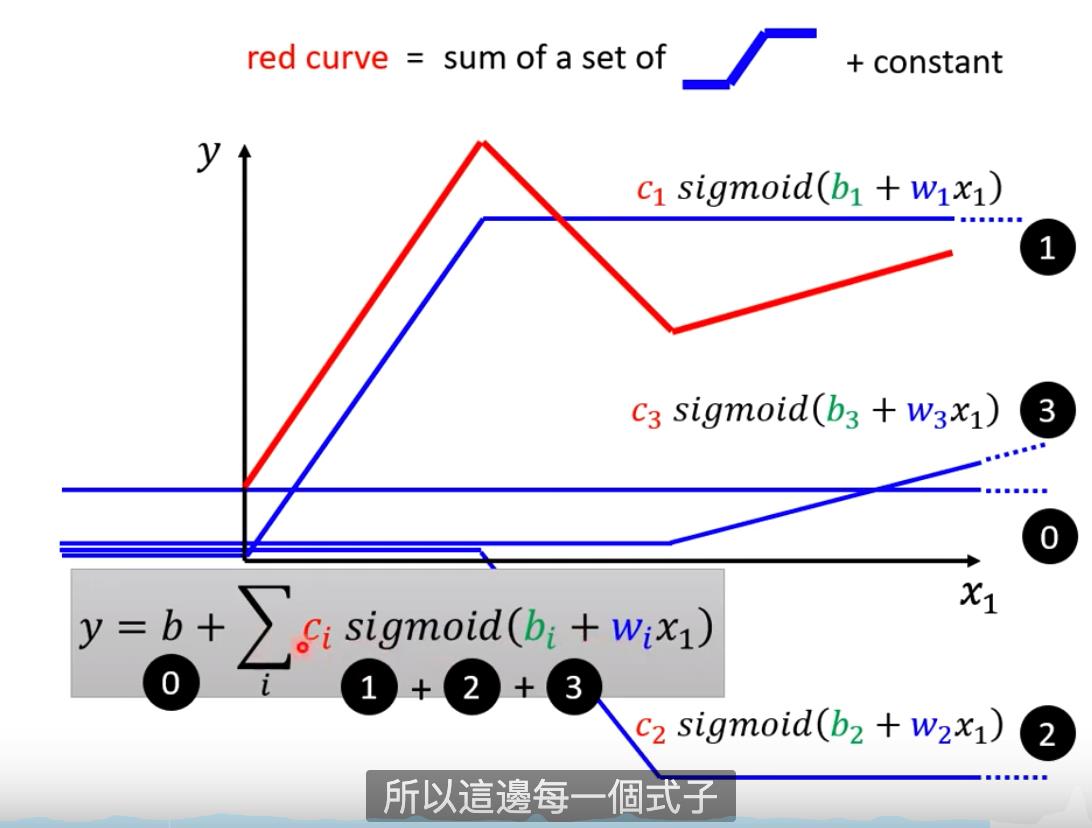

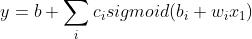

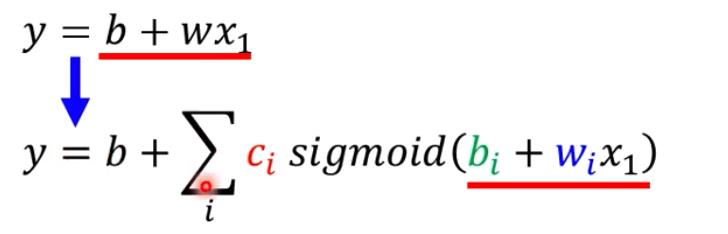

红色折线可以写成

因为 线性模型的bias 较大,为了减少这个值,采用了共有弹性的红色折线

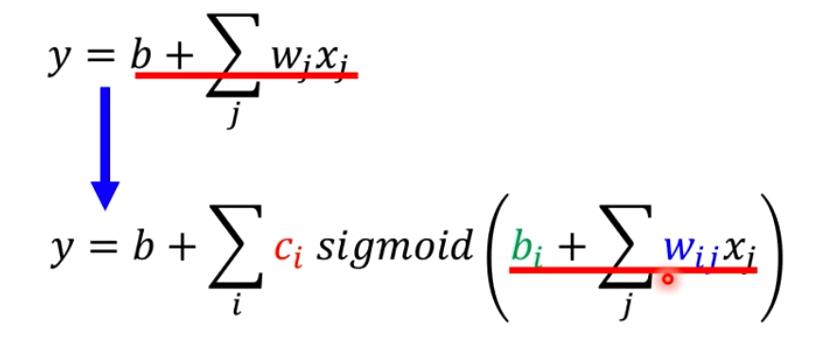

更多feature :

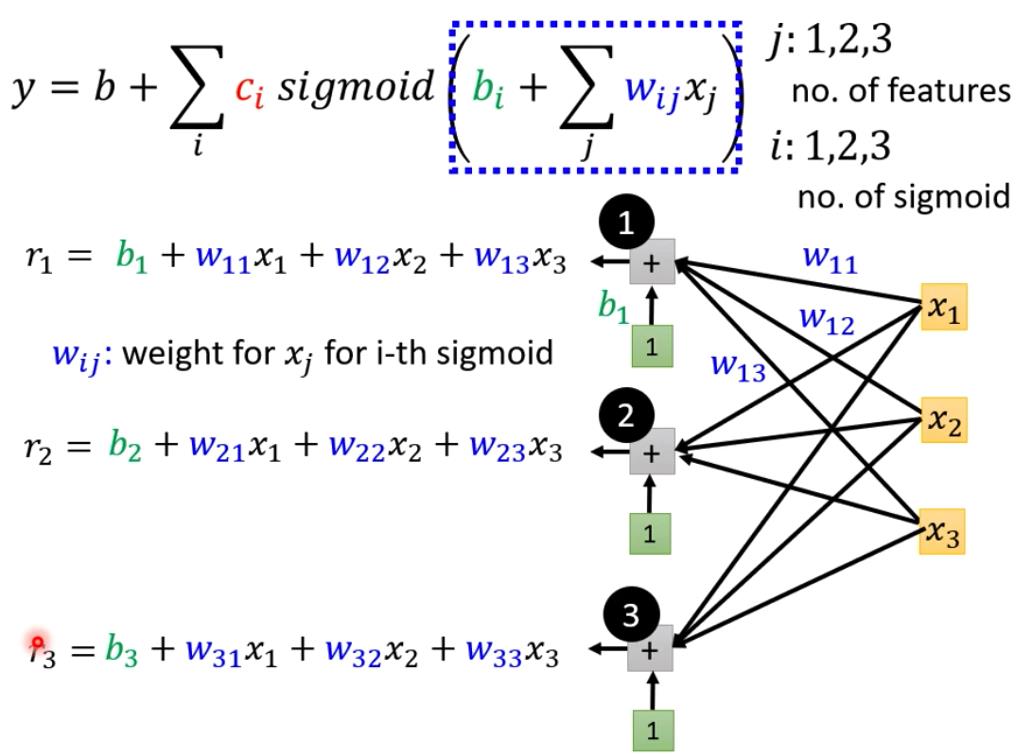

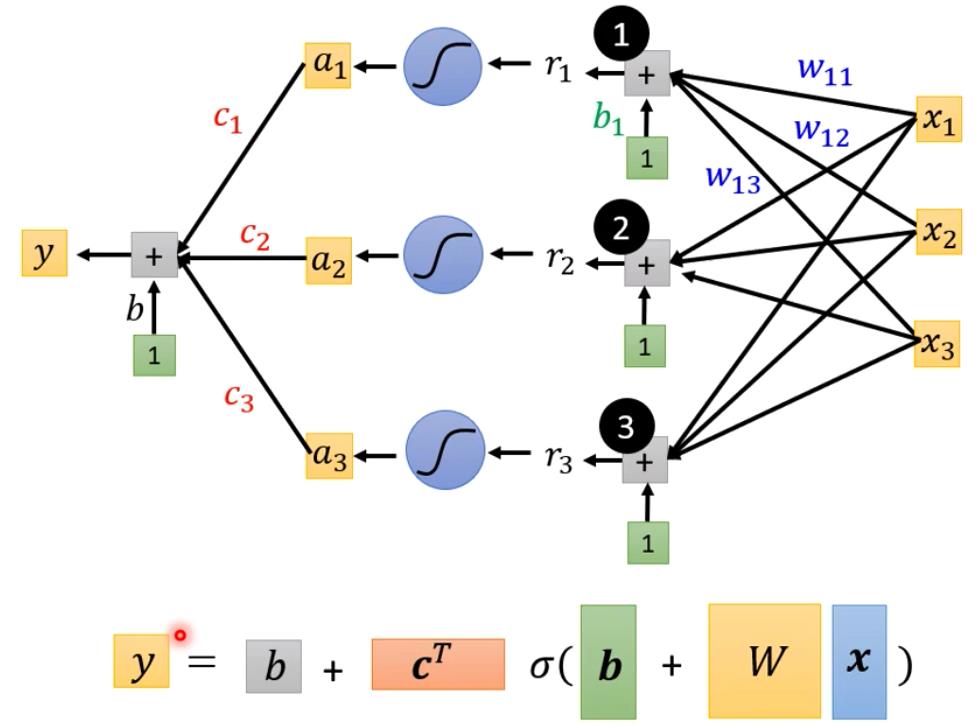

下面看下取值为3个feature(j=1,2,3)的情况,i 表示一个蓝色的function。只是举例,越多的函数就能表示越复杂的曲线,有多少个函数是超参数,自己决定。

x1,x2,x3 表示前一天,前二天,前三天的观看 人数。

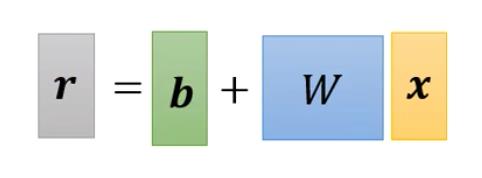

其中,r就是sigmod的入参蓝色括号内的简化表示:

上面是图形化的表示方式,下面是线性代数 的表示方式。

上面是图形化的表示方式,下面是线性代数 的表示方式。

第一步的 定义 函数就完成了(注意两个b 不同含义,颜色不同)

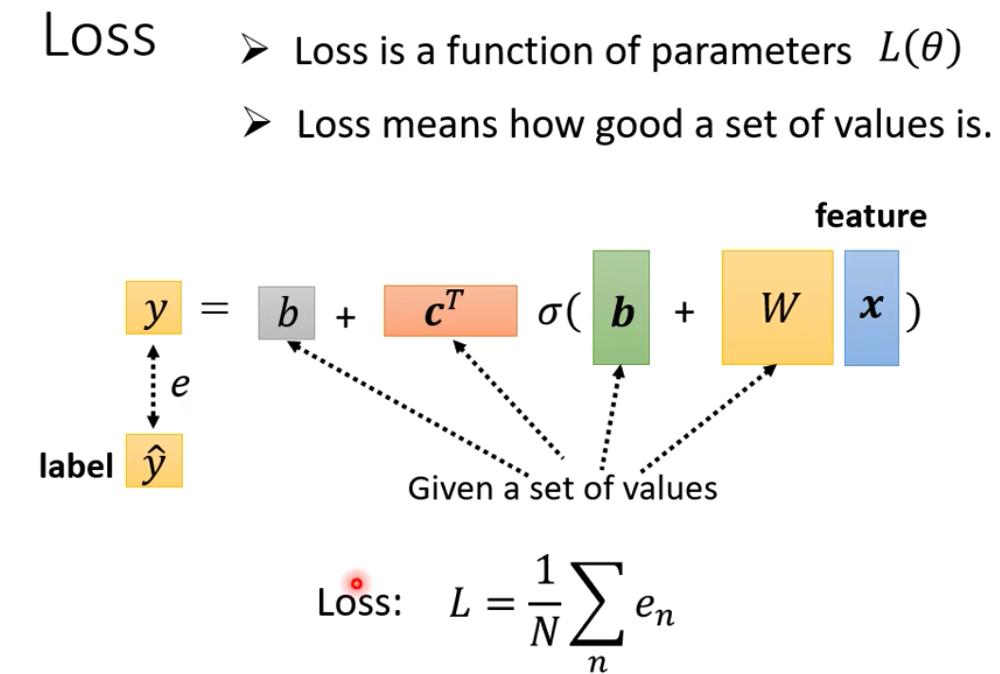

这里 的 Loss 跟之前没有不同, 就是一组未知参数的 统称。

就是一组未知参数的 统称。

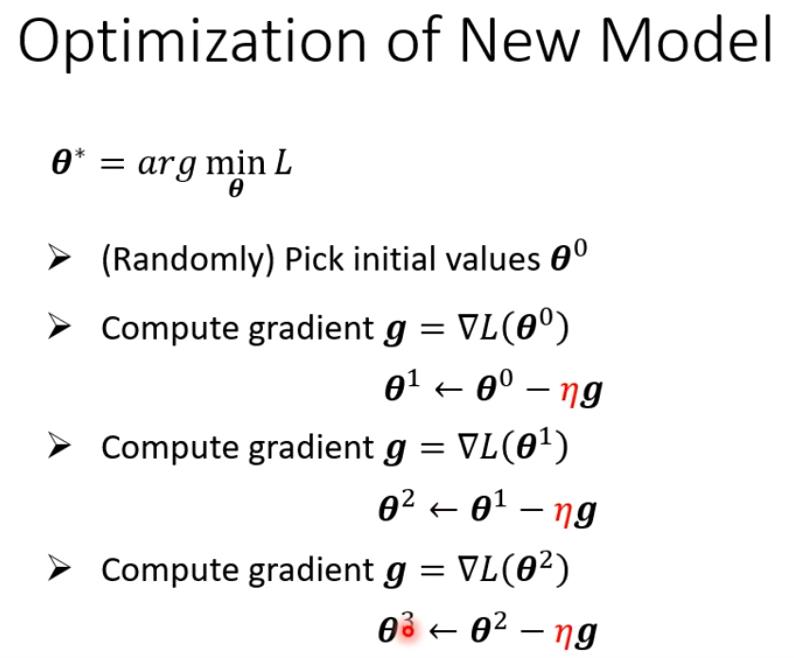

第三步 :求最优化 参数

这是一个理论 的 计算 过程,通常情况下不会计算到g=0 为止。

这是一个理论 的 计算 过程,通常情况下不会计算到g=0 为止。

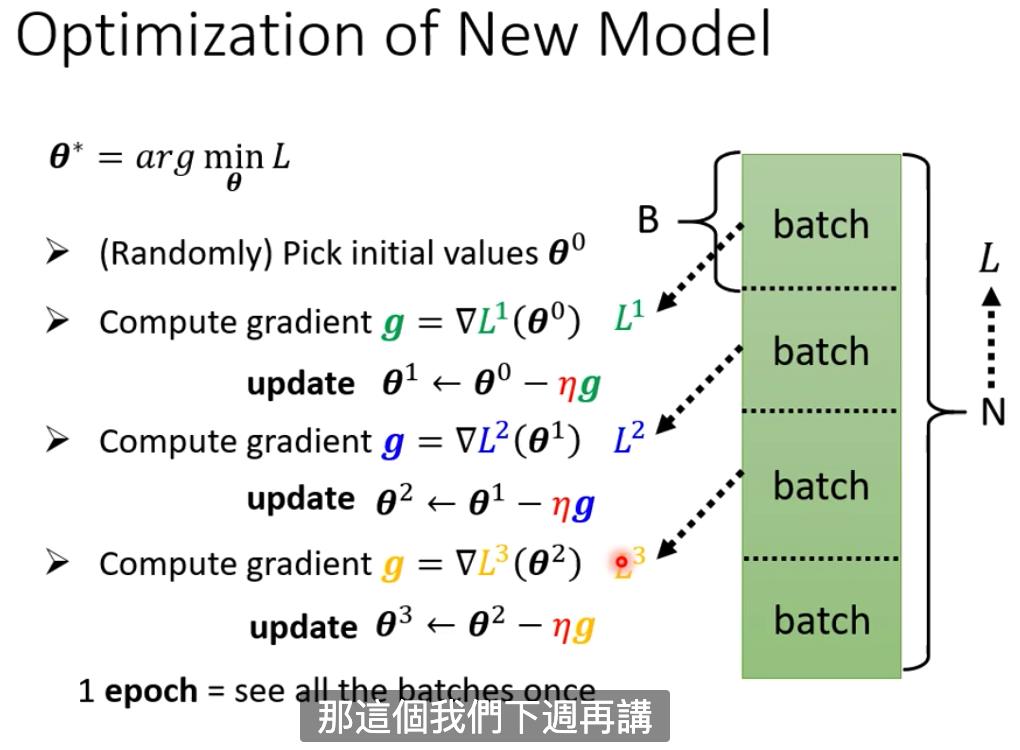

实际情况 ,会分批batch处理。根据batch去分别计算L1,L2,L3 ,所有的batch处理一遍叫eponch(一个Epoch就是将所有训练样本训练一次的过程。)每次更新参数叫update

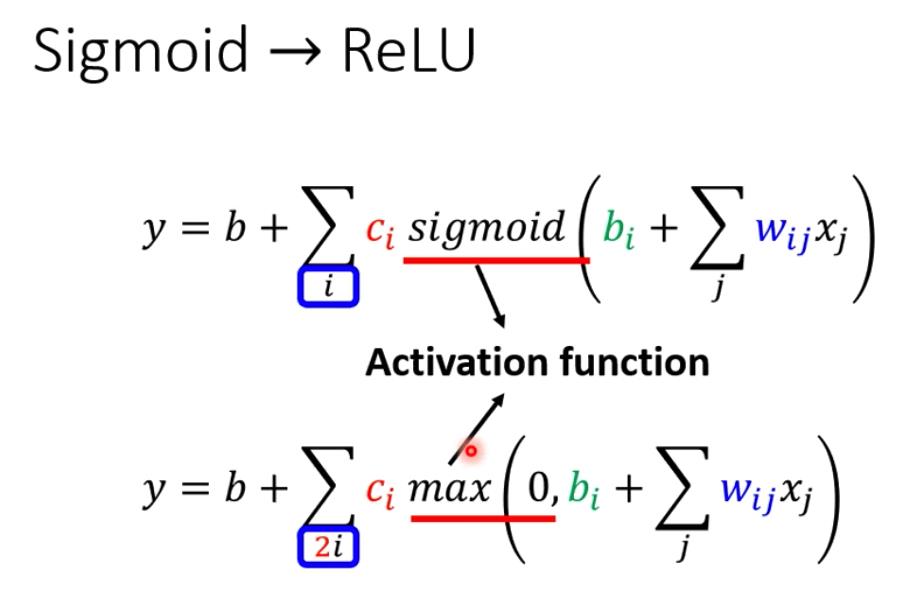

除了SIGMOD,还有其他方式表示

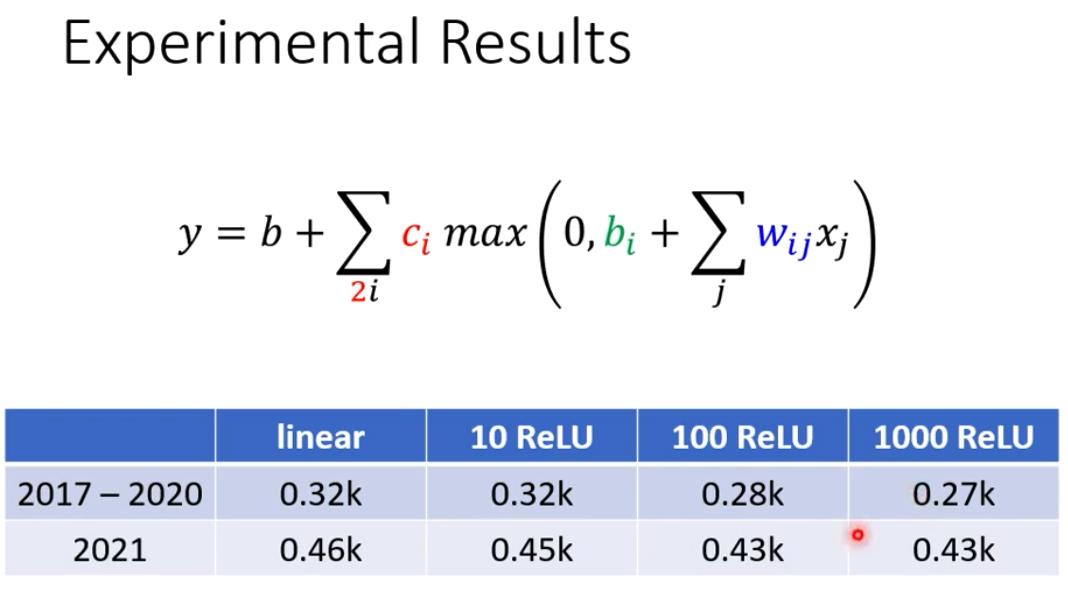

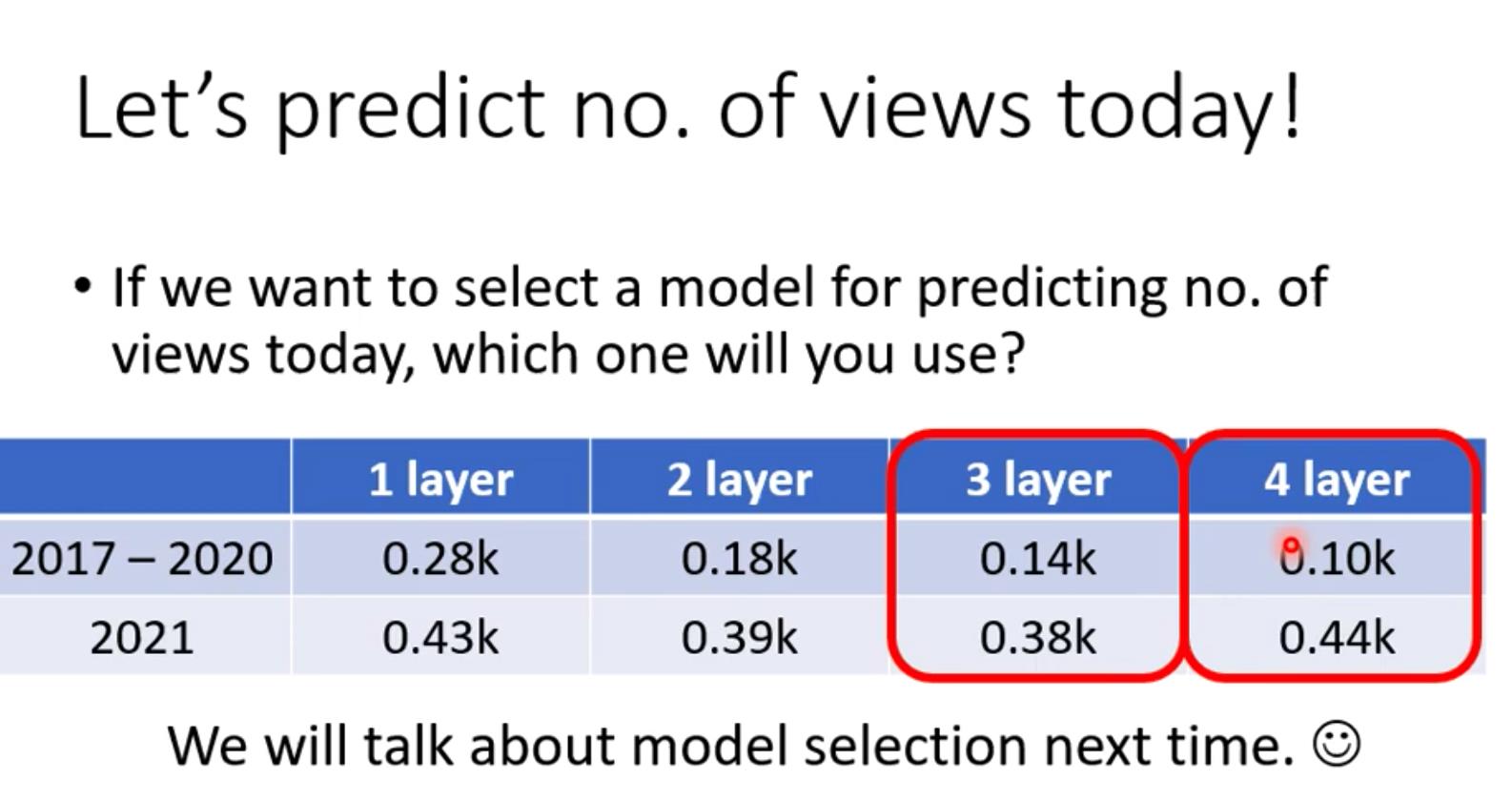

真实 数据 测试结果:

真实 数据 测试结果:

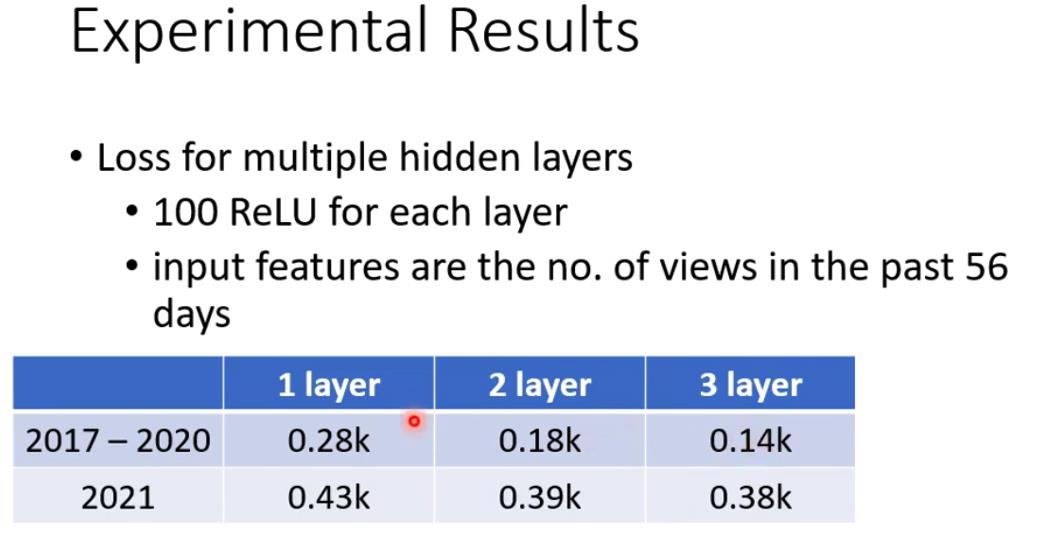

还可以 改进模型:

这里的1 layer 就进行一次*w+b,进行一次函数转换relu。

关于名字:

关于名字:

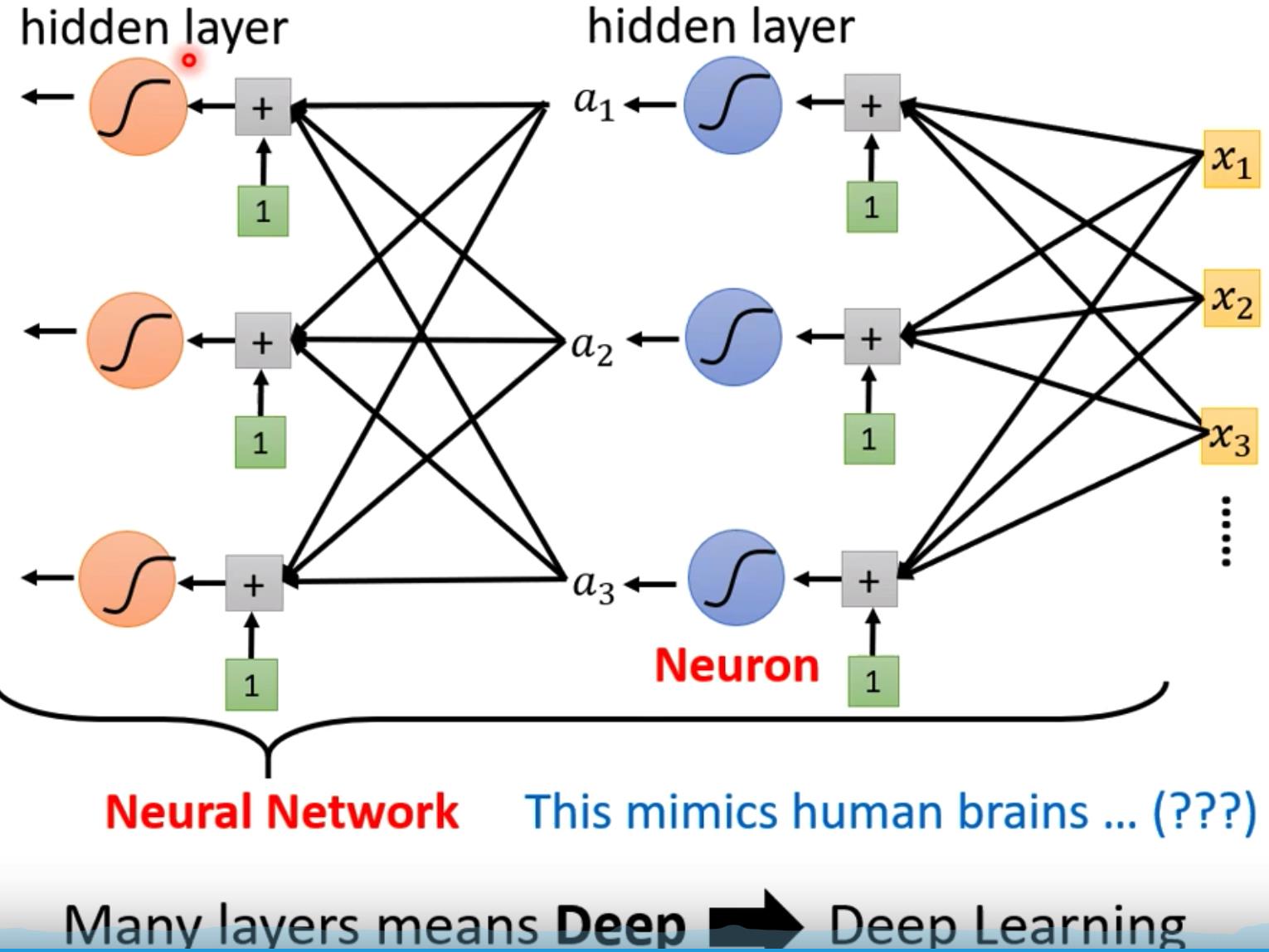

一起把sigmod 或者relu 叫做neuron (神经 元),整个叫神经网络 。过于浮夸,现在 叫做hidden layer,许多层叫深度学习。

为什么 把layer 变深而不是变广,老师后面会讲。

为什么 不是更多层?下面 的例子 ,出现了过拟合overfiting 的 问题 。

以上是关于李宏毅机器学习 p3[学习笔记 ]的主要内容,如果未能解决你的问题,请参考以下文章