Flink从入门到精通100篇(二十二)- Flink应用实战案例:如何实现网络流控与反压机制

Posted 文宇肃然

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Flink从入门到精通100篇(二十二)- Flink应用实战案例:如何实现网络流控与反压机制相关的知识,希望对你有一定的参考价值。

目录

-

Flink 流处理为什么需要网络流控?

-

Flink V1.5 版之前网络流控介绍

-

Flink V1.5 版之前的反压策略存在的问题

-

Credit的反压策略实现原理,Credit是如何解决 Flink 1.5 之前的问题?

-

对比spark,都说flink延迟低,来一条处理一条,真是这样吗?其实Flink内部也有Buffer机制,Buffer机制具体是如何实现的?

-

Flink 如何在吞吐量和延迟之间做权衡?

Flink 流处理为什么需要网络流控?

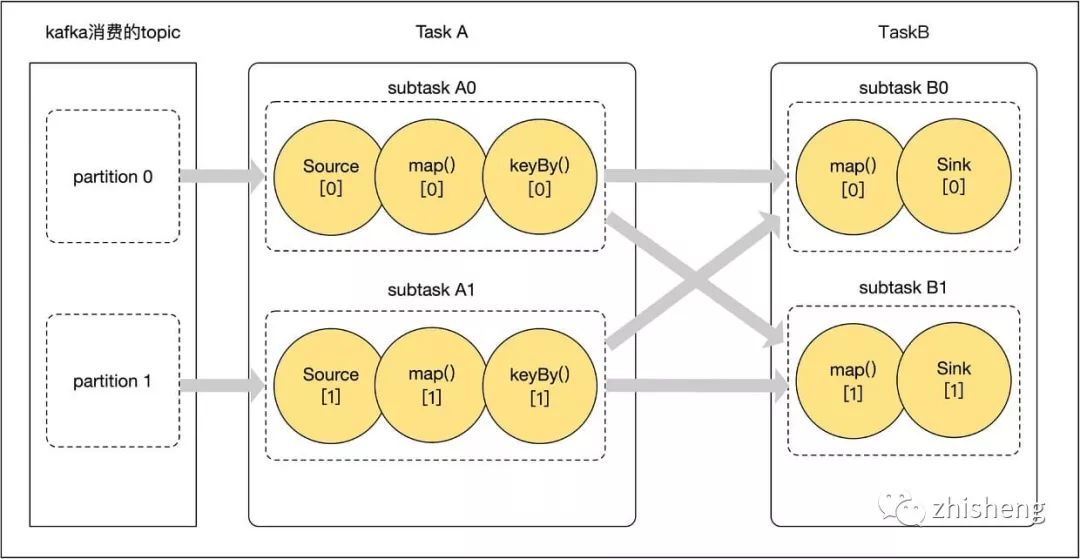

分析一个简单的 Flink 流任务,下图是一个简单的Flink流任务执行图:任务首先从 Kafka 中读取数据、 map 算子对数据进行转换、keyBy 按照指定 key 对数据进行分区(相同 key 的数据经过 keyBy 后分到同一个 subtask 实例中),keyBy 后对数据接着进行 map 转换,然后使用 Sink 将数据输出到外部存储。

众所周知,在大数据处理中,无论是批处理还是流处理,单点处理的性能总是有限的,我们的单个 Job 一般会运行在多个节点上,多个节点共同配合来提升整个系统的处理性能。图中,任务被切分成 4 个可独立执行的 subtask( A0、A1、B0、B1),在数据处理过程中,就会存在 shuffle(数据传输&#

以上是关于Flink从入门到精通100篇(二十二)- Flink应用实战案例:如何实现网络流控与反压机制的主要内容,如果未能解决你的问题,请参考以下文章

Flink从入门到精通100篇(二十二)- Flink应用实战案例:如何实现网络流控与反压机制

Flink从入门到精通100篇(二十一)-万字长文详解 Flink 中的 CopyOnWriteStateTable

Flink从入门到精通100篇(二十四)-对Flink SQL Client 源码做深度解析

Flink从入门到精通100篇(二十三)-Flink实战应用案例:如何清理过期的 Checkpoint 目录?