第21篇屏蔽自编码器是可扩展的视觉学习器

Posted AI浩

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了第21篇屏蔽自编码器是可扩展的视觉学习器相关的知识,希望对你有一定的参考价值。

屏蔽自编码器是可扩展的视觉学习器

摘要

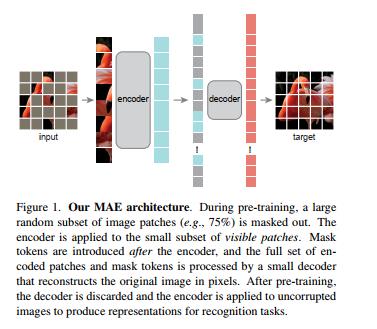

本文表明,掩码自编码器 (MAE) 是用于计算机视觉的可扩展自监督学习器。我们的 MAE 方法很简单:我们屏蔽输入图像的随机块并重建丢失的像素。它基于两个核心设计。首先,我们开发了一个非对称编码器-解码器架构,其中一个编码器只对可见的补丁子集进行操作(没有掩码标记),以及一个轻量级的解码器,可以从潜在表示和掩码标记重建原始图像。其次,我们发现屏蔽大部分输入图像(例如 75%)会产生重要且有意义的自我监督任务。结合这两种设计使我们能够高效地训练大型模型:我们加速训练(3 倍或更多)并提高准确性。我们的可扩展方法允许学习泛化良好的高容量模型:例如,在仅使用 ImageNet-1K 数据的方法中,vanilla ViT-Huge 模型实现了最佳准确率 (87.8%)。下游任务中的传输性能优于有监督的预训练,并显示出有希望的扩展行为。

1、简介

深度学习见证了能力和容量不断增长的架构的爆炸式增长 [28, 24, 47]。 在硬件快速增长的帮助下,今天的模型很容易过拟合一百万张图像 [13],并开始需要数亿张——通常是公开无法访问的——标记图像 [16]。

这种对数据的需求已经通过自监督预训练在自然

以上是关于第21篇屏蔽自编码器是可扩展的视觉学习器的主要内容,如果未能解决你的问题,请参考以下文章

PyTorch笔记 - MAE(Masked Autoencoders) PyTorch源码

PyTorch笔记 - MAE(Masked Autoencoders) PyTorch源码

PyTorch笔记 - MAE(Masked Autoencoders) PyTorch源码

Masked Autoencoders Are Scalable Vision Learners 论文研读

PyTorch笔记 - MAE: Masked Autoencoders Are Scalable Vision Learners

PyTorch笔记 - MAE: Masked Autoencoders Are Scalable Vision Learners