spark on yarn配置

Posted 一加六

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了spark on yarn配置相关的知识,希望对你有一定的参考价值。

在安装好spark后

- 修改spark-env.sh 若没有 将模板文件改名为此名称

在spark安装目录下的conf找到spark-env.sh

添加HADOOP_HOME和HADOOP_CONF_DIR让其加载yarn-site.xml文件配置

- 修改spark-defaults.conf

同在conf文件夹下找到spark-defaults.conf.template文件改名spark-defaults.conf

添加如下

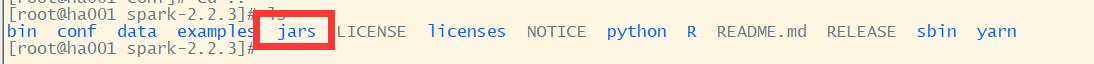

然后将spark安装目录下的jars中的文件 put到hdfs上图所指定位置

hdfs dfs -put ./jars/* /spark/jars/

这样做的目的是spark运行时可以在hdfs加载需要的jar包,就像java连接数据库要用到java-connecter-mysql.jar。

- spark on yarn 任务提交格式

#当前目录

#/export/servers/spark-2.2.3/

spark-submit \\

--class org.apache.spark.examples.SparkPi \\

--master yarn --deploy-mode client \\

--conf spark.driver.host=192.168.88.12 \\

examples/jars/spark-examples_2.11-2.2.3.jar 10

–class 是全限定类名

–master yarn 是指使用yarn管理

–deploy-mode client*cluster* client可以在提交任务的机器查看结果

cluster只能在yarn上看结果

–conf spark.driver.host=192.168.88.12 driver监听的主机名或者IP地址。就是提交任务机器的地址,这用于和executors以及独立的master通信接收结果

examples/jars/spark-examples_2.11-2.2.3.jar 运行的jar包

当我们测试一个demo如下图会为spark任务自动机器CPU、内存等资源

关于yarn-site.xml配置

以上是关于spark on yarn配置的主要内容,如果未能解决你的问题,请参考以下文章