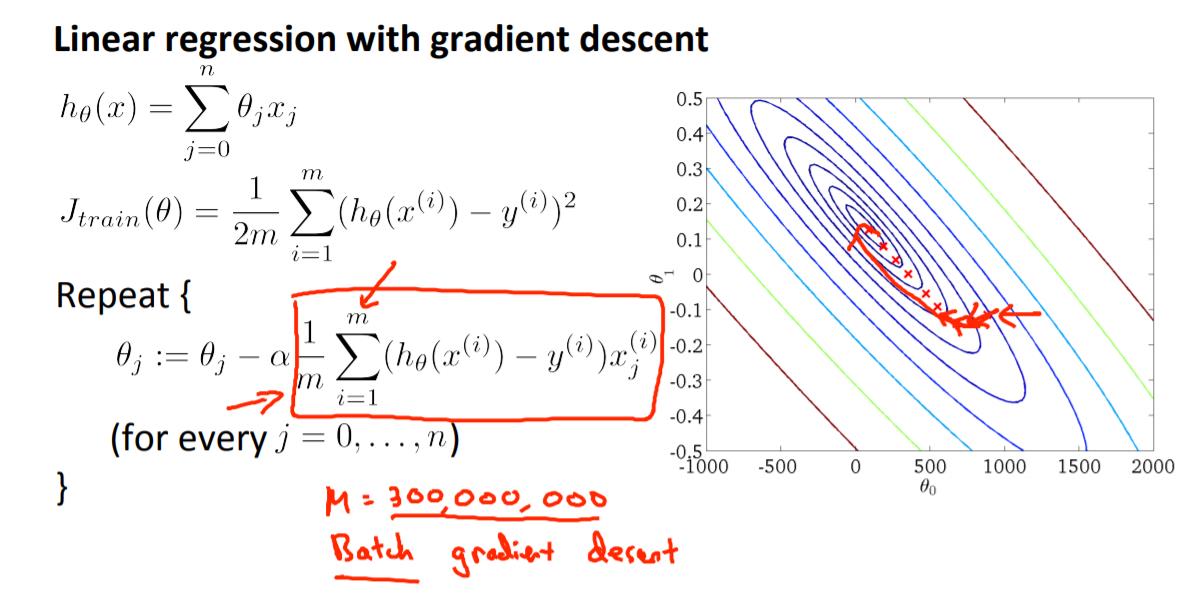

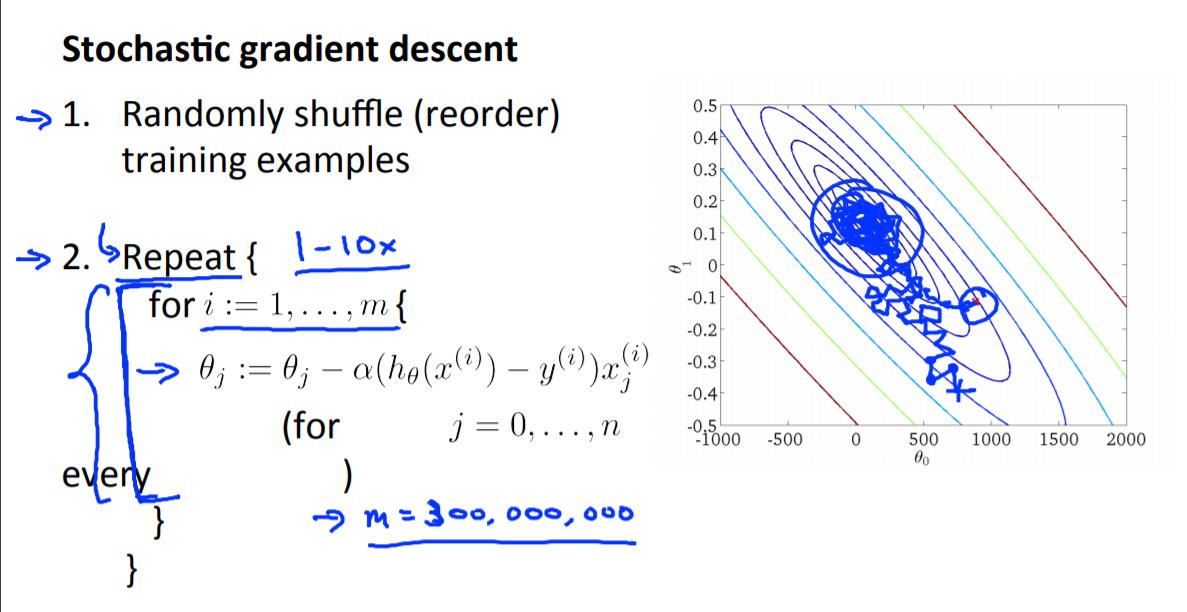

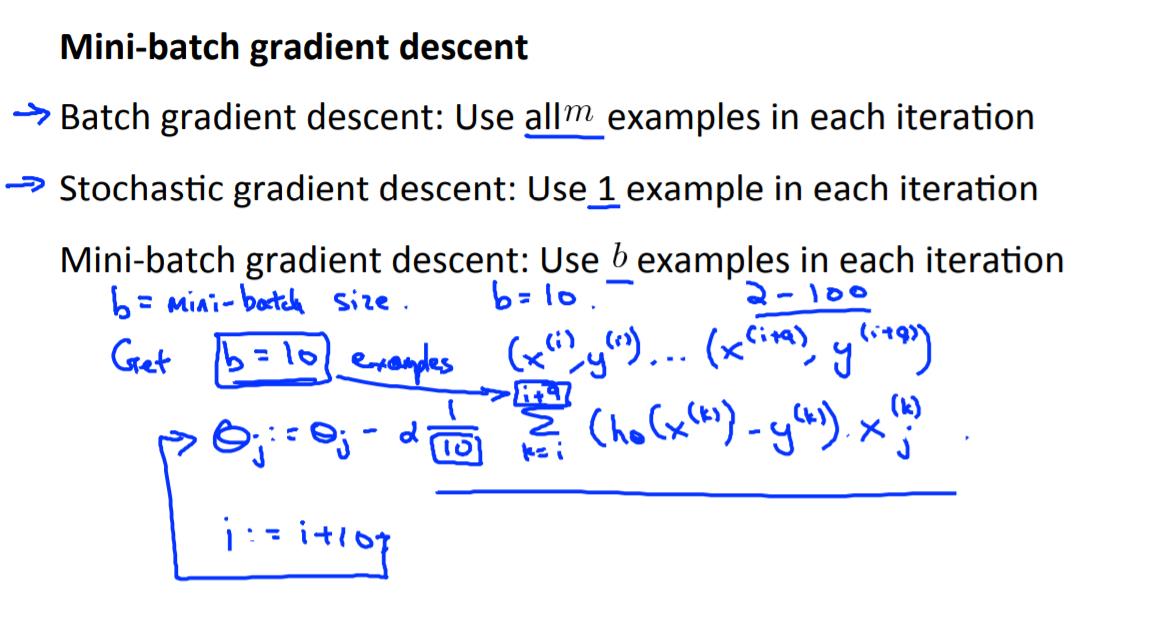

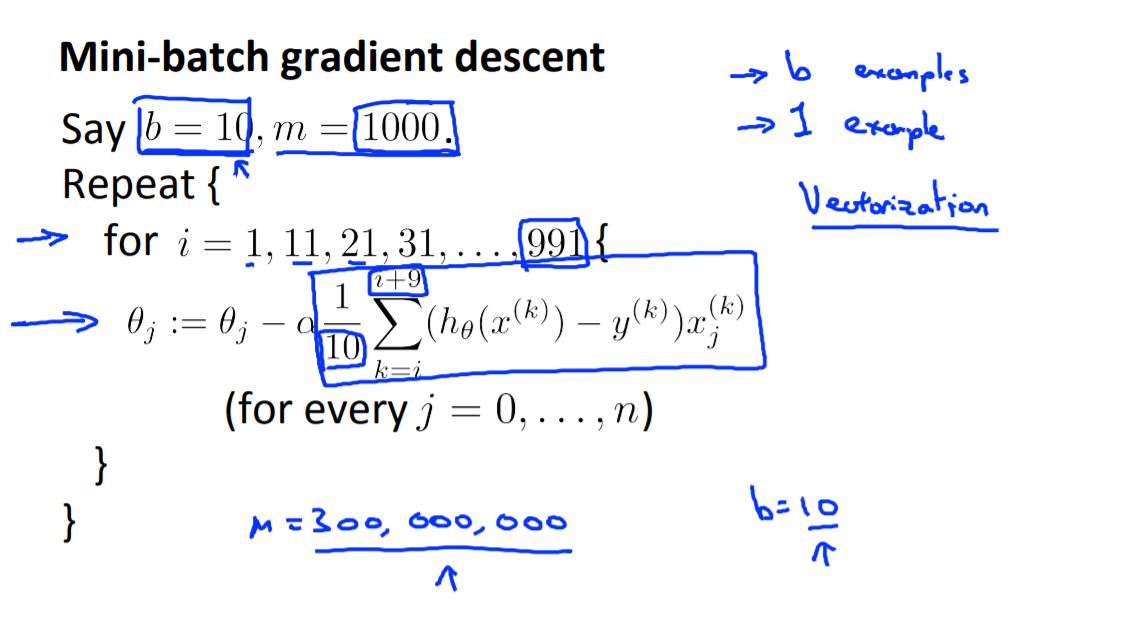

week10——随机梯度下降,批量梯度下降小批量梯度下降

Posted ^_^|

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了week10——随机梯度下降,批量梯度下降小批量梯度下降相关的知识,希望对你有一定的参考价值。

以上是关于week10——随机梯度下降,批量梯度下降小批量梯度下降的主要内容,如果未能解决你的问题,请参考以下文章

批量梯度下降BGD随机梯度下降SGD和小批量梯度下降MBGD对比

随机梯度下降批量梯度下降小批量梯度下降分类是什么?有什么区别?batch_size的选择如何实施有什么影响?