深度学习核心技术精讲100篇(六十五)-万字长文从ReLU到GELU通讲神经网络激活函数

Posted 文宇肃然

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了深度学习核心技术精讲100篇(六十五)-万字长文从ReLU到GELU通讲神经网络激活函数相关的知识,希望对你有一定的参考价值。

前言

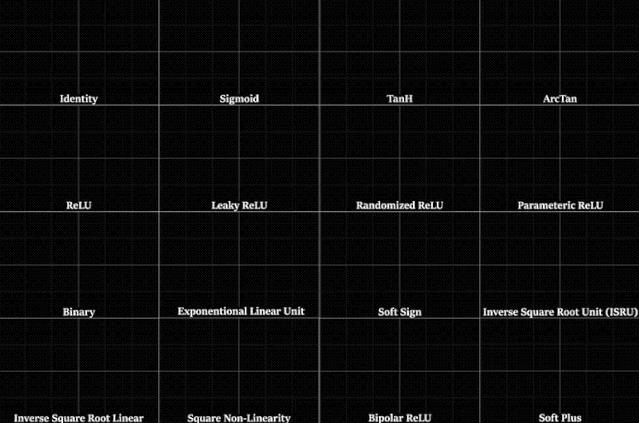

在计算每一层的激活值时,我们要用到激活函数,之后才能确定这些激活值究竟是多少。根据每一层前面的激活、权重和偏置,我们要为下一层的每个激活计算一个值。但在将该值发送给下一层之前,我们要使用一个激活函数对这个输出进行缩放。

激活函数是神经网络中一个至关重要的部分。在这篇长文中,我将全面介绍六种不同的激活函数,并阐述它们各自的优缺点。我会给出激活函数的方程和微分方程,还会给出它们的图示。本文的目标是以简单的术语解释这些方程以及图。

以下是我为大家准备的几个精品专栏,喜欢的小伙伴可自行订阅,你的支持就是我不断更新的动力哟!

以上是关于深度学习核心技术精讲100篇(六十五)-万字长文从ReLU到GELU通讲神经网络激活函数的主要内容,如果未能解决你的问题,请参考以下文章

深度学习核心技术精讲100篇(六十)-深度学习分类算法之神经网络

深度学习核心技术精讲100篇(六十三)-CNN一文详细讲解前因后果

深度学习核心技术精讲100篇(六十一)-TikTok抖音国际版留存背后的数据和算法推演

深度学习核心技术精讲100篇(六十四)-特征选择原理及应用实战案例