上海交大最新《多轮对话理解》综述

Posted 人工智能博士

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了上海交大最新《多轮对话理解》综述相关的知识,希望对你有一定的参考价值。

点上方人工智能算法与Python大数据获取更多干货

在右上方 ··· 设为星标 ★,第一时间获取资源

仅做学术分享,如有侵权,联系删除

转载于 :专知

摘要

训练机器理解自然语言并与人类进行交互是人工智能的一个难以捉摸的重要任务。随着深度学习技术的快速发展,特别是最近出现的预训练语言模型(pretraining language model, PrLM),已经设计出了多种对话系统。在这些研究中,最基本但最具挑战性的任务类型是对话理解,其角色是教机器在回答之前阅读和理解对话语境。本文从对话建模技术的角度对对话理解任务中的对话建模方法进行了综述。我们总结了对话理解相对于纯文本阅读理解的特点和挑战。然后,我们讨论了三种典型的对话模式。此外,我们对对话相关的前训练技术进行了分类,这些技术被用于增强对话场景中的PrLMs。最后,我们重点介绍了近年来的技术进展,并指出了实证分析的经验教训和对一个新的研究前沿的展望。

https://www.zhuanzhi.ai/paper/de82bf19206ccf5e6659a00c1c761c09

引言

构建一个能够与人类进行自然和有意义的交流的智能对话系统是人工智能(AI)长期以来的目标,由于其潜在的影响力和诱人的商业价值,学术界和工业界对其越来越感兴趣。这是一个有着悠久历史的人机交互经典课题。在计算机科学和人工智能被划分为各个具体的分支之前,对话作为一种现象,已经成为一个具有明确应用场景的关键研究课题。对话也是语用学(Leech, 2003)和图灵测试(Turing and Haugeland, 1950)的重要应用领域。

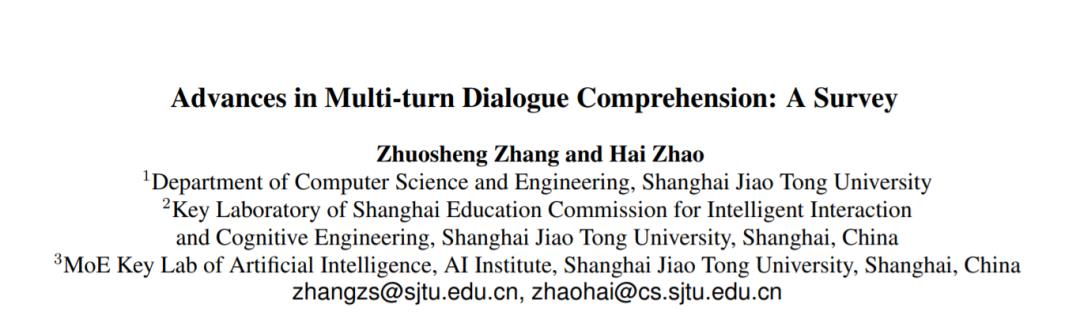

在分析输入话语的场景后,提出了传统的方法来帮助用户使用预定义的手工模板完成特定的任务(Weizenbaum, 1966;Colby et al., 1971),被认为是基于规则的方法(Chizhik和Zherebtsova, 2020)。然而,这一领域的增长受到了数据稀缺问题的阻碍,因为这些系统需要从数量不足的高质量语料库中学习语言知识、决策和问题回答(Zaib et al., 2020)。为了缓解稀缺性,人们提出了多种任务,如响应选择(Lowe et al., 2015;Wu et al., 2017;Zhang et al., 2018b),基于对话的问答(QA) (Sun et al., 2019; Reddy et al., 2019; Choi et al., 2018),决策和问题生成(Saeidi et al., 2018)。示例如图1所示。

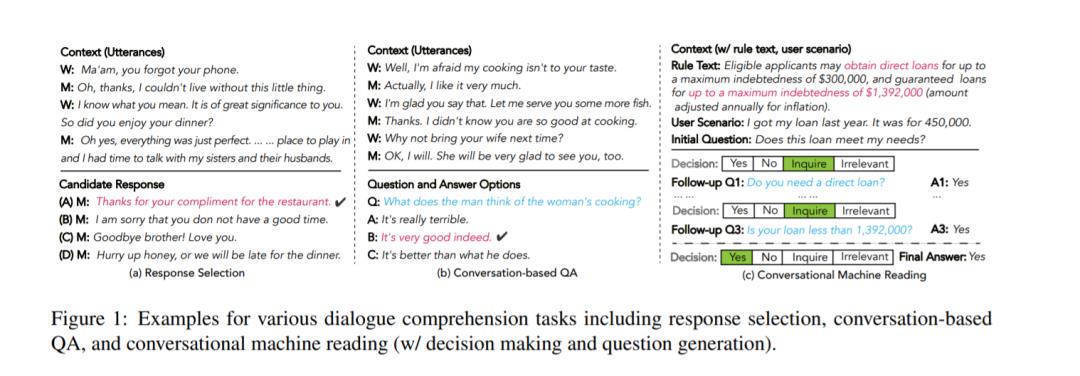

最近,随着深度学习方法的发展(Serban et al., 2016),特别是最近的预训练语言模型(PrLMs) (Devlin et al., 2019; Liu et al., 2019; Yang et al., 2019; Lan et al., 2020; Clark et al., 2020),神经模型的能力得到了显著提高。然而,大多数研究都集中在回复检索或生成等个体任务上。受建立更广泛有效和全面的系统来解决现实世界的问题的需求,传统的自然语言处理(NLP)任务,包括dialogue-related任务,一直经历着快速转换,这些任务往往是交叉和统一的形式(Zhang et al ., 2020 b)。因此,我们可以用对话理解的一般形式来看待主要的对话任务: 给定语境,需要一个系统来理解语境,然后回答或回答问题。回复可以从检索或生成中得到。作为衡量理解对话能力(相对于静态文本)的一般概念,对话理解对NLP/AI社区有广泛的启发,如图2所示。

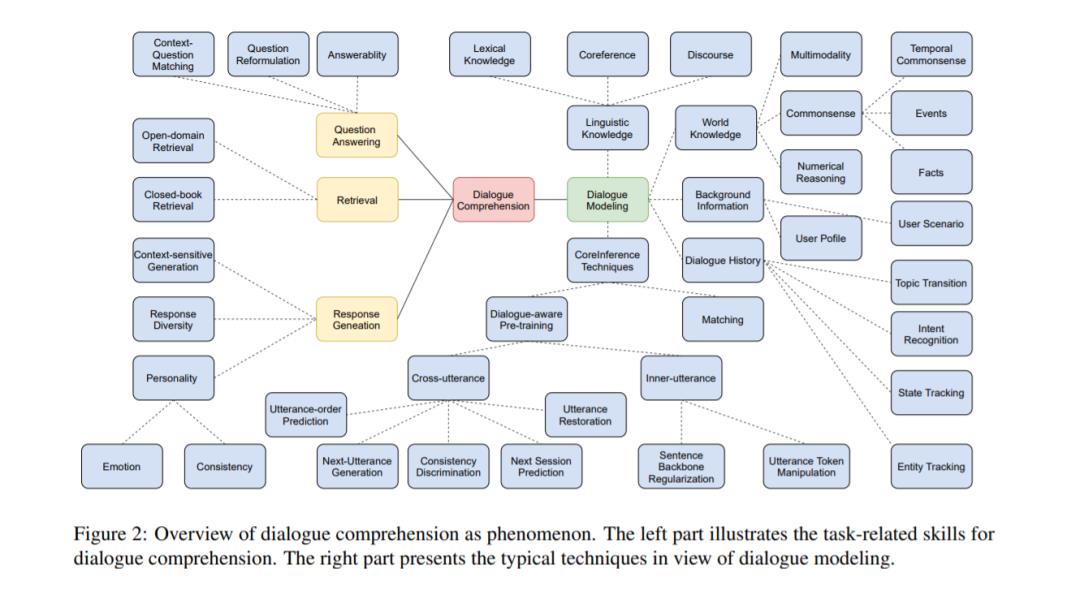

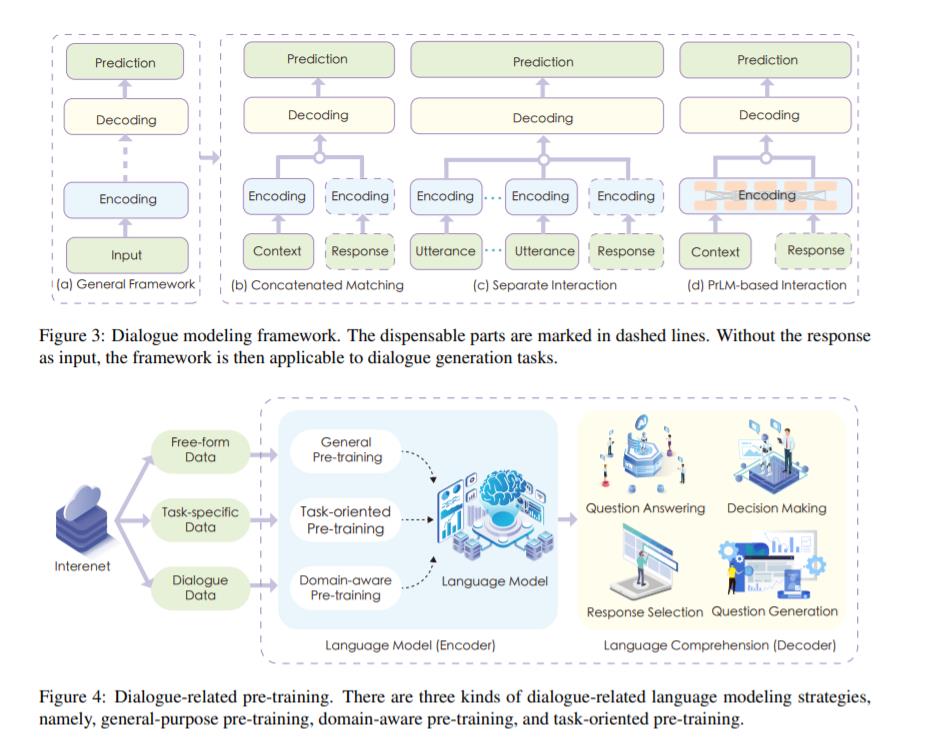

在对话理解研究中,对话建模是基本的研究方法,它关注的是如何有效地对对话语境进行编码,从而有效地解决对话任务,因此我们将对话建模作为对话理解的技术方面。早期的技术主要集中在对话语境的成对序列与候选回答或问题之间的匹配机制(Wu et al., 2017;Zhang et al., 2018b;Huang et al., 2019a)。最近,PrLMs 对包括对话理解在内的各种下游NLP任务(Devlin et al., 2019)显示了令人印象深刻的评估结果。他们将整个文本作为连续符号的线性序列处理,并通过自注意力捕捉这些符号的语境化表征(Qu et al., 2019; Liu et al., 2020a; Gu et al., 2020a; Xu et al., 2021a)。这些语言模型衍生的词嵌入是在大型语料库上预先训练的。通过提供细粒度的上下文嵌入,这些预先训练好的模型可以作为编码器轻松地应用于下游模型,或者用于微调。除了使用PrLMs 进行微调外,还出现了设计对话驱动的自监督任务进行预训练的兴趣。

本文从两阶段编码器-解码器框架的视角对对话理解的研究进行了综述,该框架受PrLMs和机器阅读理解的启发(Zhang et al., 2020b),通过这种方式,我们弥合了对话建模和理解之间的鸿沟。希望能对未来前沿PrLMs的研究有所帮助。具体来说,我们将讨论架构设计和预训练的策略。我们总结了近年来的技术进展,并强调了我们可以从实证分析和展望一个新的研究前沿的经验教训。与专注于具体对话任务的现有综述相比(Zaib et al., 2020; Huang et al., 2020; Fan et al., 2020; Qin et al., 2021b),这项工作是任务不可知的,在对话理解的范围内讨论对话系统的共同模式和趋势,以弥合不同任务之间的差距,使这些研究线可以相互学习的亮点。

---------♥---------

声明:本内容来源网络,版权属于原作者

图片来源网络,不代表本公众号立场。如有侵权,联系删除

AI博士私人微信,还有少量空位

点个在看支持一下吧

以上是关于上海交大最新《多轮对话理解》综述的主要内容,如果未能解决你的问题,请参考以下文章