详解线性判别分析(LDA)

Posted yellowTvT

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了详解线性判别分析(LDA)相关的知识,希望对你有一定的参考价值。

目录

本文着重于思想的理解与公式的推导~

Linear Discriminant Analysis(LDA)是一种经典的线性学习方法,亦称“Fisher判别分析法”

注意:本文中的

-

LDA基本思想:

找到一条直线(低维空间),使得将平面(高维空间)中的样本点投影到直线(低维空间)中,尽量使得同类样本点接近,异类样本点远离,判断新样本:当将新样本投影后,根据其投影后的位置判断其类别。

-

投影的定义

什么叫样本点投影到直线上:将点 (原点指向样本点的向量)投影到直线上,也就是投影到直线的单位方向向量

(原点指向样本点的向量)投影到直线上,也就是投影到直线的单位方向向量 上,不妨设

上,不妨设 的起点是原点

的起点是原点 ,然后求原点

,然后求原点 至投影点的距离。

至投影点的距离。

由向量的点乘可知: 是投影长度,i.e.原点

是投影长度,i.e.原点 至投影点的距离

至投影点的距离

-

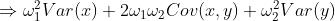

同类投影点的接近

什么叫同类投影点接近:在一维空间中,我们常常使用方差来刻画样本点偏离平均值的程度。在此处,因为已经对样本点进行投影,将每个样本点降维成了一个实数,因此就是对投影求方差,就能刻画投影点偏离样本中心点的投影的程度,也就刻画了“接近”,即投影的方差越小越接近。i.e. 越小,同类样本点越接近。

越小,同类样本点越接近。

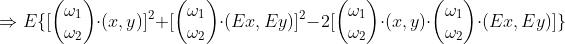

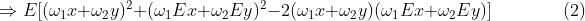

注意到西瓜书内使用的是: 刻画接近,其本质上是相等的,下面给出公式推导:

刻画接近,其本质上是相等的,下面给出公式推导:

对于 有如下变形:

有如下变形:

对于 有如下变形:

有如下变形:

可以验证的是:(1)=(2)

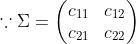

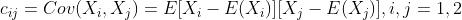

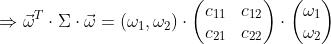

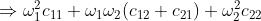

到此,证明了 ,即样本之间的协方差本质上就是样本点投影的方差。

,即样本之间的协方差本质上就是样本点投影的方差。

-

异类样本点的远离

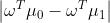

什么叫异类样本点的远离:在一维空间中,我们使用样本差的绝对值刻画距离,在此处,为了刻画一类样本点的远离,也即是求不同类别样本点之间的距离,距离越大越“远离”,但是不同类别的样本点很多,因此此处只需求异类样本中心点之间的距离就好,也就是异类样本中心点投影的差的绝对值: ,为了去除绝对值这样的不光滑的函数我们采用二次函数代替绝对值,也就是

,为了去除绝对值这样的不光滑的函数我们采用二次函数代替绝对值,也就是 越大,越远离。

越大,越远离。

此处的 是第0类的样本中心点,

是第0类的样本中心点, 是第1类的样本中心点。后文也将这样表述。

是第1类的样本中心点。后文也将这样表述。

-

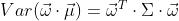

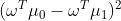

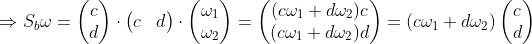

找到一条直线(转为最优化)

什么叫找到一条直线:根据LDA思想,也就是找到这样的直线,使得样本点投影到直线之后,同类样本点接近,异类样本点远离。其实已经化成了一个最优化问题:

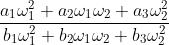

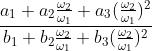

类内散度矩阵与类间散度矩阵

为方便计算

定义“类内散度矩阵” :顾名思义,也就是刻画同类样本点之间“接近”程度的矩阵,下标

:顾名思义,也就是刻画同类样本点之间“接近”程度的矩阵,下标 是

是

定义“类间散度矩阵” :顾名思义,也就是刻画异类样本点之间“远离”程度的矩阵,下标

:顾名思义,也就是刻画异类样本点之间“远离”程度的矩阵,下标 是

是

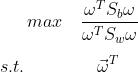

目标函数对 欧米伽大小的无关性

欧米伽大小的无关性

因此该优化问题变为:

该目标函数也称“广义瑞利商”,注意到 和

和 都是

都是 的矩阵,所以目标函数中的分子与分母都是关于

的矩阵,所以目标函数中的分子与分母都是关于

不妨设目标函数的形式为:

其中

其中 ∈

∈

可以化简为:

所以该式与 大小无关,只与

大小无关,只与 方向有关(

方向有关( 确定之后,

确定之后, 的方向也就确定了)

的方向也就确定了)

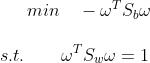

不妨令 ,最优化问题化简为:(为方便之后的拉格朗日乘子法,将最大目标转换为最小目标)

,最优化问题化简为:(为方便之后的拉格朗日乘子法,将最大目标转换为最小目标)

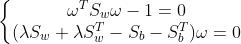

拉格朗日乘子法

使用拉格朗日乘子法:由偏导为0得到两个等式:

由 的定义可知,

的定义可知, ,即他俩是对称矩阵。

,即他俩是对称矩阵。

上式子中 为拉格朗日乘子

为拉格朗日乘子

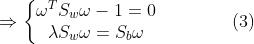

注意到

不妨设

所以 与

与 同向,而上面已经证明了原始目标函数与

同向,而上面已经证明了原始目标函数与 的大小无关,也就是

的大小无关,也就是

大小任取,从而 长度任取,不妨就令:

长度任取,不妨就令:

现将(3)(4)联立解得:

到此整个LDA就做完了。

LDA做法总结

最后再总结一下LDA的结论:

- 计算类内散度矩阵的逆矩阵

- 分别计算两类的样本中心点

- 计算最终找到的这条直线

- 将新样本点投影到求得的

再判断其类别

再判断其类别

如有错漏之处,敬请指正,谢谢!

以上是关于详解线性判别分析(LDA)的主要内容,如果未能解决你的问题,请参考以下文章