[人工智能-深度学习-10]:神经网络基础 - 激活函数之sigmoid与二元逻辑分类的神经元模型

Posted 文火冰糖的硅基工坊

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了[人工智能-深度学习-10]:神经网络基础 - 激活函数之sigmoid与二元逻辑分类的神经元模型相关的知识,希望对你有一定的参考价值。

作者主页(文火冰糖的硅基工坊):文火冰糖(王文兵)的博客_文火冰糖的硅基工坊_CSDN博客

本文网址:https://blog.csdn.net/HiWangWenBing/article/details/120559515

目录

第1章 二元逻辑分类的神经元模型

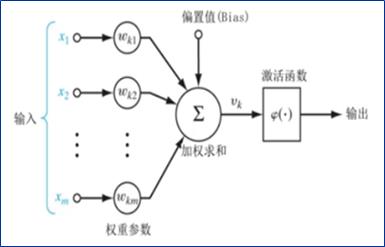

1.1 神经元 + 激活函数模型

在本章,这里的激活函数是sigmoid函数,在其他场合,可以使用其他激活函数。

1.2 神经元的多输入的几何意义

第2章 sigmoid激活函数

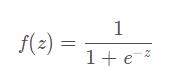

2.1 sigmoid函数的数学表达式

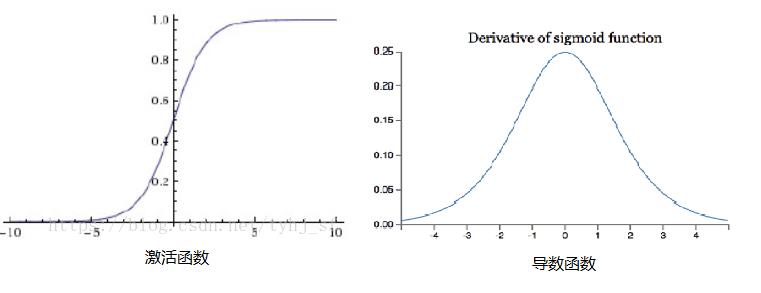

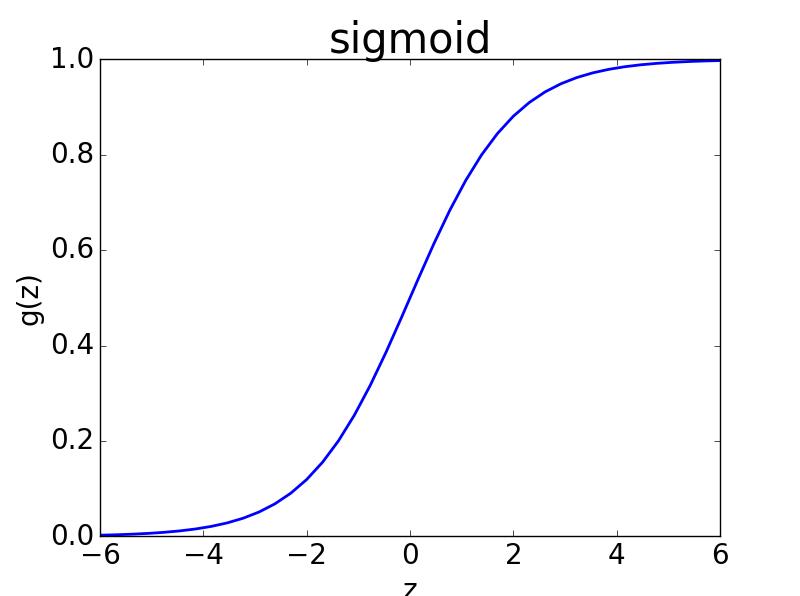

2.2 sigmoid函数的几何图形

- sigmoid是单调变化:变化后的输出序列的顺序关系与输入序列的顺序关系一致

- sigmoid是压缩变换:变化后的空间被压缩到了【0,1】区间

- 其导函数有导数为0的值,用于loss函数时,就是loss函数最小值处。

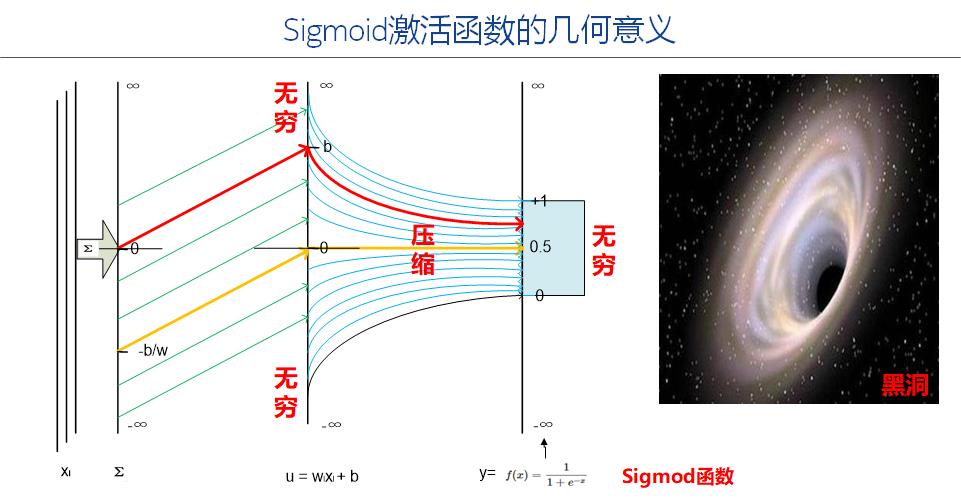

2.3 sigmoid函数的几何意义

(1)输入值X的作用

- 是【-无穷, +无穷数】 值空间的任意值,它代表了输入数据的一个特征值。

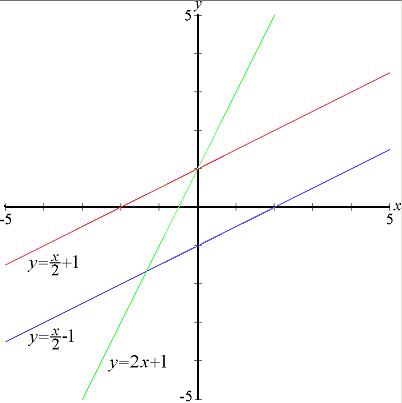

(2)神经元WX+B的作用

- 对输入数据进行线性变换:即放大或缩小(由w决定),或平移(有b决定)

- 线性变化后,输出数据Ui=WXi + Bi依然落在【-无穷, +无穷】数值空间中

- 线性变化得到的输出序列Ui,并没有改变输入数据序列Xi的顺序关系,即单调性关系。

(3)Sigmoid函数作用

- 数据(-无穷, +无穷) 的数值空间压缩成了【0,1】的数值空间,因此是一种压缩变换。

- 压缩后得到的输出序列Yi,并没有改变输入序列Ui的顺序关系,即单调性关系。

(4)总体变化的作用

- 输入序列Xi经过神经元线性变化和sigmoid的压缩变换,由【-无穷, +无穷】到了【0,1】空间。

- 变化前后,输出序列与输入序列具有一致的顺序(排序)关系。

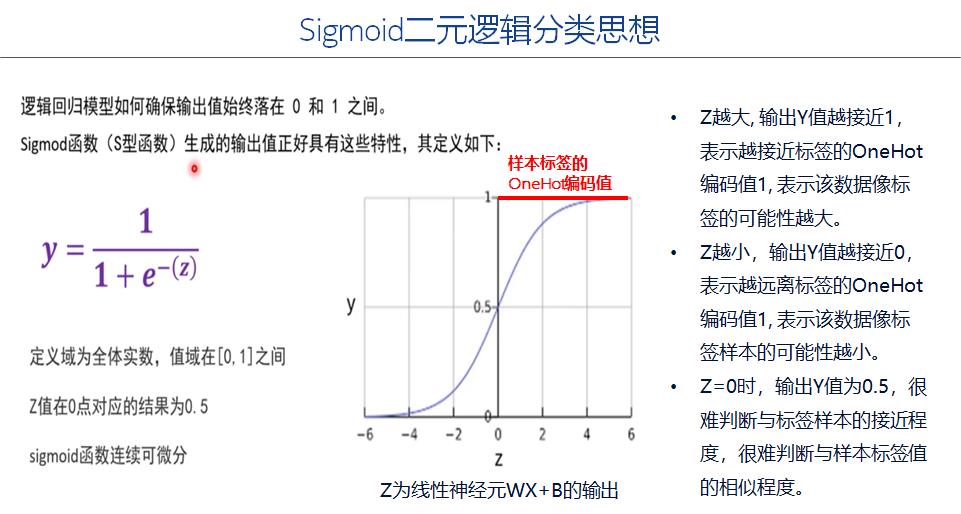

2.4 sigmod实现二元逻辑分类的思想

备注:

二元逻辑分类的样本标签是数值1或0,而不是任意值。

- 1:表示是指定的分类类型

- 0:表示不是指定的分类类型

- 线性神经的输出Z的数值空间为【-无穷,+无穷】,经过sigmoid变换后,转换成了【0,1】区间。

- 由于sigmoid函数是指数变换,当Y接近1时,Z不需要接近+无穷。当Y接近0时,Z不需要接近-无穷。

- sigmoid函数的输出,反应了对输入数据的预测值越接近于该样本数据的标签编码值1,表示与样本标签越接近,相似度越高,这是sigmoid函数一个及其重要的特性,因此在二分类,甚至多分类中得到广泛应用的一个重要的原因。

2.5 sigmoid激活函数的缺点

(1)激活函数计算量大,反向传播求误差梯度时,求导涉及除法。

- 需要大量的指数运算和除法运算,前向传播的计算量偏大。

- 反向传播求导时,该函数本身就包含除法,相比与加法和乘法,运算量偏大。

(2)反向传播时,很容易就会出现梯度消失的情况,从而无法完成深层网络的训练。

这是有sigmoid函数本身的几何特性所决定的,如下图所示。

sigmoid函数在(0,0.5)点为中心,在0附件,无论是上升到1附近的速度或下降为0的速度非常快,在0出,斜率最大,然后快速的下降,很快斜率就下降为0,也就是说,其梯度很快下降为0,导致在训练深层网络时,容易出现梯度消失的情形,无法进行进一步的训练。这是sigmoid函数一个非常大的缺点。

作者主页(文火冰糖的硅基工坊):文火冰糖(王文兵)的博客_文火冰糖的硅基工坊_CSDN博客

本文网址:https://blog.csdn.net/HiWangWenBing/article/details/120559515

以上是关于[人工智能-深度学习-10]:神经网络基础 - 激活函数之sigmoid与二元逻辑分类的神经元模型的主要内容,如果未能解决你的问题,请参考以下文章

吴裕雄--天生自然 神经网络人工智能项目:基于深度学习TensorFlow框架的图像分类与目标跟踪报告

人工智能机器学习深度学习神经网络,都有什么区别,卷积神经网络和全连接神经网络的区别

人工智能机器学习深度学习神经网络,都有什么区别,卷积神经网络和全连接神经网络的区别