深度强化学习的组合优化研究进展

Posted 人工智能博士

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了深度强化学习的组合优化研究进展相关的知识,希望对你有一定的参考价值。

点上方人工智能算法与Python大数据获取更多干货

在右上方 ··· 设为星标 ★,第一时间获取资源

仅做学术分享,如有侵权,联系删除

转载于 :专知

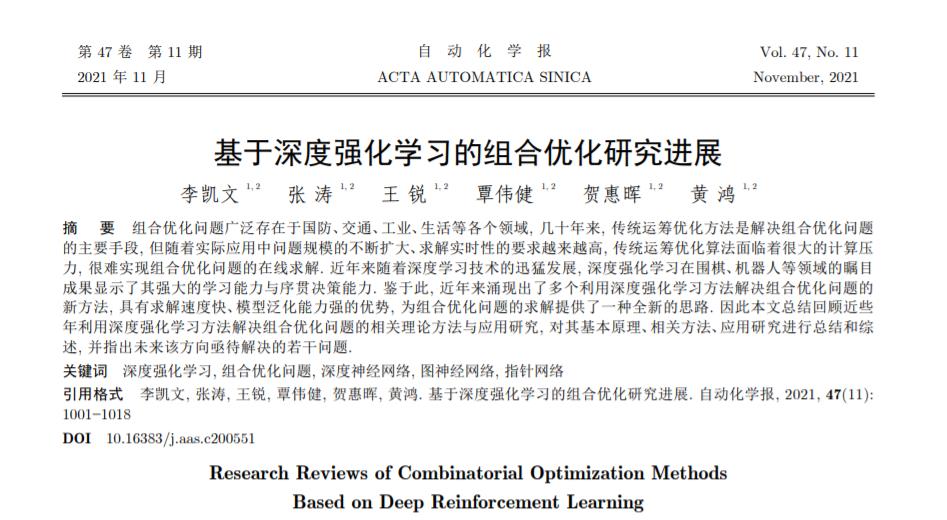

摘要: 组合优化问题广泛存在于国防、交通、工业、生活等各个领域, 几十年来, 传统运筹优化方法是解决组合优化问题的主要手段, 但随着实际应用中问题规模的不断扩大、求解实时性的要求越来越高, 传统运筹优化算法面临着很大的计算压力, 很难实现组合优化问题的在线求解. 近年来随着深度学习技术的迅猛发展, 深度强化学习在围棋、机器人等领域的瞩目成果显示了其强大的学习能力与序贯决策能力. 鉴于此, 近年来涌现出了多个利用深度强化学习方法解决组合优化问题的新方法, 具有求解速度快、模型泛化能力强的优势, 为组合优化问题的求解提供了一种全新的思路. 因此本文总结回顾近些年利用深度强化学习方法解决组合优化问题的相关理论方法与应用研究, 对其基本原理、相关方法、应用研究进行总结和综述, 并指出未来该方向亟待解决的若干问题.

http://www.aas.net.cn/cn/article/doi/10.16383/j.aas.c200551

组合优化问题(Combinatorial optimization problem, COP)是一类在离散状态下求极值的最优化问题, 其数学模型如下所示:

minF(x)s.t. G(x)≥0x∈DminF(x)s.t. G(x)≥0x∈D | (1) |

其中为xx决策变量、F(x)F(x)为目标函数、G(x)G(x)为约束条件, DD表示离散的决策空间, 为有限个点组成的集合. 组合优化问题在国防、交通、产品制造、管理决策、电力、通信等领域都有广泛的应用[1], 常见的组合优化问题包括旅行商问题(Traveling salesman problem, TSP)、车辆路径问题(Vehicle routing problem, VRP)、车间作业调度问题(Job-shop scheduling)、背包问题(Knapsack)、最小顶点覆盖问题(Minimum vertex cover, MVC)、最小支配集问题(Minimum dominating problem, MDP)等.

组合优化问题的特点是其决策空间为有限点集, 直观上可以通过穷举法得到问题的最优解, 但是由于可行解数量随问题规模呈指数型增长, 无法在多项式时间内穷举得到问题的最优解[2], 为此数十年来学者对组合优化问题的求解算法进行了大量的研究, 目前求解组合优化问题的方法主要包括精确方法(Exact approaches)和近似方法(Approximate approaches)两大类:

1) 精确方法是可以求解得到问题全局最优解的一类算法, 主要包括分支定界法(Branch and bound)[1, 3]和动态规划法(Dynamic programming)[4-5], 其均采用分而治之的思想通过将原问题分解为子问题的方式进行求解[2], 通过不断迭代求解得到问题的全局最优解.

2) 近似方法是可以求解得到问题局部最优解的方法, 主要包括近似算法(Approximate algorithms) 和启发式算法(Heuristic algorithms)两类[2]. 近似算法是可以得到有质量保证的解的方法, 包括贪心算法、局部搜索算法、线性规划和松弛算法、序列算法等[6-8]; 启发式算法是利用设定的启发式规则对解空间进行搜索的一类方法, 能够在可行时间内找到一个较好的解, 但是对解的质量没有保证, 文献中用来求解组合优化问题的启发式算法主要包括模拟退火算法[9-10]、禁忌搜索[11-12]、进化算法[13] (如遗传算法[14-15], 差分进化算法[16-17]等)、蚁群优化算法[18-19]、粒子群算法[20-21]、迭代局部搜索[22-23], 变邻域搜索[24-25]等.

精确方法可以求解得到组合优化问题的全局最优解, 但是当问题规模扩大时, 该类算法将消耗巨大的计算量, 很难拓展到大规模问题; 相对于精确方法, 近似方法可以在可接受的计算时间内搜索得到一个较好的解. 基于群体智能的进化方法以及局部搜索等方法都是近年来的研究热点, 但是该类方法都是迭代型优化算法, 当问题规模很大时, 大量的迭代搜索仍然会导致较大的计算耗时, 近似方法仍然很难拓展到在线、实时优化问题. 此外, 一旦问题发生变化, 上述方法一般需要重新进行搜索求解, 或者通过不断试错对启发式规则进行调整以获得更好的效果, 计算成本高.

近年来随着人工智能技术的发展, 深度学习技术已经在很多领域打破了传统方法的壁垒, 取得了令人瞩目的突破性进展. 在计算机视觉领域, 十多年前学者们主要利用人工设计的算法进行特征提取以及图像处理, 但如今深度学习已经成为了当前的核心方法, 深度神经网络(Deep neural networks, DNN)可以自动地对图像的特征进行学习, 代替了人类的手工算法设计. 作为深度学习另外一个重要的分支, 深度强化学习(Deep reinforcement learning, DRL)主要用来做序贯决策, 即根据当前的环境状态做出动作选择, 并根据动作的反馈不断调整自身的策略, 从而达到设定的目标. 近年来深度强化学习在AlphaGo Zero[26]、Atari[27]等问题上的表现显示了其强大的学习能力和优化决策能力.

组合优化即在离散决策空间内进行决策变量的最优选择, 与强化学习的“动作选择” 具有天然相似的特征, 且深度强化学习“离线训练、在线决策” 的特性使得组合优化问题的在线实时求解成为了可能, 因此利用深度强化学习方法解决传统的组合优化问题是一个很好的选择. 鉴于此, 近些年涌现出了一系列利用深度强化学习方法解决组合优化问题的新方法, 在TSP、VRP、Knapsack等组合优化问题上取得了很好的效果. 相对于传统组合优化算法, 基于DRL的组合优化算法具有求解速度快、泛化能力强等一系列优势, 该类方法是近年来的研究热点.

由于基于DRL的组合优化方法是近年来新兴的研究领域, 尚未有文献对该类方法进行系统的研究和综述, 因此本文对近年来利用DRL方法求解组合优化问题的重要模型进行总结回顾, 对该类方法的基本原理进行介绍, 对各个算法的优缺点和优化性能进行总结和比较, 并指出未来该方向亟待解决的若干问题, 旨在为学者在该新兴方向的研究提供指导.

文章的结构组织如下: 第1节首先对基于深度强化学习的组合优化方法进行了概述, 对其产生、历史发展、方法分类以及优缺点进行了介绍; 第2节对基于深度强化学习解决组合优化问题的基本原理进行介绍; 第3节对当前主流的基于深度强化学习的组合优化方法进行了综述, 根据方法的不同类别, 对各个算法的原理、优缺点和优化性能进行了对比介绍; 第4节对该类方法在近年来的应用研究进行介绍; 最后对本文进行总结.

---------♥---------

声明:本内容来源网络,版权属于原作者

图片来源网络,不代表本公众号立场。如有侵权,联系删除

AI博士私人微信,还有少量空位

点个在看支持一下吧

以上是关于深度强化学习的组合优化研究进展的主要内容,如果未能解决你的问题,请参考以下文章