机器学习笔记:Adam

Posted UQI-LIUWJ

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习笔记:Adam相关的知识,希望对你有一定的参考价值。

1 Adam介绍

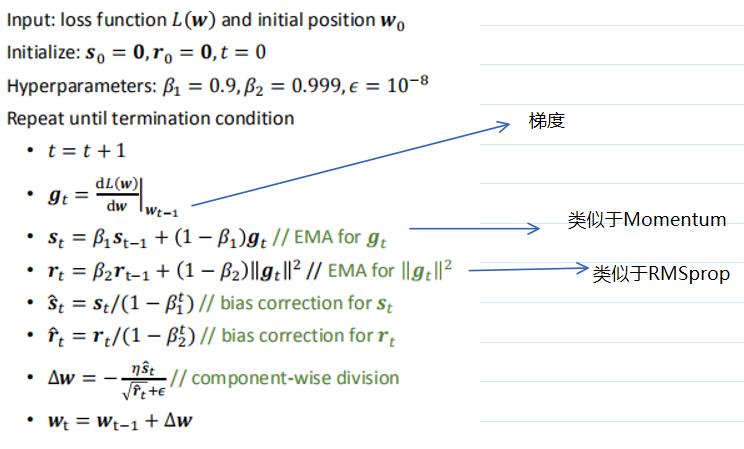

Adam可以想成RMSprop+momentum

怎么记呢?Momentum累加前面是没有分式的,相当于除了1,所以在分子;RMSprop累加式子是在分母的,所以也在分母。

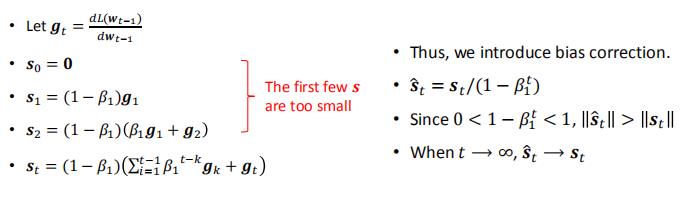

1.1 Bias Correction

2 Adam 特点

2.1 Adam通常在RNN中有很好的performance

2.2 Adam在靠近minimum的地方可能不能很好地收敛

——>靠近minimum的地方,梯度的值很小,因而梯度的平方比梯度更小。所以rt比st还要小,这就导致st除rt的值会较大。即每次变化的幅度会很大——这就可能导致overshooting

解决方法可以是慢慢地减少学习率,或者当快靠近minimum的时候,切换成带momentum的SGD

以上是关于机器学习笔记:Adam的主要内容,如果未能解决你的问题,请参考以下文章

深度学习笔记:优化方法总结(BGD,SGD,Momentum,AdaGrad,RMSProp,Adam)

深度学习笔记:Encoder-Decoder模型和Attention模型