机器学习笔记:RMSProp

Posted UQI-LIUWJ

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习笔记:RMSProp相关的知识,希望对你有一定的参考价值。

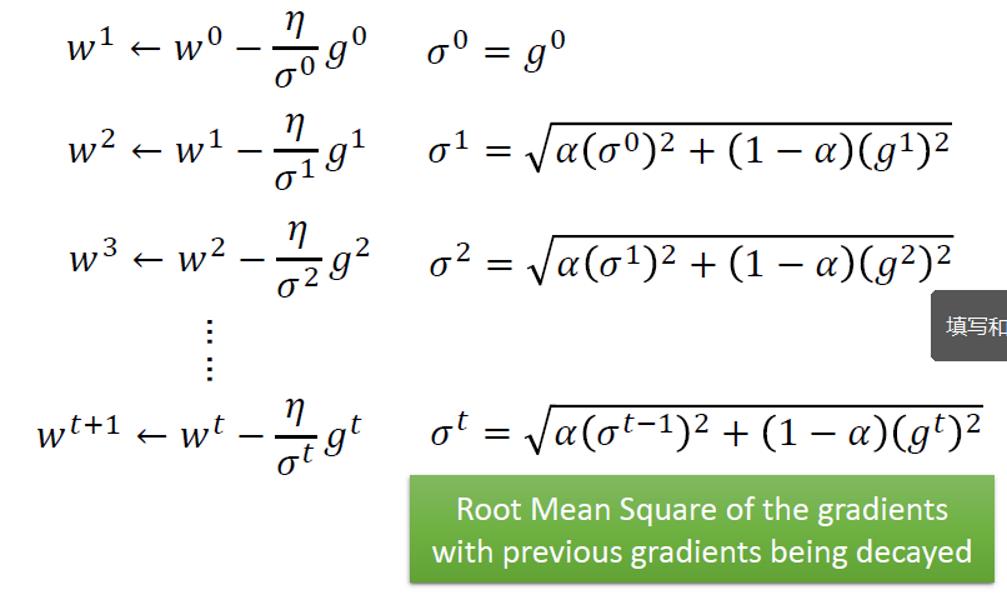

相比于 Adagrad,RMSProp也是整合了所有之前的梯度,但是Adagtad是直接求和,这边是加权求和,每个梯度对应的权重是不相同的

这个值可以手动调整

α越小,表示越相信最新的梯度

和momentum一样,越早的梯度,对于后面的影响越少(指数级减少)

以上是关于机器学习笔记:RMSProp的主要内容,如果未能解决你的问题,请参考以下文章

深度学习笔记:优化方法总结(BGD,SGD,Momentum,AdaGrad,RMSProp,Adam)

深度学习笔记:Encoder-Decoder模型和Attention模型