一流科技CEO袁进辉:人工智能产业化困局和机遇 | 量子位·视点分享回顾

Posted QbitAl

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了一流科技CEO袁进辉:人工智能产业化困局和机遇 | 量子位·视点分享回顾相关的知识,希望对你有一定的参考价值。

主讲人 | 袁进辉 一流科技创始人

量子位 编辑 |公众号 QbitAI

今年以来,有关人工智能产业化的争议成为热门话题,既有来自学术界批评AI“顶不了天,落不了地”、AI科学家从工业界离职回顾学术界等等负面现象,又有多家AI独角兽闯关上市成功的积极鼓舞。

那么,人工智能产业化到底有没有机会?机会又在哪里?

就这些行业热门话题,一流科技创始人袁进辉在「量子位·视点」活动直播中展开了系统的阐述。

以下根据分享内容整理:

前几年,社会对AI曾有过非常狂热的心态。比如有人讨论奇点来临、 AI取代人类、2020年实现全自动驾驶,从业者薪资待遇水涨船高,很多知名教授也也跳到工业界掘金。

但是最近一年,开始有唱衰AI的趋势。AI经历了三起三落,很多人担心的是现在是否又处在低谷?

我认为,必须从人工智能的本质优势和不足去理解,才不会随波逐流,人云亦云,这对AI从业者非常重要。

我们应该有一个基本判断,今天的低谷和以前是不一样的。之前两次AI热潮的确没有解决多大的问题。今天,即使有很多人唱衰,但AI实际上已经解决了很多问题,而且还在向更多的领域进军。

只不过,人们可能过于乐观,对AI期待过高,或者说不切实际,现在我们应该更实际一点,把AI摆在一个客观的、应有的位置。

在这次分享中,我将和大家探讨以下几个问题:

深度学习的本质是什么?

深度学习到底有没有根本性的进步?如果有,进步之处在哪里?

深度学习的局限性是什么?我们不能期待它是一个万金油,什么问题都能解。

深度学习是泡沫还是一次真正的技术革命?

深度学习的产业化机会有没有,它的机会在哪里?

如何准确而客观看待人工智能?

深度学习的本质

深度学习从兴起到现在,将近10年了。刚开始因为获取了一些惊艳的奇效,而被很多人所神话。但是越来越多人熟悉了深度学习,祛魅之后,又开始把它庸俗化,说深度学习其实没什么了不起,就是一个函数拟合。

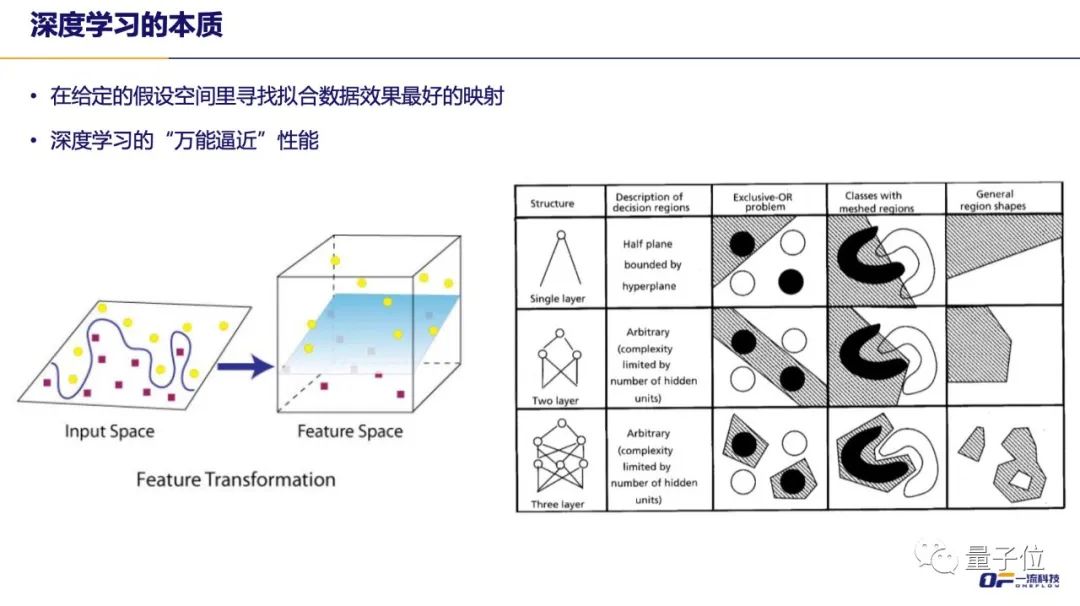

简单来说,深度学习是在一个给定的假设空间里面,寻找对数据拟合效果最好的一个映射,这是个偏数学的定义。以图片分类为例,要训练AI让它能够对摄像机拍出来的图片打标签,看图片里面有没有汽车、人、水果,就是完成一个从图像的像素到语言标签的映射。可选的映射有无穷多种,但最好的实现就是人脑。

所谓拟合,就是希望让计算机在一个映射构成的空间里自动搜索到一个与人脑功能非常接近的映射。深度学习为人们提供了一个非常好的初始搜索空间,也就是多层非线性映射构成函数空间,而且给出了一套在这个空间中自动搜索“最优”映射的算法。

深度学习有一个万能逼近的能力,理论上任何一个映射,不管多复杂,深度学习理论上都有能力去近似它。如上面右图所示,一层感知机模型只能用超平面划分空间,两层神经网络已经可以表示凸多边形了,三层神经网络已经可以表达空洞或凹多边形了。

加上大数据和算力的提升,深度学习一面世就在各个领域打败了传统机器学习算法,把数据驱动人工智能的算法统一为神经网络,也就是完成了算法的标准化。回想一下在深度学习之前,一位人工智能的研究生要学习多少种算法,支持向量机、决策树、隐马尔可夫模型、贝叶斯网络、马尔科夫随机场等等,每个算法背后都有自己的一套数学方法,每个领域都有自己的最有效算法。但是到今天,你会发现所有领域,基本上SOTA算法都是神经网络,而神经网络背后都是BP算法。

所以神经网络和深度学习的厉害之处,在于标准化一统天下。标准化还在发生,甚至不同领域的神经网络结构也在趋同。大家如果关注趋势的话,会发现Transformer开始进入到计算机视觉了,自然语言处理领域也有人开始用卷积网络,神经网络结构越来越简化、统一。

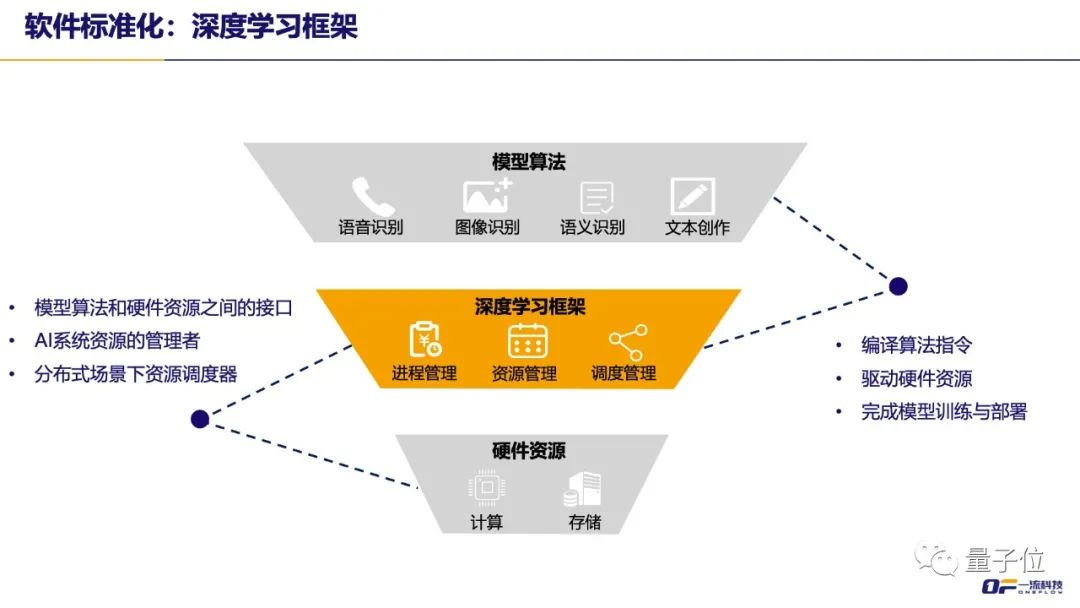

算法标准化最大的好处是,不需要为每个算法都写一套软件,只要一套软件(也就是深度学习框架)就能服务所有领域。

深度学习的局限性

深度学习本质上也是机器学习里的统计学习,所以也有机器学习的局限性。

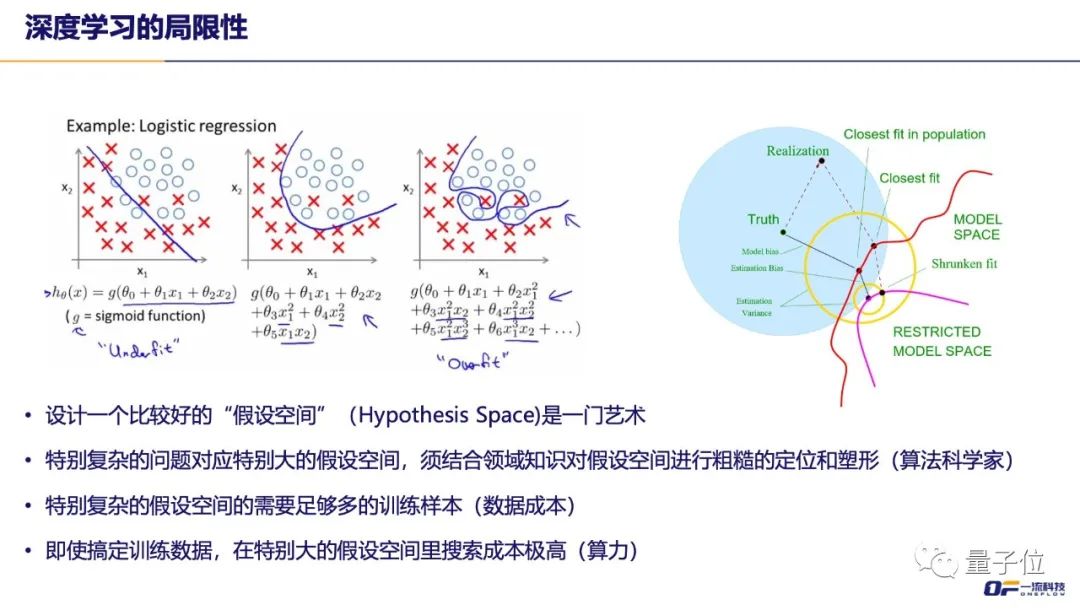

比如,既然深度学习是在一个假设空间(hypothesis space)里去找一个拟合数据质量还比较好的函数,就会出现一个问题:如果预先给定的假设空间里面不包含真实的解,那无论怎么求解都只能找到一个离真正的答案比较近似的解而已,而非最优解。特别是,当真实的解距离这个假设空间很远时,要找到这个近似解也会变得很难。

以左图为例,目标要分清楚圆圈和叉,我们一眼就可以看出最合适解的是一个二次曲线。假如说刚开始限定在线性模型里搜索,那无论如何都只能学出一条线,这就是假设空间太小,欠拟合。给它一个三次方程,理论上有可能学到这个二次方程,算法不一定能找得到。如果一步到位让算法在二次方程里去搜索,当然是最好了。

熟悉机器学习的朋友知道,这是选取假设空间的问题,即算法科学家最核心的工作——给定一个问题,确定一个比较好的算法假设空间,使问题对机器学习来说是可行的。假设空间就像一块大石头,算法科学家就像雕刻家,不断的用刀去削它,把那些没用的石片都砍掉,当剩下的石头比较接近我们想雕刻的目标时,才把石头交给机器去加工和打磨,最终形成一个美妙的雕塑。

同时,深度学习也得符合统计学习的规律——如果这个问题的假设空间非常复杂,就可能需要特别多样本才能指导这个算法收敛到令人满意的解(即样本复杂性问题)。这就影响到了深度学习的成本,收集和标注到足够的数据成本有多高,以及训练模型需要多少算力等等。

通过深度学习本质与局限性的探讨,我们就能理解AI所经历的种种高潮与低谷,即深度学习是有效但并非万能的。因此,在AI发展高潮时,我们不应过于乐观,遭遇低谷时也无须过于悲观。

深度学习是泡沫还是浪潮

那AI到底是一个大潮,还是一个小浪花?我觉得要在一个更大的上下文,也就是信息技术发展的的上下文来理解。

信息技术实质上就是把现实或物理的事物通过建模变成程序代码,然后在计算机里运行来模拟现实世界,因为这个模拟的过程要比现实世界运行更快,成本更低,就可以用模拟结果对现实世界进行预测和反馈。这是计算机能在所有场合给人类带来帮助的本质原因。

以前人们借助计算机解决问题的时候,必须先通过工程师和科学家来理解现实世界的机制,建立一个模型,再表达成程序,这是一种白盒建模方式。建模是用计算机模拟现实世界时最难的步骤。

而AI带来了一种不求甚解的新办法,也就是黑盒建模——只要有足够多的数据,无须人工理解,它能拟合出匹配甚至超越白盒的模型,可以取代白盒方式。

举个例子,不用深度学习,让人去写识别图片的程序,计算机视觉的研究者搞了几十年都没搞定,但深度学习搞定了。这种新的机制,能大大加速现实世界往虚拟世界迁移的进程。我的理解,这是AI和数据驱动的技术带来的最本质进步,从这个角度来说,AI绝对是能载入科技史册的技术进步。

白+黑,深度学习的正确打开方式

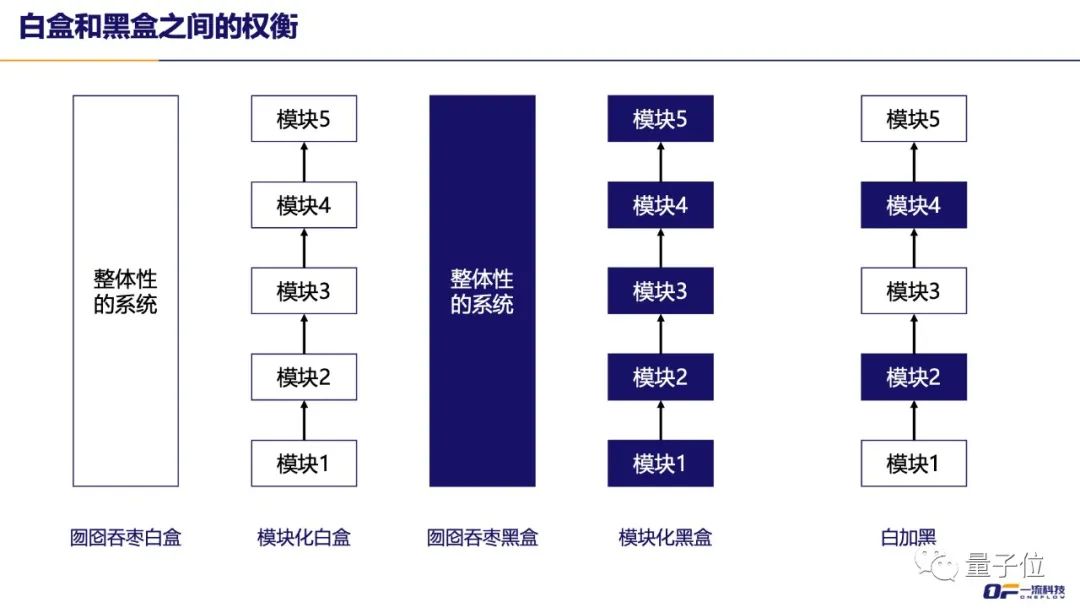

按照搭建信息系统来解决问题的不同手段,我们画一个图。

最左边这两列都是深度学习崛起前的白盒方式,都需要人去写程序。第一种方式是不分模块,囫囵吞枣地去写代码,有编程经验的朋友对这种解法的缺陷有切身体会,软件复杂度超过人的理解能力而失控。所以,实践中会引入非常多的编程技术来克服,面向对象、隔离、解耦、模块化、架构、设计模式等等,也就是第二列所展示的方法。

如果我们对深度学习的能力充满信息,认为无论多难的问题都能学习出来,就会倾向于采用第三个做法,收集到原始的输入和期待的输出构成训练数据,不问青红皂白就直接交给AI来学习。对大部分场景来说,这个方法肯定是过于乐观了。往往是这个问题太复杂,需要的训练数据太多、需要的计算量太大,如果非要在假设空间太大而数据不足的情况下去学习,只能大失所望。

这说明即使拿深度学习来解这个问题,也必须做模块化,把大问题分解成多个小问题,这些小问题之间有特定的组合关系。比如自动驾驶里分解成感知、决策等一系列子问题,每个子问题限制在AI或者深度学习能解决的范畴之内,而不是期待AI能囫囵吞枣地解决整个问题。

在实际场景中,不见得对每个子问题用深度学习都是最优选择。比如有些模块的机理本身已经很清晰,用白盒方式很容易求解(譬如一个数学公式即可),那就没必要杀鸡用牛刀。

所以,最终可能比较合理的解决方案是最右侧展示的“白+黑”的方式。对一个业务来说,业务专家和AI专家合作把问题分解,看什么问题适合AI来解决,什么问题必须用人工去解决,需要作出客观判断与合理选择。

软件2.0:数据编程的时代

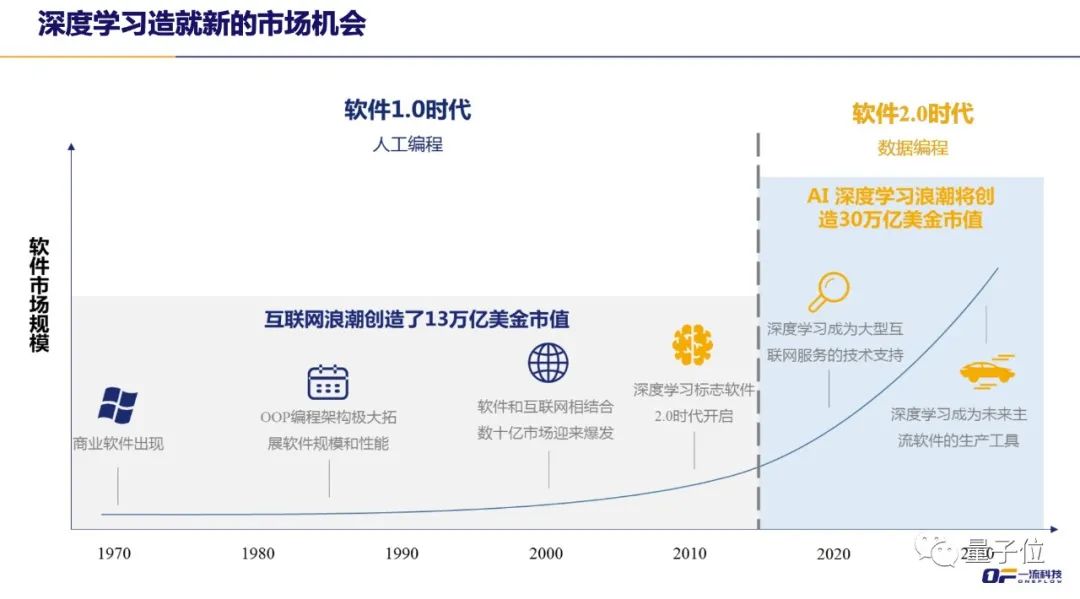

有很多思想领袖对深度学习的价值做了很好的总结和概括。比如特斯拉人AI负责人Andrej Karpathy,他在17年写了篇博客叫《Software 2.0》。他的观点,以前是软件1.0,也就是所有软件都要人写,但现在2.0可以用数据编程的方式来做。

训练神经网络的权重,本质就是在编程。

最近曾经因为赌对了特斯拉、比特币而名噪一时的ARK基金写了一份报告,罗列了他们眼中会影响未来的最重要的一二十项技术,第一项就是深度学习。ARK就从软件2.0数据编程的角度来解释深度学习的重要性,他们预测2037年AI创造的市场价值会超过以前所有信息技术之和,高达30多万亿美金。

总结一下,我们对AI的判断——它是史诗级的技术进步,而且是一种通用的技术,它一定会成为数字化基础设施非常重要的组成部分。从历史的角度,工业革命从蒸汽机到电力突破了人的体力极限,信息技术、AI突破人的脑力极限。所以对AI的技术创造社会价值,我是非常乐观的。AI既有本质优势,也有它的局限性,我们应该对它既不报过高期待,也不过度贬低。

如何预判人工智能产业格局的未来?

最近,产业AI化好像起来了,很多是甲方掌握了场景,加一点AI就取得了很好的效果,这反倒是比较健康的一个模式。我接下来重点聊一下AI产业化,很多技术出身的人在思考这个问题,有一个好锤子,怎么拿它去挣钱?近几年的探索其实是碰了不少壁,主要是AI不够标准化,所以有人说AI不存在标准化的可能性,质疑AI是不是有产业化的机会,我对此是不同意的。

要预测AI产业化的机会,我觉得要从平民化、标准化、自动化、工具化、服务化等角度来看。

人工智能的标准化趋势

AI的标准化趋势其实正在发生。除了算法的标准化,其实还有各个层面的标准化。算法的标准化带来了软件标准化的机会,深度学习框架正在走向标准化,硬件、技术平台、最佳实践也在标准化。

以深度学习框架为例,我们能注意到的一个标准化的趋势是接口的标准化,工程师最喜欢PyTorch的接口算法,我们会发现所有的框架在API设计层面都去学它,各个框架之间有迁移的需求,训练和部署不是用的同一种框架,中间格式的标准化其实也在发生,每个框架自己做的IR都大同小异。

硬件层面,虽然芯片市场也打的如火如荼,但是API设计层面也越来越像。首先大家的API应该会模仿CUDA,图编译器层面也有一些标准化的趋势,有一些通用组件出现,比如MLIR。这些芯片和上层软件对接的接口比较一致,从芯片到集群层面的架构也非常接近。

技术平台的话,有的人会有痛点——如果个人要搞一台服务器去装框架,会发现要处理驱动、版本,装好几个框架,可能还有冲突;训练模型的时候,有一些文件访问可能在别的网络文件系统,如果这个服务器是多个用户共享的话,还要协调时间,可能还涉及到数据权限,文件隔离等等一系列问题。但现在也出现了K8S、Docker这些越来越标准化的解法,有的企业会需要弹性扩容,有的在私有云上去用,有的偶尔需要扩容去公有云用等,这需要多云的支持。

我们探讨深度学习的本质和局限性提到的调参问题,在实际落地业务的时候也会涉及到,比如哪些模块用AI解决,哪些模块不用?要标多少数据,怎么标这些数据?模型用CNN、BERT,还是用Transformer?这样一系列问题,比较大的企业可能已经发现和沉淀出了一些最佳实践,有的东西不需要工程师去重复踩坑。

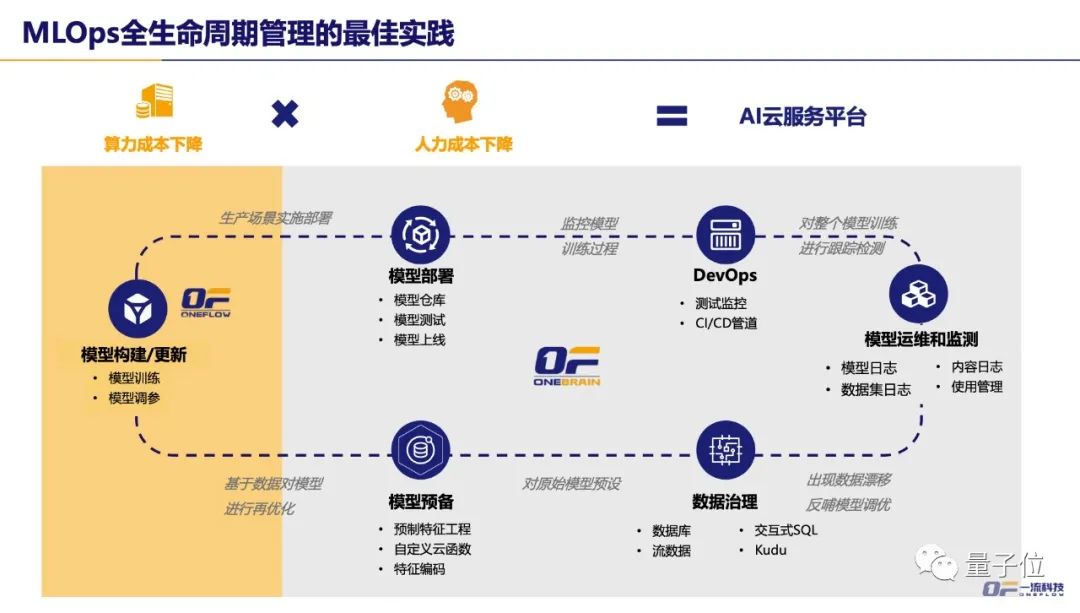

最近有个比较热门的词叫MLOps,一系列原则和理念都准确应对了上面提及的问题。比如,它能自动化,有很多模型、超参,能跟踪每个模型训练中间的结果和过程,能debug,能测试监控可视化,将这些持续集成,训练完之后自动上线。

我们会看到,从数据准备、模型加工到测试监控、资源管理,所有这些标准化之后,在一个平台上就可以完成。算法科学家或业务人员在这样的平台上去工作时,使用最少的算力成本,同时流程又非常科学,工作效率最高,人力成本极大的降低。

我们相信标准化的趋势,从框架标准化到平台标准化、工作流标准化,要在不久的将来,能给企业客户提供一个像现在使用数据库一样的AI产品,传统企业不需要有非常专业的科学家,只要懂接口,通过非常标准化的操作,就能获得 AI的能力。

历史总在重演。数据库几十年的历史形成了非常大的产业,现在结合云又有新的商业机会,数据库经历了什么,对人工智能产业化也很有启发。

最早人们做信息系统时没有数据库,每个信息系统都要单独基于文件系统去研发,后来有人发现不同的信息系统里面有些结构化数据是通用的,增删查改有固定的套路,用关系代数就能描述,关系型数据库就出来了。

如果垂直行业的每家公司都自己去做一套数据库,都要付出很大的研发成本,而且每一家企业都可能做得不太好,就逐渐地出现了专门做数据库的企业。

我们会发现,在每个垂直的行业场景里面有类似的业务需求,需要搭建各种信息系统。这个信息系统从哪采购?有两个渠道,一个是专门做数据库的企业,一个是做数据库和用户特定需求结合的信息系统集成,比如财务、人力、供应链等,这样的中间企业出现了很多。

专做数据库的出现了一些大企业,比如Oracle、IBM、微软,现在数据库开始往云原生的数据仓库发展,中间的集成商也出现了标准化的机会,原来一套软件都是用授权的方式到各个企业去卖,可能涉及到一些定制化,用户的粘性也不够强。现在,如果所有客户业务都上云,它可以在云上提供标准化的产品和服务,这个时候出现了做垂直应用集成的比较大的SaaS企业。

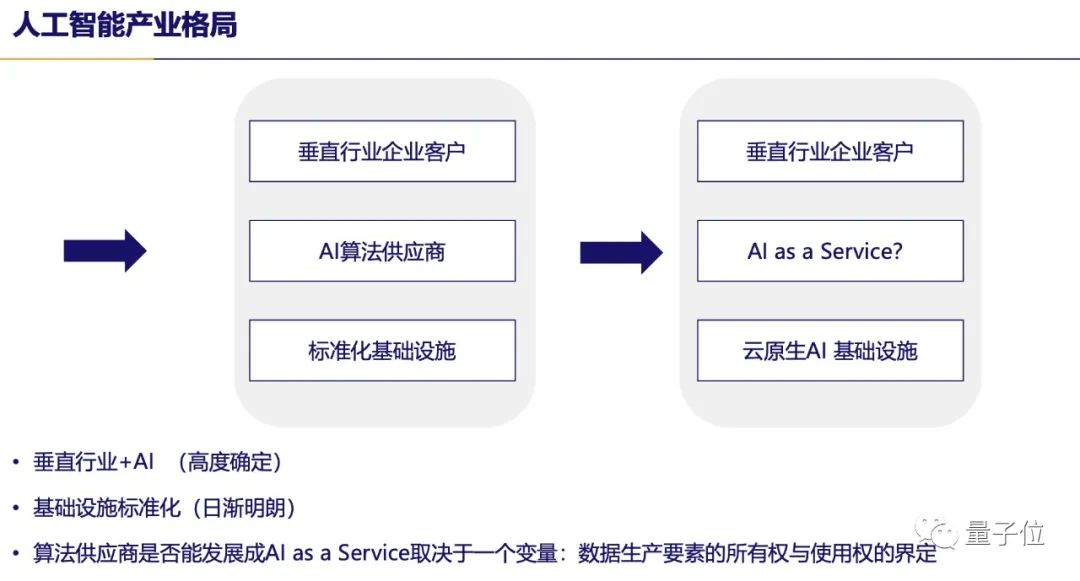

按照数据库产业的发展历程,实际上分了三层,AI会不会也分这么三层?我们可以看到,前几年最活跃的是AI算法供应商层,非常像数据库领域,SaaS出现之前的系统信息的集成商,壁垒较低,也不够标准化,有朝一日,是不是也能实现标准化,实现AI as a service的模式。

以前整个行业忽视的是最底层的标准化基础设施,但随着中间算法供应商模式受阻,以及标准化行程的演进,最近一年越来越受到关注,人工智能产业格局的趋势越来越明朗。

观点总结

最后,总结一下我的观点:

1、深度学习的本质是提供了一种黑盒建模的方式。正是因为黑盒特性,才可以标准化,才能在任何地方都能用;如果它是可解释的白盒,也就意味着它和每个领域相关,标准化程度可能就降低了。

2、相对于传统机器学习,深度学习最大的进步就是标准化,标准化带来了产业化的机会。它的局限性是什么?需要预先给定合适的假设空间,否则就可能出现像钥匙掉在黑暗处,却在路灯下寻找的尴尬。

3、站在数据编程软件2.0的角度,AI是一个技术革命,不是一个泡沫。

4、未来的AI产业格局,很可能向数据库这种分层的专业化分工趋势发展。所以,我们相信会出现标准化的基础设施的市场机会,这种机会在前几年算法集成大红大紫的背景下被人们忽略掉了。

5、AI产业化机会在于标准化的基础设施和云原生的趋势。

关于量子位·视点

量子位发起的CEO/CTO系列分享活动,不定期邀请AI创业公司CEO或CTO,分享企业最新战略、最新技术、最新产品,与广大AI从业者、爱好者探讨人工智能的技术理论与产业实践,欢迎大家多多关注~

最后,直播回放请戳链接或阅读原文:https://www.bilibili.com/video/BV1eL4y1a7SV/

以上是关于一流科技CEO袁进辉:人工智能产业化困局和机遇 | 量子位·视点分享回顾的主要内容,如果未能解决你的问题,请参考以下文章

如何轻松训练大模型?来NVIDIA GTC,听OneFlow的解决方案