Bagging和Boosting的区别

Posted AI算法攻城狮

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Bagging和Boosting的区别相关的知识,希望对你有一定的参考价值。

Baggging 和Boosting都是模型融合的方法,可以将弱分类器融合之后形成一个强分类器,而且融合之后的效果会比最好的弱分类器更好。

国内,南京大学的周志华教授对集成学习有很深入的研究,其在09年发表的一篇概述性论文

《Ensemble Learning》论文链接:https://cs.nju.edu.cn/zhouzh/zhouzh.files/publication/springerEBR09.pdf

对这两种集成学习框架有了明确的定义

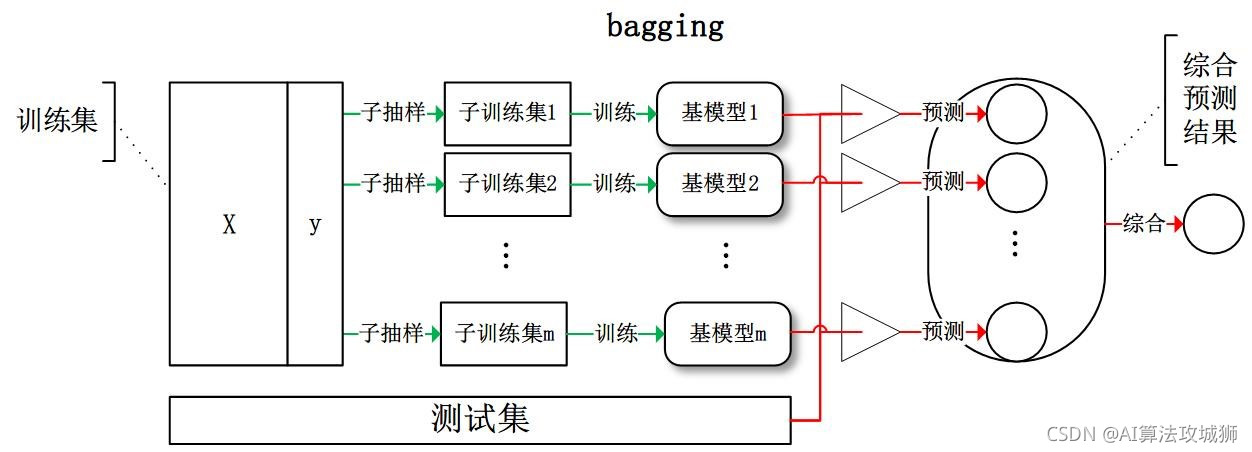

Bagging:

从训练集从进行子抽样组成每个基模型所需要的子训练集,对所有基模型预测的结果进行综合产生最终的预测结果

Bagging即套袋法,其算法过程如下:

-

从原始样本集中抽取训练集。每轮从原始样本集中使用Bootstraping的方法抽取n个训练样本(在训练集中,有些样本可能被多次抽取到,而有些样本可能一次都没有被抽中)。共进行k轮抽取,得到k个训练集。(k个训练集之间是相互独立的)

-

每次使用一个训练集得到一个模型,k个训练

以上是关于Bagging和Boosting的区别的主要内容,如果未能解决你的问题,请参考以下文章

Logistic Regression 模型和 Ensemble 模型(Bagging 和 Boosting)之间没有区别