如何快速搭建云原生企业级数据湖架构及实践分享

Posted 阿里云云栖号

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了如何快速搭建云原生企业级数据湖架构及实践分享相关的知识,希望对你有一定的参考价值。

简介: 众所周知,数据湖技术在大数据领域炙手可热,随着在云上的广泛部署和应用,其业务价值逐渐获得业界共识。如何快搭建数据湖架构被越来越多的企业探讨。本文主要分享快速搭建云原生企业级数据湖架构及实践分享。

王震,阿里云计算平台事业部 开源大数据平台 技术专家

本文根据王震在 2021开源大数据技术线上Meetup#0821 分享整理

内容框架:

- 背景介绍

- 如何使用 DLF数据湖

- 实操演示

一、背景介绍

什么是数据湖

数据湖:以一定规则形式存储各种类型的数据

- 结构化数据( Orc 、Parquet )

- 半结构化数据 ( Json 、Xml )

- 非结构化数据(图像 、视频)

为什么需要数据湖

1、数据规模进一步扩大

- 大数据存储需要治理

- 数据治理需要厘清数据依赖关系(血缘)

- 用户需要明确大数据整体成本(TCO)

2、数据来源多样化

- 事务数据(mysql, SqlServer)

- 搜索数据 (SOLR)

- 批处理数据 (SPARK, HIVE)

3、数据格式多样化

- Parquet / Orc / Avro / Csv / Json / Text

4、数据分析场景多样化

- 基于语义的搜索分析

- 随机/近实时 OLAP 分析

5、数据分析用户多元化

- 分析用户角色多元化 (开发/测试/数据/BI)

- 用户数据访问合规管控诉求

数据湖能做什么

1、针对数据规模进一步扩大

- 数据湖提供 【数据血缘】服务

- 数据湖提供 【数据治理】服务

- 数据湖帮助用户明确大数据的整体成本

2、针对数据来源多样化

- DLF 提供【统一元数据】服务

• 解决多引擎元数据一致性问题

• 解决元数据使用和维护成本问题

3、针对数据格式多样化

- DLF 提供【数据入湖/元数据爬取】服务

• 支持 MYSQL/KAFKA 入湖,元数据爬取

• 支持离线/实时入湖, 满足不同业务时效要求

• 支持 DELTA/HUDI 等数据湖格式

4、针对数据分析场景多样化

- DLF 提供【统一元数据服务】

• 可以切换不同引擎 MC/EMR/DDI

• 数据探索在不同引擎之间一致

5、针对数据分析用户多元化

- 数据湖提供【访问权限控制】服务

• 多引擎下的数据访问集中授权/避免反复授权

• 解决多用户数据访问合规问题

- 数据湖提供【访问日志审计】服务

• 解决用用户数据访问合规审查问题

二、如何使用 DLF 数据湖

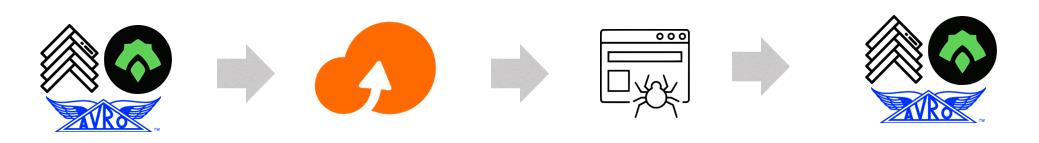

数据入湖

1、大量异构外部数据源【数据入湖】服务

- 全量导入 : 批量入湖一次导入

- 增量导入 : 实时入湖流失增量导入

2、大量现存Hadoop生态数据 【元数据爬取】服务

- 将数据导入数据湖OSS进行存储

- 元数据爬取 提取原有数据schema

数据查询

数据湖【统一元数据】服务支持多种引擎查询

- 使用数据探索(SPARK)对入湖数据进行探查

- 使用MAXCOMPUTE对数据进行深度复杂加工

- 使用Databricks DDI专用集群对数据进行探索

- 更多引擎支持中…

数据治理

一、使用【权限访问控制】服务控制数据访问

- 进行 库/表/列 级别的访问权限设置

- 统一的元数据,只需要设置一次

二、使用【数据治理】服务明确大数据总成本

- 日/周/月 级别的存储使用情况 – 及时释放过时的大存储文件

- 日/周/月 级别的计算使用情况 – 及时识别数据上的异常计算

三、实操演示

数据湖构建 DLF 体验链接:https://dlf.console.aliyun.com/

本文为阿里云原创内容,未经允许不得转载。

以上是关于如何快速搭建云原生企业级数据湖架构及实践分享的主要内容,如果未能解决你的问题,请参考以下文章

如何基于MaxCompute快速打通数据仓库和数据湖的湖仓一体实践