《深度学习》李宏毅 -- task5网络技巧设计

Posted GoAl的博客

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了《深度学习》李宏毅 -- task5网络技巧设计相关的知识,希望对你有一定的参考价值。

本文参考:https://blog.csdn.net/LucyLuo2020/article/details/118916216

Datawhale深度学习资料:https://datawhalechina.github.io/leeml-notes

https://blog.csdn.net/gwpjiayou/article/details/104308704

一、梯度下降法的局限

局部最小值saddle point和鞍点local minima

优化(Optimization)损失函数失败的原因主要有2种:

1.局部最小值 (local minima),无路可走。

2.鞍点 (saddle point),还可以继续梯度下降。

最好先知道损失函数的形状,才能更好的解决上面的问题。

二、分批(Batch) 和动力(Momentum)

2.1 Batch

分批处理(Batch),也称为批处理脚本,是对某对象进行批量的处理,可以减少运算时间。

分批处理可以减少运行时间,快速达到目标。

每次分批训练有时优于一整批次训练,因为它可以快速找到目标。

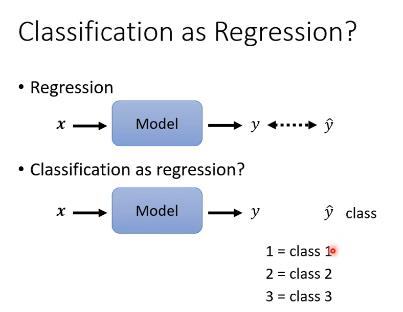

四、分类

分类问题是得到一个一个的值,跟回归问题不一样。

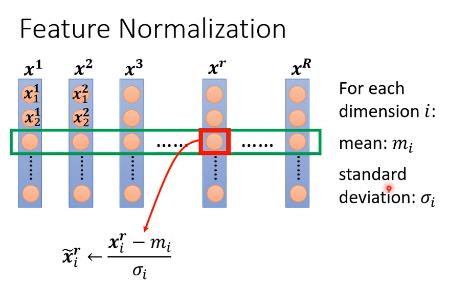

通常会把数据进行归一化处理后再分类。

五、分批标准化

分批次训练模型时,若某批次数据很小,乘以一个大底系数,变化量也是很小的,若某批次数据很大,即使乘以一个非常小的参数,数据变化也是很大的,那么在一起训练时不好处理,所以先将数据标准化,那么数据就没有什么差异。

以上是关于《深度学习》李宏毅 -- task5网络技巧设计的主要内容,如果未能解决你的问题,请参考以下文章

李宏毅《机器学习》丨5. Tips for neural network design(神经网络设计技巧)

李宏毅2021机器学习深度学习6-1 生成式对抗网络GAN1 基本概念介绍