大数据技术之DataX

Posted 脚丫先生

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了大数据技术之DataX相关的知识,希望对你有一定的参考价值。

大家好,我是脚丫先生 (o^^o)

在日常大数据生产环境中,经常会有关系型数据库和关系型数据库,以及关系型和非关系型数据库数据的互相转换的需求,在需求选择的初期解决问题的方法----离线数据同步工具/平台,小伙伴们可先收藏后慢慢研究。

小伙伴们如果觉得文章不错,点赞、收藏、评论,分享走一起呀,记得给俺来个一键三连~~

好了,我们开始今天的正文。

文章目录

一、Datax概述

1.1 Datax介绍

DataX 是阿里巴巴开源的一个异构数据源离线同步工具,致力于实现包括关系型数据库(mysql、Oracle等)、HDFS、Hive、ODPS、HBase、FTP等各种异构数据源之间稳定高效的数据同步功能。

1.2 DataX的设计

为了解决异构数据源同步问题,DataX将复杂的网状的同步链路变成了星型数据链路,DataX作为中间传输载体负责连接各种数据源。当需要接入一个新的数据源的时候,只需要将此数据源对接到DataX,便能跟已有的数据源做到无缝数据同步。

1.3 框架设计

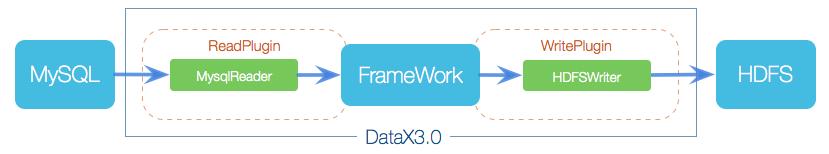

DataX本身作为离线数据同步框架,采用Framework + plugin架构构建。将数据源读取和写入抽象成为Reader/Writer插件,纳入到整个同步框架中。

DataX在设计之初就将同步理念抽象成框架+插件的形式.框架负责内部的序列化传输,缓冲,并发,转换等而核心技术问题,数据的采集(Reader)和落地(Writer)完全交给插件执行。

- Read 数据采集模块,负责采集数据源的数据,将数据发送至FrameWork。

- Writer 数据写入模块,负责不断的向FrameWork取数据,并将数据写入目的端。

- FrameWork 用于连接reader和write,作为两者的数据传输通道,处理缓冲,流控,并发,转换等核心技术问题。

1.4 DataX插件体系

DataX目前已经有了比较全面的插件体系,主流的RDBMS数据库、NOSQL、大数据计算系统都已经接入,目前支持数据如下图,详情请点击:DataX数据源参考指南

1.5 运行原理

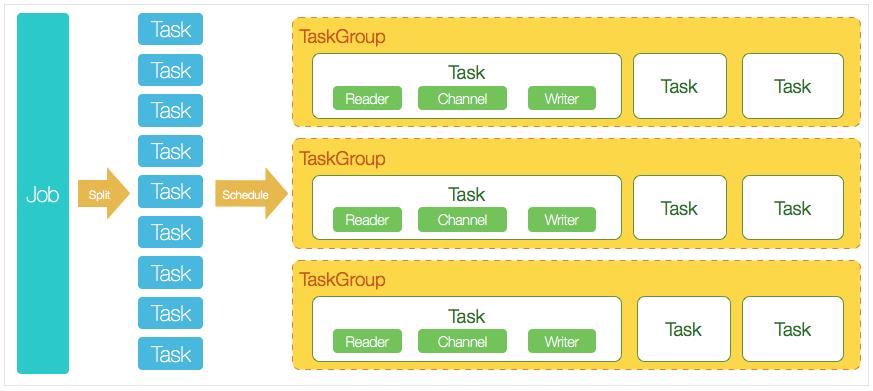

- Job 完成单个数据同步的作业称之为job。DataX接受到一个Job之后,将启动一个进程来完成整个作业同步过程。负责数据清理,子任务划分,TaskGroup监控管理。

- Task 由Job切分而来,是DataX作业的最小单元,每个Task负责一部分数据的同步工作。

- Schedule 将Task组成TaskGroup,默认单个任务组的并发数量为5。

- TaskGroup 负责启动Task。

二、快速入门

2.1 官方地址

下载地址:http://datax-opensource.oss-cn-hangzhou.aliyuncs.com/datax.tar.gz

源码地址:https://github.com/alibaba/DataX

2.2 前置要求

- Linux

- JDK(1.8以上,推荐1.8)

- Python(推荐Python2.6.X)

2.3 安装

(1) 将下载好的datax.tar.gz上传到服务器的/home/soft文件夹下

[root@xxx soft]$ ls

datax.tar.gz

(2) 解压datax.tar.gz到/opt/module

[root@xxx soft]$ tar -zxvf datax.tar.gz -C /opt/module/

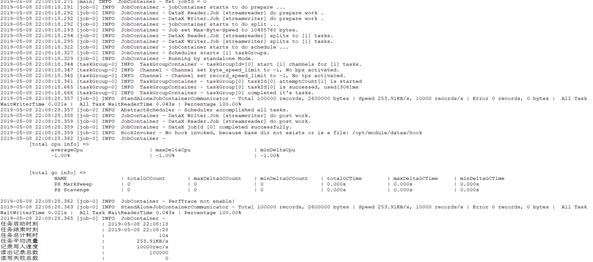

(3) 运行脚本检测

[root@xxx bin]$ cd /opt/module/datax/bin/

[root@xxxbin]$ python datax.py /opt/module/datax/job/job.json

总结

接下来继续以案例的形式分享,包括结构数据库,文件,时序,datax-web等。

以上是关于大数据技术之DataX的主要内容,如果未能解决你的问题,请参考以下文章