AI简报20210716期上海张江又一款AI芯发布寒武纪切入自动驾驶芯片

Posted RT-Thread物联网操作系统

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了AI简报20210716期上海张江又一款AI芯发布寒武纪切入自动驾驶芯片相关的知识,希望对你有一定的参考价值。

AI 芯片

1. 上海张江又一款AI芯发布!性能超英伟达T4,AMD背景团队创办,快手投资

原文:

https://mp.weixin.qq.com/s/ufZ1M2B819_O_JHSIzQhfg

AI芯片公司瀚博半导体,发布了云端推理AI芯片SV100系列,以及搭载该系列芯片的AI推理加速卡VA1。

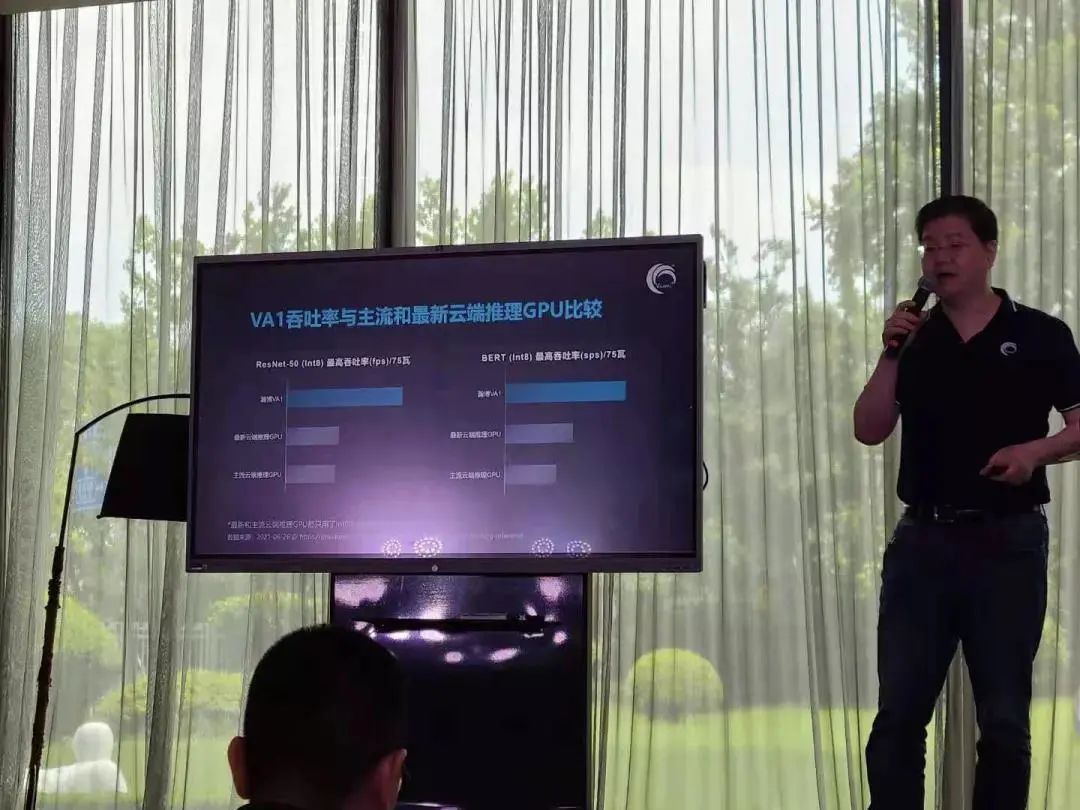

SV100系列是瀚博为云端推理而打造的服务器芯片,SV102是该系列的第一款芯片,INT8峰值算力达到200TOPS。瀚博半导体创始人兼CEO钱军表示,SV102具有超高推理性能、超低延时以及高密度视频解码等特点。SV102支持64路1080p视频解码,最大功耗为75W,接口为PCIe Gen4 x16,采用被动散热。这款芯片在今年6月刚刚测试成功。据钱军透露,SV100在开始测试之后8分钟就全部点亮,低于40小时之内所有模块基础测试提前完成。

而搭载SV102的VA1采用单宽半高半长75瓦PCIe卡设计,因此相比一般的GPU卡更节省能耗与空间。张磊表示,在ResNet-50的基准测试中,VA1是英伟达T4吞吐量的2倍以上。由于VA1节省服务器50%以上TCO,因此在一个2U服务器中,搭载VA1的设备可以解码384路视频,整机算力是T4设备的2.5倍以上,功耗比相同搭载GPU的服务器更低,可节省60%的服务器成本。在视频处理方面,VA1支持64路以上H264、H265或AVS2 1080p解码,分辨率支持高达8K。除了硬件产品外,瀚博也搭建了自己的VastStream AI软件平台,支持PyTorch、TensorFlow等主流AI框架,目前正在与CentOS、Ubuntu、Red Hat、银河麒麟等服务器操作系统进行适配。

2. 单颗算力200TOPS、7nm、车规级!寒武纪切入自动驾驶芯片

原文:

https://mp.weixin.qq.com/s/YJy1_I3D6J7kNYLKbrxvrg

在刚刚结束的2021世界人工智能大会上,寒武纪创始人兼CEO陈天石透露正在设计一款算力超200TOPS智能驾驶芯片,该芯片继承寒武纪一体化、统一、成熟的软件工具链,采用7nm制程,拥有独立安全岛,符合车规级标准,其定位为“高等级自动驾驶芯片”。

200TOPS什么概念?

说起自动驾驶,大家首先想到的就是特拉斯,因为它是自动驾驶的头号选手。自动驾驶最核心的硬件就是自动驾驶的芯片,它是自动驾驶的心脏,自动驾驶芯片的特点就是高算力,它的单位是tops,1tops就等于每秒运行1万亿次。随着自动驾驶级别越来越高,自动驾驶的芯片的算力也越来越强!目前在售车型里,特拉斯的自动驾驶芯片算力最强,特斯拉HW3.0,单芯片算力72tops,目前特拉斯旗下所有车型均采用双芯片方案,算力高达144tops。

期待该自动驾驶芯片量产的那一天的到来!

AI前沿

3. 圆形的CNN卷积核?清华黄高团队&康奈尔提出圆形卷积,进一步提升卷积结构性能!

原文:

https://mp.weixin.qq.com/s/yAj-TpYiCH1wC6jlSs_hRg

论文:

https://arxiv.org/abs/2107.02451

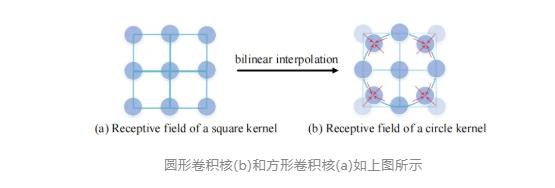

目前正常卷积的感受野大多都是一个矩形的,因为矩形更有利于储存和计算数据的方便。但是人的视野范围更像是一个圆形的。由此作者就思考能不能将卷积核的感受野变成圆形呢?作者通过一系列实验,发现了圆形的卷积核确实比方形的卷积效果会更好。

因此,受人眼视觉系统感受野的启发,作者就想能不能提出一个圆形的卷积操作,相比于矩形的卷积,圆形的卷积核主要有以下几个优点:

圆形卷积核的感受野和生物视觉的感受野更加相似;

卷积核的感受野通常应该是各个方向都是对称的,这样可以适应全局或者局部输入特征在不同方向上的信息变化,圆形卷积核具备这个性质,但是矩形卷积核只在固定的几个方向是对称的;

之前也有工作表明,矩形卷积核的有效感受野更加接近圆形的高斯分布。

最终,作者并没有采用了单独的圆形卷积,而是采用一种圆形和方形集成的卷积,并在训练过程中采用自适应的卷积核大小(也就是说,每个集成的卷积核都有一对方核和圆核。这两个核共享权值矩阵,但有不同的变换矩阵 )。

最终作者在分类任务的三个数据集ImageNet,CIFAR-10,CIFAR-100上做了实验,在不同baseline结构上,方形和圆形集成的卷积核相比于baseline都有明显的性能提升。测试结果在MobileNetV3-Small上提高了5.20%的top-1准确率,在MobileNetV3-Large上提高了2.16%的top-1准确率。

4. AI医疗版App Store来了:GE发布“爱迪生魔盒”,集成各方医疗方案,李开复点赞

原文:

https://mp.weixin.qq.com/s/LwkzSx8WpcIoJFGpnRKe-g

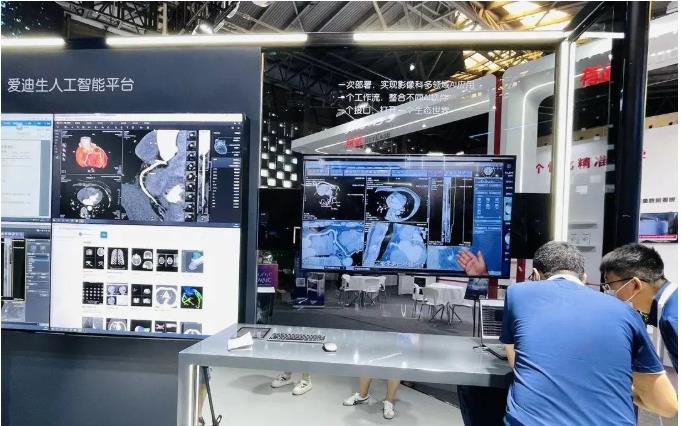

在2021年世界人工智能大会上,国际顶级医疗设备厂商GE医疗给出了AI医疗行业的App Store,这家公发布了一站式、跨品牌的集成AI平台——爱迪生魔盒。

爱迪生魔盒已经与多家本土AI医疗软件开发企业合作,包括医准智能、数坤科技、强联智创、安德医智、深睿医疗、推想医疗、科亚医疗,此外GE医疗还与创投机构创新工场合作,共同拓展爱迪生魔盒的应用生态。GE医疗从医院用户的需求出发,集成了国内多家AI医疗应用,一次性将多病种AI应用给到医院。在与某三甲医院进行合作中,GE医疗于2020年引入医准智能胸部CT多病种智能分析系统。从2020年3月至今,该AI辅诊系统已完成120万例肺癌筛查。

目前,“爱迪生魔盒”平台可实现:1、一次部署,实现影像科多领域AI应用;2、一个工作流,整合不同厂商AI软件;3、一个接口,打开一个生态世界。医生再也需要不断切换工位、硬件以及操作界面才可完成工作了。只需要采购一次硬件,就能使用不同厂商、针对不同疾病的AI医疗技术,提升效率降低成本,解决了当前医院应用医疗AI实际存在的痛点。

5.【重磅发布】中国信通院联合京东探索研究院发布《可信人工智能白皮书》

原文:

https://mp.weixin.qq.com/s/Yasxkr85ODAfQ_CXaJ2tNg

面对人工智能引发的全球信任焦虑,发展可信人工智能已经成为全球共识。2019年6月,二十国集团(G20)提出“G20人工智能原则”,强调要以人为本、发展可信人工智能,这一原则也得到了国际社会的普遍认同。欧盟和美国也都把增强用户信任、发展可信人工智能放在其人工智能伦理和治理的核心位置。将抽象的人工智能原则转化为具体实践,落实到技术、产品和应用中去,是回应社会关切、解决突出矛盾、防范安全风险的必然选择,是关系到人工智能长远发展的重要议题,也是产业界急需加快推进的紧迫工作。

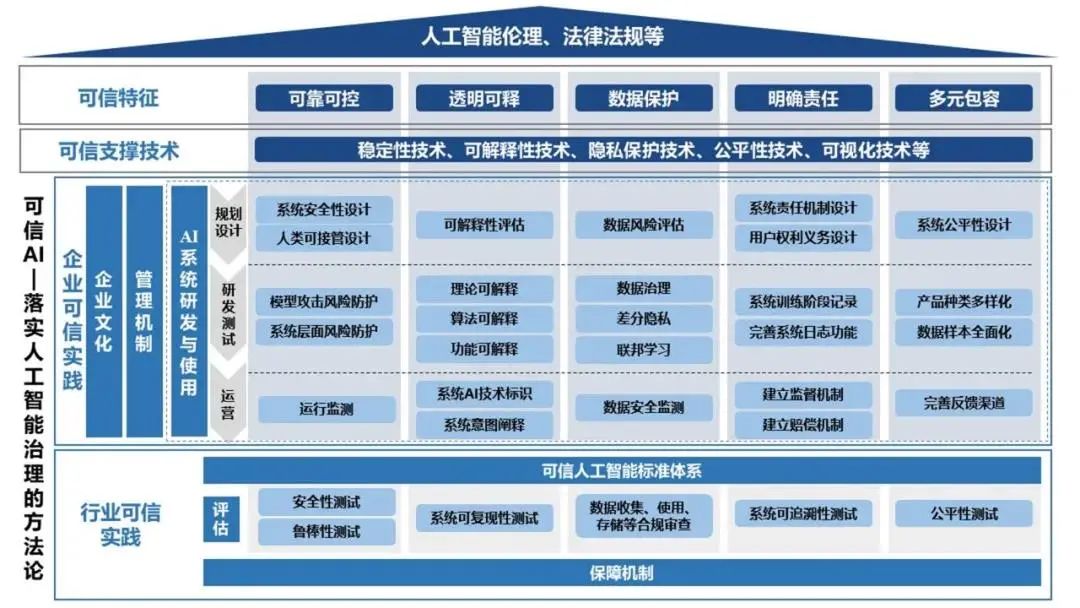

2021年7月8-10日,世界人工智能大会于上海举办。作为世界人工智能大会的主题论坛之一,可信AI论坛于7月9日在上海世博中心金厅成功召开。论坛由世界人工智能大会组委会办公室主办;中国信息通信研究院(简称“中国信通院”)、京东探索研究院承办。论坛上发布了由中国信通院与京东探索研究院联合撰写的国内首本《可信人工智能白皮书》,白皮书从如何落实全球人工智能治理共识的角度出发,聚焦于可信人工智能技术、产业和行业实践等层面,分析了实现可控可靠、透明可释、隐私保护、明确责任及多元包容的可信人工智能路径,并对可信人工智能的未来发展提出了建议。

下图给出了可信人工智能的总体框架。

6. NLP界新SOTA!吸纳5000万级知识图谱,一举刷爆54个中文任务!

原文:

https://mp.weixin.qq.com/s/VbkPCJOZS0fpmLToH4OLjQ

论文:

https://arxiv.org/pdf/2107.02137.pdf

近期, 百度新发布了ERNIE 3.0模型。ERNIE 3.0没有选择一味的比拼模型规模,而是巧妙地将包含5000万+实体知识的大规模知识图谱融合到百亿级参数规模的超大规模模型中,并通过数据规模、多样性、质量的提升,以及模型结构与训练方式的框架级改进,使得模型全面屠榜了各大中文NLP任务!还顺便登顶了GLUE、SuperGLUE两大NLP权威榜单…

提到预训练模型的效果测评,就不得不提到 SuperGLUE Benchmark 。SuperGLUE是由谷歌DeepMind、Facebook 研究院、纽约大学、华盛顿大学等多个权威机构联合发布的复杂语言理解任务评测,旨在解决常识推理、因果判断、上下文消歧、指代消解等对于人工智能系统更为复杂任务,相对于GLUE等权威经典评测挑战更大。在这份业界公认的“地狱级GLUE榜单”上,百度ERNIE3.0以 90.6 的分数击败Google T5、微软DeBERTa、OpenAI的GPT-3等强队,以超越人类水平0.8个百分点的成绩成功实现登顶!除了SuperGLUE榜单外,在NLP经典权威榜单GLUE上,百度ERNIE同样稳居第一。

为了证明模型的通用性,ERNIE 3.0竟然一口气刷新了50多个中文NLP任务。其中涵盖了情感分析、观点抽取、阅读理解、文本摘要、对话生成等NLP经典任务。例如,基于ERNIE 3.0进行下游任务finetune后,有20几个NLP任务取得了3%以上的显著提升。

为了更好的融合知识,让模型同时具备语言理解和语言生成的能力,ERNIE 3.0还融合了自编码和自回归两种范式进行统一预训练,使得模型兼具语言理解、生成与知识记忆能力。ERNIE 3.0也延续了ERNIE 2.0使用的持续学习范式,整个框架可通过引入新的预训练任务和新的任务模型网络,实现模型持续学习,进而解决新的任务。

由此可见,ERNIE 3.0框架的提出证明了预训练问题在模型规模之外依然存在很大的探索空间,包括但不限于大规模知识图谱的融合学习、数据多样性与质量优化、结构与训练方式改进等,提升参数规模绝对不是当下预训练问题的唯一解!但从另一个角度来说,未来的ERNIE模型进化到千亿、万亿乃至十万亿参数规模后,又会带给业界怎样的惊喜呢?让我们拭目以待吧!

AI开源项目

7. 仅用99行代码实现冰雪奇缘特效的「太极」再进化,胡渊鸣团队、快手等联合打造

原文:

https://mp.weixin.qq.com/s/vJFOziFu2Dre6QQbXeAtRA

论文:

https://yuanming.taichi.graphics/publication/2021-quantaichi/quantaichi.pdf

GitHub:

https://github.com/taichi-dev/quantaichi

得益于计算机仿真技术的不断发展,我们能够在电脑中重建越来越逼真的现实世界,制作出《冰雪奇缘》等优秀的特效电影。但逼真的场景、丰富的细节离不开超高精度的物理模拟,因此特效的每一帧几乎都是用经费烧出来的。现代动画电影(包括《冰雪奇缘》等),经常使用基于物理的动画生产特效,丰富感官的体验。基于粒子的表示是其中常用的方法。场景越大,粒子就越多。比如,要模拟一个 300 米长的溃坝场景中的水,可能会需要数千万粒子,而这些粒子的存储需要大量显存。比如说,如果需要96GB的显存,则需要购置大量高端显卡,如 4 块 NVIDIA Quadro P6000 GPU。而一块 P6000 在 Amazon 上的售价约为 4000 美元,而这样的 GPU,你要买 4 块。显然,这个成本不是普通家庭能玩得起的。

针对这一现状,快手、麻省理工、浙大、清华的研究者进行了物理编译器自动量化方面的研究,提出了一套用于量化模拟的新的语言抽象和编译系统——QuanTaichi。它可以使用低精度量化的数字数据类型并将其打包(packing)以表示模拟状态,从而减少了内存空间和带宽消耗。有了这项技术的加持,高精度的物理模拟只需要一块 GPU 就能实现。QuanTaichi 的实现基于 MIT CSAIL 胡渊鸣等人之前提出的「太极(Taichi)」编程语言和编译器,使开发人员可以轻松地在不同的全精度和量化模拟器之间进行切换,以探索最佳的量化方案,并最终在空间和精度之间取得良好的平衡。相关工作已经入选图形学顶会 SIGGRAPH 2021,也已经被合入到了太极的开源 Github 库中。

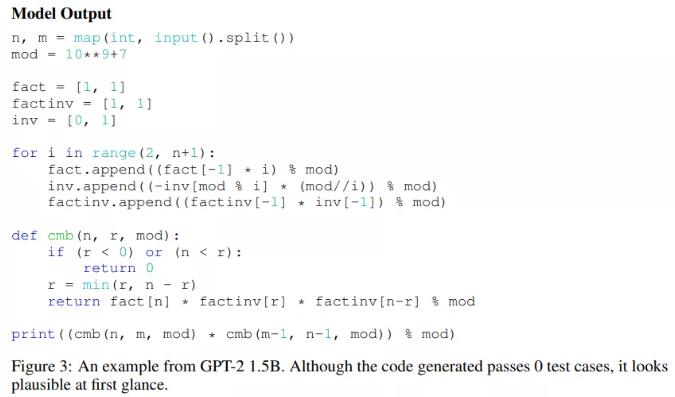

8. 计算机行业越来越卷,AI都会刷LeetCode了,网友:比我强

原文:

https://mp.weixin.qq.com/s/3pxBcX6pvRkUJAiS6Z0jmw

论文:

https://arxiv.org/pdf/2105.09938.pdf

GitHub:

https://github.com/hendrycks/apps

随着深度学习的兴起,AI 让许多行业实现了自动化,包括将 AI 用于编程。人们在编程时通常会使用大量的有意识和潜意识思维机制发现新问题并探索不同的解决方案,然而大多数机器学习算法都需要定义明确的问题和大量带有注释的数据才能够开发出解决相同编程问题的模型,因此用 AI 编程并非易事。此外,准确地评估模型的代码生成性能可能是很困难的,并且很少有既灵活又严格的方式来评估代码生成的研究。

基于此,来自 UC 伯克利等机构的研究者提出了 APPS(Automated Programming Progress Standard),一个代码生成基准,该基准测试能够衡量模型的代码生成能力,并检查代码是否符合问题要求。与公司评估候选软件开发人员的方式类似,该研究通过检查生成的代码在测试用例上的结果来评估模型。基准测试包括 10000 个问题,包含单行代码解决的简单问题和具有大量代码的复杂算法挑战等多多种问题。

论文发布后,有网友表示他们使用相似的数据集训练模型解答 LeetCode 中的题目,其中最优的模型是 GPT-2,准确率高达 80%。

在上一期 AI 简报中,与此类似的一个项目 AI 代码合成器 Github Copilot,是由微软、Github、OpenAI 三方联手推出的。最近,Github Copilot 出现了巨大的争议。Github 官方承认会使用 Github所有公开代码来训练它,并且不区分 License类别,使得网友炮轰 Github,Github Copilot 被质疑为 “抄袭工具”。

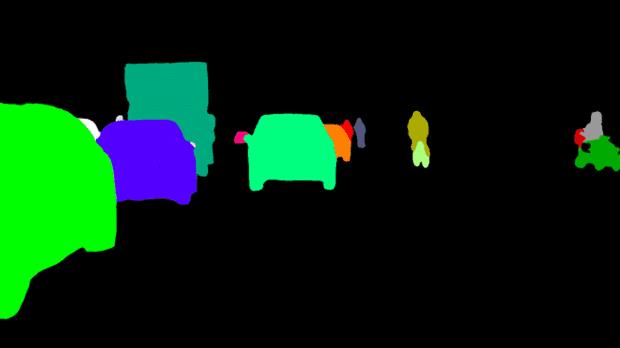

9. 火爆 Github!这个图像分割神器开源了

原文:

https://mp.weixin.qq.com/s/fAqCfxUnkO8H_qkxjP95nA

Github:

https://github.com/PaddlePaddle/PaddleSeg

百度的产业级人像分割方案PPSeg近期开源了!人像分割是图像分割领域非常常见的应用,在实际应用过程中人像的数据集来源多种多样,数据可能来源于手机、相机、监控等,图片尺寸可能是横屏、竖屏或者方屏。部署场景多种多样,有的应用在服务器端,有的应用在移动端,还有的应用在网页端。为此 PaddleSeg 团队推出了在大规模人像数据上训练的人像分割 PPSeg 模型,满足在服务端、移动端、Web 端(Paddle.js)多种使用场景的需求。

PPSeg 模型在产业中得到了广泛的应用。近期“百度视频会议”也上线了虚拟背景功能,支持用户在视频会议时进行背景切换。其中人像换背景模型采用 PaddleSeg 团队开发的 PPSeg 系列模型中的超轻量级模型。通过 Padddle.js 实现了在 web 端部署,直接利用浏览器的算力进行图像分割,分割效果受到一致好评。

小伙伴们也可前去百度首页体验百度视频会议,直观体验一下 PaddleSeg 和 Paddle.js 为大家提供的人像分割功能。

文末福利

OOM?教你如何在PyTorch更高效地利用显存

原文:

https://mp.weixin.qq.com/s/_k-jpx2zILgvlWzxku2kWw

Out Of Memory, 一个炼丹师们熟悉得不能再熟悉的异常,其解决方法也很简单,减少输入图像的尺寸或者Batch Size就好了。但是,且不说输入尺寸对模型精度的影响,当BatchSize过小的时候网络甚至无法收敛的。

当然,氪金解决一切。但为了不加钱,我们就只能尽可能地去榨取显存,原文就介绍了如何在不减少输入数据尺寸以及BatchSize的情况下,进一步榨干GPU的显存。

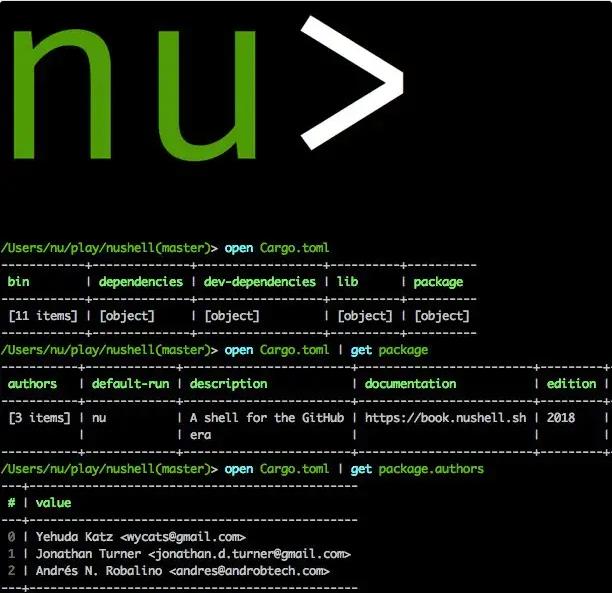

装X神器!NuShell

原文:

https://mp.weixin.qq.com/s/1hARPIQ6jXeW4pvgg8skQg

Github:

https://github.com/nushell/nushell

原文介绍了一个生产力工具Shell,它叫Nushell,它是用Rust写的,安全性提高的同时,Bug率也降低了。NuShell 专注于实现以下目标:

创建具有现代感的灵活的跨平台Shell

允许你将命令行应用程序与可理解数据结构的Shell进行混合和匹配

具有现代命令行应用程序提供的用户体验优化

在做开发等枯燥的工作的同时,有一个良好的界面视觉感和很多方便的功能,将会事半功倍!

你可以添加微信17775982065为好友,注明:公司+姓名,拉进 RT-Thread 官方微信交流群!

???? 点击阅读原文进入官网

以上是关于AI简报20210716期上海张江又一款AI芯发布寒武纪切入自动驾驶芯片的主要内容,如果未能解决你的问题,请参考以下文章

AI简报20220311期汽车AI芯片竞赛加速苹果最强芯M1 Ultra登场

AI简报20210709期AI芯片勘智K510发布GitHub Copilot AI 代码合成器上线

AI简报 20211119 期全球AI芯片峰会全球首款4nm手机芯片