hive on spark报错:没有发现类

Posted 南辰x

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了hive on spark报错:没有发现类相关的知识,希望对你有一定的参考价值。

项目场景:

配置hive on spark环境报错

问题描述

官网下载的Hive3.1.2和Spark3.0.0默认是不兼容的。因为Hive3.1.2支持的Spark版本是2.4.5,所以需要我们重新编译Hive3.1.2版本。

我们使用编译好的Hive3.1.2版本配置引擎为spark时仍然有问题,报错信息:

Failed to execute spark task, with exception

‘org.apache.hadoop.hive.ql.metadata.HiveException(Failed to create

Spark client for Spark session 7abab179-b49d-4ed0-b45b-0ef1dfb3f52b)’

FAILED: Execution Error, return code 30041 from

org.apache.hadoop.hive.ql.exec.spark.SparkTask. Failed to create Spark

client for Spark session 7abab179-b49d-4ed0-b45b-0ef1dfb3f52b

原因分析:

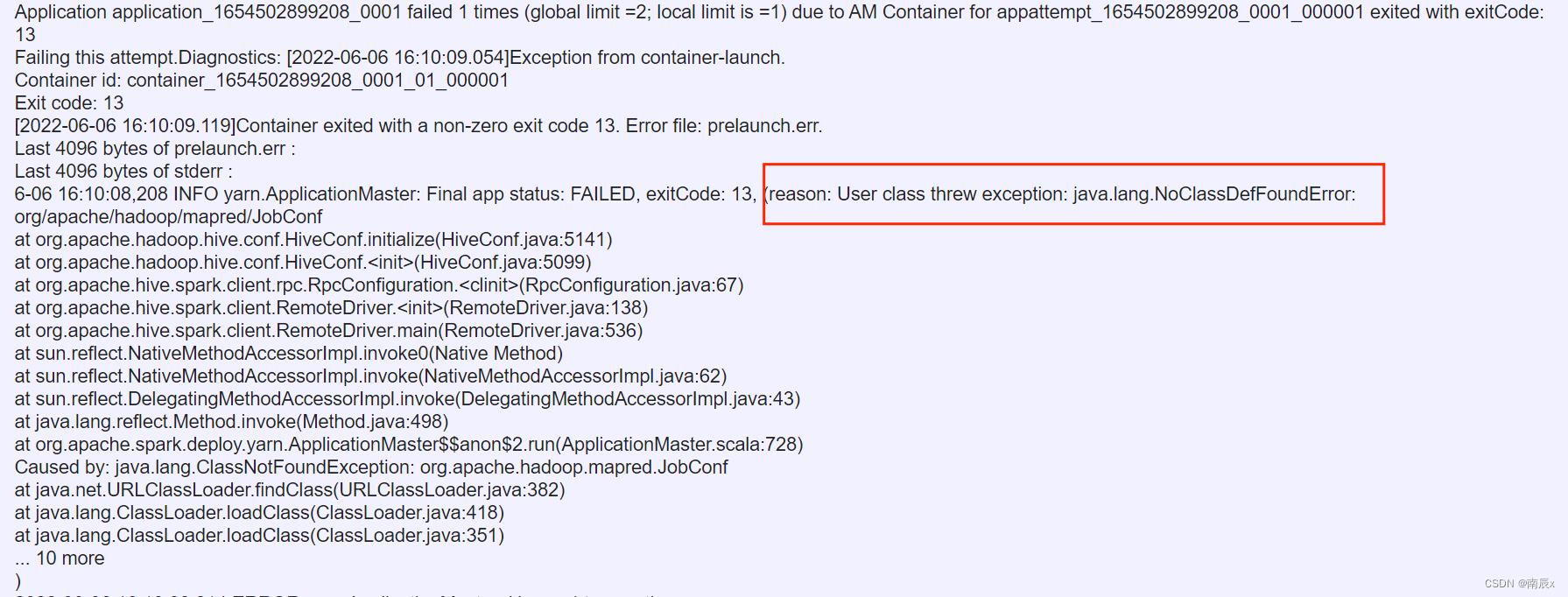

查看yarn日志后发现重要信息

红框这段话的意思就是没有发现类

一般出现这两种情况有两个原因:

-

版本兼容问题

-

配置文件没有声明类

我们是用的已经编译好的hive,所以已经解决了版本兼容问题,我们尝试在hadoop配置文件声明类。

解决方案:

在虚拟机中输入hadoop classpath,复制打印在控制台的信息

yarn-site.xml文件中添加

<property>

<name>yarn.application.classpath</name>

<value>hadoop classpath打印出来的信息</value>

</property>

然后我们运行hive,插入一条信息,就成功了!hive on spark配置就结束了。

以上是关于hive on spark报错:没有发现类的主要内容,如果未能解决你的问题,请参考以下文章

hive on spark hql 插入数据报错 Failed to create Spark client for Spark session Error code 30041

hive on spark hql 插入数据报错 Failed to create Spark client for Spark session Error code 30041

CDH6.3.2 Hive on spark报错is running beyond physical memory limits