文本分类ACT: an Attentive Convolutional Transformer for Efficient Text Classification

Posted 征途黯然.

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了文本分类ACT: an Attentive Convolutional Transformer for Efficient Text Classification相关的知识,希望对你有一定的参考价值。

·阅读摘要:

本文在Transformer模型的基础上,提出改进方案,把Transformer里面的自注意力机制,改成CNN。

·参考文献:

[1] ACT: an Attentive Convolutional Transformer for Efficient Text Classification

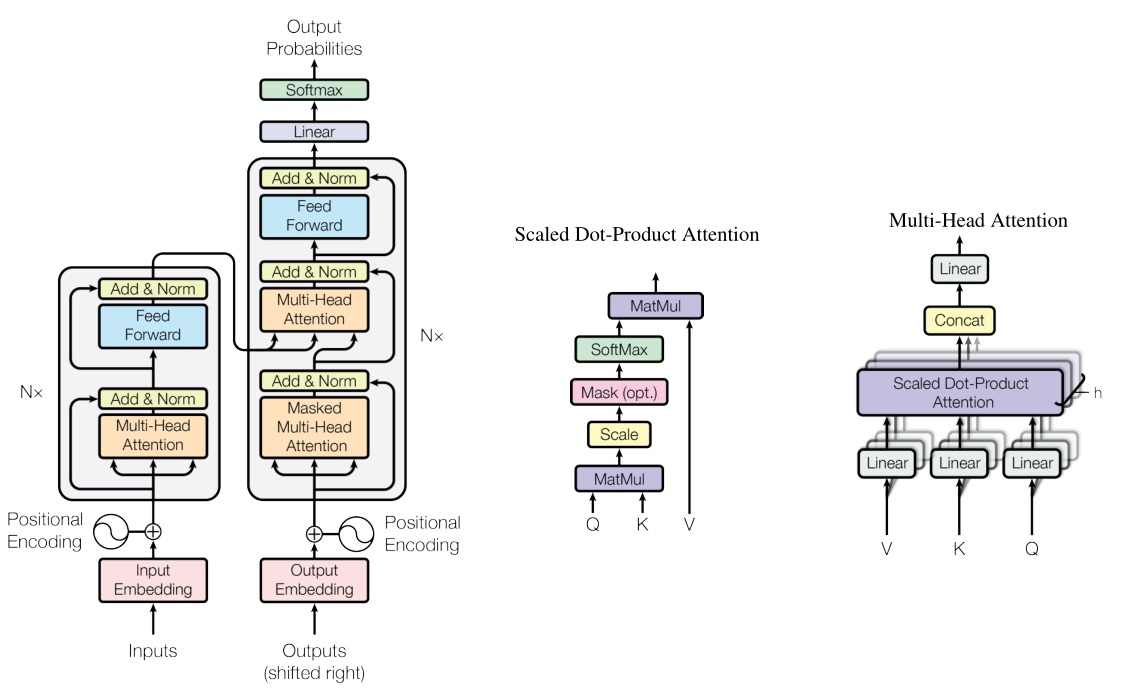

【注】:众所周知,

Transformer是超越RNN、CNN的模型,Transformer中最有新意的就是不使用RNN、CNN,而使用自注意力机制,从而使得Transformer模型表现卓越。

而本文提出的ACT模型就是把Transformer中的自注意力机制替换成CNN,我觉得这篇论文是否有意义,其实应该和Transformer的作者battle一下,哈哈。

[1] ACT模型

先看一下Transformer模型:

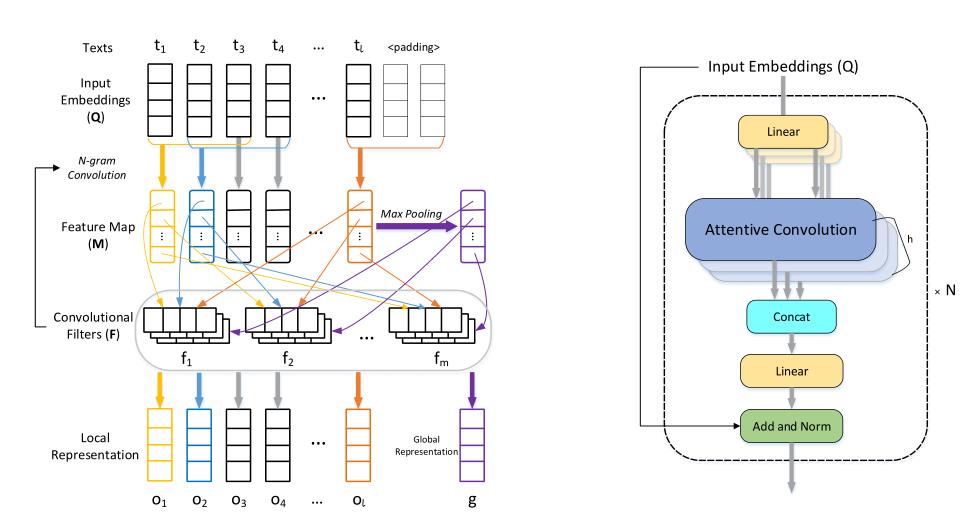

再看ACT模型:

所以说,ACT模型只是把Transformer的Scaled Dot-Product Attention模块换成了attentive convolution mechanism。

对于attentive convolution mechanism模块,主要就是CNN加了一个Global feature representation。

【注】:说白了就是普通的CNN是卷积–>池化;而论文提出的CNN是卷积+池化,其中卷积部分称为提取局部信息,池化部分称为提取全局信息。

以上是关于文本分类ACT: an Attentive Convolutional Transformer for Efficient Text Classification的主要内容,如果未能解决你的问题,请参考以下文章

论文笔记之:RATM: RECURRENT ATTENTIVE TRACKING MODEL

图像分割之Dense Prediction with Attentive Feature Aggregation

论文阅读笔记:Multi-Labeled Relation Extraction with Attentive Capsule Network(AAAI-2019)

论文阅读笔记:Multi-Labeled Relation Extraction with Attentive Capsule Network(AAAI-2019)